-

Postów

260 -

Dołączył

-

Ostatnia wizyta

Typ zawartości

Profile

Forum

Blogi

Wydarzenia

Galeria

Pliki

Sklep

Articles

Market

Community Map

Odpowiedzi opublikowane przez Michal G.

-

-

ehhh, widzicie co ta praca robi z ludźmi - czasu na hobby brakuje, dlatego przez długi czas tu nie zaglądałem

Super ciekawe rzeczy tu Panowie piszecie

Jeśli chodzi o sprzęt - stała się super przykra sprawa, otóż ktoś okradł obserwatorium. Zginął (przepiękny) mechanizm napędzania teleksopu - był mosiężny, pewnie już jest przetopiony

Pomimo, że nie ja się tym zajmuję, to wiem, że są szeroko zakrojone plany na odnowienie tego wszystkiego, jak również, jakiś czas temu profesor Pojmański odezwał się do mnie, czy nie mam jakichś lepszych zdjęc tego mechanizmu, żeby go odtworzyć. A może panowie macie?

Wiem też, że znalazły się jakieś fundusze na to, żeby te zabytki całkiem nie zmarniały i nie zostały spisane ze stanu ani zlikwidowane

(aż mi trochę wstyd tak tu zaglądać raz na dwa lata )

)

-

Cześć,

może kogoś z Was zainteresuje - w marcu będzie miała miejsce pewna konferencja Interakcja-Integracja, w ramach tej konferencji odbędzie się hackaton - uczestnicy będą mieli zadanie (albo dla pozytywniejszych myśli - możliwość

) stworzenia pokazu do planetarium. Założenie jest takie, żeby taki pokaz był czymś innym niż wszystkie pokazy we wszystkich planetariach.

) stworzenia pokazu do planetarium. Założenie jest takie, żeby taki pokaz był czymś innym niż wszystkie pokazy we wszystkich planetariach.Tak naprawdę każdy się nadaje do wzięcia udziału. Wiadomo, graficy, programiści, ale też np ludzie kreatywnie myślący, żeby wymyślać scenariusze, w praktyce opowiedzieć przygotować pokaz. Używali będziemy systemu, który jest na miejscu - czyli projekcja cyfrowa + analogowa, więc absolutnie wszystko jest możliwe

Trzeba się tylko zmieścić w 24h, które są na wykonanie zadania, potem wiadomość ulegnie samozniszczeniu

Trzeba się tylko zmieścić w 24h, które są na wykonanie zadania, potem wiadomość ulegnie samozniszczeniu

Jeśli więc ktoś z Was miałby ochotę się pobawić, albo może zobaczyć pracę planetaryjną od kuchni, to jest to świetna okazja

W sumie to jest szansa, że te pokazy (z założenia "open source-owe") wyjdą na tyle super, że potem gdzieś w Polsce będzie można je jeszcze zobaczyć

W sumie to jest szansa, że te pokazy (z założenia "open source-owe") wyjdą na tyle super, że potem gdzieś w Polsce będzie można je jeszcze zobaczyć

więcej informacji:

albo pisać do mnie, bo współorganizuję

Aaaaa, jeszcze dodam, że zapisy są teoretycznie do jutra ;p

Formularz rejestracji:

Jest opłata za uczestniczenie - 50 PLN

-

1

1

-

-

Michał G, mało wgłębiałem się w te sprawy. Rozumiem, że w astrometrii chodziłoby o wyznaczenie pozycji gwiazdy, aby następnie wybrać tylko te klatki, w których pozycja obiektu jest najbliżej średniej wyznaczonej? Myślę, że w pewien % klatek stanowiłoby wciąż błąd, gdyż ich dobra pozycja wynikałaby tylko z przypadku.

Dokładnie tak, mam w głowie coś takiego: wybieramy ileś % klatek o najmniejszym FWHM, następnie kontrolujemy te klatki pod kątem przesunięć. Wiadomo, część klatek zawsze będzie gorsza, no bo wybieramy % klatek.

-

1

1

-

-

Specyfikacja plików fit nie będzie miała znaczenia, bo to tylko metoda na przechowywanie informacji. Po nagłówki są po prostu liczby - takie jakie byłby przeczytane z matrycy.

To ja mam inne pytanie ( Może być hipopotamiczny sensor, a moze być jakis istniejący, np. KAF8300 i ASI178, mnie za jedno).

Ile fotonów musi paść na pixel by zmienić stan nagromadzonych w studni elektronów o 1?

Ile elektronów w studni musi być by zostać skonwertowanych do cyfrowego stanu 1? (to akurat proste, od tego mamy gain)

Ile cyfrowy stan 1 na ADC da ADU w wyjsciowym pliku?

Bo widzicie te 2.5log itd. to wzór na fotony, nie bity.

Pozdrawiam.

A 'fotony' czytane z matrycy są o tak, od fotonu do zliczenia (dla CCD):

1. Foton uderza w matrycę - ma X% szans na wywołanie elektronu. X jest liczbą zależną od matrycy i od energii (długości, koloru) fotonu. Dla niektórych matryc da się znaleźć w internetach noty katalogowe. Np. dla mojej kaf-1600 nominalnie dla 650 nm (czerwony) to 35%. Nieliniowość i niejednorodność są na poziomie 1%

2. W trakcie ekspozycji i podczas czytania wprowadzany jest prąd ciemny. Jest on w miarę stały, i możemy go odejmować, zatem najważniejsza jego część to to jak bardzo on jest losowy. Z noty katalogowej czytamy: dark current non-uniformity, nominalnie 15 e/pix/sec, maksymalnie 50. To duzo!

3. Po zakończonej ekspozycji piksele jadą do wiersza czytającego. Wydajność nominalna tego przenoszenia to 0.99998

4. Ładunek początkowy z matrycy uszczuplony o elektrony z fotonów trafia do wzmacniacza wyjściowego (wbudowanego w matrycę). Wzmacniacz ten ma czułość pomiędzy 9 -11 uV / e~.

5. Te mikrowolty następnie trafiają do konwertera, tu się toczy walka. Konwertery ADC są różne, mają różne dokładności i szumy. Patrzę na pierwszy z brzegu, ADS1113, 16-bitowy. Przy temperaturze 20 stopni C ma szum na poziomie 3.5 uV (czyli ~1/3 elektronu)

6. potem już następuje transfer cyfrowy, więc już nie będzie wprowadzania szumu. Wcześniej po drodze oczywiście są dodatkowe miejsca wprowadzające szum, teraz je pomijam, bo nie wiem jak oszacować taki szum

A zatem kluczowe elementy odpowiadające za pomiar i jego błędy to wydajność kwantowa oraz czułość wzmacniacza, a najbardziej nam przeszkadza zachowywanie się prądu ciemnego.

Uf!

[EDIT]

Przyszedł do głowy jeszcze jeden pomysł. A gdyby spróbować inne metody debayeryzacji materiału i na nich przeprowadzić fotometrię?dokładnie coś takiego planuje przeprowadzić w przyszłym tygodniu - nadchodzi upragniony urlop

Sensowne metody debayeryzacji są niezbyt liczne:

Sensowne metody debayeryzacji są niezbyt liczne:- możemy wziąć średnią z pikseli (R + G + G +

/ 2

/ 2- możemy wziąć średnią z pikseli zielonych (najbardziej zbliżone do V Johnsona) (G + G) / 2

- możemy wziąć bezpośrednio jeden piksel G (albo drugi, ale zawsze ten sam)

tu jest trochę o tym:

http://integral.physics.muni.cz/rawtran/

Munipack robi to dobrze i daje wybór.

-

2

2

-

-

Adam, w jaki sposób można wykonać selekcję klatek nadających się do "lucky imaging"? Na jakiej podstawie określany jest % klatek w DSS, AS!2 czy Registaxie? Sprawa dość istotna, ponieważ do fotometrii planowałem wykorzystać selekcję związaną z poziomem ADU pikseli (http://astropolis.pl/topic/56082-siegajac-do-granic-amatorskich-obserwacji-planet-pozaslonecznych/?p=650337), jednak proces potrwa pewnie wiele dni.

Analizowanie niekiedy kilkudziesięciu tysięcy klatek nie jest możliwe manualnie...

A np. mierzenie FWHM i ewentualnie astrometria? Nie styknie?

-

Aczkolwiek owe domysły przeprowadzane są dość sensownie i nawet powiedziałbym, że skomplikowanie

Dochodzi jeszcze założenie, że obiekty wykazują dużą symetrię.

Dochodzi jeszcze założenie, że obiekty wykazują dużą symetrię.Metoda opisana jest tutaj:

http://www.cg.cs.tu-bs.de/publications/wenger2012visualization/

można ściagnąć z tego miejsca kilka modeli mgławic i całą publikację na ten temat

Te modele są w dwóch formatach: HDF5 oraz DDS. Nie wiem czym jest HDF5, DDS wiem, ale nie wiem czym na windowsach można to prawidłowo otworzyć - to są pliki, które mają warstwy, każda z warstw jest przekrojem na odpowiedniej głębokości. Istnieje plugin do Photoshopa, który obsługuje DDSy (oraz cały zestaw narzędzi do command line-a) na stronach NVIDIA, trzeba szukać "DDS tools". Nie otworzą one natomiast tych plików jako modeli 3d, tylko pozwolą na konwersje do innych formatów graficznych i oglądanie kolejnych warstw osobno

DDSy oryginalnie służą do robienia tekstur w grach, bo jest to natywny format dla kart graficznych i zwiększa wydajność (ze stratną kompresją).

DDSy oryginalnie służą do robienia tekstur w grach, bo jest to natywny format dla kart graficznych i zwiększa wydajność (ze stratną kompresją).Część to pewnie pomiary odległości różnych fragmentów obiektów, część to pewnie założenie jak według naszej wiedzy pewne zjawiska powinny zachodzić, a część to pewnie zwykłe domysły, dlatego nie możemy tego interpretować jako prawdę objawioną ale pewną pomoc w wyobrażeniu sobie jak to wygląda.

-

1

1

-

-

Hejka,

parę dni temu dołączył do repertuaru film pt. "Niewidzialny Wszechświat". Oryginalny tytuł to "Dark Universe". Nie jestem wielkim fanem filmów w planetariach, ale ten, serio, ma przepiękne wizualizacje (szczególnie supernowe w galaktykach, rozszerzanie się Wszechświata oraz wzorowa wizualizacja rozkładu ciemnej materii).

Myślę, że spora część z Was może byc nim zainteresowana - film jest o ciemnej materii.

Tu można sobie zobaczyć trailer:

https://www.youtube.com/watch?v=kKUnDNX4gWM

i ciekawy komentarz autorów (m.in. Neil deGrasse Tyson

)

)https://www.youtube.com/watch?v=pOxG4aSQOO8

Film jest o tyle wyjątkowy, że wizualizacje naukowe były obliczone - w odróżnieniu od wizji grafików 3d...

Da się też, raz w miesiącu, pójść na wersję z oryginalna ścieżką dźwiękową, czyli czyta Neil deGrasse Tyson (na polskich wersjach da się wziąć słuchawki z angielskim, ale raczej nie polecałbym, bo to jednak tylko słuchawki

)

)-

4

4

-

-

Tak jak pisałem, testowałem go, ale zupełnie mi się nie podoba. Brakuje mu bardzo wiele i denerwuje mnie jego interface.

Ta cena... Cóż, z pewnością zerknę na wersję testową chociaż. Skoro tyle kosztuje, to może wreszcie będzie coś wart. A czy odejmuje darki? Czy czyta rawy Nikona?

A co to jest flicker i holy grail?

Co to przejście z dnia do nocy to wiem, ale tych dwóch pojęć nigdy nie słyszałem

Co to przejście z dnia do nocy to wiem, ale tych dwóch pojęć nigdy nie słyszałem

Nie odejmuje darków, rawy Nikona chyba czyta, aczkolwiek nigdy nie próbowałem - używa standardowej biblioteki do czytania rawów, raczej jest w niej implementacja nie tylko dla Canona.

Flicker to zjawisko mrugania na timelapse-ach wynikające z różnych jasności następujących po sobie klatek. Oczywiście na nocnych, długoczasowych zdjęciach, flicker jest mały. Mruganie to wynika z niedokładności w czasie otwierania migawki, ale też czasami z mrugania lamp i innych sztucznych świateł. Flicker jest wyjątkowo widoczny na dziennych zdjęciach, kiedy czasy otwarcia migawki są krótkie i te niewielkie niedokładności migawki mają większe znaczenie.

Święty gral timelapse-owania polega na zmienianiu (podczas wschodu/zachodu Słońca ) parametrów ekspozycji, takich jak czas naświetlania, ISO itp. Te zmiany zawsze są skokowe, więc zwykłe ułożenie klatek po sobie by było słabe. LRTimelapse modyfikuje parametry wywołania rawów w Lightroomie tak, aby klatki następujące po sobie miały płynne zmiany jasności.

-

LRTimelapse - jest genialny, ale troche kosztuje, bo 121.77 €. Ma bardzo skuteczne metody usuwania filckeru, oraz "holy grail'a" - czyli przejscia z dnia do nocy. Działa w oparciu o Lightrooma, więc tego też trzeba mieć.

-

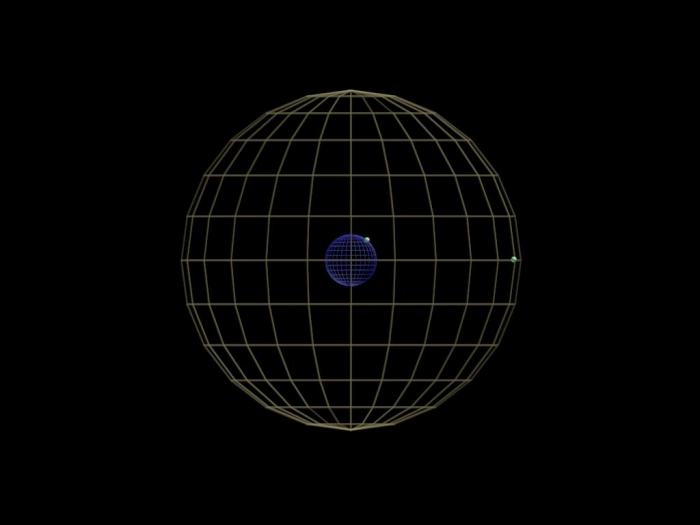

wzory trygonometri sferycznej zakładają, że wszystkie punkty leżą na jednej sferze, a w Waszym przypadku tak nie jest - miasta są na Ziemi, a satelita jest sensownie daleko od Ziemi. Co prawda odsunięcie satelity od Ziemi powoduje, że powinien być wyżej nad horyzontem, podczas gdy Wam wychodzi za wysoko...

Wizualizacja w skali

W środku jest Ziemia, na niej pryszczyk - jakies losowe miasto powiedzmy, na zewnętrznej sferze są satelity geostacjonarne, pryszczyk-satelita jest nie na tej samej długości geograficznej.

W środku jest Ziemia, na niej pryszczyk - jakies losowe miasto powiedzmy, na zewnętrznej sferze są satelity geostacjonarne, pryszczyk-satelita jest nie na tej samej długości geograficznej. A może tak do tego podejść (bardziej geometrycznie): jakie rozmiary kątowe miałaby widoczna część bardzo wysokiego komina zbudowanego na równiku na długości geograficznej 4,8° E. Dolna część komina jest niewidoczna, bo jest zasłonięta przez krzywiznę Ziemi.

-

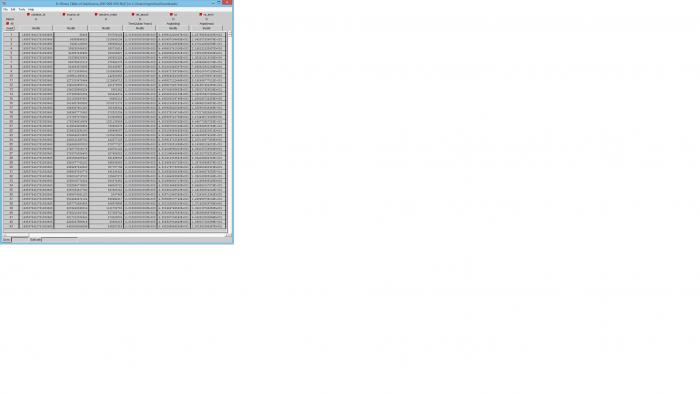

A komuś może udało się otworzyć te fitsy źródłowe: http://cdn.gea.esac.esa.int/Gaia/gaia_source/fits/ ?

bo ani maxim, ani fits liberator nie dają rady. Każdy z nich to jakieś 70MB, otwierając je notatnikiem widać nagłówek, w którym jest napisane, że to standardowy format fits.

Tak tylko z ciekawości chciałem zobaczyć jak wygląda zdjęcie z największej matrycy (106xCCD 4500x1966 pikseli każdy - to jakieś 1m na pół

i tak i nie

Te fitsy to katalog zapisany w postaci binarnej, nie są to niestety zdjęcia

Można zatem to otworzyć, ale wynik jest rozczarowująco nudny

Można zatem to otworzyć, ale wynik jest rozczarowująco nudny

Żeby chociaż odrobinę zaspokoić Twoją ciekawość mogę zaproponować zredukowane zdjęcie z kamery OGLE-IV, też jest niemała, chociaz zauważalnie

mniejsza (290×278 mm). Pełna rozdzielczość, png (82.5MB): https://www.dropbox.com/s/r1bvk7v5bfzhekp/BLG512.png?dl=0

mniejsza (290×278 mm). Pełna rozdzielczość, png (82.5MB): https://www.dropbox.com/s/r1bvk7v5bfzhekp/BLG512.png?dl=0 -

tez chcialbym podziekowac za zlot w imieniu swoim i swojej kompaniji

Przyjemnie bylo spedzic czas, zaluje, ze drugiego dnia odwozac kolege do bilgoraju popsul mi sie samochod i wrocilem juz po wykladach

Przyjemnie bylo spedzic czas, zaluje, ze drugiego dnia odwozac kolege do bilgoraju popsul mi sie samochod i wrocilem juz po wykladach

-

jest taka wizualizacja diagramu H-R, uważam, że to jedna z najlepszych wizualizacji naukowych ever, polecam

-

Czyż to nie jest piękne połączenie mgławicy emisyjnej z absorbcyjną? Musi pięknie wyglądać w podczerwieni. Na Twoim zdjęciu też pięknie wygląda

-

No więc badam już drugi tydzień metody robienia dobrej fotometrii w domu. Z tego co widzę Muniwin nie ma opcji robienia fotometri profilowej? Czy to ja sie nie doszukałem?

Udało mi się zainstalować paczkę IRAFa na windowsowym Cygwin (pod linuksami to w ogóle nie problem, ale większość z nas preferuje windowsy

) Niestety jednak zainstalowanie programów fotometrycznych (IRAF jest bardziej do redukcji) takich jak DAOPhot (fotometria aperturowa), Allstar (profilowa), DOPhot skończyło się fiaskiem, to dramat jakiś jest, trzeba sobie wszystko samemu kompilować (a DAOPhot jest napisany w fotranie 77 :/, ktośkto umie, to sobie poradzi, ale żeby zwykły zapaleniec miał to robić - nie polecam)

) Niestety jednak zainstalowanie programów fotometrycznych (IRAF jest bardziej do redukcji) takich jak DAOPhot (fotometria aperturowa), Allstar (profilowa), DOPhot skończyło się fiaskiem, to dramat jakiś jest, trzeba sobie wszystko samemu kompilować (a DAOPhot jest napisany w fotranie 77 :/, ktośkto umie, to sobie poradzi, ale żeby zwykły zapaleniec miał to robić - nie polecam)W IRAFie w zasadzie siedzi zainstalowany DAOPhot i Allstar, ale działa mozolniej niż w wersji samodzielnej (to mocno niekorzystne kiedy na obrazku jest dużo gwiazd).

Ale o co chodzi. Uważam, że w sytuacji tak, jak robisz - chcesz zarejestrować tranzyt, a niekoniecznie wyznaczać bezwzględne jasności, zrobienie fotometri profilowej da Ci (nam

) znacznie lepszy wynik. Wynik będzie jeszcze lepszy im gęstsze od gwiazd jest pole.

) znacznie lepszy wynik. Wynik będzie jeszcze lepszy im gęstsze od gwiazd jest pole. Spróbuję po zlocie ogarnąć trochę procedur w Pythonie, może uda mi się zrobić jakiś przystępny program do robienia fotometri profilowej, strasznie jestem ciekaw, jak by wyszła na Twoich danych

Niestety gotowiec - Pyraf, który istnieje i bywa używany, jest tak naprawdę wraperem dla IRAFA, więc znowu - trzeba przejść przez mega irytujący proces instalacji (oraz kompilacji)

Niestety gotowiec - Pyraf, który istnieje i bywa używany, jest tak naprawdę wraperem dla IRAFA, więc znowu - trzeba przejść przez mega irytujący proces instalacji (oraz kompilacji)-

1

1

-

-

ten model nieco uzmysławia co się dzieje w mgławicy. Owszem, to planetarna mgławica, ale to jedyna tego typu wizualizacja jaką znam...

-

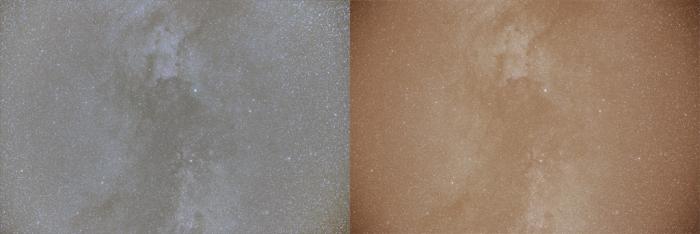

To co opisałeś to właśnie sztuczny flat

Można też szybciej to zrobić w darmowym Fitsworku lub w Pixinsight.

W sumie racja

Jak to przeczytałem, to miałem w głowie flata nie na niebie, tylko na podświetlonym ekranie

Jak to przeczytałem, to miałem w głowie flata nie na niebie, tylko na podświetlonym ekranie

-

Flat lub sztuczny flat. Innej opcji nie ma.

Jest, oszustwo

W photoshopie robisz kopię warstwy, inwersję, a następnie takiego blura, żeby całkiem zniknęły gwiazdy. Wtedy ustawiasz rodzaj warstwy na taki, który odejmuje jasności, zapomniałem nazwy... Wystarczy przelecieć przez wszystkie i dwa będą dobre (a jeden z nich lepszy)

Dobry flat oczywiście jest lepszy

[edit]

Na szybkiego zrobione. Oczywiście warto pomieszać jeszcze parametrami i powoduje to różne inne problemy, ale zmniejsza to problem, w sytuacji kiedy już mamy materiał jaki mamy. Użyty rodzaj warstwy to "jaskrawe światło", niestety mam w pracy tylko wersję polską Photoshopa i nie wiem jak się nazywa w angielskiej

Pin light?

Pin light? -

Ładnie Ci to wyszło, wygląda wiarygodnie

Czym robisz fotometrię?

Czym robisz fotometrię?nie ma ich tak dużo, do takiej listy

Samemu mozna sobie wygenerować tebelkę o np tutaj:

i w filter wpisac filtrowanie

Np wpisałem TRANSIT == 1 and DEPTH > 0.01 and V <= 11 and DEC[deg] > -20 i wyszło 16 gwiazd jaśniejszych niż 11 magnitudo z relatywnie głębokimi zaćmieniami. Owszem, nie wyfiltrowałem po RA, więc nie wszystkie z nich da się dzisiaj zaobserwować ;p Uwaga tylko, bo ta liczba mówiąca o głebokości zaćmienia to nie jest zmiana jasności w mag, tylko stosunek jasności i jeszcze do kwadratu.

Inna fajna tabelka jest na http://exoplanets.eu/ dotychczas była moją ulubioną, ale teraz się zawiodłem,bo nie da się wyfiltrować po głębokościach tranzytu. Można za to zobaczyć jaka jest faza i w ten sposób zaplanować czy można ją obserwować. Jak wpiszecie w wyszukiwarce nazwę planety, to potem po kliknięci w nią, pojawia się spis informacji, i nieco niżej - "Observability Predictor".

-

Nie mamy żadnych:)

Właśnie może na Was się będziemy wzorować - jeśli za 500 tys da się wybudować takie planetarium - ja myślałem, że sporo więcej.

U nas w mieście max kwota na projekt to 600 tys złotych - wychodzi więc, że starczyłoby.

W przyszłym roku pewnie napiszemy projekt do Budżetu Obywatelskiego.

I będziemy śledzić poczynania u Was:)

Pozdrawiam

Jest kilka bardzo sensownych metod zrobienia planetarium, wcale nie kosztownych. Obserwujcie co się stanie z projektorem z Muzeum Techniki w Warszawie, bo coś będzie musiało się stać

-

I jeszcze jedno pytanie. Czy mając tą hipotetyczną kamerę z zerowym szumem odczytu i zerowym prądem ciemnym i ze wszystkim idealnym, to robiąc jedno zdjęcie, byłoby ono idealnie gładkie (pozbawione szumu)? Czy może jednak niebo samo w sobie szumi, z uwagi na niejednostajną (nieco losową) częstość emisji fotonów w danym kierunku?

Szum jest naturalnym zjawiskiem i będzie zawsze, jeśli będziesz robił fotometrie diody, która (hipotetycznie) świeci stałym światłem, o stałej intensywności, to w różnych pomiarach otrzymasz różne wyniki. Wiadomo nawet jak różne, nazywa się to szum Poissonowski i można go nawet oszacować

Wynosi pierwiastek z liczby zliczeń. Więc jeśli obserwujemy już tę diodę i skądinąd wiemy, że idzie z niej 10000 fotonów, to w pomiarach naturalne będzie, jeśli wyjdzie 10000 +-100. Rzecz jasna uśrednianie itp historie potem pomagają.

Wynosi pierwiastek z liczby zliczeń. Więc jeśli obserwujemy już tę diodę i skądinąd wiemy, że idzie z niej 10000 fotonów, to w pomiarach naturalne będzie, jeśli wyjdzie 10000 +-100. Rzecz jasna uśrednianie itp historie potem pomagają.-

1

1

-

-

Polecasz jakiś konkretny model dla amatora (nie kosztujący fortunę) ?

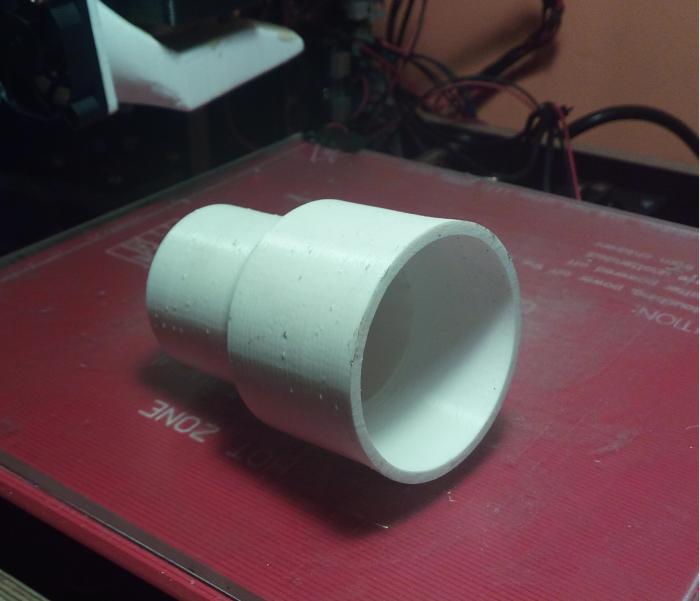

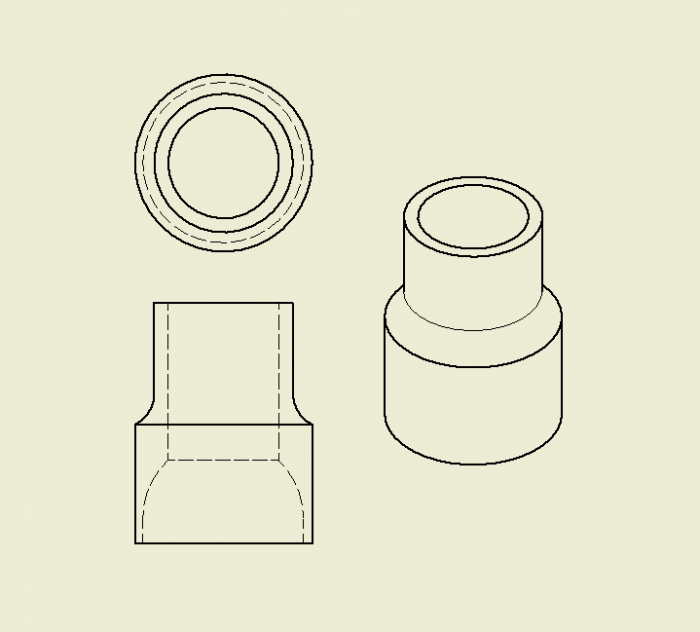

Tak, kupić elementy i złożyć samemu. Wszystkie elementy kosztują kilkaset złotych, wiadomo, zależy jakie jakościowo się kupi, ale ogólnie okolo 600 PLN można liczyć. W porównaniu z kupnymi drukarkami jest to znacznie tańsza opcja. Zamiast tych złotówek potem poświęca się czas na poskładanie tego wszystkiego i uruchomienie. Ja kupiłem zestaw elementów na allegro. Wcześniej obejrzałem baaaardzo dużo filmików na youtube-ie i poczytałem dużo artykułów, więc dosyć świadomie dokonywałem zakupu, a i tak nie jestem w 100% zadowolony, moja rama nie jest super sztywna, osie Z nie są idealnie proste, będę musiał to poprawić, wtedy jakość moich wydruków się zauważalnie poprawi. Nie przeszkodziło mi to jednak w wydrukowaniu już wielu elementów

Dosyć trudno jest powiedzieć jaka jest dokładność wykonania - każda warstwa zawsze jest troche niedokładna, ale we wszystkie strony w płaszczyźnie XY, te błędy po zsumowaniu dają raczej lepszy wynik niż gorszy. Myślę, że da się troche wyliczyć biorąc pod uwagę rozmiar mikrokroku itd. ale nie robiłem tego. Zwymiarowane elementy jak mierzę suwmiarką to najczęściej wychodzi +-0.1 mm.

Konstrukcja jest bardzo sztywna, nie wchodzi w grę ugiecie tego ręką, a co dopiero niedużym okularem 1.25". Ponieważ otwór 1.25" zrobiłem bardzo spasowany, to nie tak łatwo jest włożyć okular do środka, już nie mówiąć o jego samoczynnym wypadnięciu. Mój plan jest taki, że zrobię taką jeszcze jedną, z luźniejszym otworem i dodatkowym otworkiem na śrubkę kontrującą.

-

myślę, że przy obecnych technologiach możliwe jest wydrukowanie soczewki (a'propos okularów i barlowa), tylko taka soczewka będzie bezużyteczna

Koło filtrowe na ten przykład z całą pewnością da się zrobić - tylko trzebaby zaprojektować, chociaż możliwe, że ktoś to już zrobił

Tak samo z metalu wydruki - też można chociaż w praktyce firmy robią (nie wszyscy) tak, że drukują formę, a metal odlewają

Tak samo z metalu wydruki - też można chociaż w praktyce firmy robią (nie wszyscy) tak, że drukują formę, a metal odlewają

BTW, jeśli ktoś potrzebuje jakieś akcesorium astro, to mogę wydrukować w cenie materiału. Tylko nie gwarantuję super jakości, bo nie jestem komercyjną firmą ;p Ale takie obudowy, przejściówki, adaptery i inne duperele - spoko. Jutro planuję sobie zrobić adapter na bagnet Canona, jakiś czas temu zrobiłem sobie maskę Bahtinowa. Idzie ogarnąć

Wszelkim DIYowcom polecam drukarki, genialna rzecz

Wszelkim DIYowcom polecam drukarki, genialna rzecz

-

Hejka,

pomyślałem, że podzielę się z Wami pewnym doświadczeniem

Otóż potrzebowałem przejściówki z 2" na okular 1.25", więc za dnia popatrzyłem po sklepach, ale stwierdziłem, że bez sensu wydawać kilkadziesiąt złotych na coś, co bez problemu mogę sobie wydrukować. Tak wieć popołudniu usiadłem do kompa, machnąłem model - no i proszę! Przejściówka gotowa, koszt materiału - jakieś 5PLN

Zanim przyszły chmury udało mi się już stesować, bez większego zaskoczenia: działa, ale mogłem sprawę bardziej przemyśleć

Zasugerowałem się innym wyciągiem, który mam i z jego przejściówki ściągnąłem wymiary - w szczególności wysokość. Rzecz jasna wysokość okazała się być za duża... Jutro zatem czeka mnie wydruk kolejnej przejściówki, koszt całkowity zatem rośnie mi dwukrotnie, ale nadal się chyba opłaca, nie?

Zasugerowałem się innym wyciągiem, który mam i z jego przejściówki ściągnąłem wymiary - w szczególności wysokość. Rzecz jasna wysokość okazała się być za duża... Jutro zatem czeka mnie wydruk kolejnej przejściówki, koszt całkowity zatem rośnie mi dwukrotnie, ale nadal się chyba opłaca, nie?

Zrobiłem też zbyt spasowany otwór 1.25", musiałem pilnikiem podpiłować trochę materiału

Dla nerdów:

wydruk na DIY Prusa i3 z podgrzewanym stołem, PLA, grubość warstwy 2.5 mm, średnica dyszy 0.4 mm, wypełnienie 20%, bez supportów., bez brim/raft/skirt.

-

8

8

-

Co jest potrzebne do dostania sie na studia astrofizyczne?

w Społeczność AP (Rozmowy o wszystkim)

Opublikowano

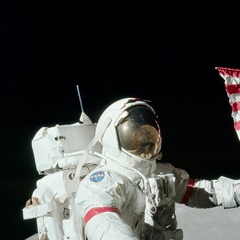

Jakiś czas temu, w zeszłym roku czy coś, byłem na wykładzie, na którym człowiek odpowiedzialny za trening i układanie harmonogramu astronautów opowiadał o tym jak zostać astronautą. Jego konkluzja była taka, że nieprędko Polak zostanie astronautą ze względu na wysokości składek jakie płacimy. Działa to tak, że płaci się składki, a potem ESA ma zadanie zainwestować conajmniej ileś (nie pamiętam) procent tych składek w danym kraju. No i my nawet nie jesteśmy w stanie dorzucać się większymi składkami, bo ESA nie będzie w stanie wydawać kasy w Polsce. Tymczasem presja od innych krajów członkowskich jest ogromna, żeby to oni mieli astornautów - a dają większe pieniądze.

Pokazywał też fragmenty (wszystkiego nie mógł) testów na astronautów, bardziej w nich chodziło o szybkie przyswajanie informacji wizualnej (patrzenie na zegary) i podejmowanie decyzji niż jakąkolwiek wiedzę naukową. Byli też np. astornauci-biolodzy, zupełnie nie związani ani z wojskiem, ani lotnictwem, inżynierią czy fizyką.