-

Postów

740 -

Dołączył

-

Ostatnia wizyta

Typ zawartości

Profile

Forum

Blogi

Wydarzenia

Galeria

Pliki

Sklep

Articles

Market

Community Map

Odpowiedzi opublikowane przez Sebo_b

-

-

31 minutes ago, ZbyT said:

użyteczna rozpiętość kamery z ADC 16 bit to od 13 do 65535 ADU

dla kamery 12 bit to od 1 do 4096 ADU

jesteś przekonany, że są choć odrobinę zbliżone?

Masz rację! Błędnie przyjąłem, że 13e- przeliczam na bity - a to odchylenie bezwzględne.

31 minutes ago, ZbyT said:poza tym skupiłeś się jedynie na szumie odczytu, a zupełnie pominąłeś inne szumy (znacznie większe). Potem próbujesz wyciągnąć bardzo ogólne wnioski. Nie tędy droga

Wydaje mi się, że tędy droga - musiałbym nie próbować żeby się nie mylić

Ale akurat tutaj moim zdaniem się nie mylę. Zamiast pisać "inne szumy (znacznie większe)" napisz jakie to inne szumy są większe - będziemy wtedy rozmawiać o konkretach. Nie boję się krytyki, ale niech ona będzie konstruktywna.

Ale akurat tutaj moim zdaniem się nie mylę. Zamiast pisać "inne szumy (znacznie większe)" napisz jakie to inne szumy są większe - będziemy wtedy rozmawiać o konkretach. Nie boję się krytyki, ale niech ona będzie konstruktywna.

Szum odczytu podawany przez producenta jest efektywnym szumem odczytu. Zawiera w sobie łącznie cały szum układu m.in "dark noise", "ADC noise" i "amplifier noise" i cokolwiek jeszcze konstrukcja danego sensora wprowadza. Z tego powodu jego charakterystyka od gaina nie jest trywialna (dark noise jest stały, amplifier noise zależy od gaina, etc). Na potwierdzenie odsyłam do EMVA 1288 pkt 2.2 Noise Model.

Jedyny szum nie uwzględniony w read noise to shot noise - jest to szum samego sygnału elektromagnetycznego, taka fizyka światła. Jak pisałem dla tego szumu rms = sqrt(signal) i jest wzięty pod uwagę przy moim wyliczeniu SNR.

-

12 minutes ago, Behlur_Olderys said:

Jeśli robisz precyzyjną fotometrię różnicową to nie obchodzi Cię rozpiętość tonalna, tylko jaką bezwzględną różnicę w sygnale uda Ci się zaobserwować.

Wydaje mi się, że wtedy 16bitów robi dużą różnicę.

Jeśli z 16 bitów 3-4 bity to szum (13e- w przytaczanym SBIGu), efektywnie mierzysz 12-13 bit na klatce. Oczywiście przez stackowanie wytniesz ten szum, ale przez to samo stackowanie powiększysz głębię 12 bitowej matrycy o znacznie mniejszym szumie. Trzeba by policzyć, które da lepsze rezultaty przy tej samej ilości materiału (ale tutaj chyba wchodzi Shannon, Nyquist, entropia - więc cytując klasyka "duża kuweta").

-

No to spory skok - z 3 kanałów w kamerze kolor od razu na 7 kanałów

Bezpośrednio od ZWO taki zestaw (z ich filtrami) to $1939–$2139 (w zależności od wielkości filtrów). Do tego dolicz 23% VATu i zostajesz bez budżetu na tubę.

-

32 minutes ago, rambro said:

wysokiej jakości przetwornikiem ADC o 16 bitach

Tutaj nie jestem pewien stwierdzenia, ale po co 16 bitów jeśli rozpiętość tonalna to i tak 12 bitów.

-

14 minutes ago, Adam_Jesion said:

Tylko w "tanim" segmencie.

Czy tak jest? Porównywana tutaj STL-11000 nie jest jednoznacznie lepsza - (moim zdaniem jest inaczej ale) załóżmy remis. ASI1600 jest 5.5 raza tańsza niż STL-11000. Znasz rynek dużo lepiej, więc popraw mnie jak się mylę bo nie robiłem głębokiego researchu (nie ma moją kieszeń) - ale chyba w segmencie 3000-8000PLN wygrywa CMOS, później w segmencie 10-40k CMOSów nie ma, więc CCD walkowerem. Później znowu CMOS.

-

Cool czy Pro? Pro ma huba + podgrzewaną szybkę.

2 minutes ago, Pav1007 said:Ha, OIII i SII do narrowbandu

Chyba lepiej zacząć od LRGB, a narrowband później - czy się mylę?

-

43 minutes ago, wessel said:

Nic poza tym że wymiękam. Nie ogarniam. (...) zrobił się tak skomplikowany że prawie bezużyteczny dla greenhornów...

Zakres matematyki potrzebny do ogarnięcia kończy się na potęgach, pierwiastkach i logarytmach. Załączyłem też jak to się liczy, a nie puste liczby. Po to jest forum, żeby pytać jak czegoś nie rozumiesz - jeśli oczywiście chcesz wiedzieć, bo w pełni szanuję, że:

1 hour ago, wessel said:wiedza teoretyczna zdecydowanie przewyższa moje potrzeby

Ja lubię wiedzieć jak coś działa, zwykle zbyt dokładnie jak na potrzeby normalnego użytkowania - po prostu mnie to kręci. Pisząc w tym wątku założyłem, że są inni użytkownicy, którzy znajdą to przydatne, jeśli nie to dajcie znać - mogę przestać pisać

PS: moje zdjęcia nigdy się nawet nie zbliżą jakością do fotek Pawła, Adama czy Maćka (kolejność przypadkowa), ale to chyba forum astronomiczne, a nie tylko astrofotograficzne

-

1

1

-

-

11 minutes ago, Adam_Jesion said:

No jak? Przecież wiele CCD ma studnię grubo powyżej ekwiwalentu16 bitów (mój KAF16803 miał 100 000e~). Bardziej zaawansowane CMOSy też zaczynają przebijać 65K. FLI Kepler na którego aktualnie czekam ma 72 000e~.

Jeśli w tym KAFie FW=10k e- a przetwornik to 16bit to trochę lipa, że nie było możliwości regulowania gaina. Moje uogólnione stwierdzenie dotyczyło tylko tych, które mają większą rozdzielczość przetwornika niż FW.

Ale masz rację - należało by to sprawdzić przed napisaniem. Poprawiłem wpis.

-

39 minutes ago, Behlur_Olderys said:

A co z gainem dla CCD? Tam też chyba jest taki parametr....

Plus przydałby się jeszcze jakiś jeden CCD do porównania, żeby było przynajmniej 2 vs 2

Gain w CCD jest zwykle stały. Powód dlaczego tak jest jest banalny - większość CCD ma większą rozdzielczość przetwornika (16bit = 65 536) niż studnię (np 50 000 e-). Dlatego nie ma sensu skalować sygnału, bo cały zakres FW mieści się w ADC. Gdyby takie CCD miały zmienny gain, to jedyne co on by robił to ograniczał DR bez żadnego wpływu na inne parametry.

Ale zróbmy proste ćwiczenie dla 11000M

FW = 50 000 e- ADC = 16 bit = 65 536 ADU system gain = 50 000 / 65 536 = 0.76 e- / ADUwg. danych producenta to 0.8 e-/ADU, więc się zgadza.

Co do jeszcze jednego CCD, nie brałem przy zakupie tych kamer pod uwagę - więc nie bardzo orientuję się w modelach. Wybrałem jeden, który przewijał się w tym wątku. Jak ktoś poda jakikolwiek inny to dopiszę do Excela do porównania.

-

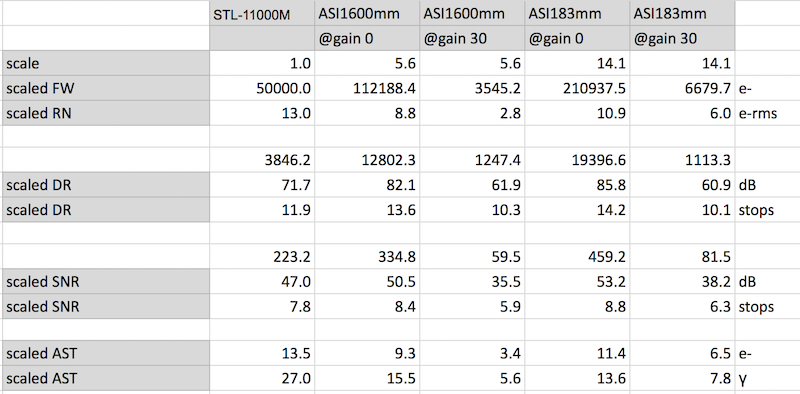

Bardzo ważnym parametrem, który nie jest brany pod uwagę w powyższych wyliczeniach jest wielkość piksela. Przykładowa CCD ma ten piksel 5x większy od ASI1600 i aż 14x większy od ASI183.

Ponieważ to ma być porównanie, powinniśmy porównywać jabłka do jabłek, a nie pomarańczy. Jak to zrobić, otóż można wyskalować parametry CMOSów w stosunku do wielkości piksela. Gdyby różnice wielkości były całkowite (np 4x 9x etc) miało by to nawet sens praktyczny i oznaczałoby np. softwareowe przeskalowanie obrazu. Różnice nie są całkowite, więc porównanie jest bardziej teoretyczne.

Teraz robi się ciekawie. Po wyskalowaniu okazuje się, że zarówno DR jak i SNR (przy gain 0) są wyższe dla CMOSów. Co więcej (aż się boję to napisać) obydwa CMOSy mają głębszą studnię. Jest jednak jedno ale... skalując np asi1600 o 5.6x wynikowa rozdzielczość to będzie tylko ok 0.5Mpix, wynika to z faktu, że matryca w 11000M jest FF, podczas gdy 1600mm to 4:3 (a 183mm to 1"). Gdyby martyce w CMOSach miały podobną wielkość do przykładowego CCD, a przy takim pikselu odpowiednio większą rozdzielczość - porównanie to miało by dużo większy sens.

Dzisiaj mógłbym pewnie skonkludować, że CMOS jest bardziej czuła i ma większą rozpiętość, podczas gdy CCD wygrywa głębokością studni i większymi pikselami.

-

Cześć,

skoro temat został odgrzany... zastanowiło mnie to stwierdzenie:

On 8/14/2016 at 1:16 AM, Paether said:CMOS różnią się od CCD tym, że teoretycznie posiadają mniejszą czułość i dynamikę rejestracji obrazu

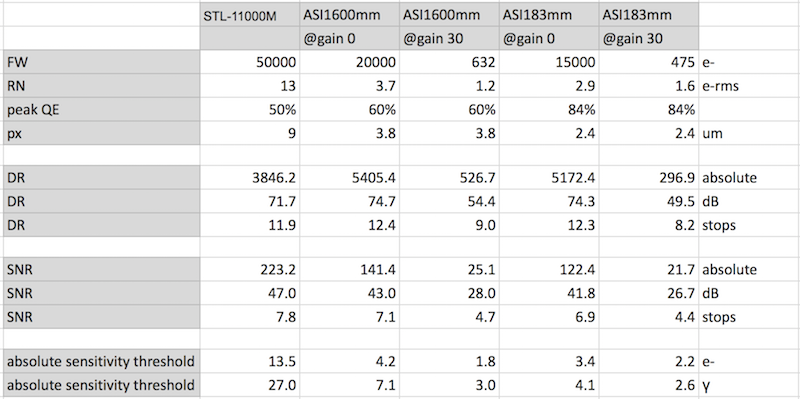

więc postanowiłem zrobić porównanie. Wiem, że istnieje aktualnie "święta wojna" pomiędzy zwolennikami CCD i CMOSa - dlatego oprę się po prostu o parametry podane przez producenta, bez wchodzenia w łatwość obsługi i uzyskania dobrego efektu. O gustach nie będę dyskutował.

Jeśli ktoś znajdzie błędy w obliczeniach - proszę pisać, nie roszczę sobie prawa do nieomylności.

Pierwsze wyjaśnienie czym różni się dynamika tonalna od sygnału do szumu (DR vs SNR). Obydwa parametry są stosunkiem sygnału (FW) do szumu, z tą różnicą, że DR nie bierze pod uwagę "shot noise" (szum samego sygnału elektromagnetycznego, który ma rozkład Poissona, więc odchylenie standardowe to sqrt(FW)), podczas gdy szum ten jest brany pod uwagę w obliczeniu SNR.

DR = FW / RN SNR = FW / sqrt( FW + RN^2)DR pokazuje nam jakie największe różnice w sygnale możemy zarejestronać, a SNR jak sensor zachowa się w warunkach pełnego naświetlenia.

Co oznacza, że jedna kamera jest bardziej czuła od drugiej. Można to rozumieć na kilka sposobów, ja przyjąłem wyliczenie minimalnej ilości fotonów, które zostaną zarejestrowane. Parametr ten to "absolute sensitivity threshold", czyli przy jakiej ilości sygnału będzie go więcej niż szumu (SNR >= 1).

SNR = signal / sqrt( signal + RN^2) signal / sqrt( signal + RN^2) = 1 signal = sqrt( signal + RN^2) signal = (1+SQRT(1+4*RN^2))/2Co możemy wywnioskować z powyższych wyliczeń:

- przy gain=0 obydwa CMOSy mają większą rozpiętość niż CCD, w miarę wzrostu gain stosunek ten się zmienia

- ze względu na większą studnię, CCD ma lepszy stosunek sygnału do szumu (prawie dwukrotnie)

- CMOSom wystarczy dużo mniej fotonów, żeby cokolwiek zarejestrowały. ASI1600mm@gain0 potrzebuje ich 7, gdy 11000M potrzebuje ich aż 27

c.d.n.

-

11 minutes ago, LibMar said:

ASI178 ma dokładnie zakres 0-510, poziom ISO wyniósłby między 100 a ~25000

Takie założenie jest błędne, nie możesz zakładać, że gain 0 == ISO 100. Co więcej, gain jest w skali logarytmicznej (jak poniżej gain+100 = 3.16x) a ISO jest w skali liniowej (ISO400 = 2x ISO200 = 4x ISO100).

Gain w ASI jest wyrażany w 0.1dB, czyli wzrost gainu o 100 oznacza wzrost wzmocnienia o 10dB. Przechodząc z dB na skalę liniową

20 * log (a/b) = 10 log (a/b) = 1/2 a/b = sqrt(10) a/b = 3.1610dB = 3.16x - więc zgadza się z Twoimi pomiarami.

11 minutes ago, LibMar said:W lustrzankach wartość ISO zaczyna się zwykle od 100 i chyba to tylko wartość umowna...

Lustrzanki zostały zrobione dla fotografów. Oni posługiwali się skalą ISO dla filmu. Przeliczono po prostu QE i gain dla danego aparatu na ISO i to widnieje na lustrzankach.

-

2

2

-

-

PS: w EMVA 1288 ten parametr nazywa się "ABSOLUTE SENSITIVITY THRESHOLD", czyli przy jakiej ilości fotonów SNR jest równy 1.

-

Moim zdaniem to trochę inne parametry.

2.7 lux oznacza, że najsłabszy sygnał jaki zarejestruje kamera to 2.7 luxa. Należałoby wyliczyć ile to fotonów na powierzchnię piksela. Pewnie @Behlur_Olderys może tutaj pomóc

Teraz CMOS (w CCD jest podobnie), bierzemy ilość fotonów, mnożymy przez QE i wiemy ile z tych fotonów nam wyjdzie elektronów. Teraz bierzemy szum odczytu (z danych producenta) i musimy mieć więcej elektronów niż szum odczytu + "shot noise" (sqrt(sygnal)), to będzie oznaczać, że zarejestruje się sygnał.

Dla ASI1600mm przy gain 0:

read noise = 3.7 e-rms

shot noise = sqrt(e) e-rms

e = sqrt(3.7^2 + e)

e = 4.23 e-

QE=60%

f = 7 fotonów

Dla ASI1600mm przy gain 30db:

read noise = 1.2 e-rms

shot noise = sqrt(e) e-rms

e = sqrt(1.2^2 + e)

e = 1.8 e-

QE=60%

f = 3 fotony

ISO w kamerach cyfrowych jest parametrem sztucznym. Chodzi tylko o to żeby QE i gain zamienić na wartość podobną jak była używana przy kliszy. Pewnie da się znaleźć gdzieś przelicznik na luxy czułości.

-

30 minut było dla przykładu - może być 300 minut, 600 minut i ile tam sobie chcesz.

Co do SNR to się nie wystarczająco jasno wyraziłem - porównujmy SNR przy tej samej ilości informacji (np przez downscaling, albo jakkolwiek inaczej, żeby nie było bez sensu).

-

Dobra - przepraszam, ale spróbuje ostatni raz, i po tym się zamknę. Trudno nam się zrozumieć, a mam wrażenie, że się już mną irytujesz, a nie o to mi chodzi.

Masz 2 identyczne kamery (ten sam sensor), jedna kolor, druga mono + filtry. Każdą robisz łącznie 30 min akwizycji. Wg. własnego uznania wybierz ile klatek na której i w jakiej proporcji filtry tak żeby bez sensu nie kaleczyć - ważne, żeby łączny czas akwizycji był taki sam, tutaj przykładowo 30min.

Materiały składasz na zdjęcie w kolorze, które będzie miało większy SNR?

-

1 minute ago, wessel said:

Przepraszam autora wątku za offa.

Autor wątku zastanawia się nad kolor vs mono - więc zakładam, że ta dyskusja jest dla niego użyteczna.

1 minute ago, wessel said:Nie. Zapominasz o luminancji.

Nie zapominam. W kamerze OSC masz lunimację - nie masz. Jest wyliczana cyfrowo z kanałów RGGB. Możesz zrobić to samo (wiem, bez sensu) dla mono dla tego samego efektu.

-

Czyli doszedłeś do pytania-konkluzji z mojego pierwszego posta w tym wątku w odpowiedzi na Pawła:

2 hours ago, Pav1007 said:To zależy. Jak masz czas palić 3x dłużej

Mono nie oznacza, że palisz 3x dłużej. Żeby uzyskać te same rezultaty (a nawet lepsze) musisz palić łącznie tyle samo w mono co w OSC. Tak?

-

Bo w kamerze kolor jest go 2x więcej (RGGB) a chcę porównywać jabłka do jabłek. W kosmosie zielonego jest mało, ale kamery kolorowe go zbierają tak czy siak.

Co znaczy, że materiał lepszy - ogólnie większy szczegół, co przy tej same rozdzielczości, warunkach (w tym focus) chyba oznacza po prostu większy SNR.

Jak uzyskam odpowiedź, która przy takich samych warunkach da lepsze rezultaty, to oczywiście kolejnym pytaniem jest czy w mono da się to pod-tweakować (np przez zamianę jednego G na L). Ale to krok kolejny.

-

13 minutes ago, wessel said:

UPSCALING I DEBAYERYZACJA NIE DODADZĄ CI BRAKUJĄCYCH SZCZEGÓŁÓW!.

Przecież to pisałem - że kolor ma 4x mniejszą rozdzielczość.

Próbuję zrozumieć procesy, dlatego stosuję uproszczenia, nie lubię "działać w ciemo" - ale ok, rozumiem, że teoretyczne rozważania mogą wydawać się bez sensu. Przejdźmy do czysto praktycznego pytania:

1. Zbieram np 10+20+10 min RGB na mono i składam kolor (luminację odzyskuję z RGB).

2. Zbieram 40 min na kamerze kolor.

Który materiał będzie lepszy i dlaczego?

-

@wessel przepraszam, ale pogubiłem się

Dla uproszczenia załóżmy hipotetyczną sytuację: kamera kolorowa i kamera mono o dokładnie tych samych parametrach sensora z hardwearowym bin2 (żeby nie wchodzić w szczegóły szumu odczytu).

1. Robię akwizycję kolor - np 40 min

2. Robie akwizycję mono w bin2 - 10min R, 10min B, 20min G

Składam cyfrowo klatki mono tak jak to fizycznie robi filtr Bayera. Czyli na kwadrat 2x2 po 1+1+2 piksele z kanałów, rozdzielczość wzrasta x2 w każdym wymiarze. Pomijając jakość maski Bayera, wynik powinien być ten sam z kolorowej i mono.

Teraz, jeśli na masce Bayera są ramki jak piszesz, które zabierają 15% światła, to jest jeszcze gorzej dla kolorowej. Na mono mógłbym zbierać o 15% mniej materiału dla tego samego efektu. Tak czy nie?

-

Co do rozdzielczości to się nie mogę zgodzić - przecież ta rozdzielczość jest fizycznie mniejsza w kamerze kolorowaj i jest cyfrowo (przy debayeryzacji) upskalowana. Można by z klatek z mono złożyć obraz raw taki jak wychodzi z kolorowej przed debayeryzacja (należałoby zrobić bin2). Będzie niewielka różnica na SNR przez szum odczytu, bo kolorowa ma niejako bining hardwearowy a cmos mono miałaby softwareowy.

Co do jakości filtrów to pewnie masz tutaj rację. Poczytam o transmisji na masce Bayera i na porządnych filtrach LRGB.

-

1 hour ago, Pav1007 said:

Jak masz czas palić 3x dłużej

Czy to zawsze jest case - poważnie pytam o doświadczenie? Skoro kolorowa ma ten sam sensor tylko o 1/4 pikseli mniej na R i B a o 1/2 pikseli mniej na G, tzn że każdy z kanałów odbierze proporcjonalnie mniej sygnału. Czyli w teorii jeśli zastosujesz te same czasy (zeskalowane) na kanał w mono i odzyskasz luminację z RGB (tak jak to robi kolorowa) to efekt wyjściowy powinien być taki sam.

-

Ogólnie do DSow mono lepsza. Poczytaj co pisał koles z astrobackyard - przez długi czas używał kolorowej kamery i nie widział z tym problemu, po czym dostał mono do testów.

Matryce CCD i CMOS

w Dyskusje o sprzęcie

Opublikowano · Edytowane przez Sebo_b

Wciąż dla mnie nie jest jasne, tego "znacznie większego" szumu nie wziąłem wg. Ciebie pod uwagę? Przy DR nie wziąłem, bo się go pod uwagę nie bierze, przy SNR jest wzięty pod uwagę. SNR dla STLa i 1600 są też "dość" podobne.

Nie wiem co tutaj odkryłeś, po tym co już napisane.

shot noise rms 16bit = sqrt( 2^16) = 2^8 = 256

shot noise rms 12bit = sqrt( 2^12) = 2^6 = 64

SNR będzie odpowiednio 256:1 i 64:1, bądź 48dB i 36dB

Po zastanowieniu się, nie jestem pewien tego stwierdzenia - ale nie jestem w stanie z marszu się ustosunkować.

Pozdrawiam.