-

Postów

5 172 -

Dołączył

-

Ostatnia wizyta

-

Wygrane w rankingu

12

Typ zawartości

Profile

Forum

Blogi

Wydarzenia

Galeria

Pliki

Sklep

Articles

Market

Community Map

Treść opublikowana przez Behlur_Olderys

-

Sky-Watch MAK-127 astrofoto - niezbyt ostre zdjęcia

Behlur_Olderys odpowiedział(a) na ajarosz temat w Dyskusje o astrofotografii

Moim zdaniem gwiazdy w środku kadru to przynajmniej częściowo kwestia seeingu: 1500mm ogniskowej + piksel 6um = skala poniżej 1"/px. A seeing w Polsce jest różny, raz większy raz mniejszy, ale mniej niż 1" to chyba nigdy -

Wspomniany bolid w świetle podczerwonym - całe szczęście Perseidy (i pewnie w ogóle meteory) świecą wcale nienajgorzej powyżej 700nm: Tak się prezentuje pojedyncza klatka 60s z ASI120mm + obiektyw 2.8mm + filtr Astronomik 642 Planetary (pasmowy, od 642 do ok. 850nm) Zdjęcie robione z okolicy Kapelanki adres obrazka: https://slidetodoc.com/presentation_image/d829d10f895dc5b45a89a3f6e802238d/image-55.jpg

-

Siedziałem do 2 za blokiem koło rzeki. Miejscówka fajna bo nikt tam nie chodzi, ale wilgoć jest niesamowita, i musiałem się zbierać z mokrymi akcesoriami. W paśmie VIS klatki były prześwietlone, totalny gradient i odblaski przy krótszych czasach, więc zbierałem w I (700-900nm) w którym LP wygląda jeszcze znośnie. Poza bolidem o którym wspomniałem niewiele się jednak złapało malutkim obiektywem 2.8mm. Po 2 wystawiłem jeszcze 8mm obiektywik na balkon. Zmiana ogniskowej a więc i apertury dała w efekcie znaczny wzrost czułości, ale kierunek zachód to parada satelitów i żadnego Perseida. Tak czy inaczej uważam wydarzenie zaliczone pozytywnie - widok tego pofalowanego śladu świecącego jeszcze długo po przelocie jest niezapomniany.

-

To jest podręcznikowa definicja Maka 127 na montażu azymutalnym

-

Przed chwilą chyba bolid w okolicy Perseusza, niezbyt długi, szedł na wschód jaśniejszy niż Jowisz na pewno, został za nim falisty ślad jeszcze z 10s widoczny. Piszę to z centrum Krakowa

-

Uwzględnianie fluktuacji atmosfery bez optyki aktywnej.

Behlur_Olderys odpowiedział(a) na atnerun pytanie w Pytania: Różne

A jak to liczyłeś? Proszę powiedz - ja się w sumie nad tym nie zastanawiałem. Jest jakiś wzór? Zakładam, że wielkości obrazów gwiazd na matrycy za sensorem Hartmanna są dużo większe, niż piksele, więc wchodzi w grę bardzo dokładne liczenie środka ciężkości takiego "placka" na poziomie subpikselowym, pewnie z dokładnością 0.1px tak jak to jest w guiderach... Epsilony w Lutni to jakieś mag 4. Nagrywałem je kiedyś aparatem - zwykłym DSLR na 25FPS - z Maka 127, latem. Były gdzieś w 1/4 histogramu od lewej. To tak, jakbym nagrywał je 10FPS z obrazem rozwalonym na 2.5 soczewki. Chciałbym mieć przynajmniej 12 soczewek, więc 5x więcej, zatem obraz będzie 5x słabszy. Wydaje się więc, że przy zastosowaniu dobrej, chłodzonej kamerki CMOS z dużym gainem i lustra w rodzaju 300mm czujnik Hartmanna powinien spokojnie dać radę rejestrować gwiazdki w rodzaju 4-5mag. Najlepiej byłoby wziąć dane z jakiegoś realnego teleskopu. Ja przed chwilą czytałem o 18 microlensach dla 3.5 teleskopu dającego do wykorzystania gwiazdki 13mag przy 300Hz. (https://arxiv.org/ftp/arxiv/papers/1607/1607.05575.pdf - może coś źle zrozumiałem?) W takim razie teleskop 12x mniejszy (144x mniejsza apertura ale i 30x wolniej sczytujący) powinien w podobnej konfiguracji (18microlens) dać radę z gwiazdkami nawet 10 mag. Jak to ugryźć? -

Uwzględnianie fluktuacji atmosfery bez optyki aktywnej.

Behlur_Olderys odpowiedział(a) na atnerun pytanie w Pytania: Różne

Hahaha no oczywiście, choć stawiałbym że będzie to jakaś liniowa zależność w takim otoczeniu (500nm a 700nm to nie aż tak daleko). W końcu zielony laser dałby Ci informację o 500nm ale użyteczną i dla 400nm i dla 600nm, prawda? Inna sprawa to że najlepiej byłoby też w ogóle obserwować w IR, żeby wyeliminować w dużej mierze LP, zmniejszyć skalę czasową seeingu i zwiększyć kąt izoplanarny (czyli obszar w jakim AO "zadziała"). To kolejny argument za tym, że więcej można ugrać dużym lustrem z kamerką w SWIR, niż bawiąc się w domowe AO. -

Uwzględnianie fluktuacji atmosfery bez optyki aktywnej.

Behlur_Olderys odpowiedział(a) na atnerun pytanie w Pytania: Różne

Przepraszam za post pod postem, ale coś jest nowego na Thorlabs i muszę się podzielić: https://www.thorlabs.com/newgrouppage9.cfm?objectgroup_id=14638 Siatka 10x10mm dosyć sporych mikrosoczewek (1 x 1.4 mm). Jakieś 60-70 mikrosoczewek. Na sensorze w rodzaju ASI120mm zmieści się kilkanaście, ale moim zdaniem to już wystarczy, żeby idea detektora czoła fali była zrealizowana. Zmierzymy na pewno kilka podstawowych modów. Oczywiście lepiej mieć większą matrycę. Jedną z przeszkód mechanicznych jest krótka ogniskowa - 4.7mm. Trzeba by wybebeszyć kamerkę trochę. Ale cena, cena, cena! Najtańsza opcja - bez coatingu, bez oprawy - to 30 EURO!!! Właściwie kupiłbym teraz dla zabawy, gdybym miał więcej czasu To gdzie jest haczyk? Niestety, nawet ta biedna konfiguracja powoduje że dla sensownej detekcji frontu fali potrzebne jest źródło, które z docelową częstotliwością (przynajmniej te 10Hz jak w SBIG AO, choć osobiście uważam, że przyzwoite minimum to 30Hz) będzie dawało światło tak silne, że zarejestruje je nasza kamerka i to już po podziale na kilkanaście części (tyle, ile mamy mikrosoczewek). Załóżmy więc 12 mikrosoczewek i 10Hz - totalne minimum. Zatem tak, jakby realnie pełną aperturą rejestrować na matrycy jedną gwiazdę z czasem naświetlania ok. 8ms. Teraz czy jest taka gwiazdka w polu widzenia? Notabene, jeszcze mi przyszło do głowy: Laser do sztucznej gwiazdy nie jest takim głupim rozwiązaniem, jeśli byłby to laser np. w podczerwieni, poza 700nm raczej nikomu by nie przeszkadzał. Ale i laserowe gwiazdy mają swoje problemy... Puszka Pandory -

Uwzględnianie fluktuacji atmosfery bez optyki aktywnej.

Behlur_Olderys odpowiedział(a) na atnerun pytanie w Pytania: Różne

https://www.thorlabs.com/NewGroupPage9_PF.cfm?ObjectGroup_ID=2861 Taka macierz + kamera + beamsplitter to już przepis na działający czujnik czoła fali. Trzeba tylko mieć właśnie duże lustro, żeby było dość światła i żeby efekt był zauważalny, bo na 200mm lustrze to moim zdaniem byłoby widać leciutkie falowanie PS jeszcze (piezoelectric 3axis stage, max częstotliwość >100Hz) to z Thorlabs, kombinerki w rękę i voila, proste AO mamy gotowe: https://www.thorlabs.com/thorproduct.cfm?partnumber=MAX311D#ad-image-0 -

Uwzględnianie fluktuacji atmosfery bez optyki aktywnej.

Behlur_Olderys odpowiedział(a) na atnerun pytanie w Pytania: Różne

Rozumiem że przed tą zwykłą kamerą stała macierz mikrosoczewek, bo bez tego to nie wiem, jak miałoby to działać. Ludzie, zróbcie coś Ostatnio widziałem projekt uczelniany, mieli poważne problemy z *jednym* aktuatorem piezoelektrycznym służącym jako chopper - nie wracał dokładnie do poprzedniej pozycji. Liczba takich problemów razy 100 a potem jeszcze do kwadratu, i mówimy o czasie, za który nam nikt nie zapłaci. A efekt? Bez metrowego lustra efekt będzie - moim zdaniem - niewarty niczego. BTW: Właśnie dużo taniej i lepsze efekty naukowe można uzyskać idąc w podczerwień czy to bliską czy termiczną, a jednak nikt tego nie robi? Do bliskiej potrzeba tylko dużego RC-ka i kamery za 10k zł. Dla kogoś, kto ma skolimowany działający zestaw z RC-kiem to tylko kwestia wymiany kamery, a jednak nikomu się nie chce tego robić. Dla dalekiej podczerwieni to kwestia dobrej kamery (od biedy można wypożyczyć FLIR Tau czy coś), jednego choppera i trochę lepszego montażu, nieco więcej zachodu i zabawy w mechatronika, ale i tak dwa rzędy wielkości łatwiej, niż AO. Tego też nikt nie robi nie tylko w Polsce. AO to moim zdaniem piramida kosztów i czasu, a efekty - hm... I tak lepsze osiągnie się po prostu stawiając swój teleskop w Chile, a takie rzeczy ludzie przecież robią już od dawna. AO od SBIGa to to samo, co Lucky Imaging, w sensie: jest to korekcja tip&tilt. Lucky Imaging robi to softowo, bo ma krótkie klatki, a działające tip&tilt robi to online, przez co można jechać dłuższe klatki. A czemu nikt nie ma AO od SBIGa, czemu nikt się tym nie chwali? Przecież to tańsze niż chałupnicze AO... Notabene: do wszystkiego, na czym działa Lucky Imaging dodawanie AO mija się z celem. Przypominam, że dla 500nm zakres poprawy seeingu dla AO to kilka sekund łuku. A zatem mówimy o jakichś ciemnych, małych planetarkach albo galaktyczkach, może Neptun. Biorąc pod uwagę mnóstwo innych celów, to tak naprawdę sztuka dla sztuki. Mój post brzmi bardzo krytycznie, chociaż uważam, że generalnie idea jest jak najbardziej pociągająca i realna. Tylko to nie zadanie dla amatorów jak ja, którzy w wolnym czasie pomiędzy pracą a dziećmi dłubią sobie w EQ3-2 używając sprzętu za kilkadziesiąt złotych z Ali. To jest zadanie dla grupy osób na pełny etat, kilka miesięcy, pracy mechanicznej, elektronicznej, programistycznej, realizacja optyki, kupno komponentów, opracowanie jakiegoś planu i teorii, zgranie w czasie, ułożenie pracy w sensowny sposób. Czas to pieniądz, więc chyba trzeba poczekać na polskiego Elona Muska PS Jeszcze żeby nie było aż tak krytycznie: Najważniejsze mody dystorsji obrazu (Zernike modes) to po kolei: - tip & tilt - defocus - astygmatyzm - koma SBIG robi tip&tilt, choć dosyć wolno (10Hz, przydałoby się 50Hz, ale już niech będzie) Defocus można załatwić podobnie przy użyciu czegoś na kształt szybkiego autofocusa. Czyli trzeba byłoby mieć taki focuser, żeby można było ostrość zmieniać kilkadziesiąt razy na sekundę. To już jest dużo bardziej realne, niż pełnoprawny AO na deformowalnym lustrze. Jeśli ktoś chciałby się zająć na poważnie AO to proponowałbym zacząć od tego i przede wszystkim zaprezentowanie realnego zysku w warunkach amatorskich przy stosowaniu takiej korekcji w porównaniu do braku tejże... -

A ja się podłączę do tematu: Mam T7C, i przez większość czasu zrzuca mi "przełamane" klatki, tj. jakby część obrazu była zamieniona stronami, dodatkowo kolory są popsute (pewnie przesunięcie pikseli psuje debayeryzację). Jak coś poklikam w SharpCapie to na chwilę mam dobry obraz, ale po jakimś czasie niestety problem powraca. Czy to można naprawić jakimś softem, albo zmianą kabla, czy kamerka już do wyrzucenia?

-

Jak zamontować enkoder do EQ3-2?

Behlur_Olderys odpowiedział(a) na Behlur_Olderys temat w ATM, DIY, Arduino

Użyłem do tego DSS: Nagrywam normalnie Sharpcapem fotki co 6s. Wkładam to do DSS, który alignuje zdjęcia i oblicza ich przesunięcia z subpikselową precyzją. A potem mielę wyniki skrypcikiem w pythonie. W przypadku jednej gwiazdki w polu widzenia zrobiłbym tak: okroił FOV tylko do tej jednej, mierzonej gwiazdki zamienił zdjęcie na mono (jeśli jeszcze nie jest) obliczył środek masy (czyli średnia ważona kawałka w którym jest gwiazda przy czym wartości uśredniane to połoźenie pixela a waga to jego wartość) Taki środek masy to już bardzo fajna, precyzyjna metryka. Kiedyś pisałem do tego soft, python + numpy robią cuda. Pozdrawiam -

Wygląda na to, że kolory wychodzą różne w zależności od ostrości - takie to uroki achromata. Wczoraj ustrzeliłem kilka klatek Albireo. Kolory wydają mi się ładne, ostrość była taka, jak widać. Być może zejście z f/5.6 do f/8 pomogło trochę. Muszę przesiąść się na Samyanga 57x20s, QHY462C, Tair3s f/8, EQ3-2 modyfikowane.

-

Jak zamontować enkoder do EQ3-2?

Behlur_Olderys odpowiedział(a) na Behlur_Olderys temat w ATM, DIY, Arduino

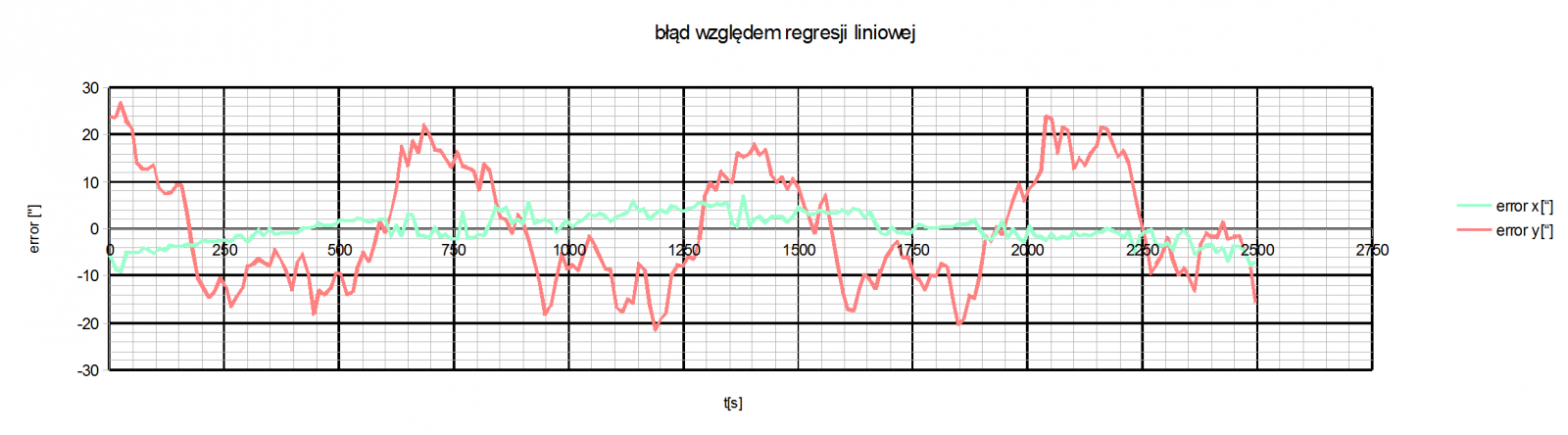

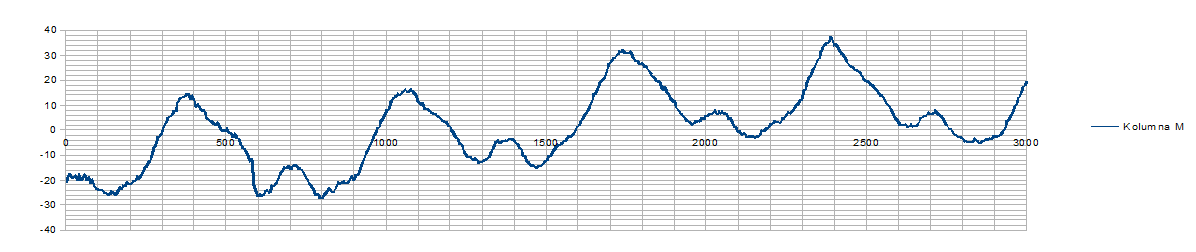

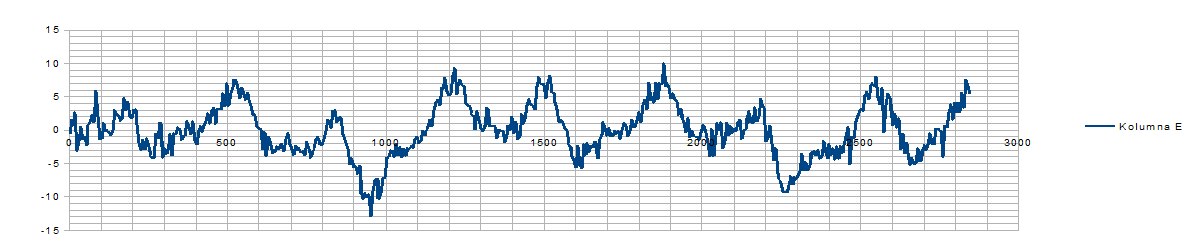

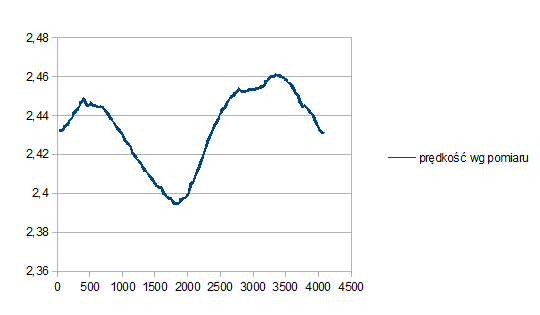

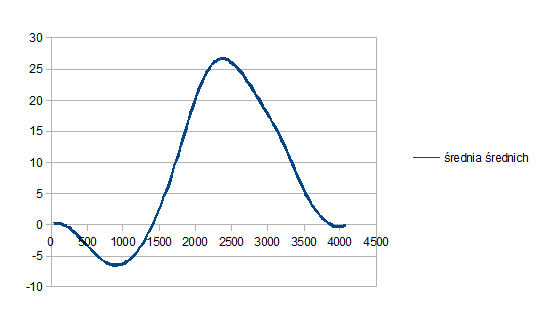

Odświeżam temat: Sukces! ...no może taki połowniczy sukces, ale ogólnie udało się mi zrobić to, co chciałem Zacznę od wykresów, które wszystko opowiadają: Przed włączeniem "ślepej" korekcji na enkoderze: Po instalacji enkodera i załączeniu korekcji "na ślepo": I wreszcie po - testowej i nieudolnej, ale jednak - korekcji prędkości ślimaka względem tego, co zarejestrowano wcześniej: (RMS ok. 4") Wiem, są piki, są szarpnięcia, ale wydaje się, że z takim PE można powoli się zaprzyjaźnić i jechać naprawdę długie klatki np. Samyangiem 135mm. No i ustawianie na biegun jest *dużo* łatwiejsze metodą dryfu. Ogólnie uważam, że jest miejsce do poprawy i będę chciał popracować nad adaptatywną wersją tego algorytmu - tj. po każdej sesji update'ować program sterujący tak, żeby zawsze podstawą do korekcji były ostatnie pomiary. Ale na razie jest dobrze Matematyka polega na wyznaczeniu funkcji zmierzonej prędkości nieba względem realnego odczytu ślimaka na enkoderze. Ta funkcja mówi, o ile ruszy się naprawdę montaż przy przesunięciu ślimaka o stały kąt na enkoderze. Idealnie powinno to być 1296000"/(130*4096) = ok. 2.434. bo 130 zębów ma ślimak, 4096 odczytów daje enkoder, a cały obrót to 1296000 sekund łuku. Zasadniczo policzenie tej funkcji sprowadza się do policzenia pochodnej z bezwzględnej, zmierzonej pozycji montażu po "tikach" enkodera. Jest to mechanicznie mówiąc model przekroju ślimaka - jego niesymetryczności. Realnie jest to funkcja zmieniająca się mniej więcej tak: Niezbyt duże wahania a już psują Jest to w uproszczeniu pochodna tego wykresu - czyli błędu prowadzenia względem odczytu enkodera: Po obliczeniu realnej prędkości ślimaka w zależności od kąta wystarczyło wyliczyć interwały, w jakich należy oczekiwać kolejnych "tików" enkodera. W przypadku idealnym te interwały są zawsze równe, ale po korekcji są zmodyfikowane, żeby pozycja "na niebie" i pozycja "wg ślimaka" się pokryły. Oczywiście służę wyjaśnieniami, gdyby ktoś był bardziej zainteresowany. Pozdrawiam -

Zimny napój w Krakowie

Behlur_Olderys odpowiedział(a) na Behlur_Olderys temat w Spotkania, zloty, wyjazdy i imprezy

no jasne, tylko trzeba dograć detale Ja akurat wyjeżdżam za tydzień, dlatego najwcześniej mogę po 21. sierpnia. -

Zimny napój w Krakowie

Behlur_Olderys odpowiedział(a) na Behlur_Olderys temat w Spotkania, zloty, wyjazdy i imprezy

Pierwsze koty za płoty. Klimat był kosmiczny Dzięki za spotkanie! Ale, ale, ale. Spójrzmy prawdzie w oczy: Wakacje się powoli kończą. Pandemia za pasem, 4 i 5 fala mogą pokrzyżować towarzyskie plany jesienno-zimowe, więc proponuję kuć żelazo póki gorące i jeszcze pod koniec sierpnia (dowolny, pochmurny dzień pomiędzy 23. a 31. VIII) proponowałbym zrobić... hm... wersję rozszerzoną spotkania Plan jest prosty: przyjść, napić się czegoś i pogadać @Tuvoc, @warpal, @Mareg, @M.K. - to tylko osoby, które nie mogły pojawić się w czwartek - ten termin (koniec sierpnia) byłby ok? Ogólnie z Krakowa i okolic na pewno jest sporo jeszcze forumowiczów, prawda? Oczywiście każdy niech się czuje zaproszony, może akurat jest na podróży służbowej ze Szczecina albo Suwałk? PS Do Egona moglibyśmy się już nie zmieścić, więc jak ktoś miałby fajną miejscówkę to proszę dać znać -

żaden. Tzn. UV/IR cut svbony. Takie wychodzą prosto z matrycy. Dodałem trochę saturacji, ale to tyle z moich ingerencji. Czerwone są bardziej jakby.... brązowe, prawda? Nie wiem czemu, może Tair3s tak robi, a może LP, a może nie wiem co EDITED: Najjaśniejsza gwiazda w kadrze to HD 187181 mag 8.81, typ widmowy A0

-

Przy okazji testów nagrałem prawie 2h materiału - same gwiazdki, w okolicy LDN798 ale oczywiście nie te warunki, nie te czasy, nie ta skala. Natomiast gwiazdki mi się podobają i jest fajny dosyć równomierny szum, więc wstawię w ramach referencji: co można zrobić prostym setupem ze środka miasta, jakie są wady krótkich czasów, małego pola kamerki i aberracji chromatycznej obiektywu. Tair 3s, QHY462C, EQ3-2 (modyfikowane) 1000x6s. Ze środeczka Krakowa DSS(stack), PixInsightLE (histogram wyrównałem), gimp (saturację tylko podbiłem)

-

Analiza spektralna pokazuje, że meteory to nie to samo, co zorza polarna. Tutaj są zaprezentowane widma meteorów, w tym Perseidów: https://www.aanda.org/articles/aa/pdf/2015/08/aa25047-14.pdf Tymczasem światło zorzy polarna ma zupełnie inny rozkład widmowy: https://www.windows2universe.org/?page=/earth/Magnetosphere/tour/tour_earth_magnetosphere_09.html W szczególności widmo meteorów zawiera linie żelaza, magnezu i sodu, które w atmosferze nijak nie miałyby się skąd wziąć. Zorza za to świeci intensywnie w pasmach tlenowych i azotowych, co jest zrozumiałe w atmosferze złożonej z .... azotu i tlenu. Główny "zielony" pik zorzy to tlen O I (557.7nm), a najczęstszy "zielony" pik w meteorach to magnez Mg I (518.2nm) @mikrokosmos klasyfikacji przedmiotów wg kolorów to dzieci uczą się w żłobku. Żaba jest zielona, a ryba niebieska... Zainteresuj się analizą spektralną, jeśli chcesz wejść na wyższy poziom dyskusji. Masz akurat tydzień na refleksję i spokojną lekturę. Jak mówisz, że Perseidy "są zielone" to tak, jakbyś mówił, że "ludzie noszą kapelusze": W zasadzie prawda: tak, niektórzy noszą kapelusze, ale nie wszyscy, nie zawsze, i rzadko jest to ich jedyny przyodziewek, a już na pewno nie znaczy, że ludzie są w zasadzie grzybami.

-

W takim razie kręcę gałką od mocy lasera aż dostanę laser o energii np. 1TeV/foton. Jest jakaś duża różnica między tym a podobnym strumieniem np. elektronów o energii 1Tev/elektron? W obu przypadkach energia kinetyczna >> masa spoczynkowa, więc masa jest pomijalnie mała dla praktycznych obliczeń czegokolwiek. A jednak strumień elektronów może istnieć a już strumień fotonów nie? I strumień elektronów na pewno grawituje, ale strumień fotonów to nie? Panowie, bądźmy poważni.

-

Hm... a laser?

-

Skąd wiesz czy tak nie jest? W końcu efekt może być niemierzalnie mały. Ja bym wolał zobaczyć wyniki obliczeń, a nie argumenty heurystyczne. Bo heurystycznie to gdyby fotony nie grawitowały to coś bardzo dziwnego działoby się kilkanaście miliardów lat temu, w Epoce Promieniowania. Np. anihilacja pozytonu z elektronem powodowałaby bardzo dziwną sytuację... Ale po co bawić się w machanie ręką. Proponuję wziąć metrykę Levi-Civita (opisującą cylindrycznie symetryczną czasoprzestrzeń), wyliczyć odpowiednie parametry np. dla strumienia elektronów poruszających się z prędkością 0.1c wzdłuż osi symetrii w tą i z powrotem. Następnie zbadać taką czasoprzestrzeń i sprawdzić czy nie dzieje się nic dziwnego, gdy stosunek energii do masy cząstek będzie dążył do zera.

-

Zimny napój w Krakowie

Behlur_Olderys odpowiedział(a) na Behlur_Olderys temat w Spotkania, zloty, wyjazdy i imprezy

Ja też -

Coraz głębiej do portfela: Część 2 - w dobie koronawirusa

Behlur_Olderys odpowiedział(a) na Paether temat w Sklepy Astronomiczne i Archiwum Giełdy

Tak, bo musisz mieć nowy telewizor iPhone a najlepiej jeszcze teleskop i kamerę -

Zimny napój w Krakowie

Behlur_Olderys odpowiedział(a) na Behlur_Olderys temat w Spotkania, zloty, wyjazdy i imprezy

Nie padła jakaś wprost alternatywa do tej pory, więc wydaje się że tak. To niezupełnie centrum miasta, z drugiej strony w taką pogodę to i tak w ogródku się nie posiedzi...