-

Postów

9 964 -

Dołączył

-

Ostatnia wizyta

-

Wygrane w rankingu

41

Typ zawartości

Profile

Forum

Blogi

Wydarzenia

Galeria

Pliki

Sklep

Articles

Market

Community Map

Odpowiedzi opublikowane przez MateuszW

-

-

1 godzinę temu, Loki napisał:

Ma to małe znaczenie, gdy robisz jakieś szerokie kadry ogniskową 50 czy 100mm. Ale jeśli jest 400mm i perspektywa całej nocy zbierania materiału, naprawdę lepiej jest mieć pewność, że ostrość ustawiona jest cacy.

Dla mnie ten problem na prawdę nie istnieje

Zobacz choćby tu, mogę też podesłać surówki bez resize:

Godzinę temu, qbanos napisał:

Zobacz choćby tu, mogę też podesłać surówki bez resize:

Godzinę temu, qbanos napisał:Do Samyanga 135 polecam właśnie maskę, sprawdza się u mnie przy EF 200 2.8. Ręczne ustawienie "na oko" nigdy nie daje pewności, że to jest właśnie focus-point.

Dla mnie maska jest tak samo subiektywna i niedokładna, jak ostrzenie ręczne. "Czy ta kreska jest już na środku?" - problem odwieczny

Wydaje mi się, że ruch tej kreski nie jest jakoś szybszy od zmiany średnicy gwiazdy, czyli nie ma tu "przekładni", która podniesie precyzję. Ostrzenie ręczne Samyanga wychodzi mi perfekcyjnie.

46 minut temu, Krzychoo226 napisał:

Wydaje mi się, że ruch tej kreski nie jest jakoś szybszy od zmiany średnicy gwiazdy, czyli nie ma tu "przekładni", która podniesie precyzję. Ostrzenie ręczne Samyanga wychodzi mi perfekcyjnie.

46 minut temu, Krzychoo226 napisał:jeżeli się nie zmieszczę idealnie w tych 44mm to rozjedzie się korekcja obiektywu? Czy przesunie się tylko punkt ostrości?

Przekroczenie 44 mm oznacza niemożliwość wyostrzenia - koniec skali ostrości "za nieskończoność". No chyba, że jakoś minimalnie, gdy obiektyw ma troszkę zapasu za nieskończonością. Natomiast odległość zbyt mała może powodować zepsucie korekcji obiektywu. Jednak jest to zależne od charakterystyki konkretnego modelu i w jednym będzie wielka różnica, a inny zadziała ok bez względu na odległość. Nikt tego raczej nie testuje, żeby się oprzeć na konkretnych danych.

-

W dniu 25.08.2018 o 18:44, Krzychoo226 napisał:

Jaki backfocus mają obiektywy? Zmieszczę się z kołem filtrowym i oagiem? Gdzie szukać takich informacji?

Bagnet Canona ma 44 mm. Z kołem się zmieścisz, ale OAG to już może być problem. Kamerka ma mały backfocus, więc jest szansa.

Z obiektywów ja również polecam Samyanga 135 mm, jeśli taka ogniskowa by Ci odpowiadała. Jest perfekcyjny i docelowy. Niestety, szkieł 100 nie znam. Choć prawdę mówiąc, na Twojej dość małej matrycy z dużymi pikselami, nie ma aż takich wymagań jakościowych i spokojnie słabszy obiektyw powinien dać radę.

Z obiektywami wiąże się odwieczny problem, którego osobiście nie udało mi się rozwiązać - złączka bagnetowa. Są na rynku rozwiązania typu Geoptik, które (chyba) są dokładne, a przynajmniej budzą zaufanie. Niestety, mają wielki backfocus i możesz tam nic nie zmieścić poza kamerą. No i kosztuje to krocie. Są też tanie złączki, robione z badziewnych bagnetów, na które się naciąłem i nadają się do śmieci - luzy, brak sztywności i nieprostopadłość. Ja zrobiłem sobie własną złączkę, o bardzo małym backfocusie (chyba 10,5mm) na bazie porządnego bagnetu. Niestety, mimo że złączka jest sztywna i wydaje się dokładna, to na tak jasnym szkle, jak f/2 widać jej nieprostopadłość i nie nadaje się (nie ma tragedii, ale jest słabo jak na możliwości Samyanga). Niestety, wykonanie odpowiednio dokładnej złączki pod tak jasne szkło może być nie lada wyzwaniem. Ostatnio pojawiły się złączki od ZWO, w znośnej cenie i ze znośnym backofcusem. Nie testowałem, ale budzą nadzieję, że to będzie złoty środek.

Jeśli chodzi o ostrzenie ręczne w dzień, to aparaty na ogół mają tzw potwierdzenie ostrości, czyli jakąś kropkę wyświetlaną w wizjerze, jeśli aparat uzna, że ostrość jest ok. W 400D nie wiem, czy to działa, ale chyba jest. Czyli zasadniczo aparat używa swojego systemu pomiarowego normalnie, a Twoja ręka jest tylko głupim silnikiem

Do zwykłego ostrzenia sprawdza się to znakomicie, problem może być tylko przy śledzeniu poruszających się obiektów. Mój Nikon ma nawet zamiast jednej kropki dwie strzałki, które pokazują, w którą stronę należy kręcić pierścieniem - to już ekstra wygoda i szybkość ostrzenia.

W dniu 25.08.2018 o 21:49, Loki napisał:

Do zwykłego ostrzenia sprawdza się to znakomicie, problem może być tylko przy śledzeniu poruszających się obiektów. Mój Nikon ma nawet zamiast jednej kropki dwie strzałki, które pokazują, w którą stronę należy kręcić pierścieniem - to już ekstra wygoda i szybkość ostrzenia.

W dniu 25.08.2018 o 21:49, Loki napisał:Ale w nocy? Super precyzyjnie? Z maską się szczypać? Fokuser budować? Same problemy. Chyba, że jest AF i APT ustawi ostrość.

Ja szczerze mówiąc nie rozumiem problemu ręcznej ostrości w nocy w dzisiejszych aparatach. Odpalam LV, daję max powiększenie i kręcę ręką, bez żadnych masek, żadnych dodatkowych pierścieni. Trafiam w punkt. Kluczem jest tu dobre LV, czyli przede wszystkim powiększenie 1:1 lub większe, oraz czułość, żeby widzieć gwiazdki w docelowym kadrze (ale to już tylko wygoda, zawsze można pojechać na Wegę

). No i ważny jest też wygodny pierścień ostrości, o długim zakresie i bez luzów (jak w Samyangu właśnie).

). No i ważny jest też wygodny pierścień ostrości, o długim zakresie i bez luzów (jak w Samyangu właśnie).

-

Gratulacje! Sam chciałem zrobić taką oprawkę, ale nie miałem z czego zdjąć wymiarów. Podeślesz plik do druku 3d, żebym mógł zapuścić na swojej drukarce? Sprawdziłbym, czy do D7500 też podejdzie.

Co do rozmiaru filtra, cóż, przydałby się większy. Zastanawiam się, czy filtr 36 mm zmieściłby się?

-

2 godziny temu, RMK napisał:

Przecież i tak ma wszystko policzone.

Z jednej strony tak. Ale z drugiej, taki tracking dwuosiowy, czyli rozwijając, tracking ze zmiennymi prędkościami w dwóch osiach jest dużo trudniejszym zagadnieniem pod względem obliczeniowym. Wyliczając pozycję dla goto z modelu nieba robimy tylko jedno obliczenie. A podczas takiego trackingu musimy to liczyć na bieżąco. Chociaż tego typu problem jest właśnie w montażu AZ no i jakoś się go udało rozwiązać...

Też nie rozumiem, dlaczego nikt z popularnych producentów nie wprowadził takich rzeczy. Tak samo, jak nie rozumiem, jakim cudem, po zrobieniu pomiarów na kilka gwiazd i mając wyliczone wszystkie błędy, montaż nadal potrafi się pomylić przy trafianiu o kilkanaście minut, albo więcej.

-

3 minuty temu, RMK napisał:

AZ/EQ wybiera się w nowszym pilocie na starcie. Ale w AZ zapewne steruje dwiema osiami, to czy na pewno nie robi tego w trybie EQ?

Ale to jeśli masz montaż AZ/EQ. U mnie w NEQ6 z pilotem v4 nie ma takiego czegoś.

-

17 minut temu, RMK napisał:

Można więc napisać lub wykorzystać oprogramowanie, które potrafi sterować obiema osiami zgodnie z poleceniami protokołu sterowania montażem. Ułatwia to także podział na Synscan firmware i Motor Control firmware. Nigdy nie testowałem ale gdyby przestawić montaż AZ/EQ w tryb AZ to będzie działać jedna oś ?

Można napisać, ale jak dotąd, nikt nie napisał

EQMod nic takiego nie potrafi.

EQMod nic takiego nie potrafi.

Nie wiem, w jaki sposób można by przestawić montaż w tryb AZ. To jest już chyba zaszyte w firmware i nie da się tego zrobić.

-

A jakie dokładności (teoretyczne rzecz jasna) oferują gimbale, które produkujecie? Macie coś "ponadprzeciętnego"?

-

7 godzin temu, Zybert napisał:

pracuję przy produkcji gimbali

Nasze forum jest wspaniałe, znajdzie się specjalista od każdej dziedziny

7 godzin temu, Zybert napisał:

7 godzin temu, Zybert napisał:ale to musi być poparte co najmniej dwiema jednostkami pomiarowymi IMU, które będą odpowiedzialne za korekcję ruchu - stabilizację, drugi za przesuwanie aparatu w sekwencji.

CytatNiestety rzeczywistość wygląda trochę inaczej - tak jak podejrzewałem, bo sygnał PWM odpowiadający za stabilizację (korekcję pozycji) pokrywa się (lub wyklucza) z synałem poruszającym gimbal w danej sekwencji timelapse, w wyniku czego gimbal albo stoi całkiem w miejscu (fixed), albo goni jak szalony w kierunku sekwencji (follow).

Dlatego myślę, że z drugim IMU poza sekcją YAW mogłoby wyjść to lepiej. Jak będę miał czas to zrobię taki test.

Hmm, nie do końca rozumiem. W najprostszym zastosowaniu wystarczyłoby, żeby aparat ciągle zachowywał stałe położenie w przestrzeni (względem nieba). Dodanie do tego ruchu (czyli np powolne obracanie się w poziomie, na tyle wolne, aby nie rozmazać klatki) to już rzecz wtórna/kolejny etap. Na razie wystarczy mi zwykłe utrzymanie aparatu w bezruchu względem nieba, czyli najprostszy tryb pracy gimbala (chyba).

-

Warto dodać, dla kompletności, że prowadzenie montażu (tracking) działa równie dobrze bez alignacji goto. Po prostu, najzwyczajniej w świecie, jest to wyliczona, stała prędkość, z jaką obraca się oś RA, zawsze taka sama, równa jednemu obrotowi na dobę gwiazdową.

Zmienną prędkość trackingu, oraz tracking w Dec posiada tylko ASA i być może kilka innych, bardzo drogich montaży z opcją mapowania nieba.

15 godzin temu, Sebo_b napisał:* - nie mogę nigdzie znaleźć potwierdzenie / zaprzeczenia czy montaże SW EQ zawsze prowadzą tylko w jednej osi, czy może jak wykryje cone-error (brak poziomu) w czasie alignacji to pomaga sobie drugą osią.

Niestety nie, na 100% SW nie używa drugiej osi.

-

Ktoś próbował, ktoś się zastanawiał? Taka stabilizacja aparatu pozwoliłaby na wiele ciekawych ujęć, np z łodzi, czy samochodu. Pytanie tylko, czy dostępne na rynku urządzenia będą wystarczająco dokładne. Bo czym innym jest utrzymanie "prawie" nieruchomo kamery podczas nagrywania, a czym innym "w punkt" aparatu przez 30 sekund.

Przeglądając pobieżnie dostępne urządzenia widzę powtarzającą się wartość dokładności 0,02 stopnia. To mniej więcej tyle, ile skala mojego aparatu (piksel ok 4um) na ogniskowej 11 mm. Pytanie jednak, czy taka dokładność będzie utrzymana cały czas bez odchyłek, w co wątpię.

Mam pewne doświadczenie z małymi gimbalami w dronach i próby kilkusekundowych ekspozycji. Generalnie trochę precyzji brakuje i nawet przy 4s jest pewien odrzut. W zasadzie nie zdarzają się krótkie drgnięcia poza właściwą pozycję, tylko raczej powolne "pływanie", co wskazywałoby na problemy z precyzją czujników, a nie mechaniki.

Jeśli ktoś ma jakieś przemyślenia, albo pomysły, piszcie śmiało. Marzy mi się piękne ujęcie drogi mlecznej z płynącej łodzi (i nie chodzi o wielki kontenerowiec

). Czy produkuje się tak dokładne gimbale? Może nie ma sensu, bo rynek za mały, a może są z tym problemy konstrukcyjne?

). Czy produkuje się tak dokładne gimbale? Może nie ma sensu, bo rynek za mały, a może są z tym problemy konstrukcyjne?

-

23 minuty temu, wessel napisał:

Mateusz, niech będzie że Twoj wynik jest lepszy.

Nie chodzi mi, że jest lepszy bezwzględnie, tylko lepszy (lub podobny) patrząc przez pryzmat różnic sprzętu. Bo bezwzględnie jest gorszy

Gdyby ASI miała piksel 9 um, a teleskop 106 mm, to mój materiał byłby kilkukrotnie mniej zaszumiony, niż obecnie. Stąd tego porównania nie można traktować bezpośrednio.

CytatTylko w tym samym czasie ja zrobiłem full kolor a ty tylko luminancję i to bardzo zaszumioną

A gdybym miał hyperstara f/1, to bym w tym czasie zrobił 20 zdjęć z kolorem

Po prostu masz inny zestaw, a w szczególności rozmiar piksela. Kwestia CMOS lub CCD jest na drugim miejscu.

Po prostu masz inny zestaw, a w szczególności rozmiar piksela. Kwestia CMOS lub CCD jest na drugim miejscu.

-

1

1

-

-

9 minut temu, maciekkacper napisał:

Popracowałbym jeszcze nad kolorystyką.

To jest niesamowity efekt. Patrzyłem na zdjęcie Bogdana wcześniej i kolory wydawały mi się super nasycone. Teraz wrzuciłeś swoją wersję i nagle oryginał stał się wyblakły. Mózg plata figle i nie jest obiektywny

-

1

1

-

-

Oba zdjęcia mają swoje plusy. Stare ma lepiej widoczny detal w cieniach, w nowym go rozmyłeś. Nowe ma świetne kontrasty na środku. Co do kolorów, to sam nie wiem, podobają mi się obie wersje. Zawsze lubiłem tą domieszkę fioletu, jak na starym zdjęciu, coś czego nigdy sam nie umiałem uzyskać.

-

W dniu 17.08.2018 o 17:09, Adam_Jesion napisał:

Dodając. Pamiętajcie, że ASI ma o 100 procent więcej pikseli od 8300, co oznacza, że dodatkowo downsamplując (zmniejszając) zdjęcie do rozmiarów 3000px znacząco poprawiamy "jakość" (też SNR), co dodatkowo daje konkretną przewagę ASI1600 nad KAF8300 - jeżeli już chcemy je porównywać 1:1.

A ja bym to rozumiał inaczej. Obie kamery mają taką samą wielkość matrycy. W ASI mamy mniejsze piksele, więc dostajemy większą skalę kosztem mniejszej ilości światła padającego na jedne piksel. Tak więc jeden piksel ASI będzie bardziej zaszumiony, niż w KAF (pomijając różnice w szumie odczytu, ciemnym, czy sprawności). Teraz, jeśli zmniejszymy rozmiar zdjęcia z ASI do poziomu KAF, to powinniśmy obniżyć szum również do poziomu KAF (nie do końca, bo szum odczytu, ale w ASI jest niski, więc prawie). Czyli możemy uzyskać bardzo podobny obrazek. Zaznaczam, że porównuję tu jedynie ilość i wielkość pikseli.

Czyli to nie tak, że ASI ma więcej pikseli i dzięki temu zmniejszając zdjęcie dostaniemy mniejszy szum, niż na KAF, ale zmniejszając zdjęcie dostaniemy z bardziej zaszumionego takie podobnie zaszumione.

W dniu 17.08.2018 o 18:15, wessel napisał:Mój głos w dyskusji:

FSQ 106N, STL 11000 na EM-11Z.

16x900 sekund luminancja ( 4 godziny)

Cóż, niewiele da się tu porównać, bo wszystko jest inne. Twoje piksele mają 5,6x większą powierzchnię, a teleskop daje 1,7x jaśniejszy obraz (światłosiła). Dodatkowo, jak zauważył Adam, bardziej zmniejszyłeś zdjęcie i jest ono ciemniejsze. Biorąc to wszystko pod uwagę, uważam (na oko) że mój wynik jest jak najbardziej w porządku, a może i lepszy. Na pewno Twoje zdjęcie nie skłania mnie ku myśleniu, że z ASI mam więcej szumu, niż powinienem mieć.

W dniu 17.08.2018 o 23:30, Krzychoo226 napisał:Na zlocie dołożę od siebie ten obiekt w takim kadrze:

Będzie uczta!

W dniu 19.08.2018 o 01:36, wessel napisał:

W dniu 19.08.2018 o 01:36, wessel napisał:Kamera CCD z pikselem 3.69 daje dużo mniejsze gwiazdki niż analogiczny produkt CMOS. Tego dotyczyła moja uwaga .

Chodzi Ci o ten nazwijmy to wzór, trochę przypominający spajki, jaki powstaje na gwiazdach w ASI? Faktycznie, to może być przyczyna większych gwiazd. A przyczyną tego jest zapewne wygląd mikrosoczewek, albo jakiejś innej warstwy na matrycy. Zastanawia mnie tylko to, dlaczego nie można pokryć tej matrycy tak samo, jak CCD, żeby efekt nie występował. Chyba, że to widna już samej budowy piksela CMOS? Może ktoś ma tu więcej wiedzy. W każdym razie, pamiętam wątki na forum, gdzie ktoś pokazywał wręcz kratownicę, jaka powstała na jasnej gwieździe.

-

1

1

-

-

W dniu 17.08.2018 o 15:29, Sebo_b napisał:

Ale przecież napisałem dokładnie to co Ty:

Masz rację, źle zrozumiałem Twój post. Myślałem, że mylisz ilość bitów z szumem, a nie mylisz

W dniu 17.08.2018 o 15:38, Sebo_b napisał:

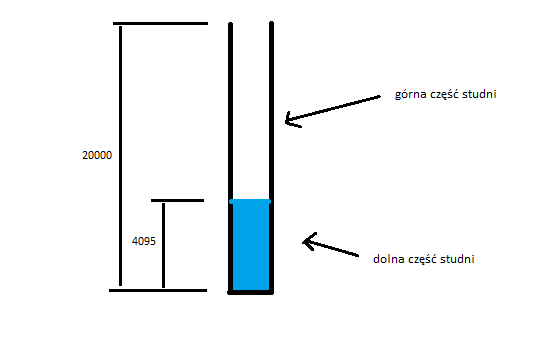

W dniu 17.08.2018 o 15:38, Sebo_b napisał:A propos bzdur - wytłumacz mi proszę czym się różni górna część studni od dolnej części studni

Proszę

-

1

1

-

-

17 godzin temu, cmku napisał:

Oczywiście przydatne jest tylko do kamer kolorowych

A nie prawda. Robiąc luminancję w kamerze mono przyda się tak samo. W mono nie widać podziału obrazu na kolory, ale rozmycie wynikające z dyspersji jest dokładnie takie samo.

-

3

3

-

-

Nie mam pojęcia, czy te struktury wyglądają tak genialnie z powodu skali (seeingu), czy HST, ale są nieziemskie! Super, zupełnie inne spojrzenie na, wydawało się, znaną mgławicę.

Kolorystyka dość nietypowa, wygląda trochę jak bicolor. Gdzie jest siarka?

Materiału bardzo dużo, jednakże szum na tle pozostał. Jest przyjemny, ale jest mimo wszystko.

-

1

1

-

-

27 minut temu, Marek_N napisał:

Tutaj masz pełny opis konwersji D7000:

- https://www.lifepixel.com/tutorials/infrared-diy-tutorials/nikon-d7000-ir

Czy ja dobrze widzę, że filtr IR jest osobnym szkłem od szybki z czyszczeniem matrycy? W D5100 była to jedna szybka.

-

1

1

-

-

1 godzinę temu, Piotr K. napisał:

Czyli łącznie musimy mieć np. 1 mln fotonów z obiektu, ale "liczą się" tylko te fotony, których jest więcej niż poziom szumu

Nie o to chodzi

Fotony, które są poniżej progu szumu nie "znikają". Można zrobić zdjęcie obiektu, który jest na pojedynczej klatce ciemniejszy od tła, jeśli nazbieramy odpowiednio dużo klatek. Bo tak na prawdę jasność piksela obiektu jest sumą jego jasności i szumu, a nie maksimum z tych dwóch liczb.

Fotony, które są poniżej progu szumu nie "znikają". Można zrobić zdjęcie obiektu, który jest na pojedynczej klatce ciemniejszy od tła, jeśli nazbieramy odpowiednio dużo klatek. Bo tak na prawdę jasność piksela obiektu jest sumą jego jasności i szumu, a nie maksimum z tych dwóch liczb.

Chodzi dokładnie o to, co napisałem. Rysunek zrobiłeś dobry, ale interpretację złą. Po prostu, jeśli oddalimy się wystarczająco od szumu odczytu, to on już nam praktycznie nie przeszkadza, prawie nie wpływa na zdjęcie. Jeśli mamy za krótki czas, to ten szum zaczyna dominować i pogarsza klatki.

-

1

1

-

-

Gratulacje wytrwałości w zbieraniu materiału i genialnego efektu końcowego!

Jest coś w tym, co mówi Adam, jednak żeby uzyskać taką różnorodną czerwień, potrzeba by mieć bardzo dużo RGB i użyć go do zróżnicowania Ha. Mając po 50 min jedyne co się zrobi, to zaszumi sygnał z Ha. Ale w praktyce ja też nie mam pojęcia, jak to złożyć, żeby powstał ten efekt

Ja w sumie lubię taką "syntetyczną" czerwień. Nie jest może naturalna, ale w jakiś sposób "ładna"

Ja w sumie lubię taką "syntetyczną" czerwień. Nie jest może naturalna, ale w jakiś sposób "ładna"

-

1

1

-

-

2 godziny temu, Piotr K. napisał:

A to nie jest tak, że im mniejszy szum, tym dłuższe czasy ekspozycji można stosować...? Chyba że chodzi o to, że można palić krócej, bo przy niższym szumie obiekt będzie wyraźniejszy mimo krószej ekspozycji?

Chodzi o to, że dobierając czas exp powinniśmy mieć pewne minimalne oddalenie sygnału od szumu odczytu. Im dłuższy czas, tym oddalenie większe (bo ten szum jest stały). Jeśli przekroczymy pewną granicę, to jest już "ok". Można używać czasu jeszcze dłuższego, ale nic to nie zmieni. Oczywiście sumarycznie musimy mieć tyle samo godzin materiału, to jest niezmiennik. Im mniejszy szum odczytu, tym można stosować krótsze klatki bez straty jakości. A długie można palić zawsze, jeśli tylko nasz montaż na to pozwala.

-

1

1

-

-

6 godzin temu, Piotr K. napisał:

A powiedzcie mi taką rzecz - czy to, że matryca Nikona ma niższe szumy, daje zauważalną różnicę na zdjęciach w porównaniu do Canonów? W sensie, że np. mniej klatek trzeba zebrać, albo surowe zdjęcia mniej ważą, albo szybciej idzie obróbka...? (o ile dobrze rozumiem, mniej szumu to mniej danych do przemielenia).

Surowe zdjęcia mogą ważyć ciut mniej, ale to pomijalna rzecz. Szybkość obróbki praktycznie nie zależy od zaszumienia zdjęć, bo algorytm i tak musi przemielić całe zdjęcie w ten sam sposób (powyszukiwać gwiazdy, czy policzyć medianę). Ale to i tak nie ma znaczenia, bo stackowanie kilkudziesięciu klatek z lustrzanki trwa może 2 min. Czas stackowania potrafi być dokuczliwy dopiero w kamerkach CMOS, gdzie masz np 200 wielkich plików i słabszy komputer potrafi to mielić nawet kilka godzin.

Mniejszy szum aparatu nie wpływa jakoś mocno na mniejszą wymaganą ilość klatek. Oczywiście trochę tak, ale większy przyczynek do szumu ma samo niebo, tzn szum wynikający z niewielkiej ilości fotonów dolatujących z obiektu - jeśli przylatuje jeden na 10 sekund, to co minutę możemy mieć ich 5,6,7 itp z jakimś prawdopodobieństwem (to się nazywa szum fotonowy). Tak więc, jeśli porównamy dwa aparaty z podobnej "epoki", to różnice w wymaganym materiale będą może 1-2 klatki.

-

3 minuty temu, Adam_Jesion napisał:

To jest generalny problem małych pikseli i taniej optyki (granica krążka rozproszenia - coś za coś, kompromisy). Gwiazdy w 1:1 nie są już tak piękne, jak w pikseli 9 mikronów. Ale ja już nie oglądam zdjęć 1:1 - jak już gdzieś pisałem (monitory 4-5K oraz printy). Można by poprawiać te gwiazdy, ale... trochę szkoda prądu. Nikt "normalny" tego nie widzi.

Mi nie chodzi o kwestię nieidealności optyki, pod tym względem jest dla mnie super. Chodzi mi o wygląd najmniejszych gwiazd, które jakby zlewają się z tłem. Są takie mało "gwiazdowe", w sumie nie wiem, jak to opisać. Podejrzewałem, że to kwestia lekkiego zmniejszenia, ale może nie?

Zgadzam się, że to szczegóły i w sumie nawet na 1:1 wygląda nieźle.

-

Ja osobiście wolę wersję z tego wątku, przewaga niebieskiego mi pasuje. Ale tak na prawdę nie wiem, czy kiedyś widziałem kolorystykę, którą bym uznał za wzorcową. Zawsze coś jest minimalnie nie tak. Cóż, ten obiekt jest wyjątkowo kapryśny

Kolumny Stworzenia (HST)

w Głęboki Kosmos (DS)

Opublikowano

A da się gdzieś znaleźć info, ile czasu naświetlali te klatki? Bo rozumiem, że to jakieś bardzo długie ekspozycje raczej? W końcu mają światło f/24

Porównałem sobie Twoją wersję i wersję NASA i co mnie zaskakuje, to to przeprocesowanie mimo wszystko ma jakiś umiar. Ja bym go nie nazwał przeprocesowaniem, tylko bardzo mocnym procesowaniem Na ich wersji szum już się zdradza, choć zdjęcie ma dużo mniejszą rozdzielczość. Gdyby było więcej materiału (haha

Na ich wersji szum już się zdradza, choć zdjęcie ma dużo mniejszą rozdzielczość. Gdyby było więcej materiału (haha  ), to myślę, że można by śmiało pociągnąć mocno suwaki, jak oni, a bez takiego mocnego resize na koniec.

), to myślę, że można by śmiało pociągnąć mocno suwaki, jak oni, a bez takiego mocnego resize na koniec.