-

Postów

9 964 -

Dołączył

-

Ostatnia wizyta

-

Wygrane w rankingu

41

Typ zawartości

Profile

Forum

Blogi

Wydarzenia

Galeria

Pliki

Sklep

Articles

Market

Community Map

Odpowiedzi opublikowane przez MateuszW

-

-

Pan w sklepie ( teleskopy.pl ) przekonuje mnie na ta tube co podalem wczesniej .. http://teleskopy.pl/product_info.php?products_id=2068&lunety=Tuba_optyczna_GSO_N-254/1000_M-LRN_OTA

Moze i za jasna .. ale 10cali czyli mieszcze sie w waszych zalozeniach a z czasem ja ogarne ... i nawet " cos" zobacze o nie powiem ale jak zobacze jakas fajna gromade to juz bede zadowolony

A na eq6 bede robic w nocy fotki takze

To powiedz panu w sklepie, żeby nie wciskał kitu, bo ta tuba jest za duża na NEQ6 do foto. Po co większa tubę, skoro niedokładność prowadzenia i tak sprowadzi zdjęcie do poziomu z mniejszej tuby. A nawet nie zdajesz sobie sprawy, jak trudną rzeczą jest kolimacja takiego ustrojstwa i zapewnienie odpowiedniej sztywności, szczególnie dla kogoś bez doświadczenia. Ta światłosiła przełoży się tylko na wielką masakrę rogów zdjęcia, nic ponadto.

-

-

Witam

Ostatnia lista zlotowa.

Mateusz W

To ja?

Ale ja nic nie mówiłem

Ale ja nic nie mówiłem  Chciałbym pojechać, ale nie mogę...

Chciałbym pojechać, ale nie mogę... -

Luzy i to bardzo duże, za duże. Regulować

A ten ruch 1,2" w Ra jest nieco dziwny, choć pewnie wynika z tych masakrycznych luzów wszędzie. Jak się wyreguluje to pewnie zniknie, a jak nie to będziemy szukać dalej.

-

Jak kupie montaż EQ6 mogę pod niego podpiąć aparat i focic czasem ?

Oczywiście, możesz podpiąć aparat z obiektywem i to nawet zalecana metoda na początku.

-

NIE...

Tuba za duża dla montażu, za jasna dla początkującego...

Kamerka do guidingu przestarzała, polecam ASI120MM

Aparat hmm... Ani tego do PC nie podłączysz, ani dobrego zdjęcia nie zrobisz...

Korektor komy na clamping ringi, hmm...

Prosisz się o problemy i tyle.

-

Byłem przekonany że po wyborze Słońca jako obiektu do alignacji i wstępnym skierowaniu teleskopu na naszą gwiazdę, montaż gdzieś tam sobie pojedzie, po czym podejmie próbę trafienia z powrotem na Słońce z mniejszym lub większym błędem który będzie można skorygować.

Ale to nie ma totalnie żadnego sensu. Skoro już wskazałeś mu raz Słońce, to drugi raz trafi na nie dokładnie w to samo miejsce (o ile mechanicznie wszystko jest ok). Alignacja 2x na ten sam punkt to bezsens. A czemu nie trafia potem na planety? Bo jest zalignowany tylko na jeden punkt, więc precyzja goto musi być słaba. Pewnie po to jako punkty alignacji można wybrać jakąś planetę, żeby mieć drugi punkt i większą precyzję celowania, ale tu koło się zamyka, bo jak zalignujemy na Słońce i planetę, to znaczy że na planetę umiemy sami trafić, więc goto nam niepotrzebne

Aby zwiększyć precyzję goto z jednym punktem alignaci wypadałoby idealnie wypoziomować montaż - bo przy jednym punkcie on zakłada, że stoi idealnie prosto, nie może wyliczyć poprawki na to.

Aby zwiększyć precyzję goto z jednym punktem alignaci wypadałoby idealnie wypoziomować montaż - bo przy jednym punkcie on zakłada, że stoi idealnie prosto, nie może wyliczyć poprawki na to.Ta alignacja ma bardziej służyć temu, żeby mieć poprawny tracking za dnia, bo AZ to nie EQ, gdzie wszędzie i zawsze prędkość trackingu jest jednakowa. A goto jak widać i jak można się było spodziewać musi być kiepskie, bo jeden punkt to zawsze tylko jeden punkt.

Ale może coś jednak kiepsko zrobiłeś, bo jednak w miarę rozsądnie trafiać powinien, po lekkim "przeczesaniu okolicy" powinieneś planetę znaleźć.

-

Popracuj nad kolorami gwiazd. Spraw, żeby niektóre z nich oślepiały niebieskością

Wtedy te kolorowe gwiazdy spowodują, że jednolicie czerwona mgławica przestanie być za czerwona.

Wtedy te kolorowe gwiazdy spowodują, że jednolicie czerwona mgławica przestanie być za czerwona. -

Dzięki za wyjaśnienie. Jeszcze jednego jestem ciekaw, co FireCapture robi z plikiem w "extended avi mode"? Używa tego OpenDML, czy może po prostu wpisuje w tym polu z rozmiarem np max wartość, a plik ciągnie się o wiele dłużej (czyli plik jest teoretycznie niepoprawny, ale mając to na uwadze da się go odczytać)? Czy na końcu pliku jest jakiś "znacznik", po którym można poznać że to koniec?

-

Gwoli ścisłości, w standardowej masce RGB Bayera środki pikseli „czerwonych” i „niebieskich” są 2x dalej od siebie niż sąsiednie piksele, więc rozdzielczość jest ograniczona do 50% (za to ilość zbieranego światła = 25%). Piksele „zielone” są gęstsze i samodzielnie dają rozdzielczość o krotności 1/√2.

Z tym 25% koledze chodziło pewnie o całkowitą ilość pikseli, no bo powierzchniowo mamy 1/4 rozdzielczości. Ale raczej sie to rozpatruje w jednym wymiarze i jak mówisz jest wtedy 1/2.

Ale generalnie tak, Miszuda masz oczywiście rację. Rozdzielczość spada zgodnie z wypowiedzią Wielkiego Atraktora i zdjęcie z Ha mamy 2x mniejsze. Ale zauważ też, że nawet robiąc RGB, do czego generalnie służy kolorowa matryca, też uzyskujesz spadek rozdzielczości i to dokładnie taki sam. Zdjęcie z kolorowej matrycy ma tylko połowę efektywnej rozdzielczości w R i B, a w G jest to 1/√2. Reszta zdjęcia to interpolacja i oszukiwanie

Kamera mono z filtrami RGB daje już pełną rozdzielczość w każdym kolorze.

Kamera mono z filtrami RGB daje już pełną rozdzielczość w każdym kolorze.Czy to zauważysz? Zależy od jakości zdjęć. Jeśli Twój montaż nie prowadzi co do piksela, to nie dostrzeżesz pogorszenia jakości, bo więcej szczegółów tam po prostu nie ma. Ale jak masz wszystko idealnie i cacy to możesz cierpieć.

No i matryca kolorowa to też większe straty światła (mniejsza efektywność kwantowa). To jakieś 20-30% straty na każdym kolorze.

-

3

3

-

-

SER wywodzi się od aplikacji obsługującej Lumenery a powstał by rozwiązać problemy klipów AVI: tylko 8-bitów i ograniczony rozmiar pliku.

Czyli SER to format wideo, a nie pojedyncze pliki ze zdjęciami?

A co do ograniczonego rozmiaru avi to jak to w końcu jest? Bo ponad 4 GB to czasem działa, czasem nie. Niby jest ustawienie extended avi mode, ale bez niego zaznaczania też to czasem działa. Ja nie rozumiem, co z tym jest.

-

Sam sobie strzelasz w stopę. Jak masz za jasno to załóż filtr neutralny, szary.

A filtr szary to nie jest strzelanie w stopę? Jak jest za jasno, to trzeba skrócić czas i tyle, nie ma innej opcji. Chyba, że w tej kamerze jest jakaś manipulacja gainem? Filtr ALP to również dobry pomysł.

-

Ale chyba właśnie gain = 0 nie odpowiada pokryciu całej studni kamerki, tylko tą wartość trzeba dobrać doświadczalnie. Tayson miał fajny link o tym, może poda

W kamerach 16 bit tak to właśnie działa, że się ustawia tak, żeby cały zakres był pokryty i git. Ale na mniejszej ilości bitów obawiam się, że przy ciemniejszych obiektach może być koniecznie podniesienie gainu, bo po wyciągnięciu w obróbce obiektu, który miał np jasność 128 ADU, okaże się że mamy obiekt zapisany na 7 bitach, więc na zdjęciu wynikowym pojawią się gradienty. Podniesienie gainu rozciągnie obiekt na pełne 8 bitów lub więcej i nie będzie już tego problemu.

A z tym nieprzepalaniem jasnych gwiazd to raczej przesadzona sprawa, bo przy takim poziomie jasności zdjęcia obiekt zginie, będzie prawie czarny. Gwiazdy na zdjęciu są nieporównywalnie jaśniejsze i żeby sensownie naświetlić obiekt trzeba je przepalić. Tak to wygląda np w moim Atiku 383 - zawsze jaśniejsza część gwiazd jest przepalona.

-

U mnie w tej chwili 178MMC chodzi na guiderze (tak wiem, niezła przesada), ale jak nastrzelam się 1600MMC, to pobawię się też ze 178-ką.

Czy wtedy 1600 pójdzie na guider?

To będzie dla niej obraza

To będzie dla niej obraza

-

1

1

-

-

Generalnie za noc astronomiczną uważa się okres, gdy Słońce jest poniżej 18 stopni pod horyzontem. Wtedy mamy gwarancję, że niebo jest maksymalnie ciemne (z dobrym przybliżeniem). Ja zaczynam i kończę focenie właśnie wtedy, gdy Słońce przekracza tą umowną granicę. Ewentualnie, jak jest Księżyc lub słaba (zaświetlona) miejscówka, to naginam tą granicę do 16 stopni (czyli zaczynam wcześniej, kończę później), bo z uwagi na większą ogólnie jasność nieba, różnica tych dwóch stopni jest pomijalna, a czasu nieco przybywa. Pod ciemnym niebem widać na zdjęciu zauważalną różnicę między -18, a -16 st, gdy nie ma Łysego, a miejscówka dobra, a już między -18 a -20 st różnica jest pomijalna. Jak widać, ten ktoś co wymyślił -18 st miał łeb nie od parady

Oczywiście w okolicy czerwca mamy zjawisko białych nocy, gdy to Słońce nigdy nie schodzi poniżej 18 st, więc żeby coś poobserwować, to trzeba nagiąć zasady

Tayson, te 2h po zachodzie akurat prawie idealnie się pokrywają z -18 st, ciekawe

-

3

3

-

-

A co jest niesamowitego w tym, że koło Saturna świecą jakieś gwiazdy?

-

2

2

-

-

Może wydzielmy "obce" posty do innego wątku i będzie porządek

-

I oczywiście też - będzie reduktor ogniskowej - bo i plejady by się zobaczyło wtedy - może....

Ja Hamalu tylko jedno zdanie i już się zamykam

Reduktor do wizuala raczej zbędny, lepiej kupić odpowiednio długi okular.

-

A czy ta rotacja nie jest spowodowana złym ustawieniem montażu na biegun?

Ja bym się bardziej spytał, czy ten montaż ma w ogóle klin paralaktyczny?

To zdjęcie wygląda jak klasyczny przykład rotacji pola z montażu azymutalnego i nic tu jakość prowadzenia nie pozwoli. Jedynie klin lub derotator. Oczywiście prowadzenie też nie jest "w punkt", ale tragedii nie ma.

To zdjęcie wygląda jak klasyczny przykład rotacji pola z montażu azymutalnego i nic tu jakość prowadzenia nie pozwoli. Jedynie klin lub derotator. Oczywiście prowadzenie też nie jest "w punkt", ale tragedii nie ma.Jeśli chcesz na tym bydlaku robić rozsądne zdjęcia, to bezwzględnie zaopatrzcie się w reduktor ogniskowej (ten od meade, dedykowany). Bez tego, na takiej ekstremalnej skali, praktycznie nic rozsądnego nie wyjdzie.

A puki nie macie klina, to trzeba się trzymać obiektów z dala od zenitu i bieguna. Najlepiej będą wychodzić obiekty w okolicy równika niebieskiego (tam rotacja jest najmniejsza).

-

No rozumiem. Przejrzałem klatki, ale żadna nie jest podejrzana - wszystkie prowadzone idealnie. To musi być kolimacja, widać ją w zasadzie już od połowy zdjęcia (z prawej) Czy z lewej również widzisz te defekty?

-

Wszystkie klatki są takie same. Tu po prostu brakuje kolimacji - prawa strona do bani. Mam tego świadomość i walczę.

-

- Ta odpowiedź cieszy się zainteresowaniem.

- Ta odpowiedź cieszy się zainteresowaniem.

Oto kolejna z fotografii, jaką popełniłem w ostatnim czasie. W zasadzie wyczerpałem nią praktycznie bezksiężycowe fragmenty nocy, które miałem ostatniego nowiu...

Zaledwie 10x600s L

Sprzęt: SW CFP 200/800 + NEQ6 belt mod + MPCC mkIII + TSOAG9 + Chameleon3

Kolor już czeka na obróbkę, a może jeszcze dostrzelam dziś trochę luminancji.

Dlaczego ten obiekt? Bo nie mam jego dobrego zdjęcia w kolekcji, a akurat nic lepszego się nie napatoczyło przy szukaniu

Choć mi osobiście ta galaktyka się średnio podoba - żaden z niej przykład spiralności.

Choć mi osobiście ta galaktyka się średnio podoba - żaden z niej przykład spiralności.-

19

19

-

trochę sprzeczność

Ale nie do końca

Wszystko zależy od odpowiedzi na drugą część, bo jeśli mając idealną kamerę i tak dostaniemy szumiący obrazek, to trzeba będzie to stackować i odróżnić sygnał od szumu. A jeśli idealna kamera produkuje idealne zdjęcia z marszu, to zamiast stackowania można wziąć sumę i problemów brak.

Wszystko zależy od odpowiedzi na drugą część, bo jeśli mając idealną kamerę i tak dostaniemy szumiący obrazek, to trzeba będzie to stackować i odróżnić sygnał od szumu. A jeśli idealna kamera produkuje idealne zdjęcia z marszu, to zamiast stackowania można wziąć sumę i problemów brak. -

Gdybys miał kamerę o zerowych szumach i 100% sprawności kwantowej to w ogóle nie miałoby znaczenia, czy robisz 0.001 sek subekspozycję, czy 2 godziny.

Czy aby na pewno? Jeśli focimy obiekt, który emituje np 1 foton/minutę, to robiąc przykładowo subekspozycje 1s będziemy rejestrować ten jego foton co 60 ekspozycji. Robiąc zdjęcia 10 min zarejestrujemy na każdym po 10 fotonów. W pierwszym wypadku algorytm stackowania uzna ten rzadki foton za szum i go usunie, w drugim te 10 fotonów będzie już wyraźne i się ładnie zestackuje. No chyba, żeby te krótkie ekspozycje najpierw sumować jakimiś paczkami np po 600 sztuk, a potem te paczki stackować?

I jeszcze jedno pytanie. Czy mając tą hipotetyczną kamerę z zerowym szumem odczytu i zerowym prądem ciemnym i ze wszystkim idealnym, to robiąc jedno zdjęcie, byłoby ono idealnie gładkie (pozbawione szumu)? Czy może jednak niebo samo w sobie szumi, z uwagi na niejednostajną (nieco losową) częstość emisji fotonów w danym kierunku?

-

3

3

-

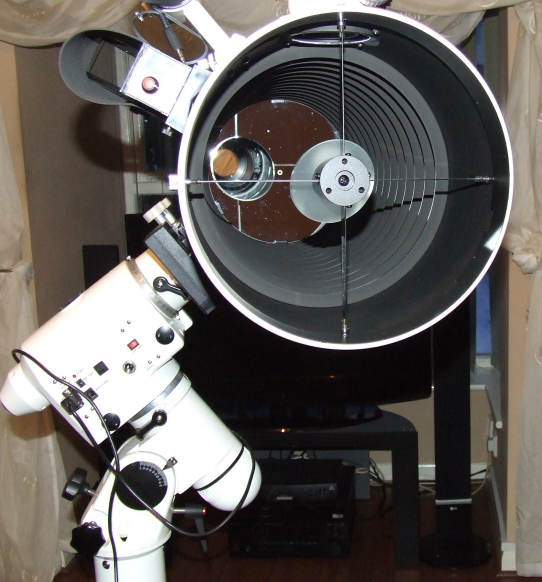

Diafragma w newtonie

w ATM, DIY, Arduino

Opublikowano

A, nie spotkałeś osobiście

No ciekawe, że ASA, czy OO tego nie robi, trudno powiedzieć czemu. Ale inne konstrukcje, jak ten Intes mają. Brak logiki

Jakieś dwa lata temu dostępne było, bo moja chyba z tego okresu pochodzi. Teraz faktycznie w Delcie brak na magazynie, ale czemu mieliby rezygnować?