-

Postów

3 154 -

Dołączył

-

Ostatnia wizyta

-

Wygrane w rankingu

13

Typ zawartości

Profile

Forum

Blogi

Wydarzenia

Galeria

Pliki

Sklep

Articles

Market

Community Map

Treść opublikowana przez LibMar

-

Live binning - rewolucja w amatorskiej rejestracji tranzytów egzoplanet?

LibMar odpowiedział(a) na LibMar temat w Egzoplanety

O właśnie, to w jakimś innym wątku pisałem. Jeśli gwiazda zmienna jest odchylona przy każdej gwieździe referencyjnej tylko w jedną stronę, to oznacza, że ze zmienną jest coś nie tak (gdy wiemy, że tego wzrostu/spadku nie powinno być, za krótkie na flary). I to nawet jest szybkie do wykonania. -

Polska zmienna typu RCB? Typu YSO? Nie, to EXOR!

LibMar odpowiedział(a) na LibMar temat w Gwiazdy Zmienne

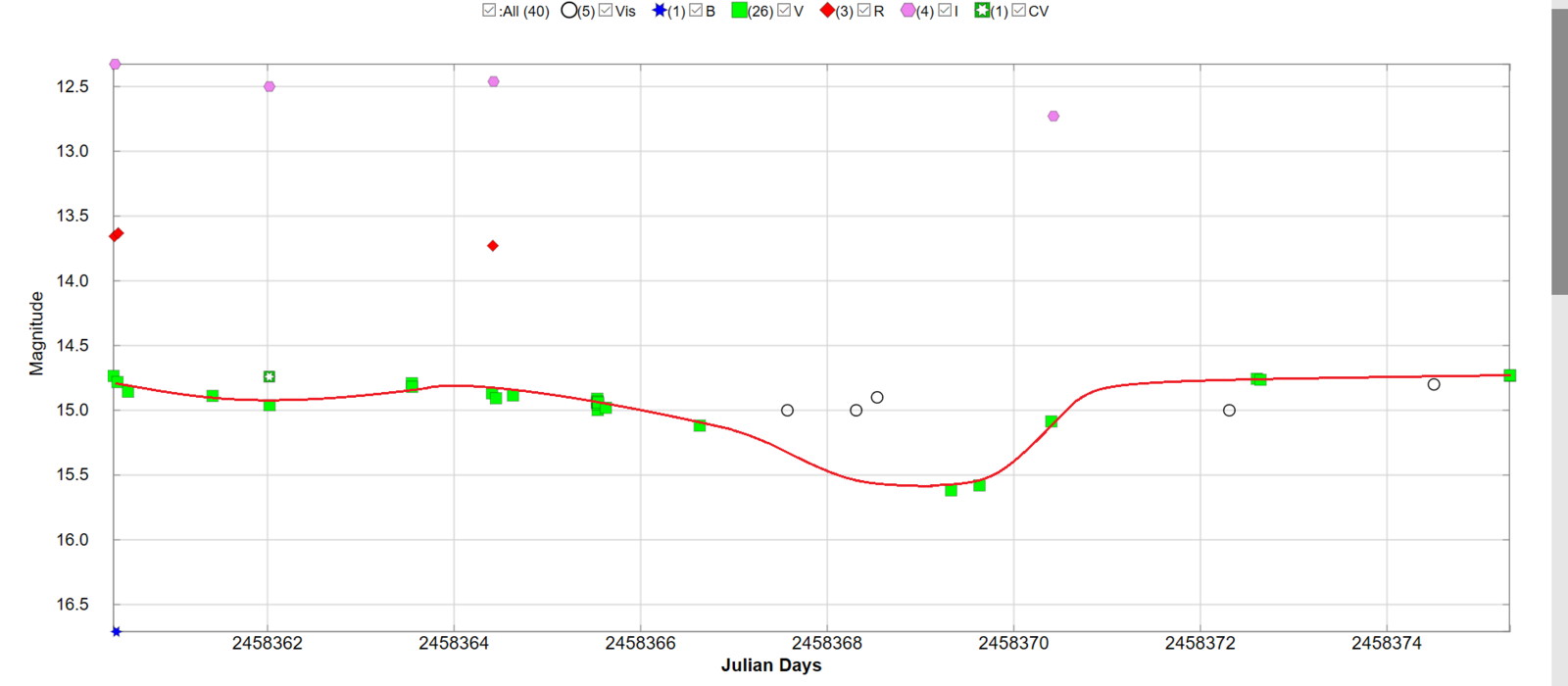

Dzięki! Tymczasem mieliśmy kilkudniowe pociemnienie zmiennej, co zostało zauważone przez czterech obserwatorów dzięki własnym pomiarom fotometrycznym (pogrubione niżej). Te pomiary V oraz I wykonałem podczas ostatniej nocy Jesiennego Star Party (i to była końcówka). Gwiazda osłabła z poziomu 14.8 mag do 15.6 mag. Co ciekawe, wizualni obserwatorzy tego nie dostrzegli. 2018 Sep. 13.81840 - 14.734 - V - DUBF 2018 Sep. 13.81840 - 14.729 - V - DUBF 2018 Sep. 13.00300 - 14.8 - Vis. - PYG 2018 Sep. 11.59199 - 14.83 - V - ASAS-SN 2018 Sep. 11.14377 - 14.764 - V - DLM 2018 Sep. 11.10455 - 14.757 - V - DLM 2018 Sep. 10.81000 - 15.0 - Vis. - BOZ 2018 Sep. 08.92500 - 12.728 - I - MGAB 2018 Sep. 08.90200 - 15.086 - V - MGAB 2018 Sep. 08.13181 - 15.580 - V - DLM 2018 Sep. 07.82799 - 15.618 - V - DUBF 2018 Sep. 07.03500 - 14.9 - Vis. - PYG 2018 Sep. 06.81000 - 15.0 - Vis. – BOZ 2018 Sep. 06.57497 - 15.30 - V - ASAS-SN 2018 Sep. 06.07300 - 15.0 - Vis. - PYG 2018 Sep. 05.13319 - 15.118 - V - DLM 2018 Sep. 04.12707 - 14.980 - V - DLM 2018 Sep. 04.04387 - 14.940 - V - STAC 2018 Sep. 03.13114 - 14.886 - V - DLM 2018 Sep. 02.94894 - 14.907 - V - DUBF 2018 Sep. 02.92300 - 12.461 - I - MGAB 2018 Sep. 02.91500 - 13.729 - R - MGAB 2018 Sep. 02.90700 - 14.869 - V - MGAB 2018 Sep. 02.04912 - 14.819 - V - STAC 2018 Sep. 02.04765 - 14.791 - V - STAC Mamy też pierwsze otrzymane spektrum, o dość małej rozdzielczości. Kolejne obserwacje będą bardzo potrzebne, gdyż na chwilę obecną istnieje możliwość, że IRAS 03536+6235 może należeć do typu YSO (czyli młoda gwiazda z dyskiem pyłowym). Pociemnienie trwało dość krótko, co jest trochę nietypowe jak na RCB. Obserwujemy dalej! Pozostały jeszcze dwa tygodnie do studiów, potem będą to sporadyczne pomiary... Liczę na aktywność innych, którzy pomagają w dopełnieniu krzywej -

Live binning - rewolucja w amatorskiej rejestracji tranzytów egzoplanet?

LibMar odpowiedział(a) na LibMar temat w Egzoplanety

I takie odstające faktycznie pojawiają się na krzywej Właśnie one usuwają się już po selekcji pięcioprocentowej. -

Live binning - rewolucja w amatorskiej rejestracji tranzytów egzoplanet?

LibMar odpowiedział(a) na LibMar temat w Egzoplanety

Musi być faktycznie coś na rzeczy, jeśli zwykłe uśrednianie (które jest łatwe do ogarnięcia) wcale nie pomaga. Stacki mają to do siebie, że pomiary są adekwatne do sytuacji - ta sama głębokość, wyjście i wejście o takim samym kształcie, podobny trend. Raczej niekoniecznie szum. Może zmienność obrazu gwiazdy, skoro mam małą skalę (1.65"/px) i trzymam się jak najostrzejszego obrazu, jak tylko mogę? I to wpływa na duże zmiany S/N na każdej klatce? Jak trzymam się wartości histogramu średnio 45%, to ten skacze mi między 40% a 50%, niekiedy schodząc pojedynczo do 30-35% rozlewając się na sąsiednie. To może takie wprowadzają na starcie gruby błąd. Bardzo fajnym porównaniem byłoby też wykonanie tego samego tranzytu (albo nawet płaskiej krzywej, łatwiejsze w analizie) korzystając z długich czasów ekspozycji, czyli 120s. Tylko, że mój montaż tyle nie uprowadzi Dopóki nie pojawi się nowa wersja Muniwina, raczej nic nie zdziałam. Sprawdzenie innymi algorytmami (np. jakość gwiazd, największa wartość ADU piksela czy któraś wartość z kolei wewnątrz apertury) na razie za każdym razem wymaga po kilka godzin pracy komputera, więc trzeba poczekać, aż będzie zajmowało to mniej niż 30 minut. Może to będzie wydajniejsza i dokładniejsza metoda, która w innych przypadkach może różnie działać. Bo taki rozrzut może być dodatkowo wywoływany np. przez kiepskie prowadzenie, gdzie jakość gwiazd będzie dobrym wyznacznikiem (która być może ma większy wpływ na rozrzut niż sam seeing). Wpływ musi być nieznaczny, skoro przy każdej obserwacji wychodzi mi praktycznie to samo, co przewiduję (jest powtarzalność). Jak seeing jest dobry, to jest ciut lepiej. Jak gorszy, no to ciut gorzej… ale mój schemat pozostaje zawsze taki sam. Obrazując myśl odrzutów, myślę bardziej w takim kierunku: mamy grupę 100 studentów na jednym roku, z których mają wyrosnąć dobrzy stomatolodzy (a co tam ). Jedni uczą się lepiej, drudzy gorzej. Chcemy, aby w Polsce byli coraz lepsi stomatolodzy i dobrze o mówiono o ich wykonywanej pracy. Ale część stomatologów nie chodziła na zajęcia i ma pewne braki - skutkuje to częstymi skargami od strony pacjentów, że coś źle robią. No bo nie nauczyli się, nie wiedzą. Zaczyna pojawiać się opinia jakich mamy beznadziejnych młodych dentystów, więc umawiają się do tych starszych. Gdybyśmy wywalili ze studiów paru studentów, to byłoby spoko, bo nie ma tych, przez których najprawdopodobniej pojawiłaby się taka negatywna ocena. Opinia pozostaje dobra. Taka jest moja opinia pod kątem odrzucania pomiarów. Traktowanie każdego pomiaru do ostatecznego wyniku równoważnie jest czymś w stylu: każdy dentysta poprawia stan zdrowia w naszym społeczeństwie, jeden lepiej, drugi gorzej. Moglibyśmy nawet studentów po pierwszym roku zatrudniać, bo przecież coś już wnoszą i mogą sporo pomóc w środowisku! To moim zdaniem zły kierunek. A ideałem jest wypośrodkowanie ilu tych studentów (*mających studia gdzieś*) moglibyśmy wyrzucić. (sam oczywiście nie życzę nikomu powtarzania roku ) EDIT: @Gajowy, w Berlinie musimy faktycznie nad tym pogadać, wyjaśnisz mi też czym ta regresja ważona jest -

Live binning - rewolucja w amatorskiej rejestracji tranzytów egzoplanet?

LibMar odpowiedział(a) na LibMar temat w Egzoplanety

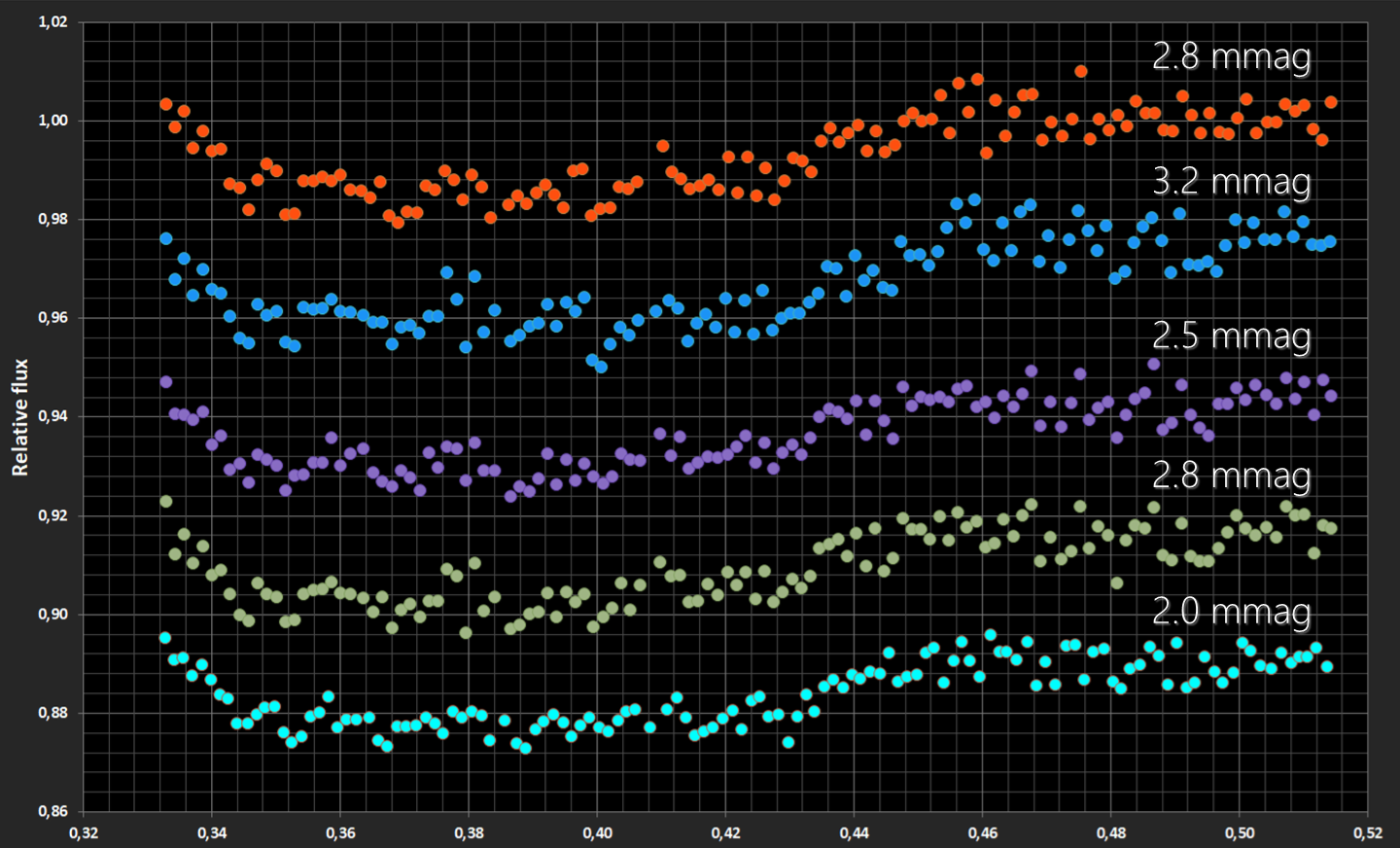

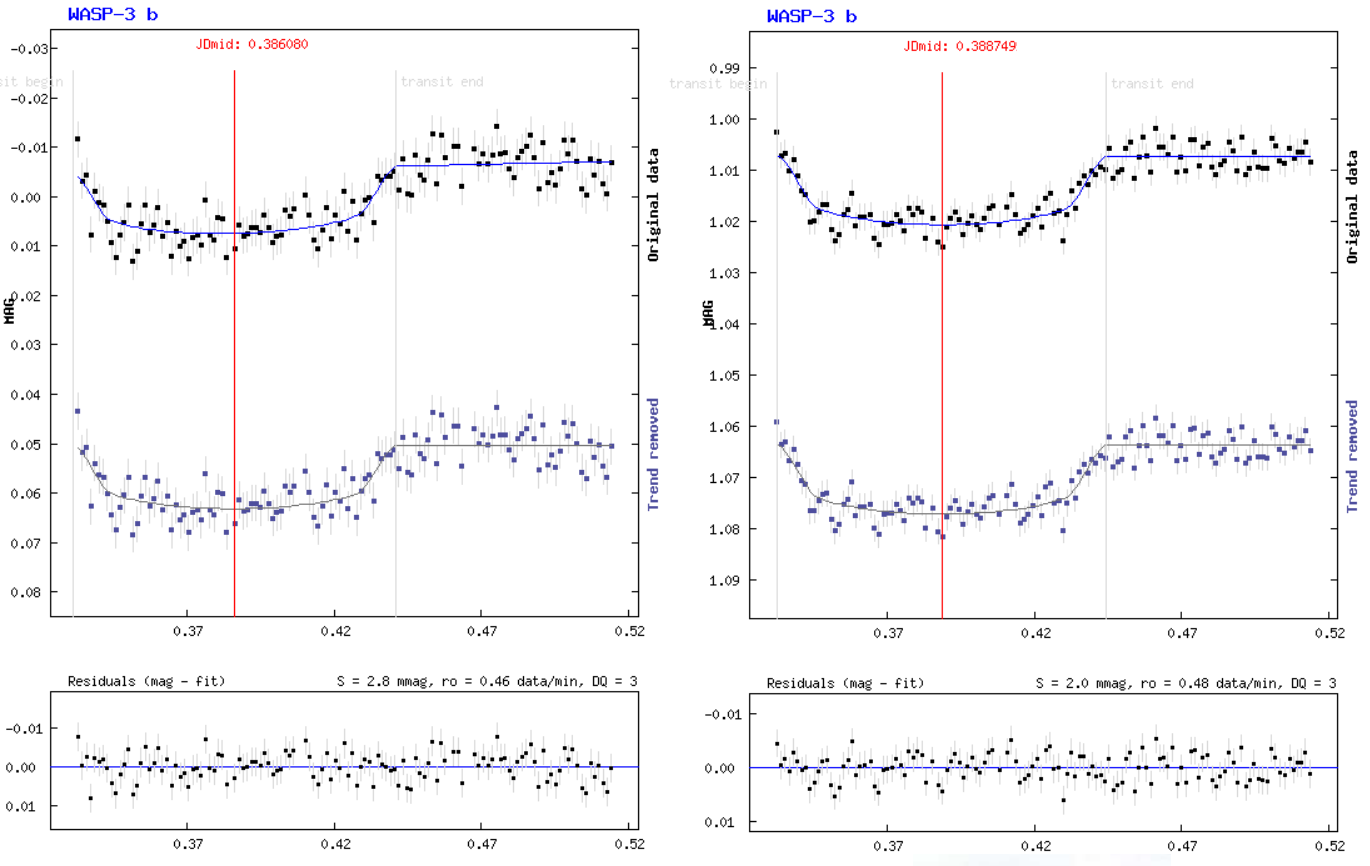

Kolejne fajne porównanie. Ten materiał potraktowałem wieloma metodami uzyskując różne dokładności pomiarowe. Zwykłe uśrednianie (wykres 2), co robiłem w 2017, okazało się najgorszą metodą pod względem dokładności - błąd standardowy w tym przypadku wynosi 3.2 mmag. Wszystkie klatki po normalnym zestackowaniu do tego samego czasu integracji jest lepsze - mamy 2.8 mmag (wykres 1). Trzeci i czwarty wykres to znowu uśrednianie pojedynczych pomiarów, ale z odrzutami. Najpierw 10%, potem 20%. No i te 20% wcale nie okazało się lepsze od dziesięciu A połączenie obu sposobów (wykres 5) dało 2.0 mmag - czyli stack + wywalenie 20%. Ciekawe ile wyszłoby po usunięciu tylko 10%. Dostałem wiadomość od autora Muniwina, że doda te "skróty fotometryczne", a więc będzie można to szybciej wykonywać i sprawdzać Odpowiednie podejście do materiału tak jak w astrofotografii, daje lepsze rezultaty. Myślę, że jest szansa poprawić wynik do 1.5 mmag, co powinno być spokojnie osiągalne przez 8" teleskop (prawdopodobnie 1.0 mmag z ASI1600 oraz 8" na odpowiednim montażu). -

Widziałeś jaki jest ampglow w ASI224, ASI174 i ASI290 (ten akurat najmniej)? Nie bez powodu wybrałem ASI178. Czasem robię testowe ekspozycje na 60s i ampglow nie robi większego problemu, że nawet nie stosuję darków. A jak ktoś bardziej wymaga, to sobie je dorobi. 60 sekund ekspozycji to jeden z uniwersalnych stosowanych czasów w CMOSach do astrofoto.

-

Lubię tego typu wątki, bowiem bardziej interesuje mnie praktyka niż teoria, tak więc posty te wyrównują co o tych różnicach wiem Odpowiedzią CCD vs CMOS jest "to zależy", gdyż tak naprawdę sami musimy zastanowić się nad jego zastosowaniem. Taką samą odpowiedź uzyskasz w astrofotografii i fotometrii. Widzę nawet coraz więcej analogii. Są przypadki, kiedy interesuje Cię bardziej rozpiętość tonalna, w innym np. prędkość. CMOS to zabawy z większą ilością materiału, skoro stosujemy krótsze czasy ekspozycji. I stackowanie ich po większą rozpiętość może sporo pomóc Pytanie czy CMOS nadaje się w fotometrii rodzi też sporą dyskusję nawet na AAVSO. Owszem, długie czasy przy takiej studni nie wnoszą już nic nowego i wprowadzimy już spory błąd w momencie zapisu. Rozrzut wynika z aspektów takich jak scyntylacja, szumy oraz zapis wartości. Trzeba wiedzieć jak do tego podejść, stąd przychodzi z pomocą praktyka. Fotometrię przeprowadzam zawsze na wysokim gainie (150-225), gdzie studnia jest nieco mniejsza niż 4096. Pomimo, że jest to 14-bitowa kamera, to informacja zmieściłaby się w 12-bit. A po co tak robię? Rozpiętość jest nadal tak szeroka, że zmiana wartości o jeden spowoduje różnicę w wartości magnitudo pewnie o jakąś dziesięciotysięczną część. Jeśli wszystkie pomiary wahają mi się o +/- 0.05 mag, to w zasadzie mało mnie interesuje czy pomiar ma dokładnie 0.9483 mag zamiast 0.9484 mag, skoro wszystkie i tak znajdą się między 0.90 a 1.00 mag. Jak damy bardzo długi czas i gwiazda przez seeing zdąży się "ustabilizować", to zwiększa się potrzeba ustalenia dokładniejszej wartości pomiaru i rozpiętość może nie wystarczyć. Takie klatki sobie stackuję zwiększając jednocześnie rozpiętość, nie martwiąc się w zasadzie o dodatkowe szumy wprowadzane większą ilością klatek - one i tak są bardzo niskie. No i wchodzi też kwestia selekcji klatek - pewnie kontrowersyjne (jak pisał w sąsiednim wątku @Gajowy), jednak po raz kolejny wskazujące, że delikatnie poprawiają wynik. Nawet ostatnio opisana metoda całkowicie unika problem ze stosowaniem średniej kroczącej. Bowiem stackuję sobie klatki, które w żaden sposób nie nachodzą na siebie. Równie dobrze ktoś może poprosić mnie o materiał do analizy, a ja wyślę takie stacki - na nich nie dowiesz się czy było po 30x4s lub 25x4s. One i tak po selekcji są dokładniejsze i sam zauważy, że są precyzyjne. Na dowolnych referencyjnych wyjdzie to samo, nawet tych, których nie brałem do analizy przeprowadzając selekcję. Coś na styl superstacków Ba, są nawet dokładniejsze niż ręczne kalkulowanie średnich pojedynczych pomiarów z takimi samymi odrzutami (to ciekawe, ale istotnie tak jest za każdym razem). Astrofotografów jest dużo i robią masę eksperymentów na różnych parametrach i istnieje masa wniosków. Fotometria to wąska dziedzina, trudna do ogarnięcia z powodu dziesiątek zmiennych od których zależy dokładność pomiarowa. Nie eksperymentuje się zbytnio, ludzi takich jest mało. Ja chcę eksperymentować i nadal nie przesiadłem się na CCD o podobnej cenie. Dochodzę do wniosków, o których sam pewnie nie dowiem się czytając w Internecie - bo tego po prostu nie robi się i nie ma konkretnego przepisu na CMOS. Wiedza pozostaje tutaj nadal na poziomie ograniczeń CCD, gdzie żadnych selekcji nie robi się. To doskonale rozumiem, skoro wywalenie klatki 120s bardzo boli. Nastały czasy, kiedy wywalenie klatki 4s, których mam już tysiące, wcale nie boli. Dobrze wiadomo czemu nie robi się 4s z CCD - długi czas zapisu, większy poziom szumu, przewaga 16-bit w zasadzie niczego nie wnosi. Mogę powiedzieć, że jest to nawet przepis na pracę naukową, która mogłaby znaleźć się w prestiżowych czasopismach naukowych. Ale temat ten jest tak szeroki i wymaga wieeeeelu prób (moje 100 nocy obserwacyjnych na różnych celach to za mało, w dodatku robione ciągle tą samą kamerą i obiektywem), że nie chciałbym się podjąć. Minusem jest jedno - czasochłonność. I sporo miejsca na dysku Ale uzyskanie danych z 10-cm obiektywu porównywalnych dokładnością do wyników robionych z CCD i 20-30 cm teleskopem już cieszy Ale później nie jest tak różowo. W pewnym momencie okazuje się, że większym teleskopem brakuje Ci pola widzenia, a gwiazdy stają się coraz bardziej rozmyte przy tak małym pikselu. Obecne droższe kamery CMOS (tak jak 294 czy 071) spisywałyby się doskonale i mielibyśmy widoczny "level wyżej". Poza jednym - są to kamery kolorowe, a więc kończą się schody. Dla jednych (wybrani astrofotografowie) to okno na przyszłość, dla innych (np. w fotometrii) jest ono zamknięte. Tak jak pisałem wcześniej - widzę dużo analogii w astrofoto i fotometrii. Tutaj porównam sobie sytuację, gdzie ktoś fotografuje M51 metodą "lucky imaging", a do stacka dobiera najostrzejsze klatki. Łukasz nie bez powodu to robi Nie każda klatka musi zawierać potrzebną informację. Te, które zostały obarczone seeingiem w największym stopniu, Łukasz sobie odrzuci - takie są w zupełności niepotrzebne. Fizycy ostro krytykujący tego typu zabiegi trzymają się stałych zasad, uważanych zawsze za niezmienne. Jeśli jest udowodniona przewaga w dokładności po wywaleniu (mówię tylko o tym przypadku w tym poście, w innych może nie działać!!!), którego nie można było określić nigdy wcześniej, to dalsze tego typu komentowanie rozumiem coś w stylu wyparcia... Cenne są zdania, co zawiera nie tak lub należy poprawić - możemy wtedy pogadać. Stąd jestem zwolennikiem krótszych czasów niż dłuższych. I teraz znajdzie się taki jeden, któremu CMOS ma wszystko co potrzeba, a inny potrzebuje kamerę do czegoś innego, gdzie nie wystarczy. Każdy działa w tym kierunku, co lubi. Dyskusja tak jak tutaj, murowana. Wesselowi interesują długie czasy ekspozycji i wyciąganie słabych detali, które w 16-bit mają lepszą szczegółowość. W 12-bitowym CMOSie różnica o jeden robi już diametralną zmianę. Trzeba najpierw wystarczająco dobrze naświetlić słaby obiekt. O ciemnych mgławicach z ASI nie wypowiem się - nie wchodzę powyżej 30s, więc trudno mi ocenić jak to jest. Tak samo ze słabymi obiektami, bowiem swoje cele obserwacyjne zawsze doświetlam do pożądanej minimalnej wartości w histogramie. W zasadzie nie zwracam teraz uwagi na drogie kamery powyżej 10 tysięcy, bo są poza zasięgiem ponad 95% amatorów, a te mają zastosowanie bardziej profesjonalne. Myśląc o zastosowaniu kamer CMOS, myślę tylko o tych tańszych, z pokroju 178 czy 1600. ASI183 to jakby taki mix obu modeli, czego efektem jest wielka rozdzielczość i pliki ważące dziesiątki megabajtów. No to znowu wracamy do CCD, gdzie tracimy sporo czasu na zapisanie klatek o krótkich ekspozycjach... nie moja droga

-

Live binning - rewolucja w amatorskiej rejestracji tranzytów egzoplanet?

LibMar odpowiedział(a) na LibMar temat w Egzoplanety

No właśnie, to jest 30 GB materiału (3716 klatek). Stacki okazały się być dokładniejsze niż średnie, co jest przewagą - można je łatwo wysłać. W tym przypadku to zaledwie 124 pliki (30x mniej). -

Live binning - rewolucja w amatorskiej rejestracji tranzytów egzoplanet?

LibMar odpowiedział(a) na LibMar temat w Egzoplanety

W zasadzie to już jest niemal automat - po wrzuceniu klatek, zaznaczasz wszystkie etapy, które chcesz zrobić. Konwersja, klatki kalibracyjne, szukanie gwiazd, dopasowanie. I po jednym przycisku czekam 2-3 godziny. Zapisuję je w postaci 1-klatkowych stacków, bo one są przesunięte. Tak, że gwiazdy znajdują się zawsze w tej samej pozycji X oraz Y. Po analizie w AIJ (selekcji), wracam do Muniwina i stackuję teraz do 120s (po 30 na jeden stack). Nie mogę od razu przejść do AIJ, bo ten ma problemy z dopasowywaniem gwiazd, więc na takich trzeba pracować. Wszystkie skalibrowane stacki po 1 klatce chciałbym teraz zestackować, a one są już odpowiednio przesunięte. Po co miałbym na nowo wyszukiwać gwiazdy i na nowo dopasowywać, skoro mam dopasowane - chciałbym od razu kliknąć stack, ale nie da się. Nie mogę skopiować pierwszego projektu, bo w Muniwinie nadal pozostają wszystkie klatki (tylko potem pojawiają się errory "File not found"). I to jest właśnie ten proces, który trwa 2 godziny... @Behlur_Olderys, podałbyś mi w jaki sposób mogę szybko usunąć wybrane pliki z folderu, mając listę ich nazw? W Excelu mogę wygenerować listę klatek do selekcji. Wyglądałaby coś w tym stylu: delete C:/(…)/frame_0048.fts delete C:/(…)/frame_0053.fts delete C:/(…)/frame_0077.fts delete C:/(…)/frame_0092.fts delete C:/(…)/frame_0115.fts To było coś, że zapisywało się linijki pliku .txt, ale w innym formacie (.cfg? .bat?). Po otwarciu tego pliku miało automatycznie zrobić to, co jest w kodzie wyżej - usunąć wybrane pliki. Kiedyś coś takiego miałem, ale nie mogę znaleźć - było w jakimś tutorialu o IRIS. Ręczne usuwanie kilkuset klatek spośród kilku tysięcy zajęło mi 30 minut. To znacznie szybciej niż googlowanie w poszukiwaniu tego sposobu (bez skutku), przez co straciłem dobre 15 minut. -

Live binning - rewolucja w amatorskiej rejestracji tranzytów egzoplanet?

LibMar odpowiedział(a) na LibMar temat w Egzoplanety

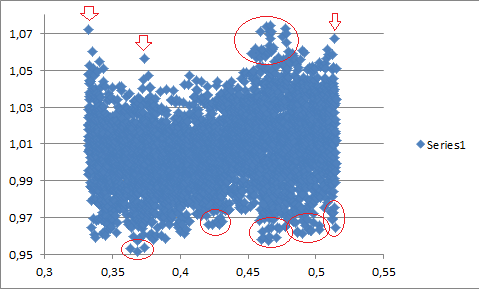

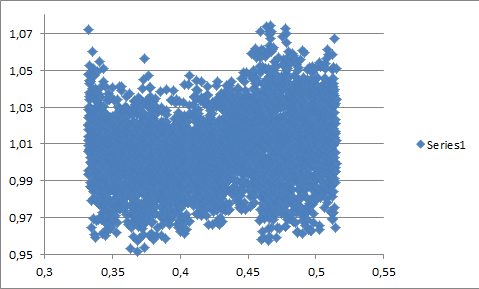

W tym wątku widzę tylko o stackowaniu. W ówczesnych czasach występowała inna metoda, która polegała na wykonywaniu tylko długich czasów ekspozycji (np. po 2 minuty). I to właśnie robi się dalej w obserwatoriach. Unikamy wtedy wprowadzenia dodatkowego szumu. CMOS z tym nie ma problemu. Głupotą nazwałbym wysyłanie takiej obserwacji do ETD: A duży rozrzut pomiarowy wynika z zastosowanych krótkich czasów ekspozycji. Przez 4s, gwiazda na skutek zaburzeń przez atmosferę nie zdąży się ustabilizować jasnościowo. Tu trzeba pakietować (jakoś nie lubię tego słowa) po 2 minuty. Fajnie też widać różnicę w dokładności przy 0.46. Wymagana była poprawka w ostrości i tak naprawdę skopałem. Kolejny raz widzę, że rozogniskowanie nie zawsze poprawia wynik, a ewentualne zastosowanie większej apertury, zwiększa dodatkowo rozrzut. Standardy się zmieniają. Podejście do obróbki w CMOSach jest inne niż w CCD, choć nie miałem z nimi nigdy do czynienia. Po prostu tutoriale i przewidywania dokładności nie sprawdzają się. W przeszłości nigdy nie stosowano krótkich czasów, bo masz długi czas zapisu. Tak długi, że tracisz tyle cennego materiału, że długimi czasami wyjdzie Ci dokładniej. Dlatego robienie 120s zamiast 5x20s może być bardziej precyzyjne, jeśli po każdej klatce potrzebujesz 4s na zapis. Tutaj inaczej - albo wybieram 1x120s przy jakimś sporym defocusie (a po co?), albo 30x4s z możliwością selekcji. Nie podejmę się tego, mając 6x20s. Z kolei 30x4s, 60x2s czy 120x1s - jak najbardziej. A zestackowanie w każdym przypadku przyczyni się do uzyskania podobnej dokładności pomiarowej, pod warunkiem, że jest podobnie mocno doświetlona (tutaj operowałbym różnym gainem). Udowodniłem to sobie na podstawie HD 209458 b. Ale... dlaczego? Po prostu niski poziom szumów CMOS. Szum odczytu przy takich stackach nadal jest na bardzo niskim poziomie. Minus krótszych czasów - gorzej dla słabych gwiazd. Ale nie interesują mnie teraz słabe gwiazdy, ważne, że WASP-3 b jest dobrze naświetlona (do 50% histogramu). Fajnym przykładem jest HD 6121 - zmienna typu Delta Scuti o amplitudzie 0.006 mag. Stacki i uśrednianie nie pokazały nic wyraźnego. Po usunięciu ok. 20% - niespodzianka! Widać falowanie zgodne z efemerydami (tam gdzie max/min, ono występuje). Szkoda, że nie mam na tyle dobrego materiału, aby to zrobić ponownie nowym sposobem. Po drodze muszę przejść do AIJ, a ten nie radzi sobie dobrze z rozjechanymi gwiazdami na skutek kolimacji. Dopiero później dowiedziałem się jak odpowiednio ustawić swój obiektyw, aby zostały punktowe. Stąd każda osoba pracująca z CCD przez wiele lat, zawsze będzie kierowała się metodą długich czasów, bo wydaje się niezmienne. Na AAVSO ludzie do dzisiaj kłócą się co jest lepsze. Zwykle jest tak, że osoba z CCD zostaje przy CCD, a ludzie z CMOSem zostają przy CMOSie. Dokładnie jak na forum co kilka tygodni. W rzeczywistości mają rację z CCD oraz CMOS. Kluczem jest tutaj zastosowanie, co nas interesuje. CCD jest "dla leniwych" ( ), natomiast z CMOSem trzeba posiedzieć trochę dłużej. W przypadku tranzytów, tanim sprzętem (do 10 tysięcy) masz większe pole do popisu CMOSem. Drogi CCD z wielką matrycą i większym teleskopem (np. CDK) sprawdzi się lepiej, bo ma nadal duże pole widzenia przy dużej średnicy. Przy takim samym budżecie, z niskimi kwotami lepiej sprawuje się CMOS, z większymi (100+ tysięcy) - CCD. Zupełnie tak samo jest w astrofotografii I co ważne - tranzytów. Bo jak interesuje nas szukanie gwiazd zmiennych, to lepiej rozważyć CCD. -

Live binning - rewolucja w amatorskiej rejestracji tranzytów egzoplanet?

LibMar odpowiedział(a) na LibMar temat w Egzoplanety

Szukałem odpowiedniego wątku (a takich było pełno), ale chyba chodziło o ten. W ramach potrzeb na konferencję, przedstawiam wyniki związane z selektywnym wybieraniem na podstawie odrzutu najgorszych pomiarów. Tylko tu inaczej - ja tutaj nie uśredniam pojedyncze oceny, lecz stackuję wybrane klatki. Wniosek ciekawy - wywalenie 20% klatek (nie pomiarów) spowodowało wzrost dokładności z std=0.0028 mag do std=0.0020 mag na przykładzie tranzytu WASP-3 b. Jak tego dokonałem? Przeprowadziłem fotometrię na pojedynczych 3716 klatkach po 4 sekundy. Aby wiedzieć jak bardzo pomiar odskakuje, musiałem znormalizować krzywą poprzez usunięcie tranzytu wykonując poziomą linię. Ważne jest, aby uniknąć zdegradowania momentu wyjścia i wyjścia. Dlatego celowo wybrałem ten tranzyt, gdyż rozpocząłem obserwację dokładnie w momencie wejścia. Skorzystałem ze średniej kroczącej obejmującej krótszy czas pomiarów w momencie kontaktów oraz dłuższy poza nimi (przy bardzo płytkich tranzytach można już stosować o tej samej długości, aby nie wprowadzać za bardzo "modelu"). Wykres był nieco poszarpany (natura średniej kroczącej), dlatego wygładziłem na kształt litery U, aby nie faworyzowało w pewnej chwili odstające pomiary. Każdy pomiar porównałem z wartością dla uzyskaną dla modelu (który jest niezbędny, jeśli jest to głębokie zjawisko), a za pomocą percentylów odznaczyłem te klatki, które były najbardziej odległe. I tu jest ważne - klatki, a nie pomiary. Więc nie uśredniam pojedynczych pomiarów z usunięciem tych 20% najgorszych, lecz stackuję znów do czasu integracji 120s, lecz usuwając po 20%. To, co jest istotne, to ilość klatek wypadających dla danych dwóch minut - raz jest ich np. 21, innym razem 27. Postanowiłem już zestackować po 24 kolejnych FITSów, więc ich nieco się różni (raz 21x4s, innym razem 27x4s), jednak ich średnia i tak wypada dla ~120s. Te pomiary zostały zaprezentowane na krzywej: Po lewej - wynik przed (30x4s), po prawej po zestackowaniu wybranych klatek. To co jest istotne, wróciłem do pojedynczych pomiarów - uzyskane stacki nie nakładają się już w żaden sposób na siebie (nie ma średniej kroczącej). Czyli przeszliśmy do punktu wyjścia - mamy stacki i tylko na nich prowadzimy pomiary. Wejście i wyjście także nie uległo degradacji. To dowodzi, że usuwanie polepsza dokładność pomiarową - działa to podobnie, jak przy astrofotografii metodą lucky imaging. Na zawsze pozbyłem się problemu średniej kroczącej, skoro są czyste stacki. Równie dobrze mogę powiedzieć, że miałem w tamtych klatkach satelity na gwiazdach, więc tak czy siak trzeba było się pozbyć. Minusem tej metody jest czasochłonność. Czy warto podejmować się tego zadania tylko dla zmniejszenia rozrzutu o 40%? Pierwotne wyniki uzyskałem po 2-3 godzinach, natomiast krzywą po prawej - po ponad 8 godzinach. Wiele procesów powtarza się i należało wykonać trzy kopie. Napisałem już do autora Muniwina o prośbę odblokowania dwóch elementów (obecnie "skróty" w programie nie działają), aby to przyspieszyć. Po zautomatyzowaniu (gotowy skrypt w Excelu) powinno być to wykonalne w 3-4 godziny, a więc niewiele dłużej. Jak automat będzie gotowy, przetestuję wyniki po usuwaniu 5%, 10%, 30% czy nawet 50% pomiarów klatek. Nie chcę bazować na uśrednianiu tych pojedynczych, lecz na stackach - stąd wymaga więcej czasu. Wartość optymalna wciąż czeka na odnalezienie, ale raczej nie przekraczałbym tych 20%. Myślę, że będzie zależało od ilości klatek wypadających na 120s (którego ciągle się trzymam). Prawdopodobnie im więcej klatek, tym większą wartość procentową można użyć. A nazwa tematu "live binning" teraz bardzo nie pasuje... pasowałoby, gdyby stackowało się tak, jak po lewej stronie, tych klatek o krótkich czasach naświetlania. W zasadzie tutaj pokrywa się tylko to - klatki przy WASP-3 b miały po 4s naświetlania. Obserwację przeprowadziłem za pomocą kamery ASI178MM-c i teleobiektywu Canon FD 300mm f/2.8L. Zaledwie 4 cale średnicy. To nie jest metrowy teleskop. Przewaga CMOS nad CCD w aspekcie krótkich czasów jest wyraźna. -

Ja inaczej u siebie przeliczam. Zrobiłem test z ASI178MM-c przy użyciu programu SharpCap. Włączyłem flatownicę i na kolejno 0, 50, 100, 150, (…), 400, 450 i 500 sprawdzałem w jakich czasach ekspozycji piramidka histogramu znajdzie się dokładnie na poziomie 50%. Wyszło na to, że wzrost gainu o 100 wymaga skrócenia czasu ekspozycji trzykrotnie. Tak więc, mając gain 500, będzie to 3^5=243. Przy najniższej czułości, jeśli wymagałem 243ms, to przy gaine 500 wystarczyło 1ms. W lustrzankach wartość ISO zaczyna się zwykle od 100 i chyba to tylko wartość umowna... biorąc pod uwagę, że ASI178 ma dokładnie zakres 0-510, poziom ISO wyniósłby między 100 a ~25000.

-

Ale ona jest "jasna"! Myślałem, że ma coś około 19.5 mag. Muszę spróbować z 8"

-

W 2022 roku Łabędź z dodatkową jasną gwiazdą!?

LibMar odpowiedział(a) na Paether temat w Astrofizyka, kosmologia i teorie

Jest aktualizacja. Niestety, według modelu i przewidywań, do tego zjawiska jednak nie dojdzie http://www.calvin.edu/academic/phys/observatory/MergingStar/2018Update.html -

XIII Jesienne Star Party - relacje

LibMar odpowiedział(a) na Paether temat w Spotkania, zloty, wyjazdy i imprezy

Tu ledwo można dzwonić, a co dopiero LTE -

XIII Jesienne Star Party - relacje

LibMar odpowiedział(a) na Paether temat w Spotkania, zloty, wyjazdy i imprezy

-

XIII Jesienne Star Party - relacje

LibMar odpowiedział(a) na Paether temat w Spotkania, zloty, wyjazdy i imprezy

Zawsze muszę wyjechać przed wschodem, aby dotrzeć na rozsądną godzinę. No poza jednym razem, kiedy i tak przybyłem o 21 :D -

HD 286123 b: zostałem współodkrywcą nowej planety pozasłonecznej!

LibMar odpowiedział(a) na LibMar temat w Egzoplanety

W końcu, po wielu miesiącach, praca naukowa doczekała się publikacji w The Astronomy Journal http://iopscience.iop.org/article/10.3847/1538-3881/aad6e7 -

XIII Jesienne Star Party - zapisy

LibMar odpowiedział(a) na Adamo temat w Spotkania, zloty, wyjazdy i imprezy

Zasięg był tam zawsze kiepski :/ Niektórzy nie mieli nawet zasięgu, aby przedzwonić- 69 odpowiedzi

-

Przy luminancji (szersze spektrum) jest przydatne, bowiem nie mamy możliwości dokonania korekcji (jest jednokolorowe "jajo". Ale chyba większość i tak robi luminancji z IR-pass, gdzie wpływ bez korektora ADC jest znikomy

-

W zasadzie nie poleca się kamery klasy ASI1600 i wyżej, gdyż właściciele zauważyli przewagę tych z mniejszymi sensorami (choćby kwestia FPS). Pozostają modele 174, 178, 290 w formie mono/kolor oraz 224 i 385 jako tylko kolor. To jedna z kwestii - czy planujesz fotografować kamerą kolorową czy monochromatyczną (koszty filtrów, ADC w zasadzie przydatne w obu przypadkach). Z pewnością IR-pass też przydatny, o ile go już posiadasz. Przejście na jedną z modeli wymienionych wyżej to koszt około 1000-1500 (gdy mówimy o sprzęcie używanym), biorąc pod uwagę sprzedaż obecnej za 500 zł (na oko zaokrąglam, nie dyktuję ceny ). Z kolei przejście na Newtona 12" to koszt minimum 5000 zł, biorąc pod uwagę jeszcze montaż. Przy Twoim budżecie w zasadzie nic w sprawie tuby nie da się zrobić, bo już masz dobrą. Czyli można podnieść możliwości mając nową kamerę. @wessel nie próbowałeś astrofotografii planetarnej którąś z kamer mono (174/178/290)? Mało kto już pracuje na 120 i raczej mają swoje powody.

-

Polska zmienna typu RCB? Typu YSO? Nie, to EXOR!

LibMar odpowiedział(a) na LibMar temat w Gwiazdy Zmienne

Zgłoszenie poszło, czekamy na obserwacje http://ooruri.kusastro.kyoto-u.ac.jp/mailarchive/vsnet-alert/22467 -

Polska zmienna typu RCB? Typu YSO? Nie, to EXOR!

LibMar odpowiedział(a) na LibMar temat w Gwiazdy Zmienne

Najnowsze obserwacje wykonane w ciągu ostatnich dwóch dni wskazują na możliwe (kolejne) osłabienie zmiennej typu RCB. Zaraz ruszamy z alertem. 2018 Aug. 13.60033 - 14.840 V - ASAS-SN 2018 Aug. 18.60063 - 14.730 V - ASAS-SN 2018 Aug. 29.84900 - 14.735 V - MGAB 2018 Aug. 29.89200 - 14.782 V - MGAB 2018 Aug. 30.00500 - 14.856 V - TRT 2018 Aug. 30.91100 - 14.889 V - MGAB 2018 Aug. 31.52190 - 14.96 V - OCN -

Polska zmienna typu RCB? Typu YSO? Nie, to EXOR!

LibMar odpowiedział(a) na LibMar temat w Gwiazdy Zmienne

Dzięki! Wzięło się od tego, aby poszukać zmienne wśród źródeł silnie emitujących w podczerwieni, podobnie jak przy mgławicach planetarnych. Wybieram sobie obszar na niebie (obecnie przejrzane od +25 do +70 w deklinacji między 3h 45m a 5h 30m) i wypisuję najciekawsze obiekty, które w bazie danych VSX nic nie mają znanego. Spośród około 70 celów, mamy 1 RCB, około 10x UXOR lub TTS/ROT/DIP (podobne wyglądem, ale inne B-V), kilka miryd oraz parę rotacyjnych (TTS/ROT). Na chwilę obecną wysłałem tylko RCB, jedno UXOR i jedno TTS/ROT/DIP, reszta jeszcze czeka. Z tym odkryciem, to jest oficjalne od weekendu (wtedy zostało zaakceptowane w VSX), tylko jest potrzeba poznania dokładnej charakterystyki tej gwiazdy. Nie jest konieczne, ale chcemy Szkoda pozostawić w obecnym etapie, jeśli w przyszłości będzie można do niej odnosić się przy pracach naukowych. A więc, jest potwierdzone jako zmienna, jest potwierdzone jako RCB (na podstawie WISE oraz Gaia - post nr 2), ale chcemy potwierdzić, czy to także podtyp RCB jako DYPer (a może coś jeszcze innego, podobnego). Do tego potrzebne spektrum, o które "walczymy" To, jaki będzie typ, zależy od składu izotopu węgla C13. Mówię w liczbie mnogiej, gdyż kilka osób mnie wspiera (Robert i Siegfried) pomagając mi gdzie najlepiej wysyłać, gdzie poprosić o wykonanie spektrum itp. Bo sami są zaintrygowani gwiazdą @Paether dziękuję