-

Postów

9 964 -

Dołączył

-

Ostatnia wizyta

-

Wygrane w rankingu

41

Typ zawartości

Profile

Forum

Blogi

Wydarzenia

Galeria

Pliki

Sklep

Articles

Market

Community Map

Odpowiedzi opublikowane przez MateuszW

-

-

Do foto planet potrzeba przede wszystkim apertury, a to stoi w sprzeczności z Twoimi wymaganiami. O ile Księżyc jakoś rozsądnie wyjdzie, to już na Jowiszu będzie panicznie brakować świtała, o Saturnie nie wspominając.

-

miejsce zwolnione

-

ale to nie o to chodzi: tam JAKIŚ człowiek jest na 100%, więc nie powinno być problemem zrealizowanie jakiegoś zamówienia (nie mówię o 1szt ale np 100szt?)

Skoro matryce mono są na ogół dostępne, to jakaś możliwość jak widać jest

Choć są takie modele, których mono nie kupisz (jak kilka nowych ASI).

Choć są takie modele, których mono nie kupisz (jak kilka nowych ASI).Generalnie do tej pory zazwyczaj mono było jednak w tej samej, lub podobnej cenie, co kolor (patrz większość kamer dedykowanych CCD). Wiele cmosów też ma tą samą cenę (jak ASI174 na przykład). Ale jak widać są takie, gdzie za tego "człowieka", co zabierze matryce przed debayeryzacją, trzeba zapłacić 50% ceny

-

No ale kolorowy CMOS to tylko CMOS mono na który dodano maskę bayera czy jakby tego nie nazwać. W teorii gdyby przechwytywać od producenta te matryce w momencie kiedy nie mają jeszcze maski to powinno taniej wyjść. A w praktyce? No właśnie....

To pewnie sobie leci na totalnie automatycznej linii, gdzie jeden człowiek dosypuje krzem do kadzi, a drugi odwozi pudła matryc wózkiem widłowym do tira

Bo gdyby tam był jakiś człowiek, to mógłby pomijać ten jeden etap produkcji dla np 0,1% egzemplarzy...

Bo gdyby tam był jakiś człowiek, to mógłby pomijać ten jeden etap produkcji dla np 0,1% egzemplarzy... -

Dlaczego?

Dlatego że z małym Newtonem 6" f/4 mamy już rozdzielczość 1 arc sek / piksel. A przy wydajności tych kamerek, pewnie da rade zbierać materiał NB przy sub-ekspozycjach 30 sek, więc EQ5 spokojnie sobie poradzi.

Generalnie "mały piksel" idealnie nadaje sie do parowania z małym ale bardzo jasnym sprzętem typu obiektywy foto.

Tylko z drugiej strony wyobraź sobie wymagania co do kolimacji takiego newtona f/4 z pikselem 2,9 um. W skrócie - porażka murowana. Co innego obiektyw foto lub refraktor dobrej klasy - tu masz rację.

Ale zauważ też, że taki mniejszy piksel z mniejszym teleskopem przy tej samej światłosile i skali będzie zbierał stosowanie do powierzchni piksela mniej światła. To tylko pozornie jest to samo.

-

Piksel mniejszy ale to akurat wg mnie zaleta.

Dlaczego?

-

ale kurcze ta zabawa z guidingiem bardzo mnie smuci, bo docelowo też nie chciałbym zostawać z tym montem, i niespecjalnie chciałbym inwestować w takie rozwiązania. Szczerze mówiąc wolałbym jeszcze zwiększyć gain i robić krótsze klatki, i tak się przemęczyć aż uzbieram na sensowny mont, który w takiej skali pozwoli mi działać bez guidingu.

Guiding nie wymaga żadnej inwestycji związanej z montażem. Kupisz nowy montaż - przełożysz guiding do niego. Masz port autoguidera, masz możliwość podpięcia montażu pod PC - niczego więcej nie potrzeba od montażu.

Niestety, ale w sensownym budżecie nie istnieje żadne montaż pozwalający focić Twoją skalą bez guidera. HEQ5/NEQ6 mają nadal za duże PE. Być może coś koło 10k z iOptrionów by się znalazło z enkoderami najtaniej. Także raczej nastawiaj się na guiding.

-

Wczoraj instalowałem nowy nabytek czyli ASI 120 MM i zauważyłem ciekawą rzecz - należy instalować FireCapture lub inny program do akwizycji PO instalcji driverów.

Bez ASCOM , po instalacji driverów i Firecapture - w takiej kolejności - hula. W innym układzie - nie rusza.

Warto zauważyć, że ASI120 i ASI120 - S mają inne drivery. Wszystkie inne, czyli nowsze modele mają już jeden wspólny driver. Także przypadłości ASI120 mogą być zupełnie inne, jak pozostałych modeli.

Moje niewielkie doświadczenie mówi tyle, że z ASI174 nie miałem żadnych problemów, a instalowałem ją po sofcie akwizycyjnym (FireCapture i Maxim). ASI120 nigdy nie miałem, być może cierpi ona faktycznie na taki problem (a może to też specyfika Twojego kompa, czasem tak jest).

-

Mono nie rozważam bo jest 1700zł droższa, a dla mnie to jest kupa kasy, praktycznie 50% więcej, nie mówiąc nic nawet o chłodzonej wersji, która jak dla mnie jest absurdalnie droga i myślenie o tego typu wydatkach to dla mnie abstrakcja.

No faktycznie wersja mono jest dużo droższa. To jest jakiś totalny absurd, pierwszy raz się spotykam z taką różnicą! Prawie zawsze mono jest w identycznej cenie, co kolor, czasami są różnice rzędu kilku %. Tu chińczyki poszalały.

Adam, umiesz to wytłumaczyć? Matryce mono są droższe, bo mniejszy nakład produkcji?

Tak czy siak uważam, że zakup kamery kolorowej to dla Ciebie strzał w kolano, zupełne marnotrawstwo. Tak, jakby jechać autem z zaciągniętym ręcznym. Jeśli na 1600 mono Cię nie stać, to szukaj mniejszej, ale koniecznie mono.

A w guiding nie chcę się bawić, bo myślę że chyba ten mont pociągnie klatki z 2-3 minuty na takiej ogniskowej, to chyba nie jest jakiś super wyczyn, a kamery cmos chyba powinny sobie poradzić ze zgarnięciem wystarczającej liczby materiału w tym czasie?

Tak, dla cmos 2-3 minuty wystarczą, ale jestem prawie pewien, że montaż tyle nie pociągnie.

Chłodzenie zawsze można dorobić z jakiegoś radiatora i wentylatora komputerowego, może nawet jakiegoś peltiera dorobić.

Teoretycznie wszystko się da, pytanie tylko czy w tej konkretnej kamerze jest to realne. Trzeba by poszukać, czy ktoś to robił. W mniejszych ASI zdarzały się przeróbki, ale te większe raczej już się kupuje chłodzone

Dorobienie chłodzenia to nie aż taka prosta sprawa. No i oczywiście skuteczność takiego chłodzenia będzie co najmniej 2x gorsza, niż fabryczne.

Dorobienie chłodzenia to nie aż taka prosta sprawa. No i oczywiście skuteczność takiego chłodzenia będzie co najmniej 2x gorsza, niż fabryczne.-

1

1

-

-

No, ale czemu nie kupisz ASI1600 MM?

Jeśli będziesz focił tylko z miasta, to moim zdaniem nie ma żadnego sensu pakować się w kolor. W ten sposób tylko na starcie pogorszysz sobie sytuację. Miasto to miejsce na czysty narrowband i tyle, nic innego sensownie się tam nie zrobi. A jeśli ma być przede wszystkim narrowband, to po co tracić fotony na kolorowej matrycy?

Zacząłem się nad tym zastanawiać, bo tayson foci w narrowie właśnie kolorową kamerą.

Tayson niedawno kupił kamerę mono

On zaczynał od fotek kolorowych, bo dysponuje rozsądnym niebem. Dopiero potem spodobał mu się narrowband. U Ciebie jest zupełnie inna sytuacja - ty na starcie wiesz, że narrowband to jedyna sensowna rzecz, na którą warto się nastawić.

On zaczynał od fotek kolorowych, bo dysponuje rozsądnym niebem. Dopiero potem spodobał mu się narrowband. U Ciebie jest zupełnie inna sytuacja - ty na starcie wiesz, że narrowband to jedyna sensowna rzecz, na którą warto się nastawić.Pozostaje jednak inna kwestia. Narrowband wymaga dłuższych czasów, nawet na cmosie (krótszych, niż na ccd, ale dłuższych niż kolor z cmosa). Dłuższe czasy to większy problem z szumem termicznym/hotpikselami, czyli bardziej jednak przydałoby się chłodzenie. Po drugie jakoś nie widzę możliwości, aby Twój montaż dał sobie radę pociągnąć wymaganą długość klatek bez guidingu. Z guidingiem owszem - ogniskową niecałe 500 mm CG5 powinien opanować. Także moim zdaniem guiding prędzej, czy później będzie obowiązkowy.

Faktycznie powstaje dylemat, czy większa ASI1600 bez chłodzenia, czy mniejsza 174 chłodzona. Ale w tym rozważaniu myśl wyłącznie o mono - zarówno 1600, jak i 174. Ja bym chyba jednak poczekał i dozbierał do chłodzonej 1600 mono, a nie szedł w półśrodki

-

Takie rozwiazanie nie ma sensu. UHC-S fundamentalnie zaburzy ci kolorystyke zdjecia. Byc moze nawet jeden z filtrow bedzie w uhc-s zupelnie slepy, trzebaby porownac wykresy.

Duzo lepszym pomyslem jest zakup filtra alp - np idasa lub astronomik cls.

A w ogole, to pytanie jest źle postawione

Potrzebujesz sposobu na wyciecie LP, a nie na wydluzenie ekspozycji (to jest dopiero skutek wyciecia lp). Bo jesli w twoich warunkach takie krotkie czasy juz wystarczajaco odsuwaja histogram z lewej, to ich wydluzanie na sile nie ma sensu (bo czas juz jest wystarczajaco dlugi dla tych warunkow).

Potrzebujesz sposobu na wyciecie LP, a nie na wydluzenie ekspozycji (to jest dopiero skutek wyciecia lp). Bo jesli w twoich warunkach takie krotkie czasy juz wystarczajaco odsuwaja histogram z lewej, to ich wydluzanie na sile nie ma sensu (bo czas juz jest wystarczajaco dlugi dla tych warunkow). -

No nie gadaj, że jednak HEQ5 stanie się Twoim mobilnym montażem

-

Piera trzeba normalnie wkopać w ziemię, ale zrobić odpowiednio większy fundament i grubszy sam pier, niż "standardowo".

A tak nie należy tego robić

http://astropolis.pl/topic/57752-potrzebna-opinia-architekta/page-1

http://astropolis.pl/topic/57752-potrzebna-opinia-architekta/page-1-

1

1

-

-

Kurcze, jesteś po prostu genialny! Niezwykle merytoryczny i przyjazny w odbiorze materiał. Większość "konkurencji" nie dorasta do pięt

Myślę, że z filmu skorzystają zarówno zaawansowani (jako uporządkowanie pojęć), jak i początkujący.

Myślę, że z filmu skorzystają zarówno zaawansowani (jako uporządkowanie pojęć), jak i początkujący.Choć z drugiej strony obawiam się, że dla "laika" to może być zbyt przeładowane treścią. Ale cóż zrobić, laikowi wypadałoby tłumaczyć te zagadnienia co najmniej godzinę, a szkoda czasu

Pewne zdania, które dla nas wydaja się oczywiste, mogą być dla wielu czymś totalnie nie do przyswojenia. Ale gdybym sam miał zrobić taki film, to chyba nic bym nie zmieniał

Pewne zdania, które dla nas wydaja się oczywiste, mogą być dla wielu czymś totalnie nie do przyswojenia. Ale gdybym sam miał zrobić taki film, to chyba nic bym nie zmieniał

FB to chyba najszybszy sposób na "zaistnienie" wystarczy że koledzy i "znajomi" widza co robisz, następnie "znajomi Twoich znajomych" a później nastpuję zjawisko toczącej się kuli.

Ja FB widzę nieco inaczej. To jest totalny śmietnik, w którym ginie wartościowa treść. Polubiłem stronę kolegi już dawno, a jak do tej pory nie przypominam sobie, żebym mi się pokazał choć jeden post w widocznym miejscu. Teraz zmieniłem ustawienia na "wyświetlaj najpierw", może pomoże, choć już z kilkoma stronami tak zmieniałem i nadal ich nie widzę.

Niestety, tylko prymitywne treści "dla mas" potrafią się przebić przez ten wszechobecny szajs na FB i zaistnieć na szeroką skalę. Merytoryczne i przyjazne w odbiorze, ale jednak tematycznie niszowe rzeczy, jak treści naszego kolegi zawsze pozostaną nieco w cieniu. No ale jasne jest, że lepiej promować swoje treści wszędzie gdzie się da, zawsze ktoś więcej na nie trafi.

Osobiście życzę Tobie jak największych sukcesów, jak największego rozgłosu i oglądalności. Twoje filmy spokojnie mogłyby zastąpić prymitywne i treściowo ubogie programiki na Discovery i wprowadzić tam nową jakość

-

2

2

-

-

no tak, nasza percepcja dostosowuje się do koloru oświetlenia i nawet tego nie zauważamy.

i potem się dziwimy dlaczego aparaty są tak głupie i nie potrafią zrobić najprostszej rzeczy do której zostały zbudowane - przekazać obraz który wygląda prawdziwie.

tymczasem aparat w całej swojej obiektywności może określić kolor prawidłowo, jednak my i tak zobaczymy go już inaczej

Najbardziej jest to widoczne w nocy, w świetle lamp sodowych. Nasze oczy widzą, że lampy są pomarańczowe, ale otoczenie ma nadal w miarę "naturalną", czyli różnorodną kolorystykę. To dlatego, że nasze oczy "ustawiają" sobie odpowiedni balans bieli. Aparat też ma automatyczny balans bieli, ale on w takich warunkach wymięka

Zdjęcie jest ewidentnie zbyt pomarańczowe. Dopiero ustawienie ręcznego balansu blisko granicy zakresu regulacji pozwala na uzyskanie na zdjęciu tego, co widzi oko.

Zdjęcie jest ewidentnie zbyt pomarańczowe. Dopiero ustawienie ręcznego balansu blisko granicy zakresu regulacji pozwala na uzyskanie na zdjęciu tego, co widzi oko.Automatyczne ustawianie balansu bieli w aparacie polega na analizie kolorystyki całego obrazu. Aparat stara się uzyskać "sporą różnorodność". Dlatego też czasami, gdy mamy w kadrze same obiekty o podobnym kolorze, aparat ustawia niepopranym balans, starając się zróżnicować te obiekty. Albo gdy zrobimy zdjęcie żółtej piłki na żółtej kartce, to wszystko wyjdzie białe

Co lepszy aparat tym lepszy algorytm ustalania balansu, takie lustrzanki jednak inteligentniej sobie radzą, niż telefony (zwłaszcza starsze). Ale oko jest tutaj najlepszym sprzętem i jego algorytm bije na głowę każdy aparat (a może się nam tak tylko wydaje?).

Co lepszy aparat tym lepszy algorytm ustalania balansu, takie lustrzanki jednak inteligentniej sobie radzą, niż telefony (zwłaszcza starsze). Ale oko jest tutaj najlepszym sprzętem i jego algorytm bije na głowę każdy aparat (a może się nam tak tylko wydaje?).Ostatecznie rodzi się pytanie: jaki balans bieli jest tym "właściwym"? Odpowiedź wydaje się prosta - taki, przy którym źródło światła jest białe - jak Słońce, żarówka. No dobra, ale co jak mamy źródła światła o różnej barwie? Albo jakiejś totalnie egzotycznej? Albo jak weźmiemy pod uwagę, że odbite od przedmiotu światło również oświetla resztę sceny jakimś kolorem? Sprawa się wyraźnie komplikuje. I jak dla mnie - nie ma tu jednoznaczniej odpowiedzi.

-

Kolejna zabawa kolorami, która w ekspresowym tempie przetacza się przez internety:

Ktoś tu nie umie zbalansować koloru, niech się lepiej weźmie za Astrowizję, to może się czegoś nauczy

1 min zabawy w PSie:

No dobra, faktycznie obiektywnie rzecz biorąc (sprawdzając kolor w programie) truskawki są w większości w okolicy szarego. Choć te jaśniejsze miejsca maja lekką przewagę czerwieni. Patrząc subiektywnie (oczami) wydaje się to niemożliwe

Czy to kwestia dostosowywania się balansu bieli oka, które stara się wyrównać kolory? Czy to już mózg? A może to jedno i to samo?

Czy to kwestia dostosowywania się balansu bieli oka, które stara się wyrównać kolory? Czy to już mózg? A może to jedno i to samo?-

1

1

-

-

A jak ciężko potem po takim radosnego astrofoto wrócić do starych giudowanych zdjęć

Na szczęście świat idzie do przodu i już chyba pozostaniemy przy szybkich klatkach.

Na szczęście świat idzie do przodu i już chyba pozostaniemy przy szybkich klatkach.Pasy widać też na stacku bez drizzle i darków, one tylko wzmocniły efekt. Zauważyłem, że te matryce CMOS poniżej jakiegoś czasu naświetlania głupieją i dostają każda właściwych dla swojego gatunku artefaktów, podobnie zresztą mają ATIKI CCD, ale nikt z Was nie robił nimi 1s więc nawet nie zauważyliscie a polecam spróbować. Może się okazać, że dla uzyskania jednorodnego tła albo będziesz robił 20 000 klatek albo wydłużysz czasy do 5-10-20 sek.

Z pasami są dwie sprawy. Po pierwsze są pasy "sprzętowe", o których piszesz. Faktycznie to widać na klatkach, ale jest w Autostakkert bardzo fajna funkcja usuwania tych pasów - usuwa je w zasadzie całkowicie. Drugi rodzaj pasów powstał z powodu jednostajnego dryfu obrazu i to, że są akurat poziome, wynika z orientacji kamerki. Te pasy to po prostu rozmazane hotpiksele zarówno te mocne, jak i prawie niewidoczne. Gdyby w autostakkert dało się wybrać metodę stackowania na jakąś sigmę, to pewnie by tego nie było. A tak to nawet nie wiem, jakim algorytmem on to stackuje. Gdyby odjąć od tego prawidłowo darka, to efekt powinien zniknąć. Niestety, coś poszło nie tak i dark co prawda usunął hoty na pojedynczych klatkach, ale po złożeniu powstała kaszana w tle. I ta kaszana jest co najmniej kilka razy mocniejsza, niż te pasy bez darków. To nie jest tylko dodanie szumu własnego darków, to zdecydowanie coś więcej. A, to wadliwe zdjęcie jest bez drizzle - jak piszesz, ono tu nie gra jakiejś istotnej roli.

-

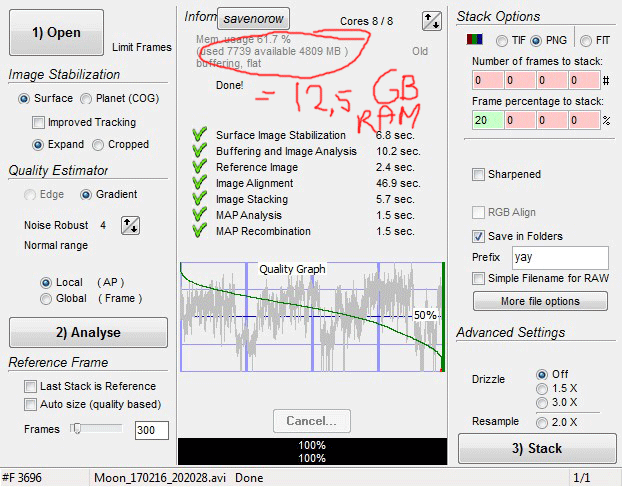

Zabaw ciąg dalszy.

Wczoraj wreszcie wybrałem się na jakieś obserwacje po dłuższej przerwie. Chmury był w kratkę, chodziło trochę niedeterministycznych niziołków po niebie

Najpierw odświeżyłem nieco wizuala, a później zapiąłem swoją ASI174MM, żeby zobaczyć co jest warta w mojej tubce. Miałem focić tylko Jowisza (o nim w innym wątku, jak go skończę), ale naszło mnie na szalony pomysł: M13.

Najpierw odświeżyłem nieco wizuala, a później zapiąłem swoją ASI174MM, żeby zobaczyć co jest warta w mojej tubce. Miałem focić tylko Jowisza (o nim w innym wątku, jak go skończę), ale naszło mnie na szalony pomysł: M13.Spróbowałem więc "astrofotografii radosnej" - bez guidingu, bez autofocusa, bez plateslova, bez Maxima i bez wielu innych rzeczy. Po prostu kamerka i jeden kabel USB do laptopa

No dobra, był też DreamFocuser (ale bez połączenia z PC), było koło filtrowe (ale wybrany tylko filtr L, też bez PC). Kamerka wsadzona byle jak, na jakiś clamping ringach, jak to pod planetki. Brak korektora. Toż to zniewaga dla DS! Ale coś wyszło. Postawiłem na krótkie ekspozycje - uznałem, że sensowne będzie 1 s, bo już coś tam widać, a jeszcze można się wstrzelić pomiędzy gorszy i lepszy seeing. Pokonanie seeingu - tego pragnąłem.

No dobra, był też DreamFocuser (ale bez połączenia z PC), było koło filtrowe (ale wybrany tylko filtr L, też bez PC). Kamerka wsadzona byle jak, na jakiś clamping ringach, jak to pod planetki. Brak korektora. Toż to zniewaga dla DS! Ale coś wyszło. Postawiłem na krótkie ekspozycje - uznałem, że sensowne będzie 1 s, bo już coś tam widać, a jeszcze można się wstrzelić pomiędzy gorszy i lepszy seeing. Pokonanie seeingu - tego pragnąłem.A więc tak:

SW200/800 + ASI174MM + Baader L + NEQ6.

900 x 1s (z 1100 klatek) = 8GB

Gain 240 (podobno "lowest readout noise"), tryb 12bit, rejestracja w FireCpature do FITsów (bo Maxim za wolno zapisywał takie krótkie klatki i tracił cenny czas).

Gain 240 (podobno "lowest readout noise"), tryb 12bit, rejestracja w FireCpature do FITsów (bo Maxim za wolno zapisywał takie krótkie klatki i tracił cenny czas).To jest drizzle 1,5x, full zdjęcie. I wciąż ostre

Skala natywna 1,5"/pix, z drizzle to jest 1"/pix. Dawno (wcale?) nie miałem tak ostrego zdjęcia z tego newtona. Obróbka w miarę szybka. No więc tak: widać komę, widać pasy w tle. Koma nie taka zła, bo matryca mała. A pasy to wina poziomego dryfu (brak guidingu). Niestety, ale odjęcie darków przyniosło dziwny efekt "fal":

Skala natywna 1,5"/pix, z drizzle to jest 1"/pix. Dawno (wcale?) nie miałem tak ostrego zdjęcia z tego newtona. Obróbka w miarę szybka. No więc tak: widać komę, widać pasy w tle. Koma nie taka zła, bo matryca mała. A pasy to wina poziomego dryfu (brak guidingu). Niestety, ale odjęcie darków przyniosło dziwny efekt "fal":Ktoś wie, o co chodzi? Materiał stackowany w Autostakkert2. Komuś się udało tam użyć poprawnie darków? Przydałoby się osunąć te rozmazane hoty, ale lepsze hoty, niż te fale...

To tylko 15 min materiału. Efekt mnie na prawdę zaskoczył. A najlepsze jest w tym wszystkim ta beztroska, to "radosne fotografowanie". Wszystko działa, bo w zasadzie nic nie ma. Wszystko proste na maxa. To jest piękne. No ale jednak kosmetyka tego zdjęcia cierpi, jednak ten wielki Atik coś tam umie zdziałać

Tak sobie myślę, co by było, jakbym ASIę wsadził w Mocnego Kolegę 2,5x

Co by wyszło z tego związku?

Co by wyszło z tego związku?-

5

5

-

-

Dokładnie, zapewne telefon sam dobiera czas exp, stąd obraz jest przepalony.

Gain to po prostu wzmocnienie- elektroniczne wzmocnienie sygnału. Gain wzmacnia wszystko-szumy też.

Niby tak, ale szum odczytu zmniejsza się wraz z gainem

Tzn wzrasta, ale wolniej niż proporcjonalnie - stąd jego udział w obrazie maleje. Stąd te wykresy na stronie ZWO z szumami

Tzn wzrasta, ale wolniej niż proporcjonalnie - stąd jego udział w obrazie maleje. Stąd te wykresy na stronie ZWO z szumami

-

Te wszystkie współczesne kamerki raczej na pewno nas nie ograniczają szybkością transferu. To jasność obiektu i jasność optyki jest ograniczeniem.

Jasne, masz rację, że współcześnie kamerki są szybsze, niż da się w praktyce wykorzystać z uwagi na konieczny czas naświetlania. Ale to jeszcze nie ten etap, gdy wszyscy mają kamerki po 300 FPS

Dalej w półce cenowej < 1000 zł mamy najczęściej prędkości, które potrafią ograniczać. Autor wątku pyta o kamerkę za 400 zł, tutaj na pewno nie znajdziemy konstrukcji 300 FPS

Dalej w półce cenowej < 1000 zł mamy najczęściej prędkości, które potrafią ograniczać. Autor wątku pyta o kamerkę za 400 zł, tutaj na pewno nie znajdziemy konstrukcji 300 FPS  Także w tym ekonomicznym segmencie wciąż transfer jest ograniczeniem.

Także w tym ekonomicznym segmencie wciąż transfer jest ograniczeniem.Wczoraj miałem wreszcie okazję ponagrywać Jowisza nową ASI174MM. Przy f/20 udało mi się wycisnąć sensowne 60 FPS w filtrach RGB, przy gainie rzędu 75%. Na f/10 poszalałem na jakiś 150 FPS. To nadal daleko poniżej możliwości kamerki

"Ja nie pisałem o czasie ekspozycji, tylko prędkości nagrywania."

Mateusz , jedno z drugim jest związane

fps(wyrażone w ramkach na sekundę) x czas rejestracji pojedynczej ramki ( w milisekundach) =1000

Tak, jasne. Jedno zależy od drugiego. Ale to nie zmienia faktu, że można te rzeczy analizować osobno. Czyli, że mój wniosek, że szybsza kamerka pozwala na lepsze "pokonanie" seeingu wynika z FPS, a nie czasu naświetlania (który siłą rzeczy musi być krótszy).

-

to tylko pobożne życzenia nie mające nic wspólnego z rzeczywistością

skąd pomysł, że są jakieś bardzo krótkie momenty gdy do teleskopu dociera niezdeformowany obraz planety? Deformacja czoła fali zawsze występuje, a skrócenie czasu ekspozycji nie ma na to żadnego wpływu. Do tego trzeba by jeszcze jakiegoś niesamowitego zbiegu okoliczności aby czoło fali z każdego punktu (docierające do każdego piksela) nagle w jakimś momencie było bez deformacji (i to powtarzalnie na czas wielu ekspozycji). Tu nie ma o czym dyskutować. To po prostu nie jest możliwe

gdyby obraz był niezdeformowany przy czasie ekspozycji np. 5 ms i przy każdej kolejnej klatce naświetlanej 5 ms to byłby też niezdeformowany przy klatce naświetlanej 10 ms, 20 ms itd.

To nie pobożne życzenia, tylko technika stosowana powszechnie wśród planeciarzy. Jeśli uważasz, że seeing jest taki sam przez cały okres rejestracji, to chyba nie mamy co dalej dyskutować...

Może ktoś znajdzie na swoim dysku na szybko awika, który pokaże naocznie, jak dynamicznie seeing potrafi się zmienić? Pamiętam, że Wojtek wrzucał tu takie filmiki czasem. Od swojej strony mogę na ten moment wrzucić tylko znalezionego w necie screena z autostakkert:

Może dziś uda mi się zestackować Jowisza z ostatniej nocy, to będę miał jakieś własne przykłady. Na tym wykresie (szarym) mamy pokazane, jak jakość obrazu zmienia się w czasie awika. Można więc założyć, że jest to praktycznie wykres zmian seeingu. Widać tu wyraźnie 3 okresy lepszego i 3 gorszego seeingu.

Nigdzie nie pisałem, że do teleskopu dociera całkiem niezdeformowany obraz, przez jakkolwiek krótką chwilę. To byłoby niezmierne szczęście, aby tak się stało choć na 1 ms, w naszych warunkach to praktycznie niemożliwe. Mi chodzi tylko o to, że seeing się zmienia w czasie tej minuty, czy dwóch. Przez kilka sekund potrafi być przysłowiowa brzytwa - czyli np 2-3x lepszy, a w pozostałym czasie totalne mydło. Głównie na Słońcu zauważałem takie bardzo wyraźne zmiany - przez większość czasu widać tylko zarys granulacji, a ze 2 razy na jakieś 3 sekundy wszystko się wyostrza, granulacja wyskakuje i jest brzytwa. Czasami zmiany są mniej dynamiczne, obraz się stopniowo pogarsza lub polepsza. Ale seeing się zmienia i to nie podlega dyskusji!

I mi własnie chodzi o to, żeby w czasie tych np 3 sekund brzytwy seeingu zebrać jak najwięcej klatek. Potem zostawimy np 20% całości, z czego 1/4 to będzie ta brzytwa. Przy np 2x wolniejszej kamerze musimy zostawić 40%, żeby mieć tyle samo klatek i wtedy tylko 1/16 klatek będzie brzytwa (2x mniej, bo stackujemy klatki z 2x dłuższego czasu i kolejne 2x, bo w czasie tych 3s nagraliśmy 2x mniej klatek).

Ja nie pisałem o czasie ekspozycji, tylko prędkości nagrywania. Ekspozycja do inna sprawa. Tutaj jest kwestia "zamrożenia" seeingu, które następuje przy jakimś tam czasie (wydaje mi się, że rzędu 20-30ms, ale głowy nie dam). To wynika z częstotliwości falowania seeingu, która wynosi kilkadziesiąt herców (poprawcie, jak piszę głupoty). Jeśli mamy exp poniżej tego czasu (jakikkolwiek by on nie był), to seeing jest z grubsza zamrożony. Tak więc dalsze skracanie czasu nie wnosi wiele do ostrości klatki. Więc, jeśli na wolnej kamerze osiągniemy ten wystarczająco krótki czas, to szybka kamera, gdzie damy jeszcze krótszy czas, nic nam nie da w tej kwestii.

-

1

1

-

-

Nie widziałaś czasem cienia Europy?Dzisiejszy Jowisz wraz z księżycami galileuszowymi.

Ja wizualnie nie widzialem, ale mam na awiku.

Ja wizualnie nie widzialem, ale mam na awiku.

-

Sa jeszcze 3/8", je stosuje sie np miedzy glowica statywu, a nogami, albo pod jakies ciezkie rzeczy (jak MTO). Ale 1/4" jest jednak duzo bardziej popularny. Upewnij sie, ktory potrzebujesz.

-

Sa jeszcze w sklepach foto i astronomicznych, ale nieco drozej. Jak masz na miejscu, to najlepsze wyjscie.

Jak wykonać dokładną śrubę metryczną?

w ATM, DIY, Arduino

Opublikowano

Zauważcie, że precyzja takiej śruby będzie nie lepsza, niż dokładność zębów przekładni tokarki