-

Postów

684 -

Dołączył

-

Ostatnia wizyta

-

Wygrane w rankingu

2

Typ zawartości

Profile

Forum

Blogi

Wydarzenia

Galeria

Pliki

Sklep

Articles

Market

Community Map

Odpowiedzi opublikowane przez Przemek Majewski

-

-

Teraz, isset napisał:

Z takim podejściem zostaniesz sam ze swoim zajebistym wypracowaniem

o Panie...

dzięki za komplement

dzięki za komplement

-

1

1

-

-

15 minut temu, isset napisał:

Odnoszę wrażenie, że jesteś wrażliwy na proste pytania

to też nie jest wątek o Twoim wrażeniu na temat mojej wrażliwości

XD

-

9 minut temu, Tayson napisał:

pozwól, ze przemilcze ostatni akapit Twojej wypowiedzi....

chciałbym to lepiej zrozumieć! nie chce psuć zabawy, ale tak jakby... nie przemilczałeś

-

aha, tak, konkluzja, że kalibracja działa. wiem, troche trywialne, ale przeszukanie internetu daje sporo "kalibracyjnych horrorów". uwagi klientów którzy sobie nie radzą (rodo) też się pojawiają.

chciałem krok po kroku pokazać w wypadku sensora, ktory nie jest "idealny" jak krok po kroku kalibracja powinna wygladać i jak "prostuje" nam "klatkę".

jeśli uważasz ze to zbyt trywialne, to nie będę w przyszłości pisał taki raporcikow z moich zabaw

-

4 minuty temu, dobrychemik napisał:

Przemku dziękuję za odpowiedź.

Głupio zrobiłem pytając o sprawę dotyczącą ASI294 w Twoim wątku. Przepraszam, będę się bardziej pilnował.

nie przesadzaj, wątek na temat asi294, i jak mnie już znacie -- sporo żartuje, bardziej chodzilo mi o to, że sporo pracy włożyłem, w robienie tych darków, flatów, kosmosów, tpl tez pomogli bo miałem dostęp do zgloszeń serwisowych asi294mc nie cool.i asi294mc cool, wiec miałem to jak sprawdzić. Po prostu nie spodziewałem się tak prostego pytanie tak ot cyk pod postem z taką ilością pracy

A w sumie wiesz, że też zawsze mozesz do mnie napisać prywatnie i zwykle odpowiadam obszernie. A jak chcemy, to jakis watek o HCG vs LCG i dlaczego jest offset, też zrobię

A w sumie wiesz, że też zawsze mozesz do mnie napisać prywatnie i zwykle odpowiadam obszernie. A jak chcemy, to jakis watek o HCG vs LCG i dlaczego jest offset, też zrobię

Chcemy?

-

2

2

-

-

Tomek,

1) HCG to High Conversion Gain, to na pewno wiesz, może powinienem rozwinąć akronim. Dwa zestawy "wzmacniaczy" w każdym pikselu, jedne zoptymalizowane pod niskie światło (HCG) i drugie pod duże (LowCG, LCG). Ciekawa sprawa.

2) Tak, płuca na flacie w bliskim IR, przynajmniej to moja diagnoza obecna. Nie mówie, że ostateczna. Na forach CN mowią czasem o tym, poza tym debajerują te flaty z wersji MC i też pokazują przez to "problemy z kolorami", które wyniakają raczek z blednej prezentacji flata.

Flata powinno sie splitować i ogladać każdy kanal rgb osobno, nie debajerować. A kalibrować oczywiście wszystko przed debajerowaniem.

Czy to uzupełnia Twoje wątpliwości?

-

1

1

-

-

11 godzin temu, dobrychemik napisał:

Akurat jestem od kilku dni szczęśliwym posiadaczem ASI 294 MC-Pro i mam jedno zasadnicze pytanie: jaki stosować Gain?

Nota bene ja też mam jedno zasadnicze pytanie: co sprawiło, że postanowiłeś to pytanie zadać w tym wątku?

Narzuca mi się też drugie: dlaczego nie zaczałeś swojej wypowiedzi od jakiegoś small talku, np. "fajne opracowanie Przemek, a jakiego gainu używałeś i dlaczego?".

Ale to ja jestem bucem

No nic. Tym niemniej spróbowałem odpowiedzieć

No nic. Tym niemniej spróbowałem odpowiedzieć

-

1

1

-

1

1

-

1

1

-

-

9 godzin temu, dobrychemik napisał:

Akurat jestem od kilku dni szczęśliwym posiadaczem ASI 294 MC-Pro i mam jedno zasadnicze pytanie: jaki stosować Gain? Czy to jest tak, że do różnych obiektów warto go zmieniać czy lepiej ustawić raz i, póki jestem zielony, nie zmieniać? Jeśli nie zmieniać to jaką wartość ustawić?

może to lekki offtop, ale w Twoim wypadku jak już Tobie odpowiedziano - gain 120, offset 4. tak jak pisałem, zrób < sekundowego darka i upewnij się, że nie ma zerowych pikseli.

co do gainu są super prelekcje Dr. Glovera na YT, ale w praktyce, zmienianie gainu daje niewiele wiecej niż męczarnie z kalibracją, szczegolnie w wypadku amp glowowych kamer -- musialbyć robić lub skalowac darki!

ogólnie przybliżone zasady do każdych kamer są takie:

- uzywasz najmniejszego HCG (jeśli takie jest)

- do Księżyca albo ds-ów używasz gainu zero tylko jeśli focisz jasny obiekt jakimś f/2 (np. jeśli na HCG robiłbyś minutowe ekspozycje to na gainie 0 będziesz robił pięciominutowe, o lepszym SNR i bedzie wygodniej)

- zapomnij o bajkach typu "unity gain" bo to największa bzdura całego internetu. tym bardziej, że "biedni" posiadacze 6200 lub 2600 nie bardzo mają co zrobić, bo nie maja "unity gainu".

Co robię np. ja? Jak coś testuje z balkonu a nie chce mi się np. stackować pięciu klatek po dwie minuty, to robię jedną dziesięciominutową na gainie 0 (najniższy LCG). Czyli np. do "przymierzenia" też jest to dobra metoda, ktora trochę ułatwia życie.

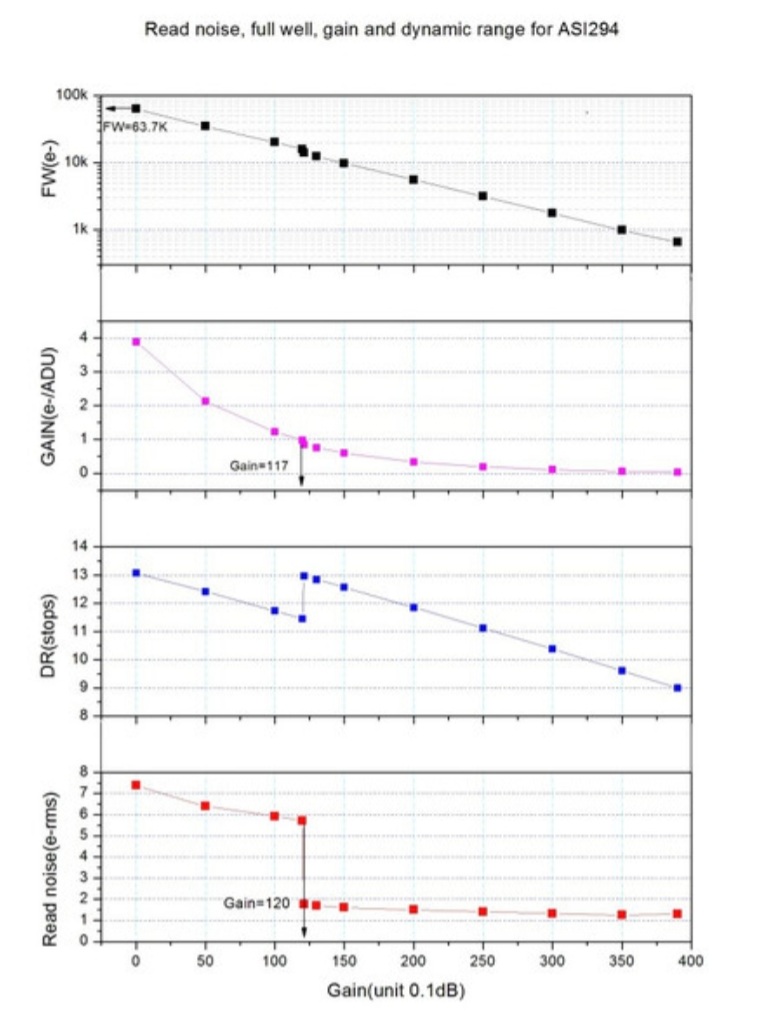

Bardzo warto się zapoznać z wykresem ze strony producenta:

Co tu widać? Ano widać, że unity gain 117 byłby najgłupszym możliwym gainem życia. o krok przed zbawiennym HCG. Tylko dlatego, że tam wypada mnożnik 1 e- na 1 bit ADC (w tym wypadku sztuczne 14 bitów zrobione z czterech 12 bitowych pikseli które w wersji MM można "rozbinować").

Więc 0 lub 120 w zależności od jasności obiektywu/obiektu. Wykres także odpowiada, że stosunek wzmocnienia (e-/adu) wynosi 4 dla gainu zero, a ok 1 dla 120. To daje też czterokrotny stosunek czasu ekspozycji w praktyce. Czyli na 0 można 4 razy dłużej jeśli to potrzebne dla wygody.

A tak poza tym... zawsze 120 i offset 4 (z pamięci mówię).

Aha! jak sprawdzić że HCG działa? Przemas ma wszystko...

pozdrówki

pozdrówki

-

1

1

-

-

- Ta odpowiedź cieszy się zainteresowaniem.

- Ta odpowiedź cieszy się zainteresowaniem.

Dotarło do mnie ostatnio sporo różnych rantów z internetu, że tło dziwne, że artefakty, że pattern noise, że chłodnica itd. I postanowiłem to sprawdzić dokładniej. Teleskopy.pl też byli zainteresowani, gdyż także do nich trafiło sporo uwag, że coś "źle działało".

Disclaimer: post będzie przydługi, i dość techniczny, ale tu mnóstwo koneserów tego typu treści. Dzielę go więc na trzy sekcje

- wstęp w skrócie i rezultaty

- analiza kalibracji (ze zdjęciami/zrzutami ekranu, nie wszystkimi bo nie chce zaspamować, czy zrobić z posta książki)

- dodatkowe uwagi/dyskusja

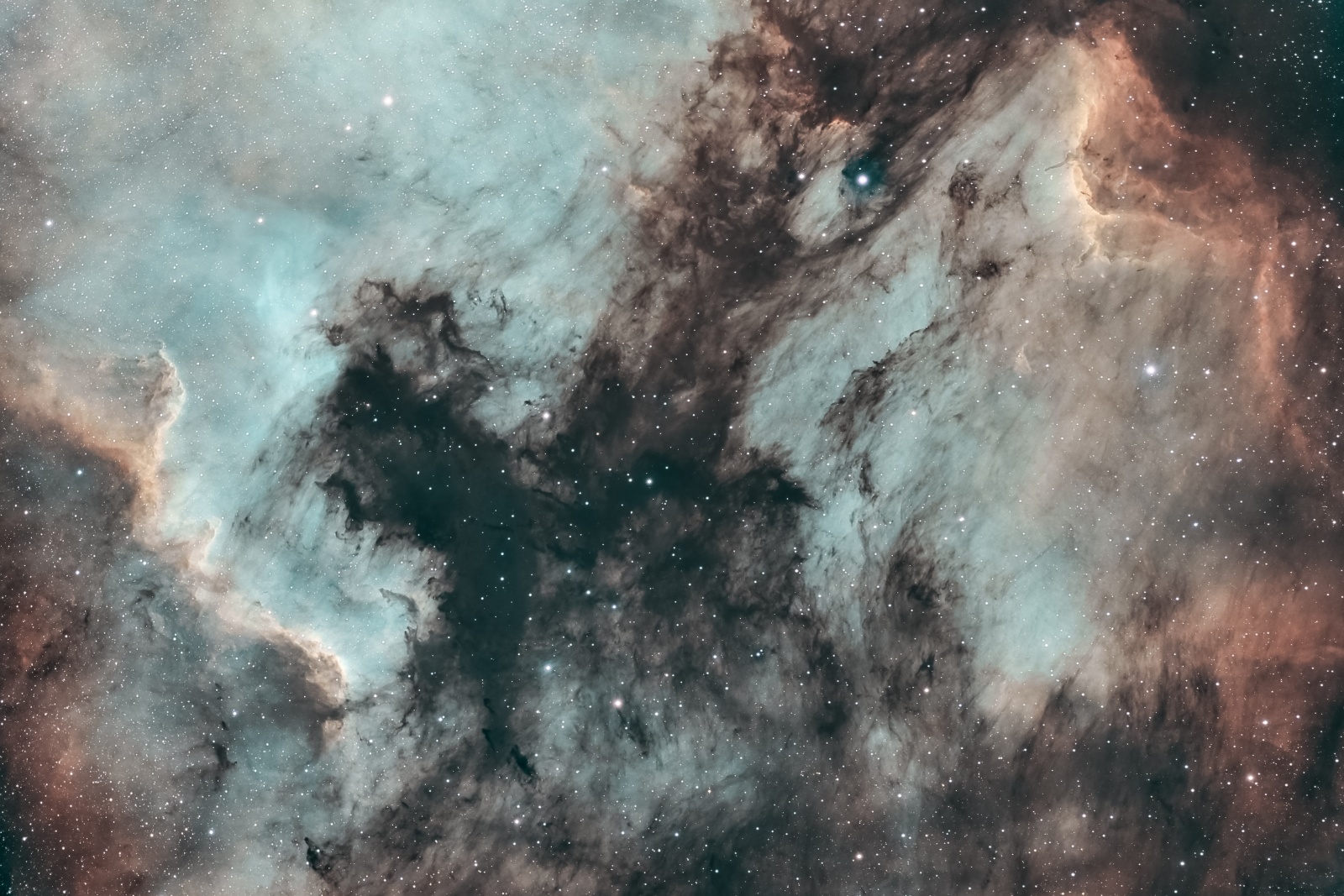

Rezultat: 3 x 8 minut z balkonu w Warszawie, M101, Ha, showcase kalibracji. rc10, 250/2000, 294mm, zwo Ha, eq6-r, oag

I. W skrócie:

1) sensor posiada dziwny wzór w tle, pierwszy raz taki widzę, przyczyny? w necie można przeczytać najróżniejsze hipotezy (czasem większe brednie, czasem mniejsze)

2) wzór ma pewne właściwości:

- pojawia się w bliskiej podczerwieni, dla narrowband nie ma go w paśmie tlenu, ale jest w widmie Ha i S2

- rożny w różnych kamerach, ale występuje zarówno w 294mm jak i 294mc, niezależnie od wersji chłodzonej, czy też grzanej

- w związku z tym wzór nie zależy od CFA (color filter array)

- wzór praktycznie NIE ZALEŻY od chłodnicy, sensor dla -15 stopni C, i dla +28 stopni dają bardzo podobny flat -- tak podobny, że "zimny" i "ciepły" kalibrują się sobą nawzajem do stałej o ok 32 DN szerokości (czyt. pixelmath: ciepły/zimny, unormowany, ma histogram o std_dev ok 32/2^16 poziomów)

3) moje hipotezy, sensor back illuminated, prawdopodobnie ta refleksyjna powierzchnia pod sensorem jest czymś pokryta lub zmieniona w produkcji, tak, że dotknięta wadą powierznia ma nieco mniejszą efektywność. ile? TYLE CO NIC. Na flacie bez ostrego strecza wzór widać "ledwo co". Ale oczywiście w wymagającej astrofotografii mógłby sprawić kłopoty.

4) zatem kalibracja w tym sensorze, tym bardziej, że wykazuje on "amp glow" jest obowiązkowa i musi być wykonana poprawnie. wszelkie złe próby kalibracji wynikające z "klikactwa" zostaną ukarane ;), czyli nie robimy żadnych meksyków typu "flaty bez lajtów", "lajty bez biasów, bo biasy niestabilne" i innych pierdół

kalibracja jest tylko jedna! THIS IS THE WAY.

II. To teraz w długości:

1) Sensory 294 wykazują amp glow, więc darków się nie uniknie, chyba, że fotografujemy plaże w słońcu. Na szczęście w chłodzonej astrokamerze nie ma z tym problemu. W nieco ciemniejszym pomieszczeniu można robić to cały dzień, czy całą pochmurna noc, jeśli tylko nie jest 40 stopni. Wtedy się nie uda. Kamerka ekstra schładza się do -15 i z moich badań wynika, że NIE MA sygnału termalnego praktycznie w ogóle. jak w ogóle? już mówię!1a) warto się upewnić, że światło nie wpada, jak to zrobić? zrobić jednego dark w "naprawdę dobrej ciemności", a później np. na stole w salonie i zobaczyć, czy średnie tło jest to samo. jeśli tak to jest ono po prostu offsetem a ciemność jest szczelna.

2) Co jest na darku? Ano właśnie, z założenia nie ma światłą z zewnątrz, wiec

DARK = CONSTANT + AMP_GLOW + TERMAL.

- constant: stała (zwana też offset, czy bias) zależy od... offsetu (ustawienie kamery), i jest ustalona tak, by read noise nie powodował fałszywego odczytu zerowych wartości. Jaki offset? Myk zrobić sobie zdjęcie ciemne < 1 s na ulubionym gainie (np. minimum HCG) i wybrać najniższy offset dla którego histogram nadal jest odklejony od zera (nawet o np 4 poziomy).

- termal: to scałkowany szum termiczny, który w związku z tym rośnie asymptotycznie jak pierwiastek z czasu, co to znaczy? 4 razy dłuższy dark miałby średnio 2 razy większy sygnał (łatwo to sprawdzić samemu, jak ktoś lubi, wrócę do tego)

- amp_glow to SYGNAŁ! tak, sygnał od elektroniki, w związku z tym rośnie LINIOWO, dwa razy dłużej oznacza, dwa razy wyższe wartości liniowych pikseli z amp glowem, to też sprawdźmy.

2b) test hipotezy "amp glow jest liniowy"

- podczas analiz wykonałem sporo darków w ciemnym miejscu z chłodzeniem, przygotowałem miedzy innymi:

a) dark 480 s uśredniony z ok 200 klatek (ehh

), -15 stopni

), -15 stopni

b) dark 120 s uśredniony z ok 200 klatek, -15 stopni

c) superbias, czyli właściwie stałą reprezentującą ustawiony offset (tak, tam niczego innego nie ma praktycznie), tez -15

- jeśli amp glow rośnie liniowo to na ośmiominutowym powinno być go około 4 razy więcej, jak około i jak to sprawdzić?

- DWIE_MINUTY = STAŁA + 1 * AMP_GLOW zaś OSIEM_MINUT= STAŁA + 4*AMP_GLOW

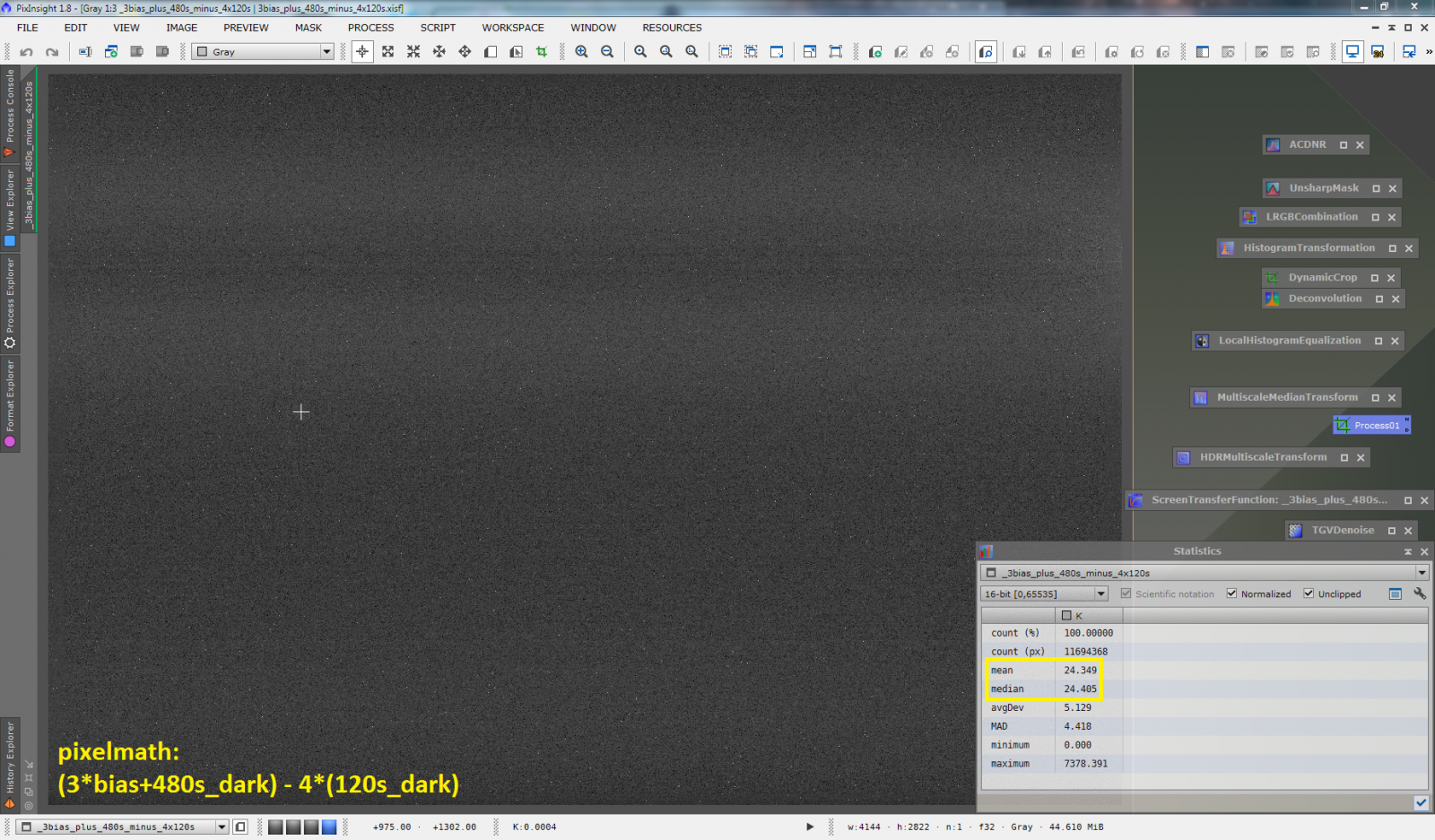

- użyjmy zatem jakiejkolwiek pikselmatematyki, i wynik piękny, poniżej (3*STAŁA + 480s_DARK) - 4*(120s_DARK)

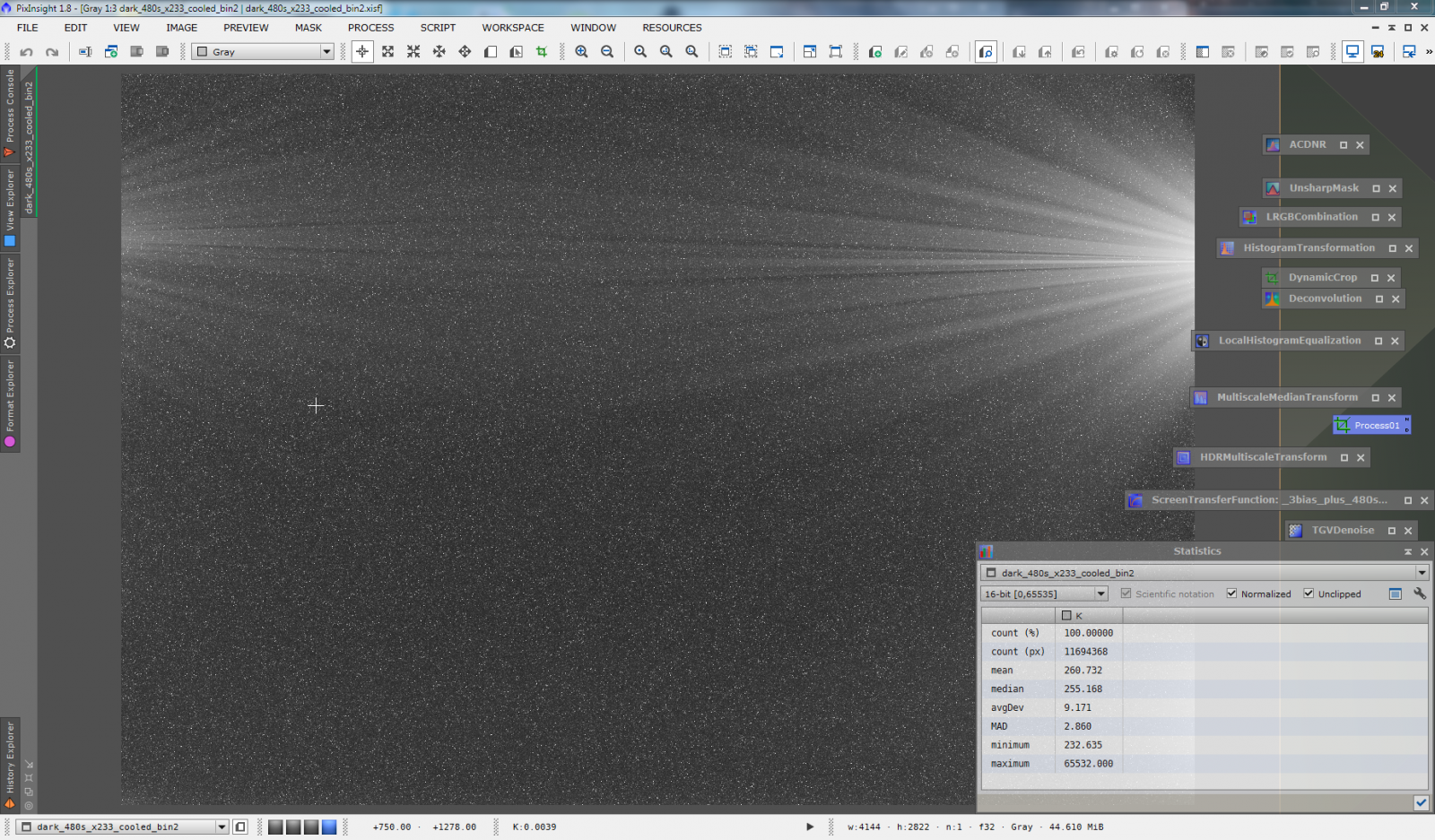

- jak widać na zrzucie, 24-25 poziomów na 16 bitów to statystyczne zero, które dostaliśmy, amp_glow wcześniej prominentny znika, dla kompletu, wrzucam zrzut z darkiem 480 s (z 233 plików)

^dark 8 minut, schłodzony, ze statystykami

widać, ze amp glow jest liniowy, co może w sytuacjach podbramkowych pozwolić np. na skalowanie darków (schlodzone wlasciwie nie mają termala, i trzeba zabrać stała, bo jej NIE WOLNO skalować)

2c) prototyp testu: szum termalny rośnie z pierwiastkiem z czasu:

- fizyka statystyczna nie kłamie

- przy okazji można sprawdzić, czy amp glow zależy od chłodnicy (raczej nie)

- "ciepłe" 480 s można skalibrować "zimnym" 480 s

- to co zostanie powinno być różnicą w amp glow (tego nie będzie raczej w ogóle) oraz czystym szumem termicznym (BEZ STAŁEJ)

- tak samo można sobie przygotować 120 s szumu termicznego

- ten 480 s będzie średnio 2x większy -> inspekcja statystyk da odpowiedź (różnica jest gorszym sposobem, czasem może być sporo zer, stąd np dobrze dodać na początku.. 1000

)

)

- przykładu nie będzie bo miało być o FLATACH a już dość spamuje

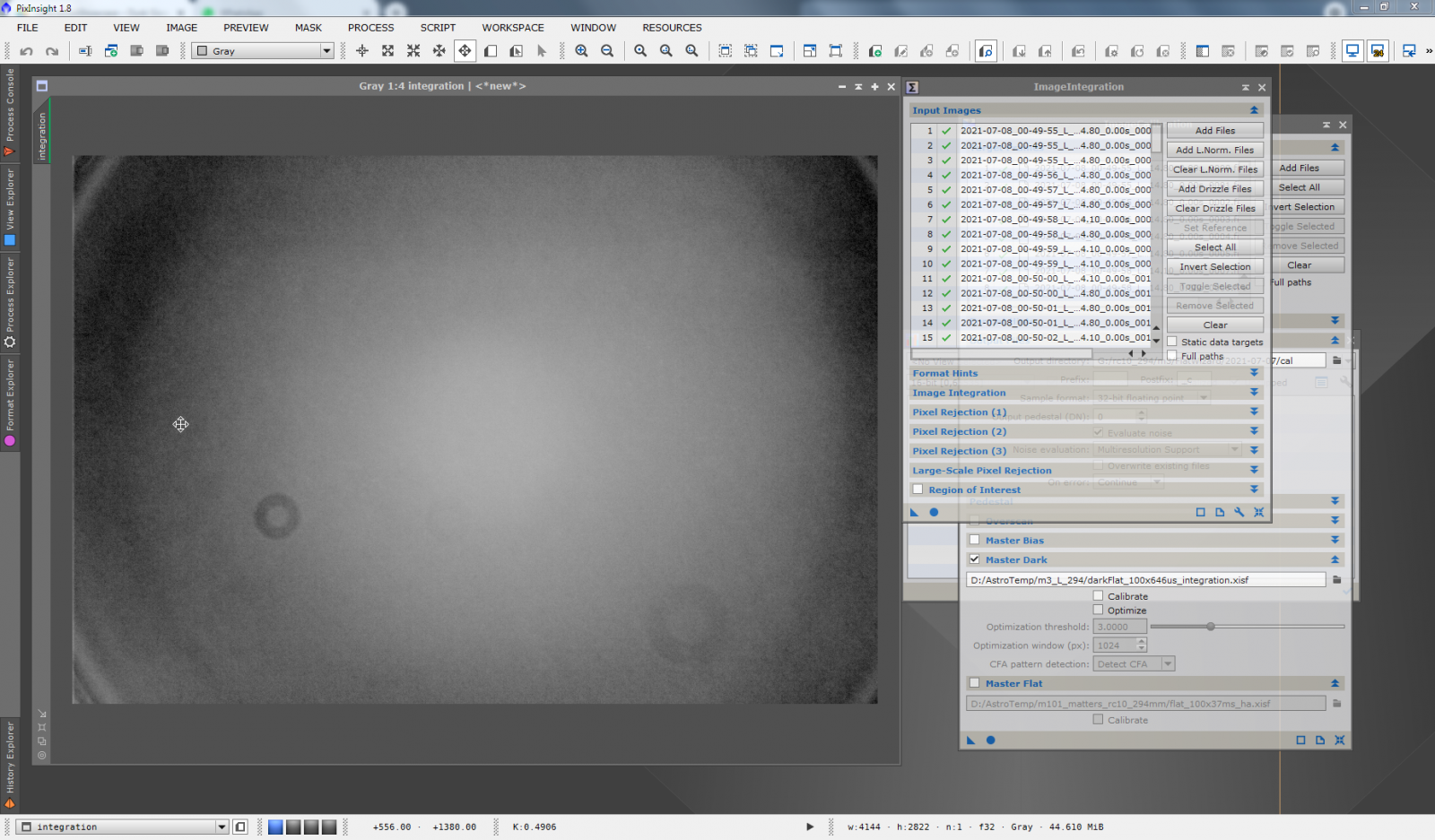

3) teraz powoli historyjka klatki, która byłą okładką tematu:

3a) nieskalibrowana zupełnie klatka 8 minut Ha, M101

Widać sporo dziwnych rzeczy, prawda.

3b) odejmuje darka, pozbywamy się w ten sposób sztucznej stałej, a także amp glowu

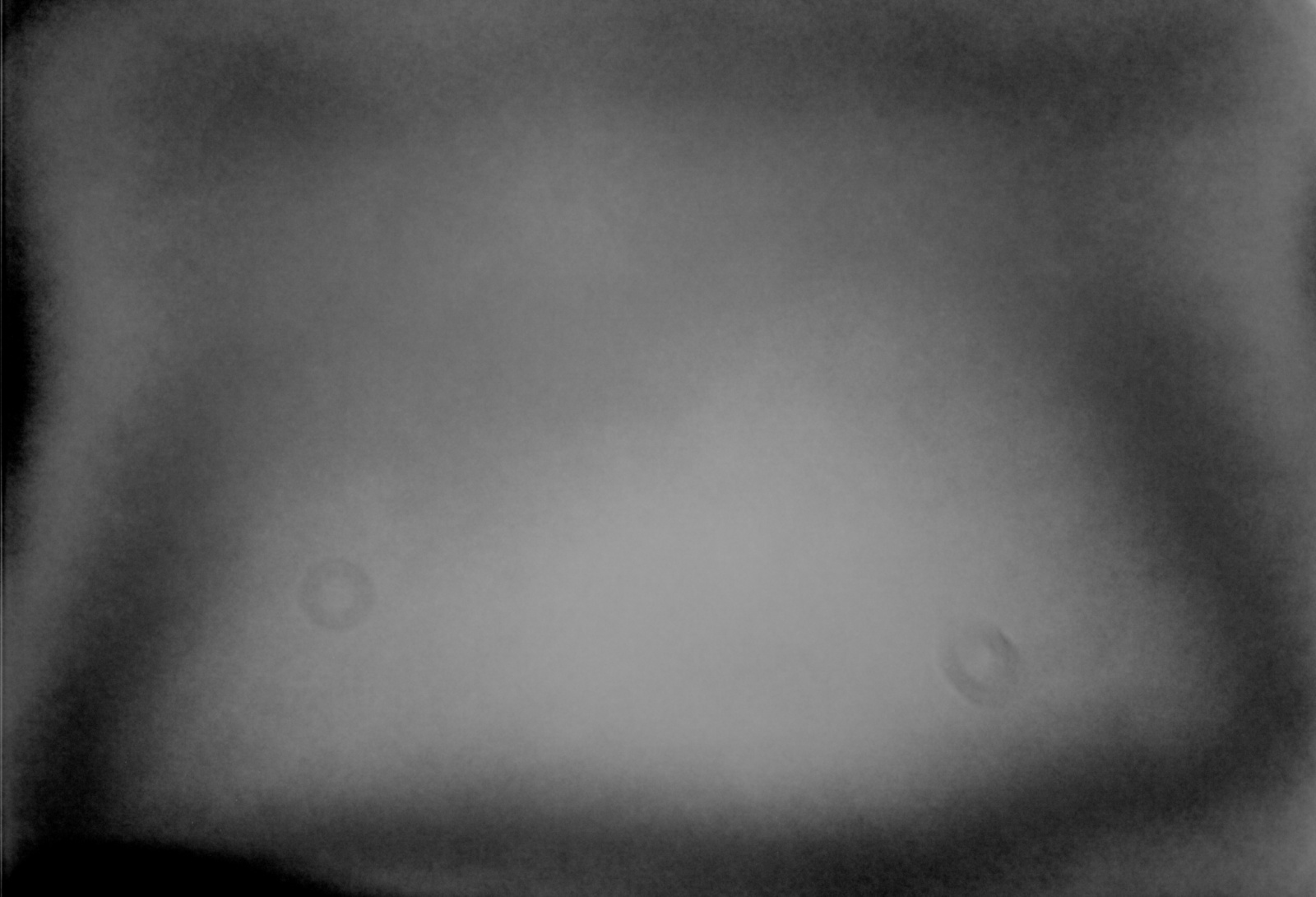

Już znacznie lepiej! Ale takie RTG płuc zostało... fatalne, prawda? Kiedy pierwszy raz użyłem swojego panelu LED do robienia flatów, to myślałem, że może ten panel się do tego nie nadaje (żart). To co widać "w kosmosie", a raczej indukowane przez miejskie tło Warszawskiego centrum, widać też na flacie! Poniżej flat po streczu

Zawsze z dwa ziarenka kurzu mi muszą zostać *angry*. TEGO WZORU NIE MA NP. DLA FILTRU O3!

3c) podzielmy to co zostało przez tego skalibrowanego (bez stałej) flata i pyk

czyste tytułowe zdjęcie!.

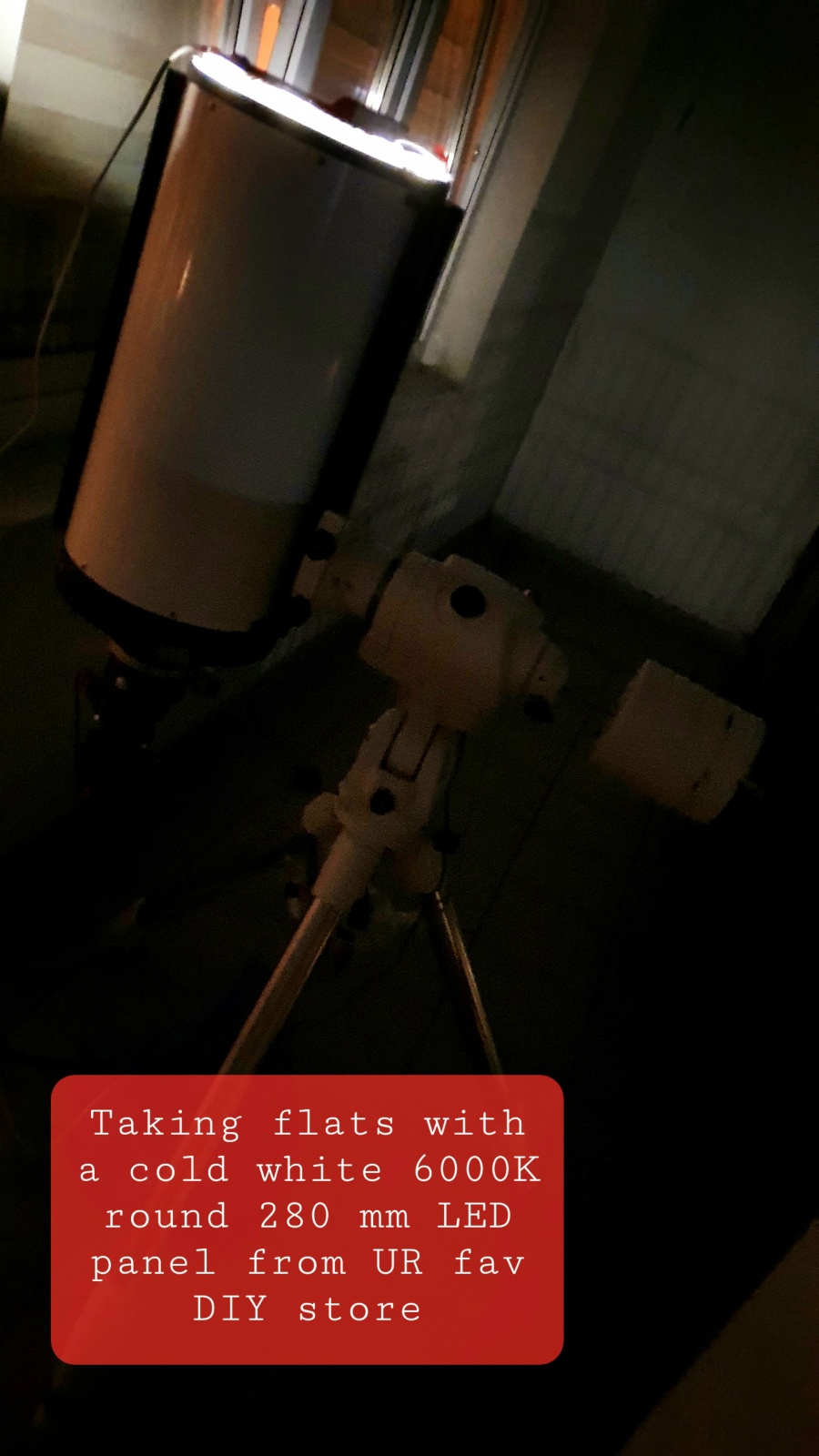

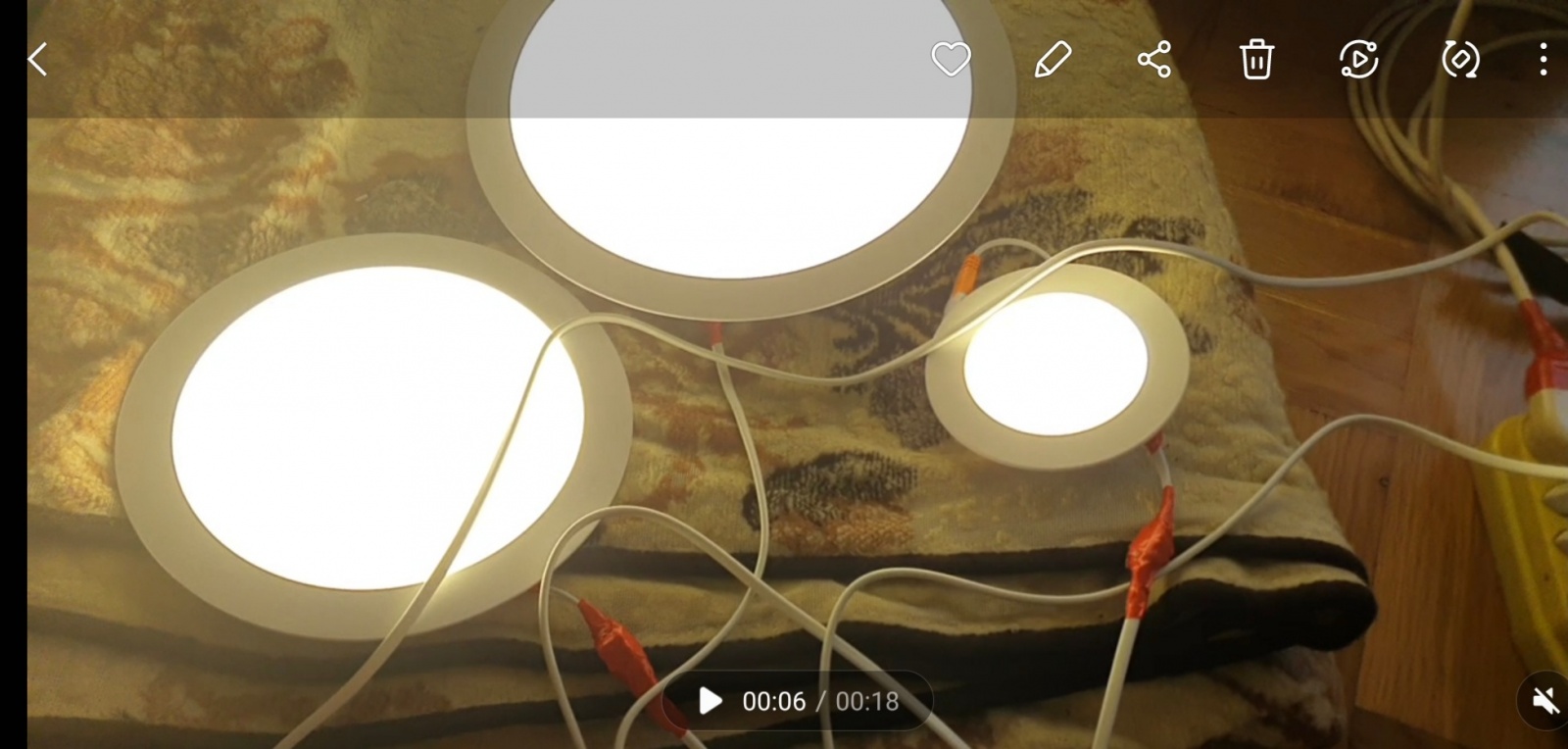

4) jak robię flaty? ja używam taniego kółka led do podwieszania, jest duże, zakrywa rc10 i wygląda to tak

robię z setkę na milisekundowych czasach, i w ogóle się nie martwię. później używam włącznika na kabelku, wyłączam i robię dark flaty. Skalibrowane suby flatów (flat minus darkFlat) kalibruje multiplikatywnie (bo już nie ma stałej) i całkuje z odrzucaniem.

Chyba działa... (może świeci lekko bardziej środkiem, ale to i tak zasłania obstrukcja, dzięki obstrukcjo)

III. Uwagi:

1) narrowband jest bardzo selektywny, stąd umożliwia pełną kalibrację; jeśli zjawiska zależą od widma i obserwujemy je łącznie, to może być niewielki problem, gdyż widmo naszej :"flatownicy" może być inne niż widmo tła

2) i tak np warto sie zastanowic nad lubianym kombo: L-extreme + 294mc. tutaj piksele czerowne (od Ha) będą dawać ten efekt, a piksele zielone i niebieskie NIE! W tlenie tego nie ma, w L tego nie widać, pojawia się dopiero przy czerwonych barwach

3) czy będzie kłopot? nie, gdyż kalibarcję flatem wykonuje się przed debajerowaniem i jest to operacja piksel-po-pikselu. polecam - zróbcie flat, i rozłóżcie na kanały np "CFA Splitem"

4) jak wygląda flat tym samym zestawem w "L", ano tak

5) podobnie jest właśnie np. w O.

6) gdyby, ktoś chciał fotografować w samej podczerwieni w szerokim paśmie, np 1000-600, to może miałby kłopot z separacją tego zjawiska, ale to bardzo absurdalne zastosowanie, pozostałe są OK. problemy wynikają z inepcji dzisiejszego homo sapiens sapiens.

7) zdjęcie SHO, które udało się zrobić tą matrycą (za karę dla tych, co doczytali do końca!):

PS. publikuję, i robię proof read

-

16

16

-

3

3

-

3

3

-

14 minut temu, Patryk Sokol napisał:

No to prawda.

Zasadniczo bym się zgodził, pytanie ile tego chromatyzmu wprowadza.

Mam wrażenie, że więcej robi mi refrakcja atmosferyczna.

No to akurat prawda, RCek ostrzy na zakrzywioną powierzchnię, a nie na płaszczyznę.

Niemniej - przy RC6" i APS-C to nawet ostrząc na środkowe 1/3 obrazu (czyli 1/3 od środka gwiazdy są nie brane pod uwagę, później 1/3 jest brana pod uwagę, a ostatnia 1/3 jest znów pomijana), to jednak ostrość wychodzi jednak nędzawa.

No to akurat prawda.

Ogólnie lubię zabawy z RC, bo ma bardzo dużo porządnie opisanej teorii w internecie. Dla porównania, to procedury kolimacji lustra wtórnego na gwiazdach Newtonem to znaleźć po prostu nie mogę (wszyscy tylko o głównym).

Niemniej - ja jestem bardzo zadowolony z zastosowania flattenera, jednak równe pole mi bardziej pasuje niż te wady które ze sobą wnosi

tak

tak

tak

-

1 minutę temu, Patryk Sokol napisał:

Taka ciekawostka - korzystam z RC 6" i matrycy APS-C .

Z pomocą takiego flattenerka:

https://teleskopy.pl/Flattener-korektor-płaskości-pola-do-jasnych-refraktorów-(Orion--08893)-teleskopy-4383.htmlMam całe pole nie zniekształcone, a to mały teleskop jest.

Kupiłem go do Evostara 72, włożylem raz do RC 6" i już tam został

jasne. dedykowane tez istnieją, do tego to fajna zabawa projektować/dobierać korektor do erceków

tracisz jednak jedną potężna własność -- zerową aberracje chromatyczną, której nie ma dla prawa odbicia, gdyż dlań współczynnik refrakcji wynosi -1...

dobry korektor byłby albo jedynie do narrowband, albo musiałby być apochromatyczny + korekcja

ponadto w ercekach nie ma zniekształconego pola -- przesuwajac ostrosc do przodu możesz wyostrzyć rogi obrazu i odwrotnie, do tyłu, środek. u mnie w rc10 na full frame ta różnica (środek/róg) to ohydne 0.8 mm!! wybieram balans gdzieś pomiedzy zaleznie od tego jakie pole chce uzyskać.

komy nie ma w szerokim zakresie, aberracja sferyczna nie jest zerowa, ale znikoma (nie ma idealnego ogniska w środku)

spory jest astygmatyzm, gwiazdy w rogach odwracaja sie o 90° przy przyjsciu na drugą strone ostrosci

ercek ma tę zaletę, że to "teoretyczny" teleskop. wszystko w nim wiadomo pod warunkiem, ze dobrze zrobiony

-

3 godziny temu, simarik napisał:

Przepraszam za off'a, ale @Przemek Majewski - musze dopytać.

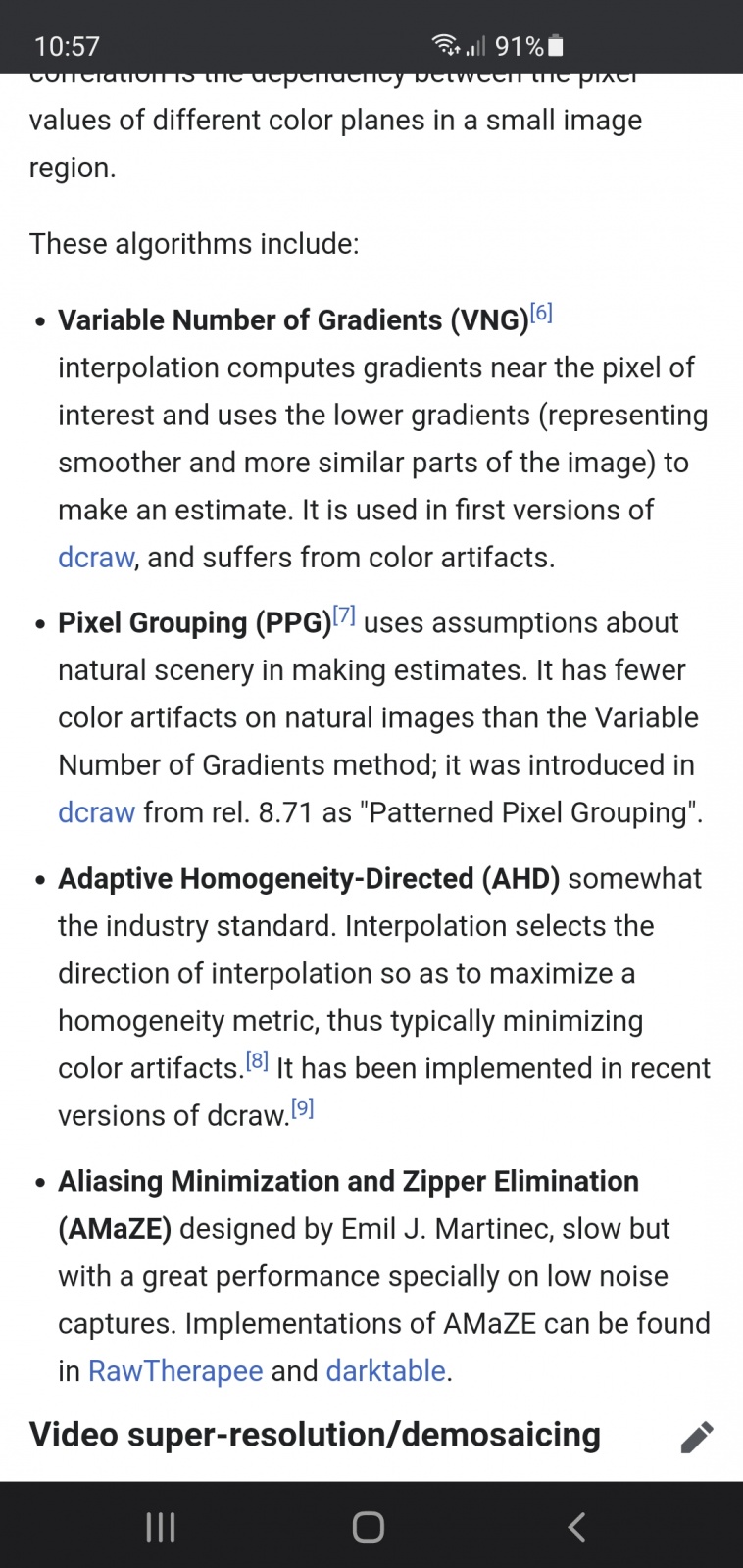

Ad 2d. Mając OSC - najlepiej jako metodę debayeryzacji wybrać "superpixel"? Do tej pory używałem bodajże VNG. Rozumiem, że po superpixel będę miał obraz wynikowy o połowę mniejszy (bin2)?

Ad. 2f. Mógłbyś podać jaki to panel - akurat szukam czegoś odpowiedniego do flatów.Nie nie. Polecam VNG/Bilinear do astro. Różnice subtelne.

1) jeśli zamierzamy poźniej robić CFA drizzle x1 to Bilinear, taniej. Inaczej VNG

2) w fotografii dziennej króluje AHD.

Tutaj BARDZO WAŻNE jest, że superpixel zmniejsza skalę. W wypadku, kiedy masz skalę piksela rzędu 0.5" to nie ma co mqrzyc o takim detalu i te piksele sie "marnują". Męczą Ciebie etc. W takiej sytuacji superpixel robi dwie rzeczy

- zmiejsza rozdzielczosc 2x (jak bin2)

- debayeruje bez interpolacji odtwarzajac jeden trojkanalowy piksel z czwórki RGGB.

Moja odpowiedź była ściśle skorelowana z tym, że autor narzekal na oversampling.

czyli "jeśli osc jest oversampled użyj debayer superpixel"

w wypadku mono także "bin" lepiej robic w postrocessingu, ale jest to oczywiście juz zwykle usrednianie sąsiednich pikselków. i offtop.

EDIT: Aha, panel. wpisz w google panel led, wybierz średnicę i temperature 6000K, kosztują rzędu 20-30 pln. nie ma co sie wahac ani rozwodzic. kup taki co masz najblizej i potestuj.

EDIT2: to naprawde takie proste panele

-

1

1

-

1

1

-

-

- Ta odpowiedź cieszy się zainteresowaniem.

- Ta odpowiedź cieszy się zainteresowaniem.

Pawle, super że sie za to wziałeś! świetne zdjęcie misternego obiektu!

Mam parę uwag:

1) chyba musimy się spotkać

2) zdecydowanie bin1 i tylko bin1. 26 mpix nie zabija dzisiejszych kompow a bin w poście możesz zrobić (zaraz wyjasnie)

2a) po pierwsze, kalibracja bylaby niewygodna. kalibracja w bin 1 tylko, po co miec rozne mastery

2b) tu w 2600 to tylko superbias(albo stala/piedestał) i flat, sensor super. zero amp glow. schlodzony praktycznie nie generuje cieplnego sygnału

2c) bin2 w tej kamerze to jest jakby bin 4! zobacz jak daleko sa od soebie czerwone piksele! bin 2 w wypadku OSC nie grupuje klatki 2x2 jak w mono. tylko 2x2 klatek RGGB

2d) a propos kamer osc: ogarnij "debayer superpixel", to metoda prosta jak sra%^&. robi z kwadratu RGGB jeden piksel trójkolorowy (R, (G1+G2)/2, B ); jednocześnie sensownie binujać 2x2

2e) zatem:

- akwizycja bin1

- kalibracja bin1 (light - offset)/masterFlat (unormowane), a masterFlat jako (flaty-offset)

- pierwszy krok po kalibracji: debayer

'superpixel'

- od razu masz skalibrowane, czyste, 2x mniejsze zdebajerowane bez interpolacji zdjecia

- Twój sposób, stosowany oczywiście w sieci w tysiącach świadczy o malym zainteresowaniu środowiska algorytmami pod spodem, spróbuj, bedzie wygodniej i lepiej (brzmi jak hucpa wiem)

2f) flaty robie takim fajnym okragłym flat panelem ze sklepu z oswietleniem i jestem oczarowany rezultatami! trwa to doslownie minutkę po komendzie "slew to zenith" (pożycze, albo pokażę w akcji)

3) kolimacja moze być jeszcze znacznie znacznie korzystniejsza (EDIT: możemy razem zrobić

). co do pola, rc10 miałby pelne pole na aps-c, rc8 bedzie miał troche ubytków, krzywizna pola uniemożliwi jednoczesne wysotrzenie gwiazd w calym polu, w wolnej chwili uruchomie moje kody z MATLAB-a i przesymuluje jakie pole bedzie w teoretycznym RC8

). co do pola, rc10 miałby pelne pole na aps-c, rc8 bedzie miał troche ubytków, krzywizna pola uniemożliwi jednoczesne wysotrzenie gwiazd w calym polu, w wolnej chwili uruchomie moje kody z MATLAB-a i przesymuluje jakie pole bedzie w teoretycznym RC8

No a gromady kuliste moje ukochane, a przez prace, chmury, lato i inne ja znowu żadnej porzadnej fotki gromadzie nie cyknąłem

No, a gdzie mnie znaleźć to wiesz

Dla uatrakcyjnienia mały test w skali 0.5" na piksel z balkonu bez Polaris

294mm, pełna kalibracja, rc10, 45 x 120 sekund w stronę warszawskiego centrum

0.5" na piksel. eq6r.

-

12

12

-

2

2

-

1

1

-

4 godziny temu, Behlur_Olderys napisał:

1) Ty piszesz, ja liczę.

Twoje można przeczytać i uwierzyć albo nie, a moje można sprawdzić i albo się zgadza, albo nie.

2) Nie, nie jest lepsza, o ile zbierasz odpowiednio wiele klatek.

1) Gratuluję. Ja piszę, ze trzeba pomnozyc efektywność przez czas i szerokość pasma, a ty liczysz.

Ja bym się nie podjął. czapki z głów.

2) Prawda. Najlepiej tyle samo czasu co kamerą mono.

Subpixel debayer.

Subpixel debayer.

Ad 2) W innym temacie, dipskaj, jest CFA drizzle, który ma zrobić z wielu zmozaikowanych zdjec jednego kolorowego stacka. Bardzo użyteczna opcja która robi mono-reassembly bez debayerowania. Daje troche wiecej w zielonym kanale a w astro wolelibysmy chyba więcej czerwonego i niebieskiego. I ten brak kontroli jest qg mnie głównym zarzutem. Wielu użytkowników używa osc z l-extreme, gdzie żyją praktycznie tylko 2 piksele. Ale możesz mnie przekonywać, ze kolorowe rysunki sa lepsze, od identycznej idei przekazanej jednym zdaniem

Addendum: Nadal wspolnym mianownikiem jest ten sam strumien przez tę samą aperture w tym samym czasie.

To moze ja się czegoś nauczę:

Pytanie, ten sam czas przez tę sama aperturę i teoretyczne sensory, co lepiej OSC czy Mono x 3?

Oczywiscie w OSC nie można np "dopalić wiecej blue", bo trzeba wszystko razem. Wiec jasne, ze OSC jest niewygodny w tej materii, ale takie teoretyczne pytanie. Przynajmniej dla mnie. Ciekawi mnie jaką przewagę w dyskusji dadzą te dwa zielone piksele. Prosiłbym uwzględnic efektywność kwantową w funkcji długosci fali, a także widmo emisyjne mgławic tzw "wodorówek" i jak ono wpływa na efektywność tych zielonych pikseli. Żeby można było coś... obliczyć i sprawdzić

Ponieważ sam nie ogarniam, ucieszyłyby mnie jakieś rachunki

Ponieważ sam nie ogarniam, ucieszyłyby mnie jakieś rachunki

-

3 godziny temu, Krzysztof z Bagien napisał:

A przeczytaj tytuł wątku.

Co do reszty - zmień ton wypowiedzi, to może pogadamy. Nawet jak uważasz, że masz rację, to nie musisz się zachowywać jak pretensjonalny dupek, któremu się wydaje, że pozjadał wszystkie rozumy. Bez odbioru.

dziękuję za pozytywną opinię

(wolę to... niż bredzić)

(wolę to... niż bredzić)

-

10 minut temu, Marcin_G napisał:

stąd seria pytań na forum. Problem w tym, że nie rozumiem udzielanych mi odpowiedzi....

A to powoduję, że stoję w miejscu.

Hmm.

Debajer 1-0-1

Kamera kolorowa ma 4 piksele z roznymi filtrami ułożonymi w kwadrat, przykladowo

R G

G B.

Najprostsza metoda "superpixel" dzieli rozdzielczosc na pol, a te kwadraty na 3 kanaly, o tak:

RG

GB -> (R, (G1+G2)/2, B )

już tu mozna zobaczyc, czy wynik taki jak trzeba.

Ponieważ siatka pikseli G whglada tak,

G*G*G

*G*G*

G*G*G

a kolor G jest "najjasniejszy" to z niej odzyskujesz jakby detal mono.(zwykle zielony kanal jest najlepszy w fotkach OSC).

W jednym wierszu dziury zastępujesz tylko czerwonym, w nastepnym tylko niebieskim.

TEN PATTERN MUSISZ ZNAĆ. I podac go swojemu programu. Koniec

Widać, że jak mu zle podasz gdzie sa G, to bedzie dużo gorzej niż tylko "zmiana koloru".

Widać, że jak mu zle podasz gdzie sa G, to bedzie dużo gorzej niż tylko "zmiana koloru".

Teoria odzyskania nieco lepszej rozdzielczosci niż takiego "dwupiksela o 1/3 efektywnosci" jest calkiem zacna, gdyż to mainstreamowy temat w miliardach aparatów.

-

3 minuty temu, Marcin_G napisał:

Nie, to ja przepraszam za siebie - od zawsze jestem debilem w sprawach komputerów i wszystkiego, co cyfrowe. Moja znajomość tych zagadnień w skali od 0 do 10 to jakieś "-1,5"

ej. to nie przepraszaj. warto poznac

-

43 minuty temu, Behlur_Olderys napisał:

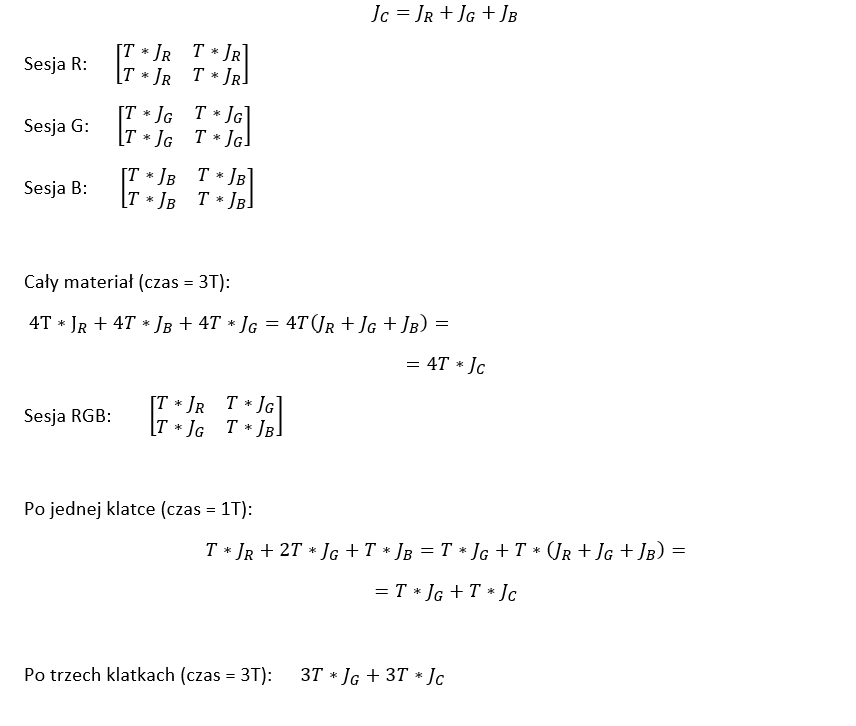

Niech T to czas naświetlania jednej klatki, a J to strumień światła od obiektu. Wyobraźmy sobie podstawową komórkę matrycy jako obszar 2x2 piksele. Wtedy akwizycję można zapisać tak, jak poniżej:

Jak pokazują obliczenia, kamera mono zbierze w tym samym czasie 33% więcej materiału (albo kamera kolorowa będzie miała 25% mniej materiału), przy czym wynika to tylko z tego, że kamera kolorowa będzie miała nadmiar zieleni. Zasadniczo więc, gdyby nie interesował nas konkretny kolor ale ogólnie ilość zebranego światła, to z dużym przybliżeniem można powiedzieć, że będzie to tyle samo.

Założenie jakie poczyniłem, to że robimy setki zdjęć, więc nie ma się co przejmować próbkowaniem kolorów, tj. zakładam, że szczegóły jakiegoś obiektu trafiają na piksele R G czy B z równym prawdopodobieństwem. Założenie to mogło by być nieprawdziwe w przypadku teleskopu Hubbla, którego nie obowiązuje seeing, ale na Ziemi raczej jest to oczywiste.

Dodatkowe założenie to że w zasadzie nie ma wielkiego znaczenia czy mówimy o pixelu mono przykrytym zewnętrznym filtrem R, czy pikselu kolorowym z maską R.

Pozdrawiam

PS warto zwrócić uwagę, że zakładam tą samą rozdzielczość. Operacja zmiany rozdzielczości (rozumianej jako bezstratną zmianę ilości pikseli w obrazie) przez interpolację pociąga za sobą zmianę SNR:

4x mniejsza rozdzielczość to 2x większy SNR i na odwrót: 4x większa rozdzielczość to 2x mniejszy SNR.

I chyba to tłumaczy nieporozumienie, bo w tym świetle zarówno @Krzysztof z Bagien jak i @Przemek Majewski macie rację

1) mniej czytalenie sie chyba nie dalo xD

przeciez dokladnie to samo napisalem:

4 RGB vs RGB+G -- bez filtra

a 4 G vs 2 G

i 4 B vs 1 B z filtrani ale przy tym samym czasie. Wiec nie wiem co ten material uzupelnia. Ale dzięki za powtorzenie mojego rozumowania z wyjsciowego komentarza.

W skrocie: Kamera mono zbiera 3 razy szybciej ale potrzeba 3 sesje. I wychodzi prawie "na zero". Rozdzielczosc mono za to lepsza.

Inaczej: Godzina z jednej apertury z tym samym polem widzenia to to samo. Niezależnie, czy sprobkowane OSC, czy też 3 razy po 20 minut.

Zwykle jednak wersja mono i wrsja mc maja pod spodem ten sam piksel. a komórka rozdzielczosciowa jednak jest inna. O tym się tez wiecznie zapomina, ze luminancje tworzą tak naprawdę glownie te dwa piksele G.

Najbardziej ciekawi mnie "subpikselowe debajerowanie przez autostakkert". Bo to niezłe kuriozum. Próbuję sie domyślać, ale niezła zagadka

-

Godzinę temu, Marcin_G napisał:

Na szczęście NIC z tego, co napisałeś / zalinkowałeś, nie rozumiem.

A tak po polsku: co mam zrobić?

przepraszam za siebie. to powszechne tu na tym forum. debajerowanie to magia.

sprawdzić jaki pattern ma Twoja kamera! i taki wybrać w opcjach debajerowania.

Typowo jest to RGGB. Ale widac, ze jak np odwrocic/odbic sensor to sie moze zmienic na BGGR, GBRG i wszystkie inne mozliwe. To trzeba sprawdzic w "instrukcji" do Twojej kamery. Jesli masz POPRAWNY pattern, to już tylko suwaczkami od balansu bieli az kolor będzie "ladny".

Aha, to mozesz sobie tez sprawdzić po domowemu - sfotografuj np czerwona kartkę. Te piksele, ktore bedą na niej najjasniejsze to czerwone. Te bardzo ciemne -- niebieskie. Tylko oczywiscie podglad surowy potrzebny bez debayerowania. Ewentualnie wynik demozaikowania musi wyjsc... czerwony w przyblizeniu.

-

19 godzin temu, Krzysztof z Bagien napisał:

Kamera RGB zbierze w tym samym czasie trzykrotnie więcej materiału, który na surowo faktycznie ma mniejszą rozdzielczość, ale po pierwsze jest go, jak wspomniałem, trzy razy więcej* (więc łatwiej wybrać naprawdę dobre dane)

Nie. Nie zbierze w tym samym czasie 3 razy wiecej. Zbierze tyle samo, albo nieznacznie wiecej z powodu kanalu G. Czego nie zrozumiałes w mojej "szkolnej matematyce" ze powtarzasz brednie ze stron sprzedawców. Te opisy to automaty piszą.

Więc jeszcze raz:

1) Mono + filtr G: 4 zielone piksele

2) OSC: 2 zielone piksele

^ tu dwa razy mniej

W R i B tylko 1/4 pikseli odpowiada.

Z filtrem L kamera mono zbiera 3 x szybciej. Z filtrami R B tak samo jak JEDEN piksel z czterech kamery OSC w tym czasie.

"Kamera RGB zbierze trzy razy tyle"...

Borze zielony, wolno pisać takie brednie?

EDIT 1: Poproszę źrodlo paranaukowe bo się chce douczyć w tym temacie w takim razie

-

19 godzin temu, Krzysztof z Bagien napisał:

1)

Generalnie nowsze sensory mają wyższą sprawność kwantową niż starsze, więc bez porównania tego parametru trudno tak naprawdę robić jakieś wyliczenia. Ale akurat przy nagraniach planetarnych to na brak światła raczej nie narzekamy i każdy kanał można spokojnie nawet przepalić jak ktoś chce, więc czułość (czyli w efekcie ilość zebranych fotonów) nie jest tu problemem.

2)

a po drugie AutoStakkert potrafi to zdebayeryzować z subpikselową dokładnością podczas stackowania, więc przynajmniej część informacji, która normalnie byłaby utracona i interpolowana

Ad 1) Chyba jasne, że w tej dyskusji mowię o dwoch wyimaginowanych sensorach O TEJ SAMEJ EFEKTYWNOŚCI. Może faktycznie dyskutant ma mnie za imbecyla, ale nie porowniuje matrycy mono z QE 80% ze starą matrycą z QE 10%. Bo chyba nie o to pytał autor!

Ad1 jeszcze) co z tego ze nie narzekamy na swiatlo w foto planet? 3 x szybciej to 3 x szybciej. I właśnie o to chodzi pytajacemu by zdazyc przed rotacją. Ponadto nie chodzi o czas jednej klatki, tylko o to, że tę samą liczbe fotonow co w OSC w minutę mozna zebrac w 15 sekund w L mono. To chyba dość proste powinno być do zrozumienia

Ad 2)

"zdebajerować z subpikselową dokładnością" no to niezła bajerka jest. szkoda że troche bełkot. na ścianę sobie powieszę, bo to niejako odkrycie. jak one się tam wgryzaja subpiksel mając 4 probki o odtwarzajac wiecej niz 12...

POPROSZĘ ŹRÓDŁO DO TEJ RADOSNEJ TWÓRCZOŚCI PARANAUKOWEJ. Tam może też będzie można coś skorygować.

-

W dniu 28.06.2021 o 10:43, Marcin_G napisał:

Wątek suwaczkowy jest dla mnie jasny.

A właśnie myślałem czy to nie jest kwesta tego, że pikseli zielonych jest dwa razy więcej niż czerwonych lub niebieskich

Pikseli zielonych jest dwa razy wiecej, gdyż służą one także do określania zmian luminancji, które sa znacznie wyższej częstości, a R i B do określania koloru. Ja to po%$biesz, tzn ktore są które, to dopiero wtedy dostajesz "za zielone".

Reszta to zwykle white balance.

Reszta to zwykle white balance.

Metoda interpolacji (powiedzmy poza biliniową i superpixel), która sluzy do rozwiniecia czwórki RGGB na 2x2 RGB (12 z czterech), jest dość skomplikowana i nieliniowa. Inny status mają w niej sprobkowane "co drugi" zielone piksele a inny te R i B. Wlaśxiwie mowa o kanałach R-G oraz G'-B traktowanych wierszowo/kolumnowo.

tu lista kilku sposobow za wikipedią. kiedyś kodowałem w jakimś moim projekcie edukacyjnym AHD i muszę powiedzieć, że to niezłe cacko ludzkiego umyslu.

-

1

1

-

-

22 godziny temu, Marcin_G napisał:

Typowo dużo zieleni może oznaczać zly CFA pattern, tego sie nie naprawi suwakiem. Moze zamiast RGGB masz np GRBG. Warto się upewnić jaki ma Twoja kamera. Możesz też załadować surowe do Autostakkerta i w color spaces poklikać opcje az stwierdzisz, ze kolor poprawny.

Dlaczego to nie suwaczkowy? Piksele G maja inny status w debajeryzacji i nie można ich tak sobie pomylić z R oraz B. Mówiąc w dużym uproszczeniu G niosą luminancję i detal, zaś R i B chromę, U/V, kolor.

W wypadku złego balansu barw (prosty suwaczkowy problem)

działają barwowe prawidla

- za mało czerwonego -> cyjan

- za mało zielonego -> magenta

- za mało niebieskiego -> żólty.

Oczywiście za dużo podstawowej barwy daje rzecz jasna tę barwę.

-

1

1

-

-

9 godzin temu, Misza napisał:

Czy ktoś miał już do czynienia ze stosunkowo nowa asi462 ? Zastanawiam się jak ta kamera wypadłaby na planetach w porównaniu z np monochromatyczną 178mm. Tą druga posiadam i używam od roku, jestem z niej w zasadzie zadowolony ale na szybko rotujących planetach jest problem przy zbieraniu materiału dla kolejno IR R G B (przesunięcie) dlatego zastanawiam się czy taka kolorowa, nowsza jakby nie było, konstrukcja nie stanowiłaby sensownej alternatywy?

Czy naprawdę zbiera się wolniej? Fakt derotacja jest dyskusyjna, bo to jednak mocna obróbka cyfrowa prawie jak nakładanie tekstury... ale można ją robić. Jednak, że wolniej to się nie zgodzę. Można robić "łatwiej" OSC, ale nic nie zastąpi detalu niepokrytego CFA sensorem.

To tego znowu troche podstawówkowej matmy, zeby nie bylo za trudno.

a) 4 piksele kamery czulej na całe pasmo = 4*RGB + 4*IR

b) 4 piksele "zwykłej" kamery OSC = RGB + G

c) 4 piksele kamery 462mc (unikatowa czułość w IR) = RGB + G + 4*IR

Widać, że sensor mono nawet z UV/IR cut jest czulszy 4RGB/(RGB+G) razy. Jeśli kanały mają równą intensywnosc (co zwykle nie jest prawdą) to mamy 4*3/4 = 3 razy więcej zebranego swiatla. Czyli dokladnie tyle samo...

Jak mówił klasyk... życia nie oszukasz.

Widać, że tak naprawdę fotony zbiera się "tak samo szybko" z powodu braku ograniczeń na transmisji przez filtry. Czy zalożymy "własne" LRGB czy bayerowski CFA... intensywnosciowo są niewielkie różnice.

Uniwersalność kamery mono do "naukowych" astrozastosowań, UV, IR, CH4, 540 nm, LRGB jest nie do przecenienia. Poza tym warto zadać sobie pytanie... czy to jest produkcja zdjęć one click szot (ma byc łatwo, ale mam hobby! ale mam!) czy hobby które Was fascynuje (robie to, bo mnie ciekawi swiat)?

Ja na pewno będę próbował składać planety w tym sezonie z różnych pasm. A 462mc też mam.

Ostayecznie, wydaje sie, ze posiadac 178mm (tez mam) oraz 462mc to nie jest overkill przy tym hobby...

-

1

1

-

Tło i jego kalibracja w sensorach asi294mc/mm

w Testy i Recenzje

Opublikowano · Edytowane przez Przemek Majewski

Tak, poza zaspamowaniem wspólnie trochę tego wątku, to jeszcze w swojej mądrości trafiłeś w moje największe lęki osamotnienia

No i naprawdę dzięki, że myślisz, że jest za%$biste