-

Postów

684 -

Dołączył

-

Ostatnia wizyta

-

Wygrane w rankingu

2

Typ zawartości

Profile

Forum

Blogi

Wydarzenia

Galeria

Pliki

Sklep

Articles

Market

Community Map

Odpowiedzi opublikowane przez Przemek Majewski

-

-

13 minut temu, Flaytec1 napisał:

Musze to sprawdzic samemu majac dwa teleskopy obok siebie F5 i F10 i przekładac kontowke z roznymi okularami inaczej ciezko mi sobie wyobrazić roznice. Dziekuje za wyjaśnienia.

powiększenie + apertura + kontrast nieba

do obserwacji mgławic polecam powiększenia minimalne. lub niskie. bonusem jest, że czasem nie warto mieć wtedy okularu o "szerokim kącie" widzenia, bo brzegi pola widzenia mogą już miec niską jakość korekcji.

ps. co uznać za "element porównawczy". kolor nieba/tla. jak do oczu przylozyc lornetkę 7x50 i 10x50 to błękit pociemnieje

-

Teraz, Flaytec1 napisał:

ok to rozumiem tylko mglawice widać w odpowiednim powiekszeniu zaleznie od jej wielkosci i jasności.

nie powiększeniu. tylko wielkosci! wielkosci = srednicy apertury. powiekszenie minimalne do mglawic jak znalazł. sa duze.

prosty wzór na powiększenie minimalne

ogniskowa okularu = 6-7 mm x światłosila.

Np. dla f/5 okular 32 mm.

Teraz, Flaytec1 napisał:Np w moim 102/500 F5 przy pow 35x hantle dobrze juz widać chociaż sa male. Jak teraz wezmiemy tube 90/900 F10 i włozymy taki okular by uzyskac takie samo powiekszenie 35x to jaki bedzie obraz tych Hantli-ciemniejszy ???

ciemniejszy razy (90/102)^2. Tyle razy ile mniejszy przekrój apertury.

-

1 minutę temu, Marcin_G napisał:

I klarowność + stabilność atmosfery.

Nie bardzo ma to związek z optyką (chyba że komuś sie adaptuje xD), ale zgoda. Gdyby "poradnik" miał byc kompletny to tak.

-

Podstawową różnicą między foto a wizualem jest możliwość długoczasowej integracji. Poza tym róznic nie ma (no może jeszcze pasmo)

Oko bardzo czułe, ale podobno integruje ok 100 ms (może ktos ma lepsze info na ten temat? ja to pewnie "gdzies przeczytalem" i nie uwazam za jakas super pewną informacje)

-

2 minuty temu, Flaytec1 napisał:

Co to znaczy sensor? Chodzi mi o obserwacje wizualne, nie astrofoto.

W obserwacji wizulanej to samo. f/4 i okular 20 mm to to samo co f/8 i okular 40 mm. (przy tej samej aperturze)

Liczą się tylko apertura i powiększenie.

A poza tym konstrukcja optyczna i jakość okularu.

-

Teraz, Flaytec1 napisał:

Obecnie mam wszystkie teleskopy F5. Nie mam porownania jak wygladają mgławice gdy skierujemy na nie teleskop F8 a potem F5 czy nawet F4. Czy gdzieś są zdjecia jak obraz się prezentuje

Tak samo?

Teraz, Flaytec1 napisał:i czego się spodziewać?

Tego samego?

Czasem w f/7 - f/8 prezentuje sie nawet lepiej, bo gwiazdy ładniejsze. ale wtedy potrzebny z kolei większy sensor by widzieć to samo. Więc zwykle korekcja optyki na podobnym polu widzenia taka sama.

f/4 i sensor 18 x 12 mm x 3 um =

= f/8 i sensor 36 x 24 mm x 6 um

(przy tej samej aperturze i konstrukcji optycznej)

-

1

1

-

-

Też szukam małej przezroczystej kulki. Zdjęcie jak zwykle świetne.

-

1

1

-

1

1

-

-

Teraz, isset napisał:

przepraszam

ja chętnie zrobię, ale nie miałem jeszcze okazji

ja chętnie zrobię, ale nie miałem jeszcze okazji

-

1

1

-

-

Hej Kuba!

Rozumiem, że to jest LRGB kamerą mono? (dodawanie tego "C" w nazwie MMC, bardzo mnie myli, niektórzy piszą MM-C, ale to "cool" faktycznie można sobie już darować, a teraz nie wiem, czy to może nie miało być MC? a masz oba sprzęty, czy to hybryda z obu kamer?).

Jeśli to ASI2600MM:

- czy możesz powiedzieć jakiego gainu używasz? spodziewam się, że gainu 100, jeśli mógłbyś też odczytać offset z headera, to super

- jeśli miałbyś chwilkę wrzucić plik surowy z L oraz R, takie w miarę dobre, z okolic północy astronomicznej (ca 00:30), w miarę niejajowate (niskie eccentricity/mimośród)

Jeśli to ASI2600MC -- podobne pytania, ale tylko o jedną klatkę.

Jeśli w ogóle "wgrałbyś" gdzieś po jednym pliku bias na gainie 100 i 250 (np. 10 ms, ciemno, chłodzenie nieważne) to już w ogóle by było super.

Co mam w głowie? Pomnożyłbym Twoją klatkę x4 w pixelmath. Wiele osób paliłoby nawet 8 minut L i nie marudziliby, że gwiazdy przepalone. Ty możesz ten efekt osiągnąć mnożąc gain x4. W wypadku ASI2600 jest to 100 vs 250 (gain/adu 0.2 vs ok 0.05, nie testowałem dokładnie, a z wykresików trudno odczytać, zresztą kto by takie rzeczy testował, zdjęcia robić trzeba!). Niestety w trybie HCG read noise już tak ładnie nie spada jak w przypadku jednego "wzmacniacza". I według ZWO ASI jest to praktycznie niewiele poniżej 1.3 e- (1.5 e- dla 100).

Nie sądzę, że to pomoże, ale przynajmniej jest to jakaś statystyczna analiza zjawiska. NIestety myślę, że tu prawda jest brutalna -- ponieważ read noise nie zmienia się już prawie w ogóle od 100 wzwyż, to jedyną metodą zmniejszenia całkowitego noise'a w stacku jest zmniejszenie liczby subów (tj. wydłużenie czasu suba, zakładamy stały całkowity czas poświecony na projekt). Im ciemniejszy obiekt chcemy próbować, tym dłuższy czas potrzebny, gdyż, w uproszczeniu,

- TOTAL_NOISE^2 = SUB_NUM * READ_NOISE^2 + TOTAL_PHOTONS

Drugi składnik jest przybliżony/uproszczony i zależy od QE, i będę o tym pisał tutka pewnie. Jak zdążę. Jednak minimalizacja

- SUB_NUM * READ_NOISE^2

jest kluczowa. W obszarach, gdzie TOTAL_PHOTONS jest "malutkie", przeważa pierwszy składnik. Najłatwiej redukować go "SUB_NUM-em". Wiele klatek można by jeszcze solidnie dopalić... Czasem da się też używać wyższego gain i zbić trochę read noise. Myślę, że w wypadku HCG w ASI2600 nie da to żadnego zauważalnego wyniku. Jednak można sobie klatki w Pixelmath mnożyć, x2, x3, x4 i patrzeć, (w linowym!!!, bez stretcha) ile "kropek" wyskakuje, i ile jest przepalone, czy sobie z tym jeszcze poradzimy.

PS.

Aha, bin2 można sobie w komputerze zrobić, np przedstawiając wersje pliku jpg w rozdzielczości 2048 x 1600

Poza 294 i CCD to rozważanie binu w sterowniku ot jedynie wygoda (rozmiar/transfer), ale to raczej rzadko problem w dzisiejszych komputerach.

Poza 294 i CCD to rozważanie binu w sterowniku ot jedynie wygoda (rozmiar/transfer), ale to raczej rzadko problem w dzisiejszych komputerach.

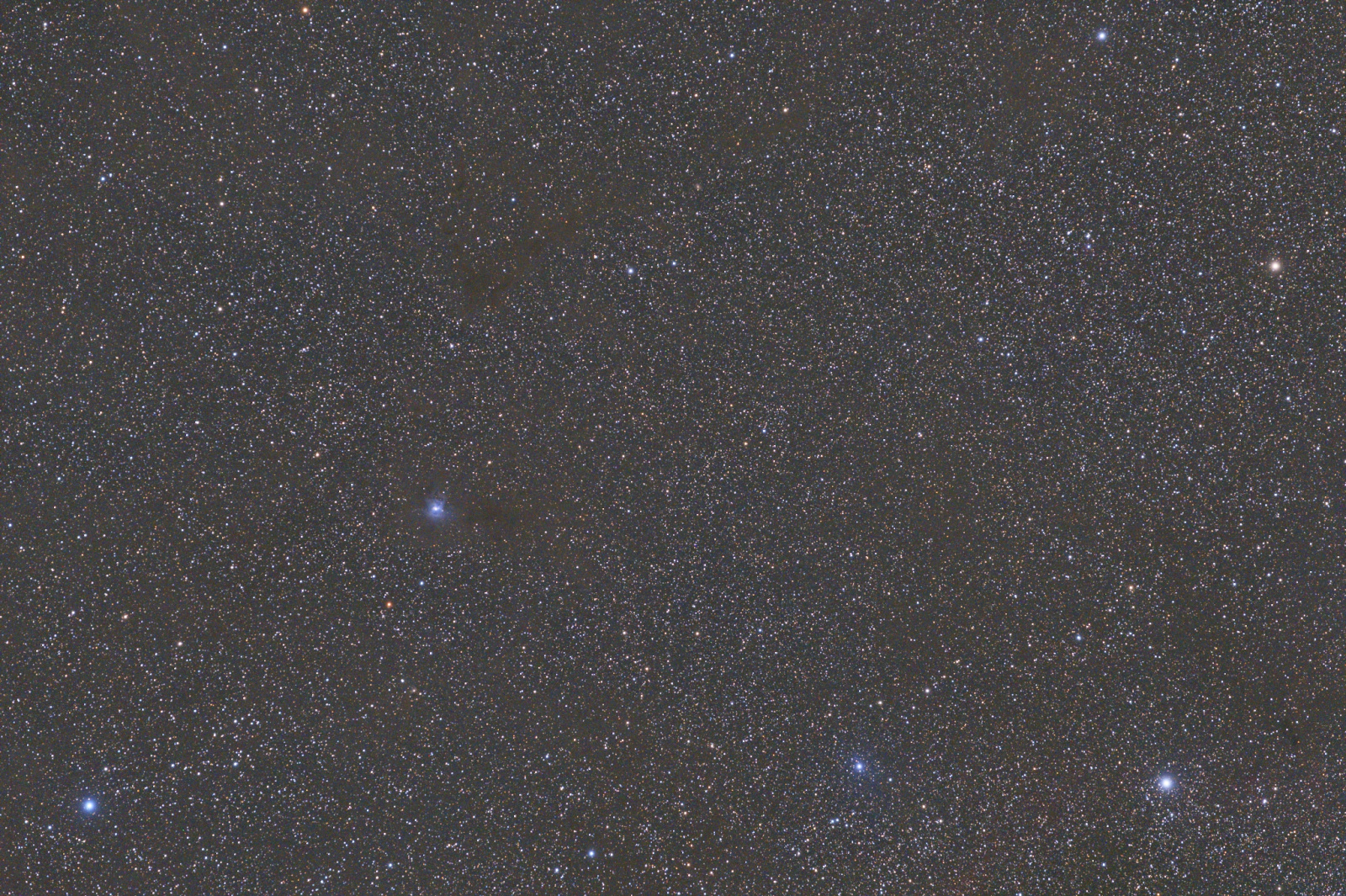

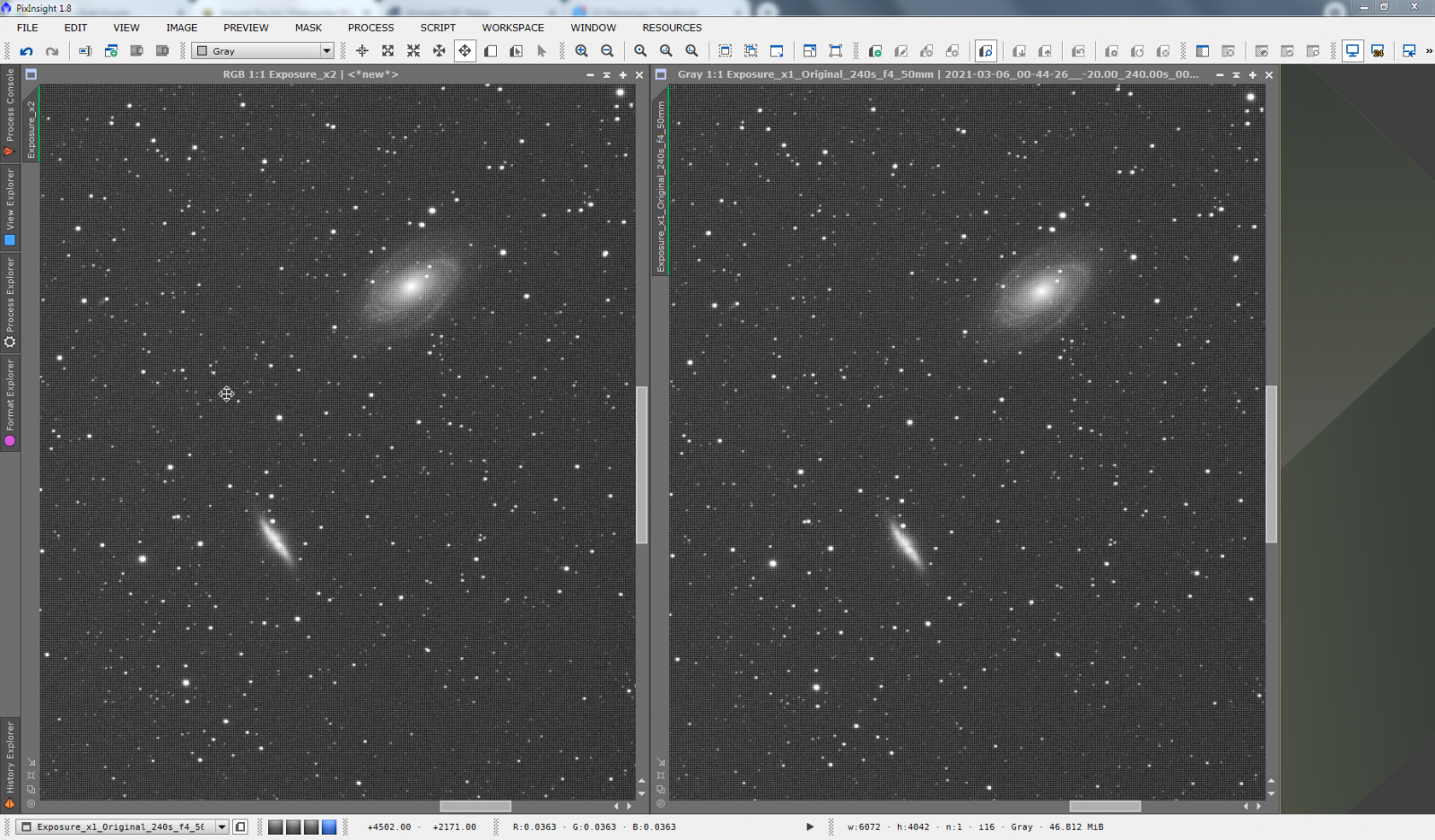

Tu wycinek klatki z mojej próby foty IFN.

- Lewa strona: sztucznie x2 (symulacja 8 minut ekspozycji).

- Prawa strona: f/4, 200 mm, 240 s, gain 140, asi2400mc.

Nie widać, żeby się coś szczególnie paliło, trochę więcej jądra M81 i M82 jaśniejsze tylko nieco, ale nadal szare. Czy mogłem sobie robić 8 minut zamiast 4 minuty? Ja np. teraz nawet żałuje. Gdybym mógł zmniejszyć read noise o czynnik pierwiastek(2) też bym mógł. A poświęcając tyle samo czasu, składnik SUB_NUM * READ_NOISE^2 byłby dwa razy mniejszy. Nadal miałbym 61 subów zamiast 112, to i ditherów dość i processing krótszy.

Dodatkowo, tu stretch dla wyczucia co tam jest, prawa-lewa identyczna (dosłownie, bo stretch sam kompensuje moje x2).

-

1

1

-

2 godziny temu, wessel napisał:

No cóż, pozostaje życzyć powodzenia..

Ale przy czym? Co nie tak? Czemu tuby pod montaż dobierać a nie ogólnie upgrade planować? Bo kłopot z dostępnością montaży xD?

Z tej obszernej odpowiedzi niestety nie umiem wysnuć nic pomocnego mi, czy wątkowi, ale dziękuję.

-

1

1

-

-

1 godzinę temu, wessel napisał:

No i znów nikt nie bierze pod uwagę montażu?

Bo to nie jest istotne.

- Montaż można zupgrade'ować to po co się nim kierować przy wyborze ogniskowej. Dosyć skomplikowane hobby już i tak.

- U mnie na eq6 zwykłą lunetką prowadzę <0.5", OAG jest jeszcze bardziej niezawodny

- Mam znajomych, którzy schodzą dobrze poniżej sekundy łuku na heq5

- Są belt mody

- Nawet z ogniskową 600 mm dla najmniejszego mozliwego piksela 2.4 mikrona mamy 0.8"/px

- Zakładając duży sensor tych "megapikseli" będzie z 60+ i i tak ludzie wolą taki piksel powiedzmy 4 mikrony i wtedy sampling 1.33"/px

- Całkowity PSF to "suma" (właściwie splot) składowych, główne to: TotalPSF = OpticsPSF*SeeingPSF*MotionBlurPSF, od odpowiednio: apertury/optyki; atmosfery; ruchu obiektywu.

- Oczywiście im mniejszy każdy składnik tego splotu, tym lepiej, ale są to osobne zagadnienia

Dlatego bym się nie kierował montażem przy wyborze ulubionej zabawki. Rzadko kto "wgrywa" fotki powyżej 4K o sensownej jakości do spodu. To powoduje, że na APS-C efektywnie mamy 8 megapikseli. To daje piksel około 25 mm/4k = 6 um. (skala 2"/px przy 600 mm) To sugeruje, że nawet z prowadzeniem w granicach 1" może być nieźle.

Idąc tym tropem oczywiście można nie kupować niczego dopóki nie mamy GM 3000HPS 10 micron.

Kiedy guiding jest na poziomie 0.5-0.7" to wyraźnie widzę seeing i niedokładności w optyce i ciężko to bedzie poprawić.

Kwestie masy? Lecę z taką dokładnością 20 kg z czteroma przeciwwagami na EQ6. Fra600, 400 i acl200 to są maleństwa. Fra600 to najlzejszy i najkrotszy apo108 mm jaki widziałem. Więc masa tu tez nie odgrywa duzej roli.

-

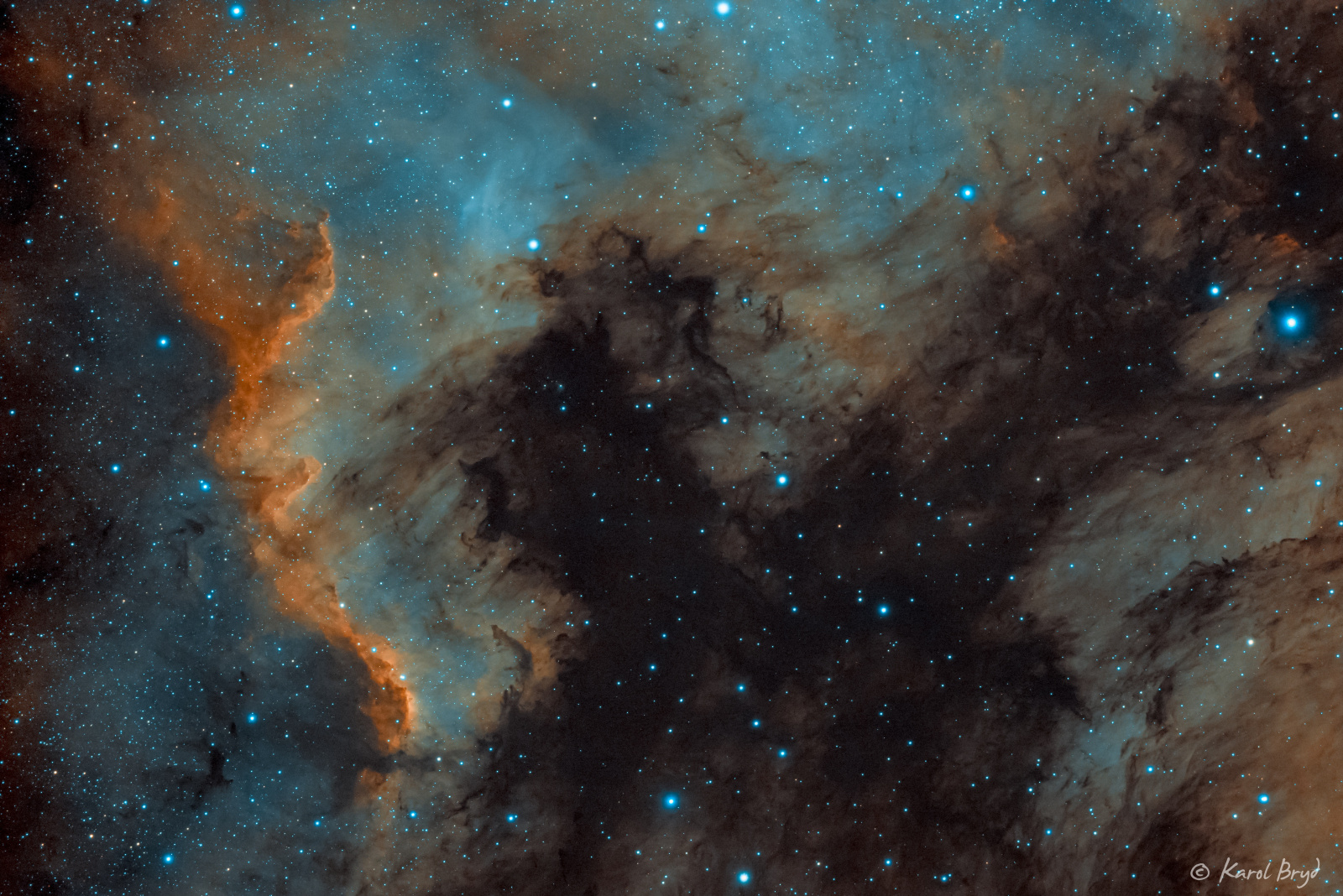

W dniu 1.08.2021 o 18:43, karolbe napisał:

Oto moje 1. podejście do HOO. Kolory wzorowałem na tym co widziałem na astrobin i innych miejscach. Nie do końca wiem jak ogarnąć kolor gwiazd, wpada w niebieski i gwiazdy maja spore halo (a te jasne gwiazdy nie dość, że duże i to brzydkie) - nie wiem jak je zmniejszyć bez użycia PixInsight (którego nie mam). Chętnie poznam jakieś dobre sposoby na to, skrypty Astronomy Tools wydają się nic nie zmieniać w tej kwestii mimo, że mają skrypt do zmniejszania halo. Oczywiście krytyka mile widziana.

Szczegóły techniczne:

Po okolo 3.5h Ha i OIII z Warszawy

ASI183MM + GT81 na EQ6-R

stackowanie i łączenie APP, usuwanie szumu i reszta w PS/LightRoom.

-

Każda ogniskowa się przyda, proste pryncypium to

1) co chce sfotografować

2) jaki fov potrzebuje

3) jaki mam sensor

4) jaka do tego ogniskowa

5) największa apertura z najlepszą korektą na jaką mnie stać (jaka istnieje) przy tej ogniskowej

Wtedy maksymalizujemy możliwości sensora (nie robic crop) i apertury/ogniskowej (nie ma potrzeby mozaik)

Z tych co wymieniłeś: fra600 bez redukcji z kamerą FF wkręconą wprost w m68 (z dużym oagiem i kołem) to po prostu marzenie. Nie jest to co prawda "najbardziej funky" tryplet jaki można sobie wyobrażac. Ale... "sensownie tanie" 108 mm apertury.

-

1

1

-

1

1

-

-

M31 galaktyka w Andromedzie ma dużo klasterów globularnych (xD) i możemy je spokojnie podziwiac jak się postaramy

https://en.m.wikipedia.org/wiki/Andromeda_Galaxy

Tu amatorskie "dostrzeżenia"

https://www.astrobin.com/267215/?nc=all

W dalszych galaktykach obserwacje gromad kulistych są już pewnie niemożliwe. Za to supernowych spokojnie.

Ciekawostka: najdalszą od nas gromadą kulistą jaką ja znam jest Intergalactic Wanderer w Rysiu, ok 300k lś. Czyli "kilka" dróg mlecznych. Ogladałem eRCekiem

https://en.m.wikipedia.org/wiki/NGC_2419

Dlaczego Słońce zachodzi na czerwono? Nudne, każdy wie. No wlaśnie dlatego niektore chmury molekularne są żółtoczerwone a gwiazdy na nich pomarańczowe. "Przeszkody" maja akurat taką gęstość, że "zdejmują" troche niebieskiego. Niektóre za to są tak gęste, że prawie czarne. Niebieskie gwiazdy na tle gęstego brązowego pyłu mają szansę być "przed nim" lub "w nim" (Irys).

Stąd także i zmiana kolorystyki galaktyki, szczegolnie części zasłoniętej gęstszą materią bliżej jądra.

Wiele z tych niebieskich "paciek" to regiony H_II, M101 Pinwheel jest rekordzistą, polecam tam się przyjrzeć. Są regiony Ha, które już zostały wymienione. A reszta to po prostu średnie światło gwiazd.

Może o czyms zapomnialem? Jak sobie przypomnę to dopiszę.

Tu właśnie suma światła naszej galaktyki wstecznie, w maluteńkim ułamku odbita od kosmicznej kołderki wróciła do mojego sensora.

PS. W moim temacie o 294mm kalibracja, jest obrazek surowy Ha z M101.

Tak mi się skojarzyło.

Tak mi się skojarzyło.

https://astropolis.pl/topic/79472-tło-i-jego-kalibracja-w-sensorach-asi294mcmm/

-

3

3

-

-

@Behlur_Olderys No i może jeszcze wrzucę, że nie nazwałbym drizzle "sztucznym", nawet w cudzysłowie (moje małe czepialstwo). To realny efekt. Pod warunkiem, że poprawnie przygotowany.

Metoda "fachowo" nazywa się

variable-pixel linear reconstruction

i pod takim hasłem można znaleźć więcej technikaliów.

-

2

2

-

1

1

-

-

@Wiesiek1952 ...

najs. I już na nic nie muszę odpowiadać

najs. I już na nic nie muszę odpowiadać

dla @isset dodam tylko uwagę nt. CFA drizzle, ktora tyczy sie tylko OSC i na ma związku z undersamplingiem. można dać krotność x1, czyli bez zmiany rozdzielczości, ale za to pikselki z matrycy CFA (np. RGGB) zbiorą się w zdjęcie bez interpolowania czy debajerowania

-

3

3

-

1

1

-

-

3 minuty temu, everr napisał:

Chciałem poznać jakie mechanizmy siedzą w PIXowych auto-stackowaniach/kalibracjach/alignacjach itp. a do tego uzupełnić wiedzę z tych procesów.

Do tej pory robiłem wszystko za pomocą skryptu WBPP. Czyli wrzuciłem wszystko do termomixa i prawie na defaultach otrzymywałem materiał do wyciągania i edycji. Teraz głód wiedzy powoduje, że może jednak coś da się zrobić lepiej.

Podsumuję co wiem (ogólnikowo):

Kalibracja - z pomocą BIASów, DARKów i FLATów nanosimy pewne poprawki związane z charakterystyką działania elektroniki oraz toru optycznego

Stackowanie - "łączenie" wszystkich klatek LIGHT w jeden wynikowy plik

Alignacja - dopasowanie poszczególnych klatek(?) lub grup klatek np z danego filtra do siebie aby przy nałożeniu pokrywały się elementy ze zdjęcia

Teraz niewiadome:

Normalizacja - wiem, że pomocna ale nie czuje się na siłach aby powiedzieć co dokładnie wykonuje.

Drizzle - o ile dobrze zrozumiałem jest po to aby "naprawić" obraz po ditheringu lub po to aby sam dithering zadziałał przy usuwaniu szumu?

I najważniejsze - Kolejność działań.

Do tej pory ustaliłem, że:

1) Selekcja - wizualna BLINK, "matematyczna" SubFrameSelector.

2) Wybór klatki referencyjnej (potrzebna będzie tylko do alignacji?) - SNR, FWHM -manualnie z listy wyników SFS?

3) Wykonanie masterów klatek kalibracyjnych? - ImageIntegration

4) Kalibracja - i tutaj zagwozdka bo znaczy to, że kalibrujemy każdą klatkę z osobna odpowiednimi masterami (jesteśmy jeszcze przed stackowaniem)? - ImageCalibration?

5) Alignacja - StarAligment

6) Normalizacja (?) - do stackowania są chyba potrzebne wygenerowane pliki normalizacji, a tworzy się je po alignacji?

6) Stackowanie - ImageIntegration

Przy zdobywaniu tej "wiedzy" korzystałem z tematu naszego forum oraz kilku różnych wątków z sieci.

Ustawienia w każdym z tych procesów to trochę odrębny temat.

Wiem, że wielu z Was wykonuje niektóre te działania także w Maximie ale nie mam takiej możliwości i chcę to wyrobić sobie proces to stackowania w Pixie.

Niektóre rzeczy maja mniejszą istotność i komutują swobodnie, inne większą. Nie sądzę, że ja to wiem akurat jakoś super dobrze, czy "lepiej", ale mogę powiedzieć jak robię, albo co sądzę.

- Kalibruje klatki od razu, tego samego dnia najczęściej.

- Zatem kalibracja na początek, przed blink, może zmarnuję trochę CPU na kalibrowanie odrzutów, ale skalibrowane klatki wyglądają lepiej.

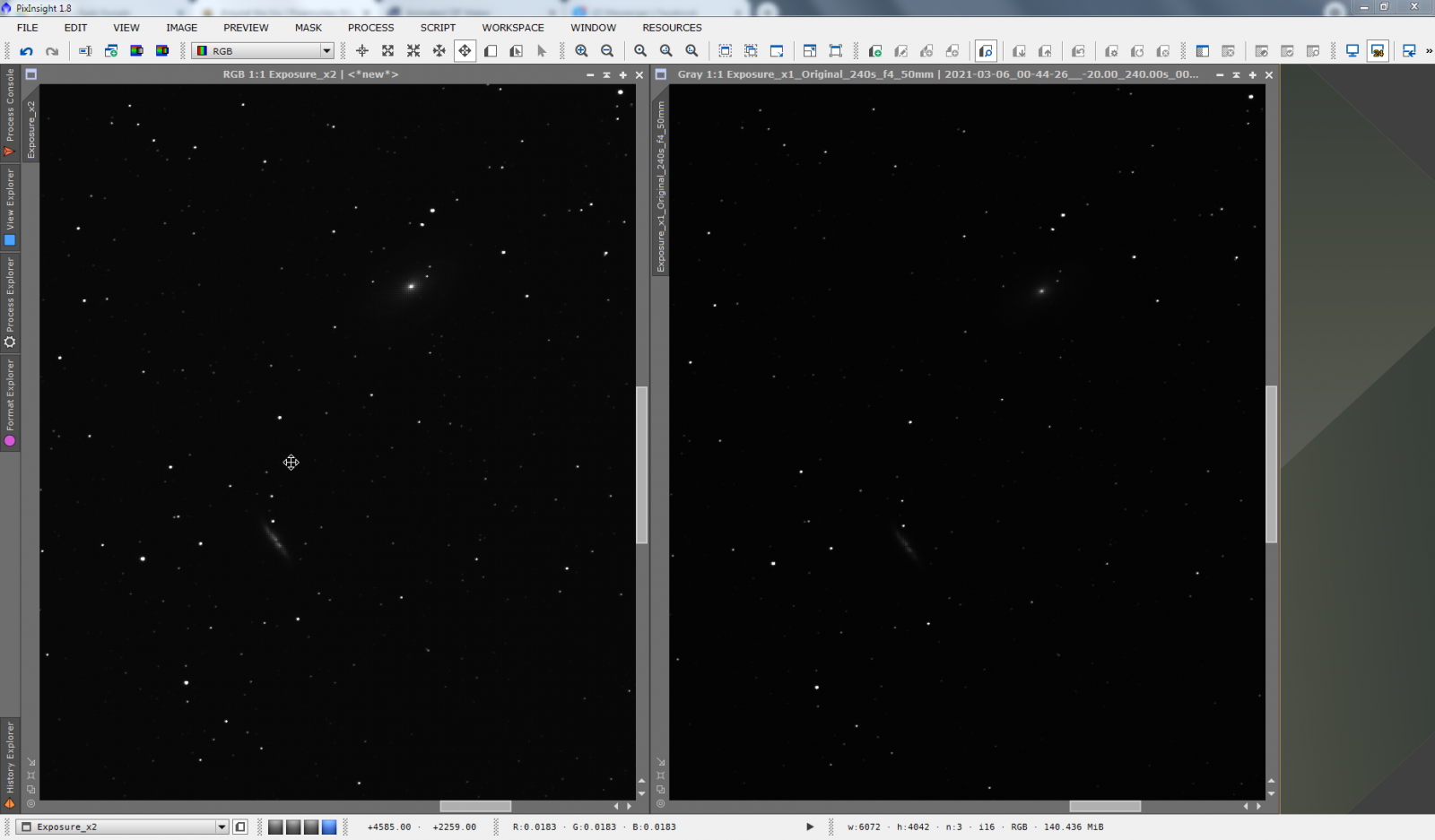

- Na wzmocnienie, moje szerokie pole w Irysie

-

nieskalibrowana najlepsza 240 s:

-

skalibrowana najlepsza 240 s:

-

wolę blinkować skalibrowane

- Co do normalizacji -- jeśli mowa o "local normalization" to przed całkowaniem po Align. Zwykle jednak Normalizacja w procesie integracji wystarczy.

- Jaka to normalizacja?

- multiplicative -- dla integracji skalibrowanych flatów (flat -darkFlat) lub (flat - superbias), ogólnie stosowalne kiedy "zero jest w zerze"

- no normalization -- dla biasów, darków

- addtive+scaling (jak proces Linear Fit, proces, nie opcja odrzucania) -- dla skalibrowanych lightów (light-dark)/masterFlat

- equalize fluxes -- normalizacja przy odrzucaniu dla flatów, mapuje piki histogramów na siebie

- scale+zero offset = additive + scaling, w pixie to samo występuje zwykle pod kilkoma nazwami, taka niekonsystencja

Na zakończenie stack 112 x 240 s z klatek, które pokazywałem:

stackflow: kalibracja, debayer (bilinear), blink, subframe select, star align (generate drizzle), integration (generate drizzle, additive+scaling, linear fit clip, scale+offset), CFA drizzle (integration x1, drop shrink 1.0 (none)), crop, DBE, photometric calibrationI to uważam za koniec procesu stackowania. Od teraz jest obróbka. Oczywiście kroki związane z CFA należy wymazać z workflowu dla mono. Wystarczy: wykreślic debayer, CFA, zmienić x1 na x2, lub całkowicie wykreślić drizzle, crop (nie wiadomo jaki crop bedzie póki nie ma wszystkich masterow), photometric (rzecz jasna)

Kalibracja MONO i CFA jest IDENTYCZNA. Wszelkie bzdury na ten temat to bzdury. Kalibrujemy surowe klatki przed demozaikowaniem. Surowymi flatami, bez demozaikowania.

-

7

7

-

1

1

-

- Ta odpowiedź cieszy się zainteresowaniem.

- Ta odpowiedź cieszy się zainteresowaniem.

W dniu 15.08.2021 o 11:26, Misza napisał:Już kilka tygodni temu podjąłem, jak mi się wówczas wydawało, finalną decyzję co do zakupu ASI294MM. Ostatnio jednak dożo czytam o problemach z kalibracją i częstym pojawianiem się dziwnego "wzoru" zwłaszcza przy NB. Niektórzy piszą że da się to ogarnąć flatami ale nie zawsze łatwo. Ma to być moja pierwsza kamera nie licząc planetarki więc zastanawiam się czy wyborem modelu który nawet wśród ekspertów uchodzi za trudniejszy nie proszę się sam o problemy. W tej sytuacji myślę tez o opcji ASI2600 u której (chyba?) takich problemów nie ma, w każdym razie nie natknąłem się na takie opisy. O wspomnianym problemie w 294 pisał sporo tutaj Przemek Majewski, jest też opis (chyba również jego) na stronie teleskopów.pl. Podobno ten wzorek na matrycy jest też widoczny gołym okiem i nie trzeba nawet zdjęć by ocenić który egzemplarz będzie w większym stopniu wykazywał ten problem (a od egzemplarza również to zależny). W sumie to już nawet byłem dogadany co do zakupu z teleskopami.pl (podobno mają na stanie sporo egzemplarzy). Zastanawiam się nad dwiema opcjami:

1. Zakupić 2600mm (opcja bezpieczniejsza?)

2. Przejechać się osobiście do teleskopów i poprosić o możliwość rzucenia okiem na kilka egzemplarzy 294 by spróbować wybrać egzemplarz gdzie problem będzie mniej widoczny (ale to chyba nie da większej gwarancji co potem wyjdzie w praktyce na zdjęciach)

Pomijając wspomnianą wadę na matrycy wolałbym zostać przy 294 mimo że niektóre parametry ma lekko gorsze.

Tańsza, tańsze (mniejsze) filtry, większy piksel co dla początkującego nie jest bez znaczenia.

Doradzicie coś?

Moja rada jest prosta, 2600 MM to overally better camera, ale x2 droższa.

Czasem proszę Was, żebyście brali sobie do serca moje "wypociny", ale chyba nie skutkuje

To najpierw dosadnie:

- Martwisz się flatem? Skoro pokazałem jak prosto się to kalibruje, a flaty w astrofoto to podstawa? TO SIĘ NIE MARTW, bo to jak grochem o ścianę.

- NIE MARTWISZ się za to amp glowem, który świeci w tej kamerze jak żarówa

Dlaczego internet wybiera te "niewlasciwe zmartwienia" jako główne. Wzór w podczerwieni to pikuś i kalibruje się doskonale, a to i tak przy okazji, bo flat to zwykle mus.

A amp glow? Chcesz mieć darki na 120, 300, 480 i 600 sekund. Robił będziesz libkę z tydzień, jak ja do testów. Zechcesz zmienić czas na 420 sekund, bo tak będzie lepiej? I co? Dorabiać darki, albo skalować tamte odjąwszy bias etc. AMP GLOW, to jest właściwa uciążliwa sprawa. Dajcie spokój temu flatowi -- nauczycie się tego kalibrować, flaty są i tak potrzebne, a złe flaty, to tylko gorzej dla zdjęcia. Flaty i tak są niezbędne, wada i tak się skalibruje. Nie ma co o tym gadać.

ASI294MM ma za to wielką zaletę, ma Unbin 1, i ten tryb ma super piksel 2.3 mikrona i świetnie działa na planetach, dość wygodne -- nie zmieniać setupu. Z drugiej strony poza niską ceną, ma też mniejszą matrycę. Aha, tryb Unbin1 nie jest wspierany przez NINĘ, Firecapture. Działą w ASICAP i chyba w Sharpcap, nie wiem jak w SGP. Więc niby nowinka, ale też uciązliwa. Ma duży amp glow. Z zalet: ma backfocus 6.5 mm, można wkręcić m42 wprost w koło, i filtry będą bardzo blisko. wystarczą nawet małe filtry.

ASI2600MM ma:

- średni piksel pomiędzy 294 bin/unbin

- backfocus minimalny 12.5 mm po odkręceniu tilt plate-a

- brak amp glow, co umożliwia kalibrować wszystko piedestałem bez darków

- dzięki powyższemu, absolutna dowolność w czasach ekspozycji

- jeśli ktoś w końcu nauczy się "kryterium ekspozycji" dla astrofotografii, to może sobie dobrać parametry gain/czas wyjątkowo dowolnie i optymalnie

- ponadto, to o czym wspominam, GAIN 0, gain 0 dla asi2600MM jest niesamowicie dobry, szum odczytu dla gainu zero skaluje się zgodnie z pierwiastkiem ze wzmocnienia względem gainu 100

- powyższe znaczy, ze można używać 4x dłuższych ekspozycji na gain 0 bez żadnego statystycznego uszczerbku(przypis) dla zdjęć (jeśli ktoś to umie w ogóle naprawdę dostrzec, bo to są niuanse)

- to z kolei jest niezwykle dobre przy robieniu subów L z jasną optyką

- za to trzeba dać prawie x2 tyle dolarów (ceny znam najmniej)

W tym sensie porównywanie tych kamer to bardziej, czy chce dać 2x tyle, za 2x lepszy rzecz, czy dać mniej, i np. robić bibliotekę darkow, trzymać się pewnych czasów subów, etc. i mieć jednak duzo mniejsza matrycę! Moim zdaniem już różnicę ceny pokrywa zwiększenie samej matrycy, nie mówiąc o dodatkowych perkach.

Przykład:

Gdybym używał reflektora, np GSO RC10 (no lubię, no), to miałbym parfokalność dla wszystkich filtrów i naprawdę nie musiałbym osobno dla nich ustawiać ostrości. Mając ASI2600MM z kołem LRGB ustawiłbym taką sekwencję

- 600 s L, gain 0, offset ten sam co dla 100 (dla wygody)

- 400 s R, gain 100, offset dobrany

- 300 s G, gain 100, offset dobrany

- 300 s B, gain 100, offset dobrany

- dither

Taką sekwencję powtarzałbym do bólu. Łączny czas 23 minuty (w tym 20 s na dither), z tego 10 minut wpada w L, reszta w RGB, dlaczego 400 dla R? Bo też efektywność jest jak 60% dla R, 80% dla G/B. Dzięki temu robię 1 dither na 23 minuty, ale każdy kanał jest poditherowany. Super oszczędność. Łapię wszystkiego ile chce, a czasy mogę dobierać proporcjonalnie, nie przejmując się darkami, do tego łapie super suby L. Po dziesięciu godzinach mam 25 takich serii, wiec jest co stakować i odrzuć outliersy.

Przypis:

Mamy do zważenia ca 3.5 kg i dwie wagi

- taką o zakresie 0...1 kg, z błędem 1 g

- taką o zakresie 0...4 kg, z błędem 4 g

Możemy podzielić tę masę (odsypać). Której wagi lepiej użyć?

Rozwiazanie: Przyzwyczajeni do liniowości świata, ludzie bez wahania mówią "bez różnicy"! Ale jak dodajemy cztery pomiary z błedem 1 g, to jest on losowy, może być w gorę i w doł. Widać, że sumujac, jest spora szansa, że "trochę błędów się zniesie". Błędy dodają się jak w twierdzeniu Pitagorasa -- w kwadracie. Dlatego "1+1+1+1" = 2 = pierwiastek(1^2+1^2+1^2+1^2). Zatem ważąc 4 razy wagą mniejsza i dodając wyniki dostajemy sumaryczny błąd 2 gramy! Więc duża waga ze swoim 4 g błędu jest do bani.

Mamy do zważenia 3.5 kg i dwie wagi

- taką o zakresie 0...1 kg, z błędem 1 g

-

taką o zakresie 0...4 kg, z błędem 4 g

Tak samo jest z gainami. Jak gain 0 jest około 4 razy dłuższy, i ma około 2 razy większy read noise w [e-], to te gainy są równoważne. Tak jest i w tej kamerze 2600mm. To rzadkość w ZWO. W ASI 294MM ten gain 0 jest 4x słabszy i ma 4x gorszy szum. LCG jest raczej gorsze od HCG.

===========================

Zainteresowani potencjalnie właściciele lub chętni na asi2600 dla których może to być interesujaće ,a nie bede musiał powtarzać, wywołuję:

@TUR @everr @rybek0s i reszty zapomniałem, albo nie znam, bo mało kogo znam.

a to jeszcze @teleskopy.pl teleskopy.pl, podwójna moc teleskopowania, oni się tym najbardziej interesują

-

6

6

-

1

1

-

4

4

-

5 minut temu, apolkowski napisał:

Pomaga monitorowanie SNR gwiazdek guidingu.

Moj phd2 "drze ryj" jak gubi gwiazdę

to pewnie przeprogramowany to i ten prąd do worka mosznowego mógłby dostarczać (ktos sugerował)

to pewnie przeprogramowany to i ten prąd do worka mosznowego mógłby dostarczać (ktos sugerował)

-

3

3

-

-

2 godziny temu, everr napisał:

Chciałbym podziękować @JaLe, @Przemek Majewski, @rybek0s, oraz @Wiesiek1952 za testy i recenzje. Właśnie złożyłem zamówienie na ASI2600MM Pro. Każdy z Was dołożył swoją cegiełkę.

Jeszcze w zasadzie zapomniałem dodać kolegę @TUR bo to od niego się zaczęło

Mam nadzieje, że w @teleskopy.pl teleskopy.pl (lubie to podwójne nickowanie dla wzmocnienia, ach).

To mnie nie zabiją za szum wokół postu z kamerką

-

1

1

-

-

1 godzinę temu, Wiesiek1952 napisał:

Test byłby nic nie warty bez zdjęć. ;-)

Ładna Andromeda.

Wiem, ze to pewnie "żarcik", ale powiem: NIE ZGADZAM SIĘ. Test (matrycy) przez zdjęcia jest NIC nie warty, gdyż wchodzą w to czynniki

- seeing

- umiejetnosci operatora

- guiding

- niebo/typ obiektu/warunki

- jakosc optyki

- i milion innych

Mało ludzi tu widać wie, że od samej kamery naprawde mało zalezy w astrofotografii poza rozmiarem jej matrycy/piksela. I jej kalibracją.

Kalibrację najlepiej badać BEZ nieba, albo na przykladzie sprawdzonego setupu/panelu led, darkow i syatystyki szumu. Dzieki filtrom mozna sprawdzić EFEKTYWNOŚĆ w różnych pasmach jesli mamy źródło o znanej temperaturze barw.

To sa wszystko "sprawy" które nazwałbym testem. Fajnym, niecodziennym. Ale się już powtarzam a dowcip zrozumiałem

PS. Do tego uciażliwe efekty jak microlensing, dziwne artefakty matrycy tez się zdarzają i tez trzeba to testowac w specyficzny sposób.

-

22 minuty temu, rybek0s napisał:

A to ci dopiero

Wlasnie jestem w trakcie robienia tego samego, tyle że zamiast Uno wybrałem IoT nano z bluetooth. Właśnie w wolnych chwilach pisze sterownik pod ASCOM żeby działało to jako SafetyMonitor. Plan jest taki żeby podpiąć to pod NINA i w połączeniu z IFTTT wysłać sobie notyfikacje na telefon

Wlasnie jestem w trakcie robienia tego samego, tyle że zamiast Uno wybrałem IoT nano z bluetooth. Właśnie w wolnych chwilach pisze sterownik pod ASCOM żeby działało to jako SafetyMonitor. Plan jest taki żeby podpiąć to pod NINA i w połączeniu z IFTTT wysłać sobie notyfikacje na telefon

Same mądre rzeczy tu ^^ Można też wyprowadzkę do Chile... zamiast tego napięcia do...

-

52 minuty temu, Tayson napisał:

Wstepnie ok 2k pln w plecy. Oby nie ;(

Zrobię mu za zero jak juz się ogarnie

Tylko nie ma jak zamknąć bezkurzowo. Tak jak pisałem Karolowi - czyste złożenie najgorsze. Resztę robiłem.

-

Zrobimy Karol, nie bój żaby.

-

1

1

-

Jaka różnica w obrazie mgławic między F4 a np F8 ?

w Pierwsze Kroki: Sprzęt

Opublikowano

do przegladu nieba okular 32 mm -> źrenica wyjściowa 6.4 mm (32 mm/ 5). powiększenie x15.5.

i zgodnie z tym co tu wcześniej było pisane, dla okularu 6 mm źrenica wyjściowa (EP) bedzie 1.2 mm i zdecydowanie lepiej skonczyć nawet na okularze 9 mm