-

Postów

9 964 -

Dołączył

-

Ostatnia wizyta

-

Wygrane w rankingu

41

Typ zawartości

Profile

Forum

Blogi

Wydarzenia

Galeria

Pliki

Sklep

Articles

Market

Community Map

Odpowiedzi opublikowane przez MateuszW

-

-

1 godzinę temu, Andrzej76 napisał:

Jeśli chodzi o kamerę , to chciałem aby była lekka i bez chłodzenia .

Brak chłodzenia to bardzo duża wada, warto je mieć.

1 godzinę temu, Andrzej76 napisał:Mam kamerę ASI 178 MC , i myślałem czy nie kupić takiej samej tylko mono , jedna do guide druga foto .

178 ma małe piksele, jak na newtona. On nie będzie Ci w stanie dać wystarczającej jakości obrazu dla tej kamerki. Już lepiej 174, bo ma większy piksel i nieco większą całościowo matrycę.

5 godzin temu, Andrzej76 napisał:astępując 80/400 lunetą do guidingu StarGuider Guidescope 50 mm f = 162 mm / 1,25 , warto to zamieniać ?

Ja bym zamienił na zwykły szukacz SW przerobiony. Wyjdzie sporo taniej, a efekt taki sam. A co do zasady - tak, warto zmienić obecną tubę na coś bardziej zwartego.

-

18 minut temu, _Spirit_ napisał:

Zrób jeszcze jedną diagnostykę tym

https://www.aida64.com/downloadsTo jest SSD i Crystal nie za dobrze pokazuje - zapomniałem.

Chodzi o AIDA Extreme, czy inną wersję?

Testy odczytu są ok, a jak chcę zrobić zapisu, to taki dziwny komunikat:

Jaki sens mają testy, które mi wyczyszczą dysk? Może gdzieś coś innego mam włączyć?

-

7 minut temu, Pav1007 napisał:

Nie ma unity offset - offset ustawia się, żeby uniknąć pikseli o wartości zerowej. Ustawiałeś go może? Tutaj jest dobrze opisane:

A czy przypadkiem ustawiając te presety gainu (unity i 2 inne), offset się też nie ustawia na odpowiedni? Tak mi się wydaje, nie mam kamerki przy sobie, żeby potwierdzić.

Maćku, może zrób Darki i biasy i porównaj je z tymi, co kiedyś Adam wrzucał, jak testował Asi. Jak szum będzie inny, to będziemy coś wiedzieć.

Mogę też zrobić na mojej kamerce, mam tą samą wersję.

-

Z jakiego to programu?

-

Godzinę temu, AdamK napisał:

Nie zgadzam się z taką teorią w tym przypadku, ponieważ Ha potraktowałem jako źródło luminacji, a nie jako powód do zabarwienia wszystkiego na czerwono.

Ja bym powiedział inaczej. Mi by się bardziej podobało, gdyby mgławica była bardziej czerwona

Ale w obecnej wersji i tak jest świetna!

-

1

1

-

-

1 minutę temu, JaLe napisał:

Kamera sumuje fotony, bo ma światłoczułą matrycę, natomiast software pixele, a to przecież jest kolosalna różnica.

Kamera sumuje sygnał analogowy, a software cyfrowy. Różnica jest tylko w szumie odczytu, który w software się dodaje 4x, a w hardware 1x. Ale to tyczy się CCD, bo one mogą taką operację dokonać z uwagi na sposób odczytu (przesuwanie ładunków do bufora wyjściowego). W CMOS każdy piksel jest odczytywany niezależnie, więc nie ma fizycznej możliwości zrobić bining na poziomie analogowego sygnału, przed ADC i wzmacniaczem. W CMOS od razu dostajesz cyfrowy obraz i bining możesz wykonać najwcześniej gdzieś w procku kamery, ale to będzie już cyfrowa operacja, czyli taka sama, jak na PC. Za to CMOS mają właśnie mały szum odczytu, więc ten brak jest mniej odczuwalny, bo nie zmienia dużo.

-

3

3

-

-

4 godziny temu, Duser napisał:

Sugerujesz, że po resize IFN wysycił sie na tyle , że zrównał sie z biningowanym stackiem?

Mniej więcej.

Generalnie resize obrazu to jakiś mniej lub bardziej złożony algorytm, który w efekcie da nam wynik podobny do uśredniania. Dlatego nie ma sensu porównywać "biningu" do resize, bo to podobne operacje. Przyjrzałem się opcjom resize w PSie i jest kilka do wyboru. Dla zainteresowanych prosta: http://www.algorytm.org/przetwarzanie-obrazow/zmiana-wielkosci-obrazu-interpolacja-dwuliniowa.html i bardziej złożona: http://www.paulinternet.nl/?page=bicubic.

Żeby to miało sens, musimy porównać zbinowany obrazek do oryginału. No i po wyświetleniu obu w 100% moim zdaniem widać różnicę (lepszy zbinowany). Zrobiłem też pomiary odchylenia standardowego w Maximie dla dwóch fragmencików bez gwiazd. Wyniki:

Bin vs orginał

6,18 vs 8,65

5,87 vs 8,65

Jasno widać, że zbinowany jest lepszy. Teraz pytanie do @Behlur_Olderys, jak się ma odchylenie std do SNR? Czy dwukrotna różnica w odchyleniu do też dwukrotna w SNR?

dygresja: Sprawdziłem też ten obrazek po resize i ma on jeszcze ciut mniejszy szum

STD Dev = 5,37. Generalnie, jak się mu przyjrzałem na dobrym monitorze, to widać, że jest on jakby ciut zblurowany w stosunku do bin(to widać minimalnie). Pewnie to kwestia użytego algorytmu do resize.

STD Dev = 5,37. Generalnie, jak się mu przyjrzałem na dobrym monitorze, to widać, że jest on jakby ciut zblurowany w stosunku do bin(to widać minimalnie). Pewnie to kwestia użytego algorytmu do resize.

Jako, że człowiek kiepsko porównuje szum na zdjęciach o różnej skali do siebie, to należało by zrobić inny test. Wziąć dwie tuby o tej samej aperturze, jedną f/5, drugą f/10. Wsadzić tam tą samą kamerę. I teraz zdjęcie z f/10 zbinować i porównać z tym f/5. To z f/10 zbinowane powinno mieć praktycznie taki sam szum, jak z f/5, jedynie dwa razy mniejsze pole widzenia. Różnica będzie na poziomie szumu odczytu, który w bin doda się 4x, ale jak wiemy, jest on w CMOS niski i nie powinno to wiele zmienić. Realnie takiego testu pewnie nikt nie zrobi

-

4 minuty temu, Duser napisał:

resize to tego samego rozmiaru

Pytanie, czym jest ten resize. Spodziewałbym się, że to jakieś uśrednienie właśnie...

-

1 godzinę temu, Behlur_Olderys napisał:

Światło, czyli ilość zarejestrowanych fotonów to iloczyn tylko dwóch wielkości: apertury obiektywu (tutaj to 10000mm^2) i czasu naświetlania (tutaj 8100s dla L)

Jeśli używałeś 135mm f/2 samyanga, to miałeś aperturę 2x mniejszą (4556,5mm^2) i czas 12480s, więc fizycznie miałeś 70% fotonów zarejestrowanych *mniej* niż Duser. (nie biorąc pod uwagę QE matrycy, domyślam się, że byłoby jeszcze bardziej na korzyść materiału Dusera).

Dlaczego więc IFN widać gorzej? Bo przy ogniskowej 4.3x większej, niż u Ciebie jeden piksel na Twoim zdjęciu zebrał tyle sygnału, co tutaj 18.

Parametry teleskopu i matrycy można rozpatrywać na wiele sposobów, w zależności, co chcesz akurat porównać

Tak, sumaryczną ilość światła określa apertura i czas exp. Ale ja pisałem o ilości światła przypadającego na powiedzmy jeden piksel. Jeśli weźmiemy dwa teleskopy np 8" i jeden ma f/5, a drugi f/10, to ten drugi zbierze tyle samo światła, ale "rozsmaruje" je na 4x większej powierzchni. Teraz, jeśli do drugiego teleskopu zapniemy 2x większą matrycę, to uzyskamy taki sam efekt (jeśli matryca będzie miała 2x większy piksel, to będzie to wprost, a jak zachowamy jego rozmiar i zwiększymy ilość, to trzeba będzie zrobić ten binning i też wyjdzie to samo).

Tak, sumaryczną ilość światła określa apertura i czas exp. Ale ja pisałem o ilości światła przypadającego na powiedzmy jeden piksel. Jeśli weźmiemy dwa teleskopy np 8" i jeden ma f/5, a drugi f/10, to ten drugi zbierze tyle samo światła, ale "rozsmaruje" je na 4x większej powierzchni. Teraz, jeśli do drugiego teleskopu zapniemy 2x większą matrycę, to uzyskamy taki sam efekt (jeśli matryca będzie miała 2x większy piksel, to będzie to wprost, a jak zachowamy jego rozmiar i zwiększymy ilość, to trzeba będzie zrobić ten binning i też wyjdzie to samo).

W tym przypadku stosuję taki "model", że światłosiła określa mi ilość światła na jeden piksel, a ogniskową pomijam, bo określa tylko skalę zdjęcia. Można powiedzieć, że średnica będzie wynikać z tych dwóch parametrów (w tym "modelu"). Chciałem porównać nakład czasowy do wykonania zdjęcia o "natywnej skali" dla danego instrumentu, stąd takim "model" przyjmuję.

Zgodzisz się ze mną?

Jeśli chodzi o zrobienie software binning 4x4, to zgadzam się - to powinno działać. To będzie w zasadzie taka konwersja skali na snr - jedno kosztem drugiego. Niestety, jeśli zmniejszymy zdjęcie do rozmiaru mojego zdjęcia z Samyanga, to stracimy jeszcze pole widzenia i to dość drastycznie (w sensie, że ja będę miał wciąż wielkie pole, bu tu go nie odzyskamy).

-

1

1

-

-

Gratulacje, świetne zdjęcie! W zasadzie bez wad

No może bym ciut jaśniejsze tło w wersji RGB pokazał, bo siedzi tam na prawdę sporo sygnału.

13 godzin temu, Duser napisał:

No może bym ciut jaśniejsze tło w wersji RGB pokazał, bo siedzi tam na prawdę sporo sygnału.

13 godzin temu, Duser napisał:Liczyłem trochę na złapanie IFN-a wokół galaktyk, jednak zarejestrował sie tylko słaby jej ( mgławicy) sygnał

Jak mawiają "z pustego to i Salomon nie naleje"

Porównałem sobie Twoje zdjęcie do mojego IFN przy Polarnej (gdzie wyszły dość mocne). U Ciebie ok 2h, u mnie 3,5h materiału, ale to szczegół. Ważne, że Ty masz jedynie f/5,8, a ja f/2, czyli daje to aż 8,4x mniej światła! Całościowo licząc daje to 13x mniej światła u Ciebie. To chyba tłumaczy, czemu IFN siedzą tak blisko szumu. No ale zebrać 13x więcej materiału w Twoim wypadku to byłby spory wyczyn. Światłosiła to jednak paskudna rzecz. Choć z drugiej strony ja fociłem pod dobrym, ale nie Bieszczadzkim niebem. Mam też wrażenie, że one lepiej się eksponują na szerszych kadrach, teleskop to już trochę dużo dla tak sporych struktur.

Porównałem sobie Twoje zdjęcie do mojego IFN przy Polarnej (gdzie wyszły dość mocne). U Ciebie ok 2h, u mnie 3,5h materiału, ale to szczegół. Ważne, że Ty masz jedynie f/5,8, a ja f/2, czyli daje to aż 8,4x mniej światła! Całościowo licząc daje to 13x mniej światła u Ciebie. To chyba tłumaczy, czemu IFN siedzą tak blisko szumu. No ale zebrać 13x więcej materiału w Twoim wypadku to byłby spory wyczyn. Światłosiła to jednak paskudna rzecz. Choć z drugiej strony ja fociłem pod dobrym, ale nie Bieszczadzkim niebem. Mam też wrażenie, że one lepiej się eksponują na szerszych kadrach, teleskop to już trochę dużo dla tak sporych struktur.

-

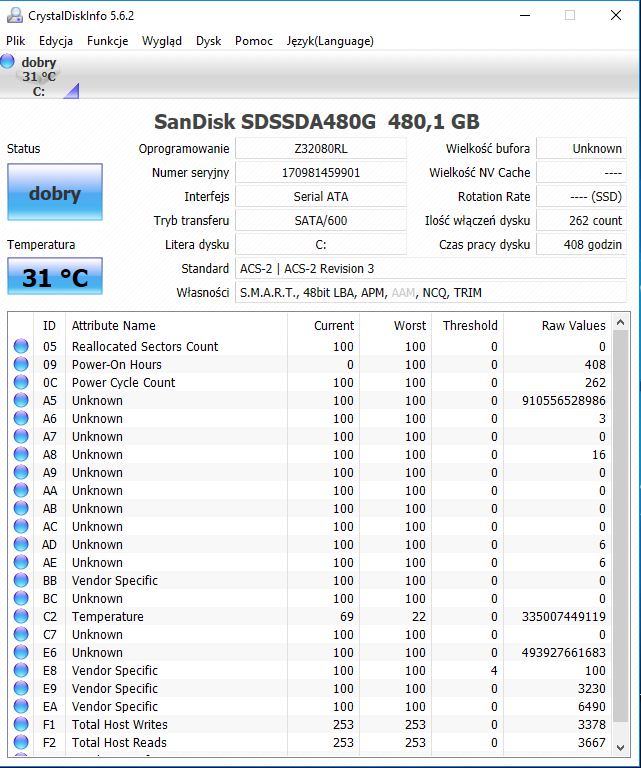

Stan dobry, a większość atrybutów nieznana...

-

58 minut temu, RomekAstrobaza napisał:

Trzymam kciuki

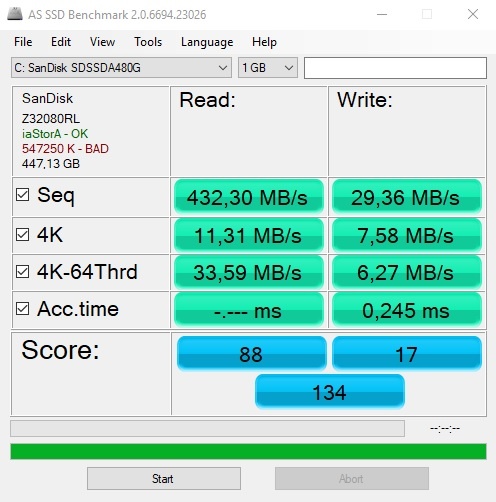

Operacja się powiodła. Partycja wydaje się być wyrównana. Poprawił się też wynik testu:

Ale... dysk nadal działa wolno. Zarówno w FC, jak i podczas kopiowania plików. Już nie mam pojęcia, o co chodzi.

-

Udało mi się zmusić do działania EaseUS Partition Master. Trzeba było zrobić specjalny plik, bo nie chciał ruszyć proces po restarcie. Na razie, przez ponad godzinę zrobił 3/4, już niedługo się okaże, czy to pomoże (oraz, czy system wstanie

).

).

-

1 minutę temu, RomekAstrobaza napisał:

Paragon Alignment Tool a ten dziala?

Nie jest darmowy

-

Polecicie jakiś dobry i darmowy program do wyrównywania dysku? Jak na razie, albo znajduję tylko "pozornie" darmowe, albo nie działają.

-

6 minut temu, RomekAstrobaza napisał:

obstawiam, ze tutaj jest problem - tak na 90%

Pytanie tylko, dlaczego na początku było dobrze. Wydaje mi się, że do win10 zaktualizowałem praktycznie od razu po zakupie kompa, a więc to powinno od początku występować. Zresztą nie wydaje mi się, żeby windows podczas aktualizacji potrafił zmienić to wyrównanie - musiałby wywalić chyba wszystkie dane i na nowo formatować.

-

1 minutę temu, RomekAstrobaza napisał:

Offsen/Aligment @4K Cluster - tak z angielska mi odpowiedzialo jak najechalem na ten napis;)

Hmm, czyli to jest to samo, co wyczytałem z programu SanDiska - że nie ma wyrównania sektorów. Czy to może być przyczyna? Czytałem, że nowe windowsy powinny same o to dbać przy instalacji. U mnie system instalował sklep (win7), robiłem upgrade do 10. Możliwe, żeby to zepsuło wyrównanie?

-

18 minut temu, RomekAstrobaza napisał:

w moim programi jest taki dostep do smart jak na zdjeciu

Ślepy jestem, znalazłem:

Widzisz tu coś niepokojącego? Ja nie bardzo.

-

2 minuty temu, RomekAstrobaza napisał:

zle sie wyrazilem - chodzilo mi o przejrzenie logow ze smarta wlasnie w programie od dysku.

tak z ciekawosci zrobilem test dysky a ja mam SATA2 i wypadl rzeczywiscie duzo lepiej

W tym programie nie widzę nic ponad odpalenie testu, żadnych logów.

No właśnie, u Ciebie wyszło normalnie. Ale jedna rzecz mnie zastanawia i to może być trop - u Ciebie w tym okienku pod nazwą dysku są dwa zielone napisy z OK. U mnie jest jeden zielony, a drugi czerwony - BAD. Ktoś wie, co to oznacza?

Jest jedna rzecz, która mnie zastanawia. W programie SanDiska jest informacja, że dysk nie jest wyrównany do 4k. Czytałem, że to może pogarszać wydajność, ale podobno max 2x. Czyli to raczej nie to. Ale i tak dziwne, że nie ma tego wyrównania.

8 minut temu, WielkiAtraktor napisał:ale może pomóc operacja zwana TRIM

Wykonałem tą operację z poziomu programu producenta - zajęło to kilka sekund, co jest chyba dziwne. Efektów brak.

9 minut temu, WielkiAtraktor napisał:okazało się, że dostęp do NTFS nie wyrabiał przy dziesiątkach tysięcy plików

Ale nie wyrabiał, jak chciałeś użyć tych konkretnie plików, a nie że one sobie były, a ty chciałeś skopiować coś innego i tamte pliki powodował spadek wydajności? U mnie aż takiej sieczki nie ma, znacznie więcej plików mam na innych dyskach. Kopiowanie takiej drobnicy jest faktycznie wolne (na każdym kompie), do tego się przyzwyczaiłem akurat

Choć w tym aspekcie zaskoczył mnie linux, który jakoś perfekcyjnie sobie z tym radzi - kopiuje drobnicę jakby to był jeden plik.

Choć w tym aspekcie zaskoczył mnie linux, który jakoś perfekcyjnie sobie z tym radzi - kopiuje drobnicę jakby to był jeden plik.

-

1 godzinę temu, Tomek_P napisał:

Dysk ustawiony jest na AHCI czy IDE

Jest AHCI, a nawet nie ma dostępnej innej opcji do wyboru.

-

7 minut temu, RomekAstrobaza napisał:

dostan sie do ustawien smart - pewnie tam sa wszystkie bledy i problemy wyswietlone

choc nie wiem dlaczego Cie smart nie ostrzegl, ze jest problem z dyskiem.....

W tym programie od SanDiska jest test SMART - nie wykrył błędów... Co masz na myśli pisząc dostań sie do ustawień smart? Gdzie tego szukać? W samym systemie, czy program potrzebny?

-

Rewelacyjna praca, cudowne i subtelne tło z minimalnym szumkiem - takim, jaki być powinien. Kolory bajka. No fotka jak z bajki

A materiału wcale nie miałeś jakoś za dużo. To z APO100Q?

A materiału wcale nie miałeś jakoś za dużo. To z APO100Q?

RGB robiłeś bez bin? Czy w CMOS bin ma w ogóle jakieś znaczenie i sens? Bo sprzętowo wykonane być nie może przecież.

-

Wrzucam screen z testu. Widać, że jest masakra. Chociaż, jak robiłem ten test na początku (nie mam screena), to seq write było dobre (ok 300), natomiast pozostałe prędkości podobne do tych. No i przy mierzeniu opóźnienia read wywaliło błąd, że nie może się dostać do urządzenia (przy tej wcześniejszej próbie tego nie było, a czas był podobny, jak dla zapisu). No i podczas testu 4k zapisu menedżer windows pokazywał średni czas dostępu rzędu 30 sekund! Nie ogarniam nawet, skąd on to wziął, ale coś musi być nie tak.

-

3 godziny temu, sidiouss napisał:

Czy dostałeś i masz zainstalowane oprogramowanie producenta do tego dysku?

Jeśli tak, to:

- sprawdź czy nie jest dostępne nowsze oprogramowanie do tego dysku

- wykonaj dostępne z poziomu oprogramowania testy wydajnościowe

- przejrzyj ustawienia optymalizacji pracy Windowsa względem tego dysku (może Windows coś nadpisał).

Ustawienia optymalizacji i sprawdzanie błędów windows nic nie zmienia/nic nie znajduje. Do dysku nic nie dostałem, ale pobrałem teraz program od Sandiska - SSD Dashboard. Generalnie twierdzi, że firmware jest aktualny, a dysk jest nowy w 99%. Testów wydajności tutaj nie ma.

2 godziny temu, kjacek napisał:CHKDSK C: /F /R /X

Skończył sprawdzać i chyba niczego nie znalazł (wszystko ok wg niego).

48 minut temu, Tomek_P napisał:Dysk ustawiony jest na AHCI czy IDE. Choć to laptop więc pewnie stosunkowo młody podejrzewam że bios sam ustawił na AHCI sam kiedyś po blue screenie bios sam mi przestawił więc to może być to. Polecałbym też diagnostykę jakimś programem SanDiska może po prostu wiekowo nie wyrabia, każdy dysk SSD ma jakąś bezpieczną ilość zapisów którą może przetrwać więc jeśli przez większość czasu był niemal cały zajęty to każdy zapis wypadał dokłądnie w tym samym miejscu. Z tego samego powodu nie polecam defragmentacji to ciągłe przepisywanie zawartości dysku, pomijając już fakt że ze względu na dużą ilość lini dostępowych mało wydajne.

Raczej na pewno AHCI, bo bym nie osiągał nigdy prędkości rzędu 300MB, ale zaraz sprawdzę. Laptop to Lenovo x230, raczej nowoczesny (SATA3 jest). Kupiony jako używka rok temu, ale dysk jest nówka (ma rok). Generalnie z laptopa korzystam bardzo mało, przez większość czasu leży na półce. Był faktycznie długi czas zawalony w ponad 90%, ale jak mówię, bardzo mało z niego wtedy korzystałem. Teraz zwolniłem większość miejsca, nic to nie poprawiło w wydajności.

Defragmentacji w windows się nie da nawet wykonać (sam wie, że to SSD). Zresztą, od czasów win7 ta defragmentacja na HDD jakoś się sama robiła i zawsze twierdził, że jest 0% pofragmentowany. Pamiętam piękne czasy, gdy na XP odpalałem defragmentację, rysował taki piękny obrazek, gdzie było widać, jak pliki są porozwalane i faktycznie coś z tym robił

opinie o statywach

w Dyskusje o sprzęcie

Opublikowano

Moim zdaniem nie ma sensu wydawać więcej kasy, ani targać niczego cięższego, niż zwykł, stalowy statyw 2". W NEQ6 chyba ostatnią rzeczą, jaką bym uznał za słabą był statyw. Wszystko się gnie - tuba, dovetail, itp, ale taki statyw nigdy.