-

Postów

684 -

Dołączył

-

Ostatnia wizyta

-

Wygrane w rankingu

2

Typ zawartości

Profile

Forum

Blogi

Wydarzenia

Galeria

Pliki

Sklep

Articles

Market

Community Map

Odpowiedzi opublikowane przez Przemek Majewski

-

-

2 godziny temu, komprez napisał:

Napisz na support ZWO że masz taki problem i czy są w stanie wysłać Ci firmware do wgrania lub aktualizacji. Podejrzewam że pewnie zleją temat i trzeba wysłać do nich więc to się nie opłaca jeśli kupiłeś kamere w PL to ślij na gwarancję tutaj nawet bez zastanowienia bo to naprawdę strata czasu - uwierz mi

hmm, ciekawe rozumowanie. kupowac na ali, alenie słać bo się nie opłaca, a jak w polskim sklepie to terrozyzowac, bo blisko.

2 godziny temu, komprez napisał:

2 godziny temu, komprez napisał:Kamera ma działać a nie jakieś kombinacje akrobacje ...

co to za typ uwagi? poprzednia Twoja odpowiedz była dużo bardziej rzeczowa.

a jakie mamy info czemu padła? nowa? stara? warunki zewnetrzne, mroz, wilgoc? zasilanie.

czy elektronika tak ot umiera? może Ci z Ali doślą płytę główną?

-

1

1

-

-

Godzinę temu, dobrychemik napisał:

Nie wiem czym sobie zasłużyłem na ironię. Dałem Ci powód do podejrzewania mnie o kpienie sobie? Chyba moimi pomiarami daję jasno do zrozumienia, że analityczne podejście do sprzętu jest mi bliskie. A to o czym piszę lub nie piszę na forum to już jest inna sprawa.

tak. ten cudzysłów sprawił trochę takie wrażenie lekkiego sarkazmu

możliwe, że jestem przerwrażliwoony, ale dlatego zapytałem

-

1

1

-

-

30 minut temu, dobrychemik napisał:

Ciekawy, inspirujący wątek: mam ochotę kupić sobie sztuczną gwiazdę i poeksperymentować ze sprzętem "w zaciszu domowego ogniska" - przy świetle i w cieple

światełko lepiej slabe. z lampki.

no i znowu nie wiem, czy kpisz czy nie. choć wiele mnie to akurat nie obchodzi

na pewno najlatwiej tak porownywac w miare referencyjnie halo miedzy filtrami.

a Ty w ogóle w zimnie coś eksperymentujesz? bo nie widziałem chyba...

-

37 minut temu, Kapitan Cook napisał:

Legendarny Esprit którego wykonanie jest już mniej legendarne

Ten tilter tam jest fabrycznie ?

Ten tilter tam jest fabrycznie ?

fabrycznie. esprit jak udany, to niezly. jednego jednak osobiscie wyekspediowalem z powrotem do dystrybutora.

jak powloki są do kitu, i jest halo wokol gwiazdy, to w domu nic chop nie zrobi.

37 minut temu, Kapitan Cook napisał:Apropos Samyanga to sprawdziłem jego konstrukcję - 11 soczewek w 7 grupach. Teleskopy w budowei optycznej są bardzo proste w porównaniu do obiektywów. 4-5 elementowe obiektywy skończyły się chyba w latach 70. Generalnie jest to zastanawiające, skoro 5 elementowe teleskopy dają idealne pole to co stoi na przeszkodzie aby do takiej konstrukcji dać AF i bagnet pod aparat? Powłoki nanieść to chyba nie problem. W dużych teleobiektywach sprawa się jeszcze bardziej komplikuje. Tam to jest po 20 soczewek w 10-12 grupach. Jakie wady optyczne mogą być nie wyeliminowane w teleskopach dających idealnie płaskie pole a mogące wyjść w dziennej fotografii ?

problem jest w korekcji wad dla roznych odleglosci źródła. obiektyw ma dzialać od 3 metrów do nieskonczonosci np. tu znowu troche trudnosci sie pojawia

https://en.m.wikipedia.org/wiki/Anastigmat

najprostszy, a jeszcze barwy trzeba skorygowac. co ciekawe, trójzwierciadłowy teleskop moze miec wszystko:

- skasowany astygmatyzm, come i sferyczna w najistotniejszym rzedzie

- zerowa aberracje chromatyczną

https://www.telescope-optics.net/paul-baker_telescope.htm

-

tak wyglada tilter celi przedniej w esprit 80. teraz wiedząc ze trzeba ten obraz przesunac w dol mozna to banalnie zrobic "na zywca".

w wo to jest dopiero w linii flt od 91 wzwyż zdaje się. jak to "narychtowac" w samyangu? nie mam pojęcia

-

7 minut temu, Kapitan Cook napisał:

Rozumiem. Natomiast myślę że co nie wyjdzie to i tak będzie to nie do poprawienia ze względu na konstrukcję obiektywu.

Zwykle tak jest. Ale np w duzych refraktorach albo duzych teleskopach lustrzanych wszystko jest regulowane.

Nie tylko można przesuwac wzgledem siebie soczewki, ale takze pochylic cele z przodu, przesuwać korektor etc. Tam naprawdę można wszystko ustawić.

7 minut temu, Kapitan Cook napisał:Dla mnie obiektyw to urządzenie które albo nie działa na leżycie od początku albo działać nigdy nie będzie.

Z prostymi kontrukcjami, sklejonymi itd tak po prostu jest.

7 minut temu, Kapitan Cook napisał:Późniejsze serwisy obiektywów rzadko coś znaczącego poprawiały. Piszę z doświadczenie głównie o autofocusie. O takich rzeczach jak kolimacja to myślę że serwisy nawet nie śniły. Tak jak piszesz, taniej kupić nowy niż stary doprowadzić do idealnego stanu, bo zwyczajnie nikomu oprócz nas i kilku świrów z dziennej fotografii to nie przeszkadza.

Ja z czystej żyłki do gmerania w rzeczach lubię probowac. Dużo rzeczy niestety wlasnie młotek albo nic.

Jednak, akirat kolimacja soczewek wzgledem siebie jest latwa do sprawdzenia i dlatego taki test zasugerowałem -- wyklucza jeden problem. Z trafieniem osią optyczną w srodek matrycy jest juz niestety problem. Paradokslanie w teleskopie zabawka typu Newton mozna to zrobic pochylajac lustro wtorne. W samochodzie lusterka regulowane. A jednak dopieor w duzych APO producenci dają nam tę mozliwosc. Oczywiscid inna sprawa, że tez sporo osob nie umie z tego korzystać...

-

1

1

-

-

1 minutę temu, Kapitan Cook napisał:

Przepraszam ma moje ignoranctwo. Moim zdaniem najprostszy test to niech autor podłączy inny obiektyw i sprawdzi czy są podobne wady. I znowu moim zdaniem na 99% skopana kolimacja obiektywu. Jeśli ktoś to potrafi skolimkować na fest to może zakładać serwis i żyć dostatnio do końca swoich dni.

Kolimacja moze być w porzadku. Kolimacja to słowo wytrych. Serwis to ciężki chleb, w urzadzeniach, ktore nie maja regulacji, niczego nie poprawisz, a w takich które mają, uzytkownik moze i powinien robić to sam. Do tego czas wykwalifikowanej osoby pracujacej z tym najczesciej przekracza koszt obiektyeu. A polski Janusz "chce za stówkę". Już pisanie epopeji za darmo na astropolis i czasem jak grochem o scianę -- jest bolesne :p

To jest kwestia zrozumienia czy wada TEGO OBIEKTYWU bierze sie z tiltu, kolimacji, zlej osi optycznej etc. Tych czynnikow jest wiele. Tak samo jak nie kazda zła gwiazda jest zła z powodu "komy", tak samo "kolimacja" sklada sie z wielu elementów, ktore warto wyszczegolnic.

Test "kólek" sprawdza czy soczewki sa ulozone poprawnie wzgledem siebie w celi. Nic poza tym. Przechylony obiektyw z kolei wlasnie bedzie dawal dodatkowo taki efekt. Kolejne elementy trzeba od siebie oddzielić. Inaczej jest jedna wielka kupa i nie wiadomo co winne.

-

9 minut temu, ASTRF napisał:

to co tu widać to, ze wierzchołek powierzchni ogniskowania (focal surface) jest w gornej czesci kadru. tak jakby obiektyw swiecil swoja wiazką glowną (osią) w górną część matrycy.

w teleskopie typu rc lub newton po prostu pochyliloby sie zwierciadlo wtorne. tu nie ma wiele narzedzi by to poprawic. tylko niektóre apo mają tilt przedniej celi. "apo, ma dzialac od razu bez zarzutu, a nie coś mam kombinowac". i tak to się kończy.

tiltem z tylu tego sie nie załatwi. przyslona tego nie zmieni, ma marginalny wplyw na krzywiznę pola, raczej na ksztalt gwiazd tnąc promienie boczne.

obawiam sie, ze ten problem bedzie poza mozliwą regulacją. zwykle jak przytrafia mi sie taki problem w apochromacie bez tiltu celi z przodu to się poddaje. tak jakby mowiac prosto: na twoim zdjeciu trzeba byloby "przegiac przod obiektywu tak by świecił w dół".

-

17 minut temu, Kapitan Cook napisał:

Ja nie wiem co ma pokazać taki test. Chyba tylko jak będzie wyglądał Bokeh na rogach, gdzie w KAŻDYM obiektywie na pełnej dziurze idealnego koła nie będzie. Jedyny wyjątek jaki znam to Sony stworzyło jakiś specjalny obiektyw gdzie bokeh aż po róg wygląda podobnie jak w centrum. Normalnym też jest że im bardziej przysłonisz obiektyw tym lepiej będą wyglądały robi.

ma pokazać, czy jego (autora) problemy biorą sie ze zlej kolimqcji soczewek w celi (przesuniecia wzgledem siebie), czy z innych problemów.

skoro uważasz, że "rozklad normalny" to są arkana dla ekspertow nie podejrzewam, byś docenil interferometr. ale moze warto posluchać?

-

5 minut temu, ASTRF napisał:

No i tak zrobiłem... Fotki robione na przysłonie f/2.8. Ta sama metoda łączenia, co w pierwszym moim komentarzu...

Jak na moje oko... Widać znaczną poprawę, jeżeli obraz jest przed ogniskiem. Wykonałem jeszcze test, czy przysłona wpływa na "jakość" tej rozogniskowanej gwiazdy, jako iż obraz wyglądał znacznie gorzej kiedy był za ogniskiem, no to właśnie na tym tą przysłone zmieniłem.

Napiszcie co o tym sądzicie : Ptak!

za ogniskiem i przed ogniskiem widac nieco inne zjawiska. Ale to by było dużo gadac. Do sprawdzenia kolimacji wystarczy jedna ze stron, ja preferuje przed.

jak zrobisz to doswiadczenie z jakims filtrem barwnym to interferencja bedzie najwyrazniejsza, i masz taki "domowy interferometr". i bedziesz mial rezultaty takie jak ja wrzucilem w komentarz.

-

3 minuty temu, ASTRF napisał:

No i tak zrobiłem... Fotki robione na przysłonie f/2.8. Ta sama metoda łączenia, co w pierwszym moim komentarzu...

Jak na moje oko... Widać znaczną poprawę, jeżeli obraz jest przed ogniskiem. Wykonałem jeszcze test, czy przysłona wpływa na "jakość" tej rozogniskowanej gwiazdy, jako iż obraz wyglądał znacznie gorzej kiedy był za ogniskiem, no to właśnie na tym tą przysłone zmieniłem.

Napiszcie co o tym sądzicie : PSuper. Przede wszystkim spróbuj podejsc jak nakblizej do ogniska. To wyglada zupelnie normalnie, ale jak poprzednio mowilem, im dalej, tym gorzej widac szczególy.

Zrob tak, żeby gwiazda nie miala wiecej niz 30 pikseli. To wystarczy by widziec wzor interferencyjny. A od razu znacznie bardziej widać niedociagniecia.

Pewnie jak zwykle problem lezy w osi optycznej nie padajacej idealnie na srodek matrycy i w tilcie matrycy.

-

1

1

-

-

Godzinę temu, Marcin7 napisał:

darka zrobie ale pewnie dopiero w sobote bede miał chwilę żeby się tym zająć. . Z góry dzięki za podpowiedzi i wnioski.

zrób bo zarówno bias i stack biasa wyglądają normalnie. te efekty zapewne "rosną" z czasem i konkurują z sygnałem w ciemnych miejscach zdjecia.

poza tym na pytanie o banding paść moze tylko odpowiedź "bo tak jest".

jedyne co mozesz zrobic, to zrozumiec ile tego jest, jak dlugo naświetlać i jaki duży dither dać. czyli co jeszcze można uratować w przyszlych projektach

-

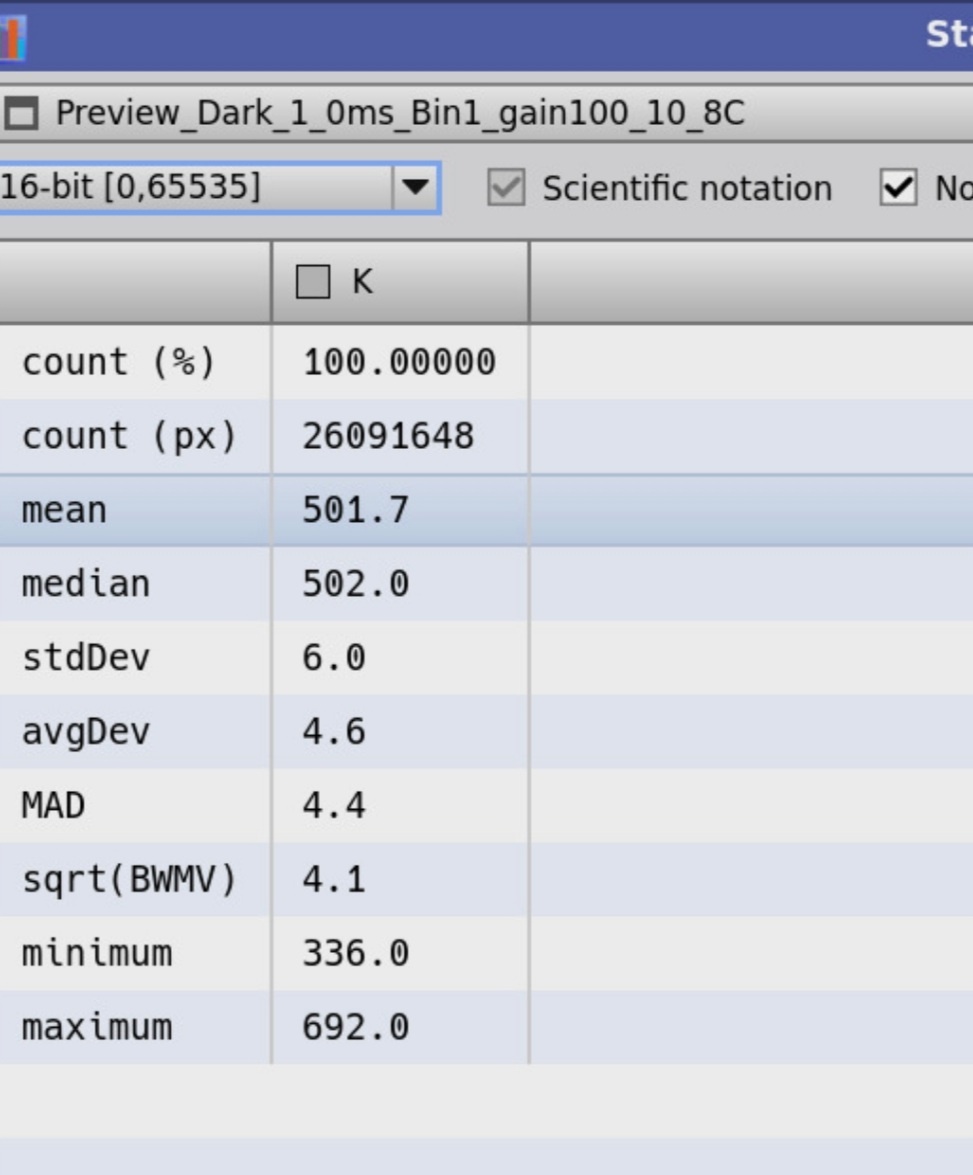

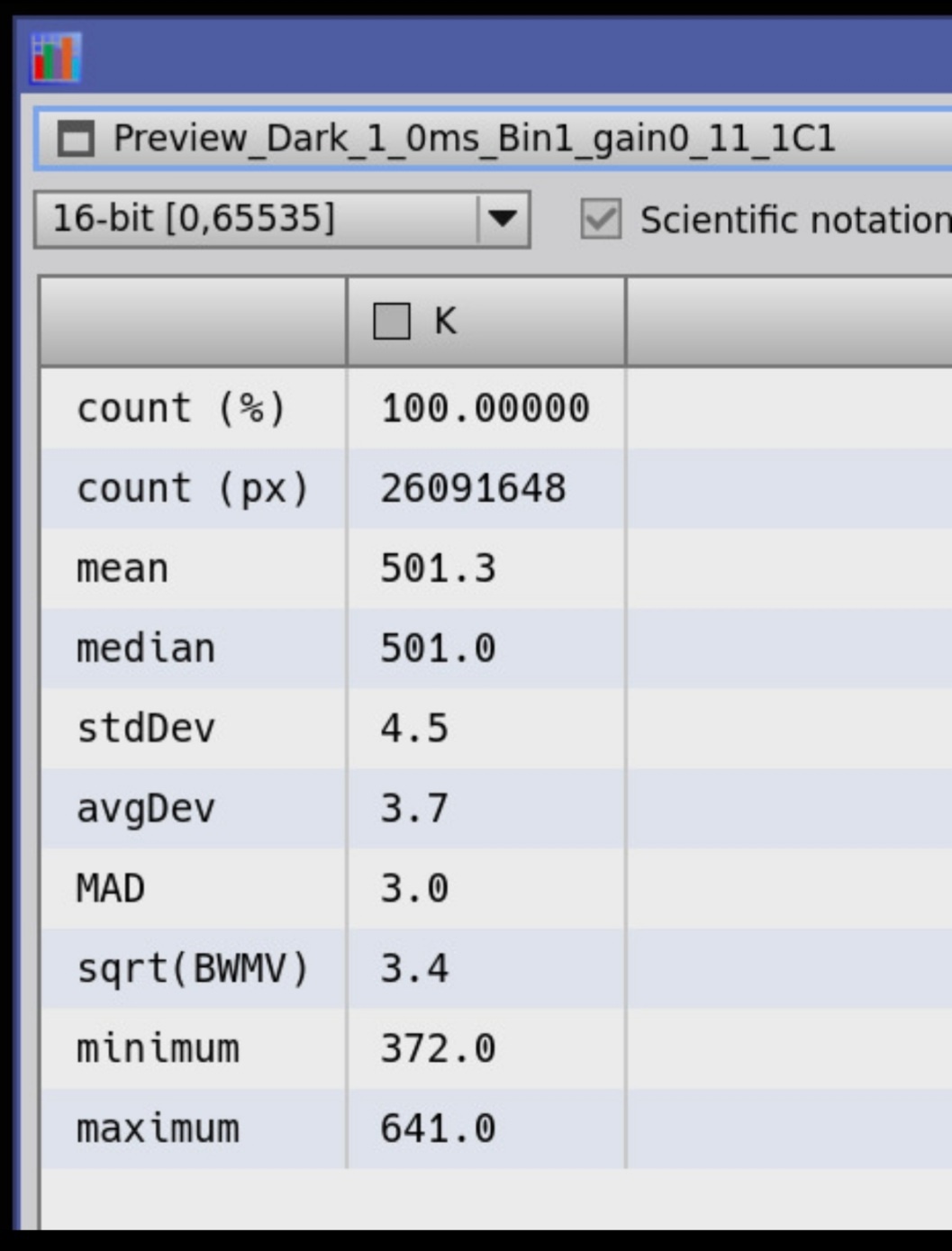

tu masz kilka luźnych przykładów (bez wyjasnienia) jak patrzę na to. ale oczywiscie mozesz pytać.

dark bedzie znacznie ciekawszy niz bias. mediana(bias) w uint16 powie nam ile poziomów bazowo masz dodane do odczytu w lustrzance. Ten bias potraktuj superbiasem i to jest podstawa ustalaniq "zera" w Twoich zdjeciach.

dark dopiero pokaże, co się dzieje na Twojej matrycy. ale jak mowilem. trudniejsze. dlugi czas, ze 600 s i przynajmnjej 20-30 klatek z dobrej ciemnosci (zeby swiatlo nie wpadalo) i rozsadnego chlodu (symulowanie przecietnej nocy).

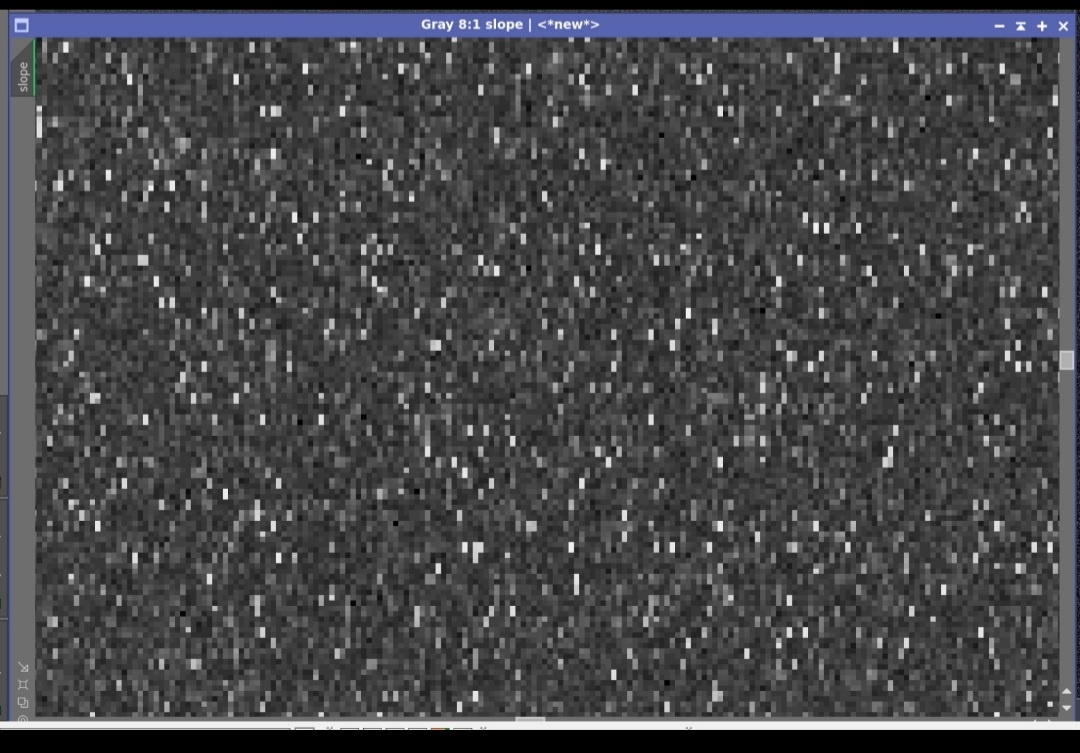

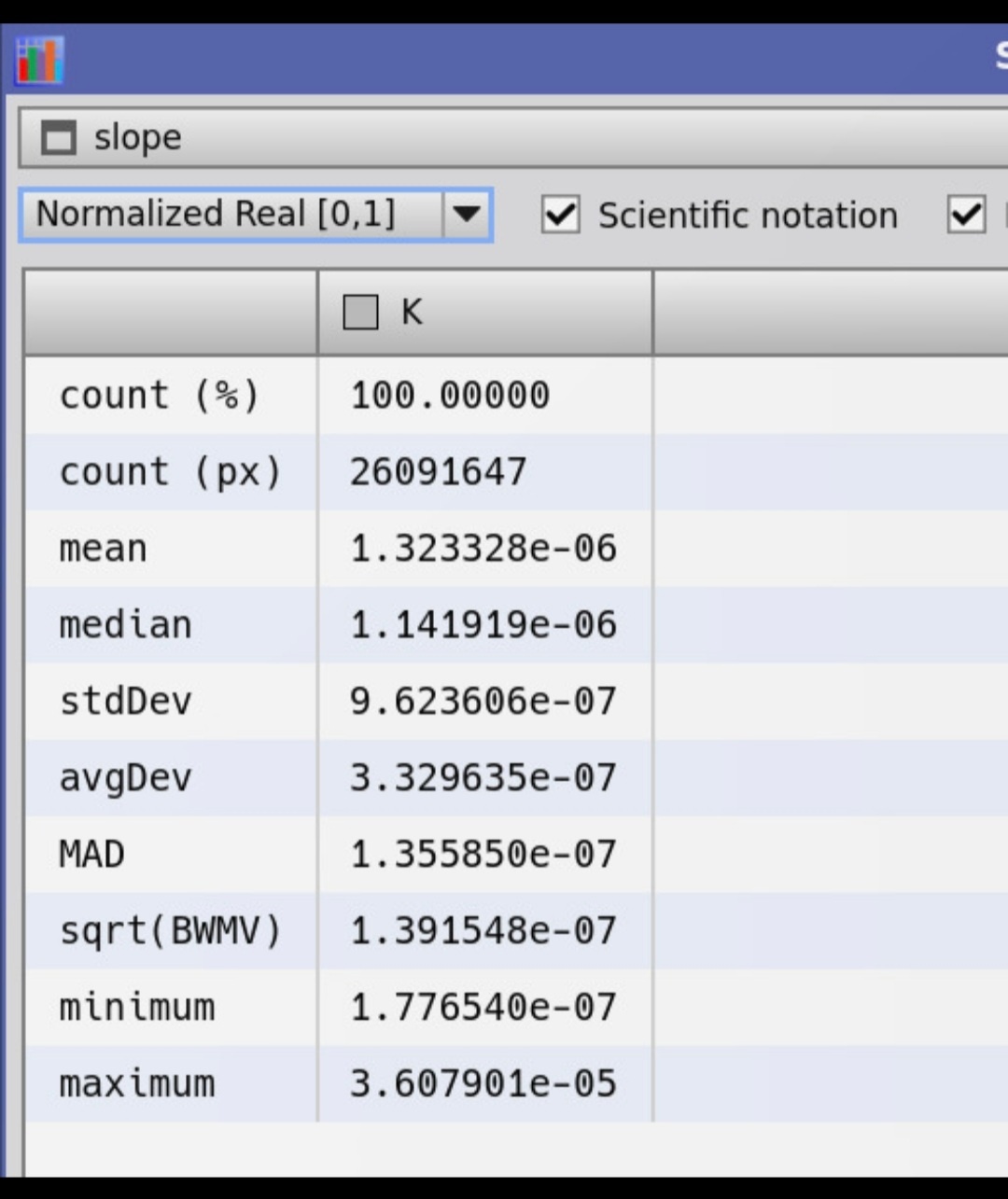

to niczego nie pokazuje. sieka. ale to sa nachylenia odczytow pikseli w stacku 200 biasow

statsy:

mówią, ze to nachylenie jest 1e-6, 0.000001. Zero! to nie sa rysunki, tylko dane, liczby, i tak nalezy je czytac.

ciekawe jest maksimum: 36e-6, sa piksele, które fluktuują 40x bardziej niz srednie. to beda te ktore dadzą hot pixele zapewne.

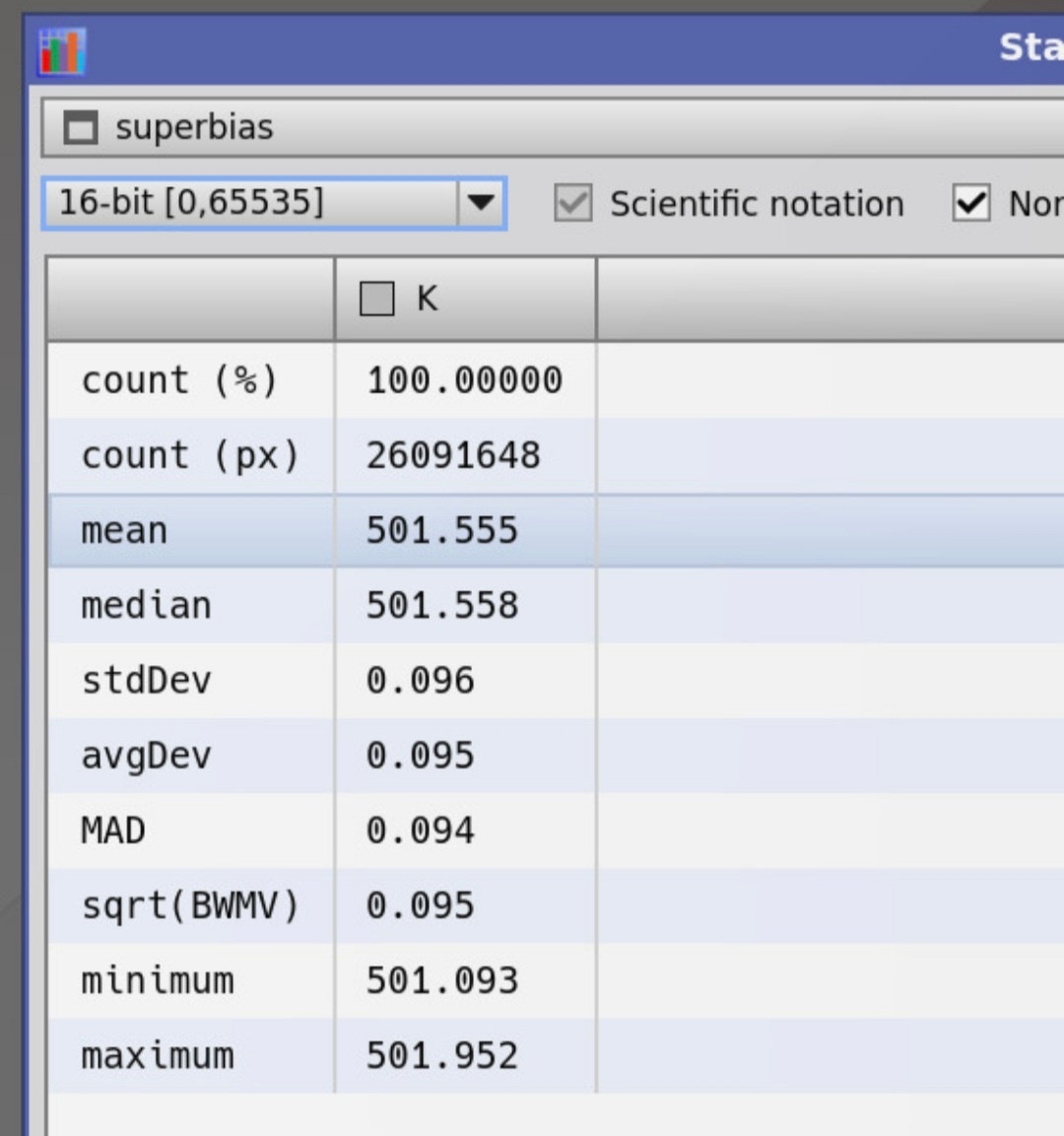

superbias. to tez niczego nie mowi... ale za to statsy:

mówią ze ten plik, superbias = 501.5 DN. czyli mozna go zastapić piedestalem 501 DN.

to takich kilka luznych uwag. nielatwo o tym pisac w komentarzach. jak sobie przejrzysz historie zaczetych przeze mnie watkow to jest kilka luźno zwiazanych z tymi zagadnieniami.

-

2 godziny temu, Marcin7 napisał:

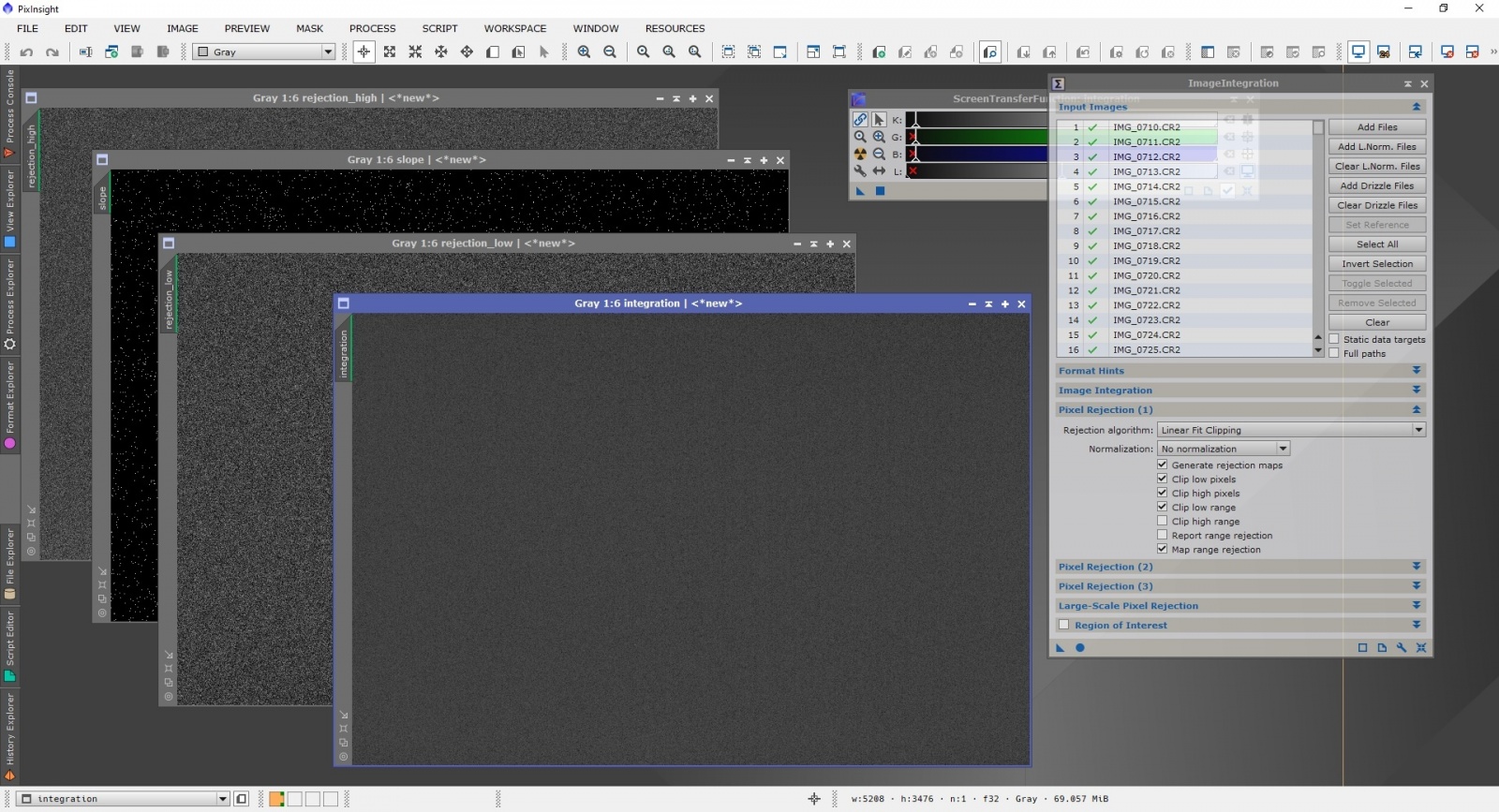

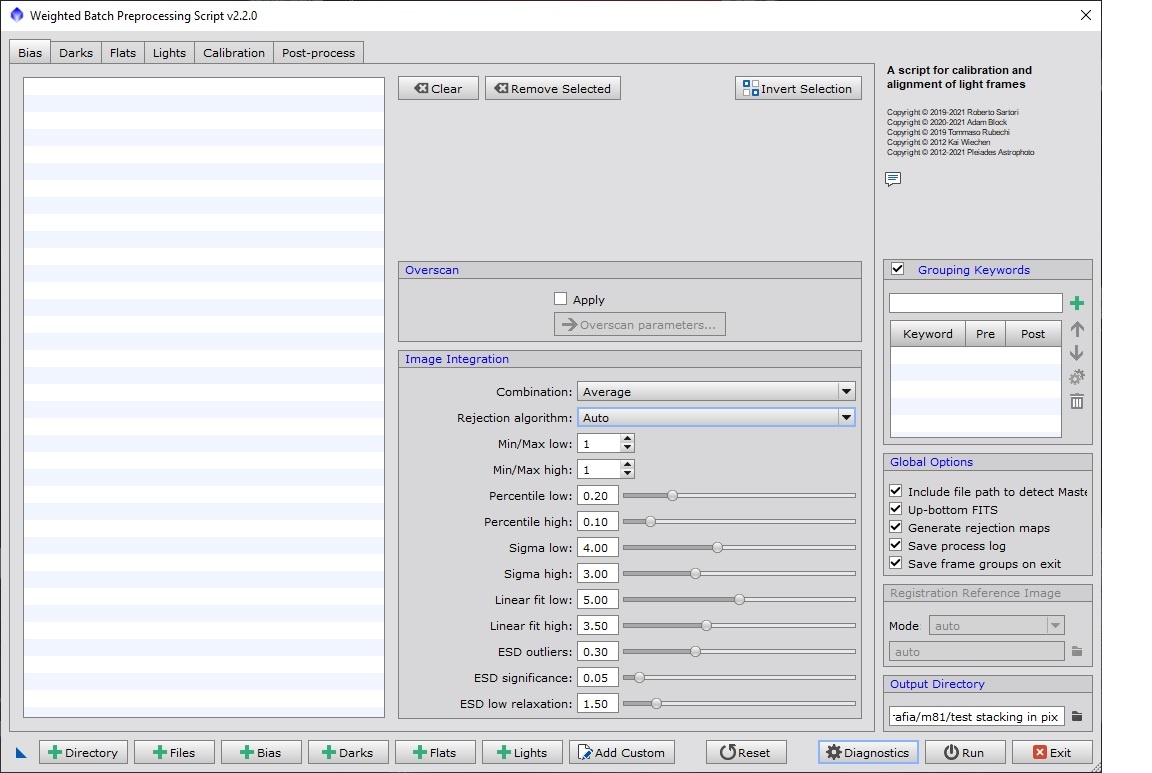

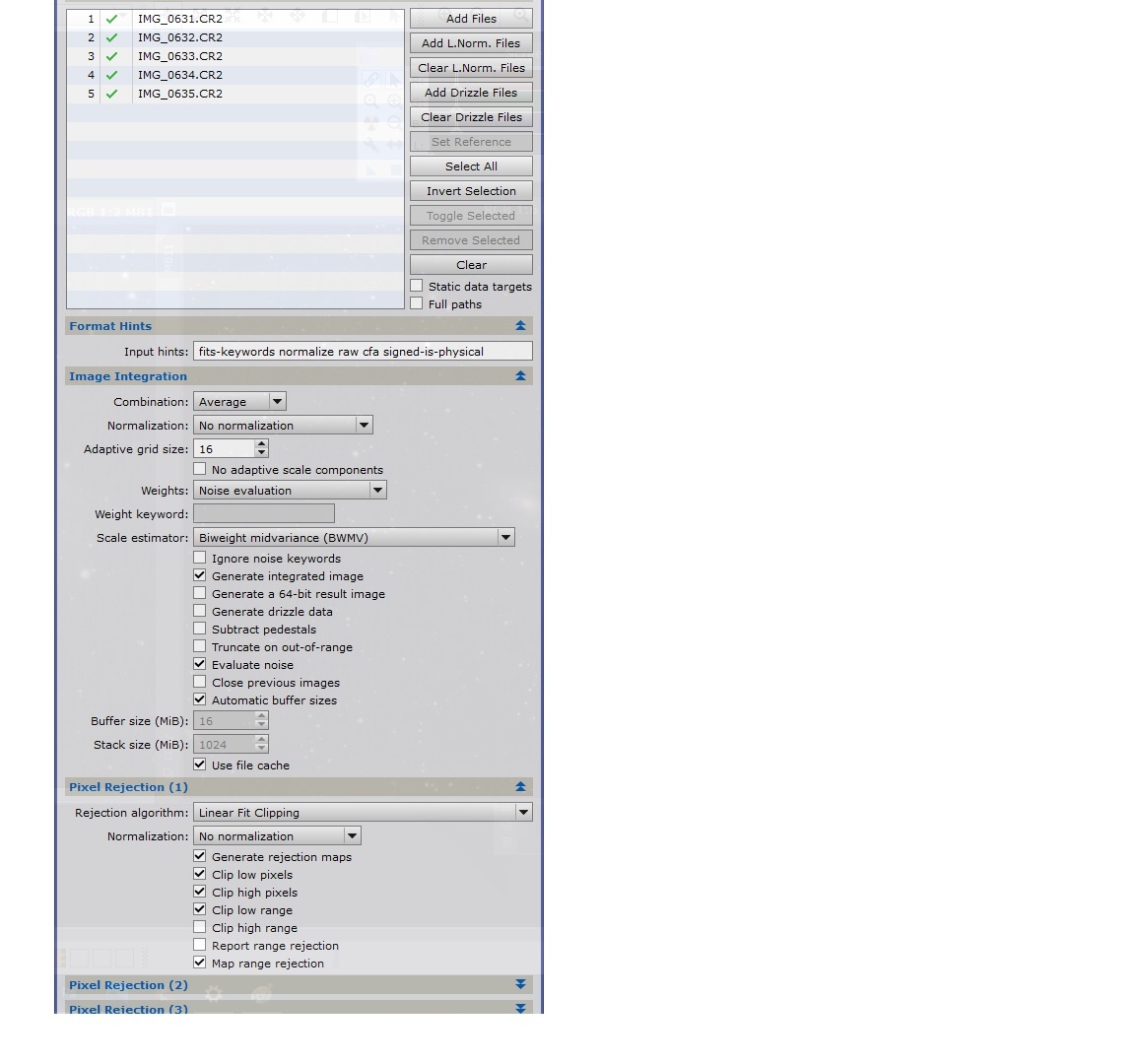

pix wlaśnie przemielił te 220 biasów. ISO 1600. Użyłem ImageProcessora tak jak sugerowałeś. Wyłączyłem ten noise evaluate i ustawiłem "weights" ustawic "Don't care, all weights =1".

Pytanie teraz jak chcesz to zobaczyć bo pix wyrzucił wynik w czterech osobnych oknach. Wszystkie wyglądają tak samo przed stratchem ale po wlaczeniu autostratcha w Screen Transfer Function coś widać. Zrobiłem print screen z czterech ale jakość pewnie nie będzie tutaj za dobra i zastanawiam się czy Ty chciałeś żebym przesłał surowy plik z każdego wyniku jakoś przekonwertowany czy wystarczy print screen z autostretchem poniżej. Jak tego nie zestretchuje to plik po zapisaniu zawsze bedzie taki sam a jak zaczne to stretchować to już ingeruje w wynik i w zależności czego użyje to stretchowania i jak to ustawie to co innego zobaczysz. Daj znać proszę czy to wystarczy jakby co to przerobie i podeśle zgodnie z wytycznymi. dzieki

jeśli użyłeś odrzucania Linear Fit

dostaniesz poza stackiem 3-5 okien. zaleznie od opcji.

1) slope: nachylenie prostej ktora byla w kazdym pikselu dopasowana do stacka (w trzecim wymiarze tak jakby)

2 i 3) rejection high i low. czyli prawe i lewe odrzucone wartosci

Kazde z tych zdjec najlepiej ogladac nie tylko na stretchu ale przy pomocy "Process/Image Inspection/Statistics".

Statystki takich zdjęć zawsze sa bardziej wlasciwe. Jedne warto ogladac w [0,1] a inne w 0..65535. Jak komu wygodnie.

Teraz statystyki tego biasa (z zaznaczonym stdDev i sqrt(BWMV) ) powiedza troche o matrycy.

Co do darka stretch pokaze pewnie juz sporo efektów i moze byc wystarczajacy. Ale zawsze sprawdzić warto medianę, min max etc. Wszystko powoli.

-

3 minuty temu, Marcin7 napisał:

wrzucę dzisiaj tego biasa to zobaczymy. Nie mniej jednak muszę przyznać że wciąż nie daje mi spokoju pytanie które zadałem już kilka razy i na które nikt nie odpowiedział jednoznacznie.

Jak to jest możliwe że wcześniej tym samym sprzętem na ISO 1600 robiłem 2-3 godzinne projekty i tło było bez zarzutu? jedyne różnice to filt L-pro a wcześniej był Lenhance oraz położenie obiektu na niebie ponieważ z Lenhancem raczej robiłem obiekty wysoko nad horyzontem a ten był stosunkowo nisko i może rzeczywiście był bardziej narażony na światło lamp sodowych z którymi filtr sobie nie poradził. Byłbym wdzięczny gdybyś spróbował to wytłumaczyć. Zakłądam też że być może potrzebujesz tych biasów żeby coś wiecej powiedzieć ale i tak czy inaczej zadałem pytanie. dzieki z góry

22 minuty temu, Marcin7 napisał:Hej, zrobiłem te biasy i przymierzam się do złożenia tego w pixie. Przyznam że nigdy nie stackowałem w pixie tylko APP lub DSS. Generalnie nie widzę tu dużego problemu natomiast w odniesieniu do tych opcji stackowania o których piszesz to nie jestem pewny czy dobrze to zrobie. Rozumiem że chodziło Ci o użycie procesu WeightedBarchPreprocessing ale tutaj w opcjach stackowania nie widze wogóle tych ustawien o których wspominasz powyżej tzn average/no normalization/linear fit rejection/no normalization. Jest tylko "avarage". pozostałych nie widze i zastanawiam się czy nie chodziło Ci o process "ImageIntegration" bo tam są podobne ustawienia o których wspominasz powyżej. Daj proszę znać to puszcze to i za chwile wrzuce wynik. dzięki

Myślałem o procesie "Image Integration". Oczywiście możesz użyć WBPP, ale jak coś badam to zwykle robie to w osobnuch krokach. Wynik podobny, choc masz wiecej możliwości w opcji solo niż WBPP.

Wazne by w "weights" ustawic "Don't care, all weights =1". To dosc logiczne, statystycznie kazdy bias/dark są sobie rowne i nie trzeba ewaluowac ich jakosci. Tym bardziej "noise evaluation" odradzam kazdemu. Można też odznaczyć "evaluate noise", oszczedzi sie troche czasu. Zawsze mozna to zrobić skryptem (ImageAnalysis|NoiseEval).

Co do pytania o to co się zmieniło? Pewnie przypadek i wysokosc na horyzoncie. Poza tym filtr coraz ciemniejszy to widać coraz wiecej matrycy a coraz mniej light pollution.

-

1 godzinę temu, szuu napisał:

pomijając kwestię szumu, twój test jest nieprawidłowy bo również w nierealistycznym przypadku z idealnym stałym sygnałem LP musi on pogarszać obraz wynikowy przez to że zjada pewną część pojemności piksela, a więc na użyteczny obraz zostaje mniej "bitów".

to mozna łatwo zasymulowac. jak dodasz jakiś gradient z szumem, to czesc pikseli sie przeswietli po prostu (te ktore przekrocza próg). a na szczęście sam szum odczytu nie zależy od saturacji piksela. ja tak np symuluje zdjecie x4, zeby zobaczyc 4x dluzszy czas. jedynie co trzeba zrobic to odjac offset by skalibrować poziom 0 odpowiednio.

-

23 minuty temu, Kapitan Cook napisał:

Oczywiście, tylko że same podstawy są kompletnie nie zrozumiałe dla przeciętnego człowieka. Chodzi choćby o same pojęcia typu rozkład gaussa gdzie w normalnym życiu nikt ani o tym nie wie ani bym bardziej nie rozumie.

ponieważ rozklad Gaussa jest tym granicznym rozkladem w Centralnym Twierdzeniu Granicznym, występuje on w przyrodzie praktycznie wszedzie, gdzie wiele czynnikow ma wplyw na jedno zjawisko. (jest granica sredniej dowolnych zjawisk losowych)

Sama nazwa "rozkład normalny" wskazuje na jego centralne znaczenie w zyciu i statystyce.

Jest to zatem najbardziej podstawowy element statyski. Każdy średnio wyksztalcony czlowiek powinien wiedziec, co to średnia, odchylenie standardowe, i rozklad normalny. Jeśli nie wie, to jest to porażka całego systemu. Zwykle wie, ale nie wie, że to sie tak nazywa. A krzywą dzwonową widział dosłownie każdy.

-

2 minuty temu, Kapitan Cook napisał:

Wniosek jest prosty. Idę na kasę do Biedronki. Inżynierem nie zostanę

no nie wiem. wystarczy się troche otworzyć na to, a nie mówić, że sie nie lubi. ja chcialbym chociaż trochę ciekawostek "odczarować".

co do glownego watku: kiedy w grę wchodzą szersze kadry powyzej stopnia, dwóch, na zdjęciu pojawia sie już gradient tego tla. nie jest ono stałe. estymacja tego gradientu poprawnie jest kolejną trudnoscią. ponadto, ten gradient zmienia sie z polozeniem na niebie. Bo LP jest nieruchome, obiekt fotografowany po niebie "sie porusza" (pozornie).

to właśnie robi Normalize Scale Gradient, nowy skrypt w Pixie.

-

No.i zapomniałem dodać...

QE=1 i QE = 0 są naturalne, skrajne przypadki idealne, nielosowe. Ale ciekawe jest, ze ten "szum" występuje oczywiscie niezależnie od szumu odczytu, ktory się do niego "dodaje" (nie przez dzialanie +, a raczej wariancja szumu calkowitego jest sumą wariancji z rozkladu dwumianowego i wariancji odczytu piksela)

-

3 godziny temu, Kapitan Cook napisał:

Nie rozumiem skąd przy LP ma być dodatkowy szum . Przecież samo LP też będzie emitowało fotony które trafią na matrycę. Nie da się prościej wytłumaczyć tego o czym mówicie ?

Wpadłem za to na pomysł aby symulować LP w taki sposób że oświetlę lampką kartkę z tekstem a drugą lampkę skieruję w obiektyw tak aby nie było flary ale aby kontrast zmalał.

Będzie trzeba popróbować eksperymentalnie co i jak ustawić, ale powinno dać jakieś ciekawe wyniki.

Mialem o tym napisać dluzszy post, "ale pewnie byś go nie lubił".

Piksel (kazdy osobno), który ma pewne QE (prawdopobienstwo rejestracji), dostaje N fotonów. Średnio zarejestruje QE*N. Ale to nie koniec historii. Ile razy sie pomyli?

Wykonał N niezależnych prób Bernoulliego z sukcesem QE. Wlasciwym bedzie rozkład dwumianowy. Dla niego

Wariancja(QE, N) = N*QE*(1-QE). (€)

Odchylenie jest pierwiastkiem z tej wartosci. W pierwszym rzędzie hest proporcjonalne do pierwiastek(N).

Warto zauważyc, że wzor (€) daje zero zarówno dla QE = 0, jak i QE= 1. Jest bowiem symetria "sukces <-> porazka".

Maksimum (€) jest dla QE = 50% i wynosi

Wariancja(50%, N) = N/4,

a co za tym idzie, bład wynosi 0.5*sqrt(N).

Dla typowego 80% = 4/5

Wariancja(80%, N) = N*4/25,

Zatem w tej sytuacji błąd w funkcji strumienia fotonow N wynosi 0.4*sqrt(N). Ten błąd jest owym szumem, wynikiem wielu losowych doświadczeń przeprowadzonych przez każdy piksel sensora.

Ponadto, te procesy są splecione z sąsiednimi pikselami przez efekty bluru: seeingu, optyki, prowadzenia oraz dyfrakcji na aperturze.

Dlatego lepiej albo polubić, albo nie symulować.

Ps.1 dla zainteresowanych

Pojawia się kolejny problem, gdyz nie znamy N. Znamy tylko estymator QE*N, czyli średnio zarejestrowanych fotonów. Aby więc oszacować poprawnie wariancję naszych estymatorów trzeba wykonać nawet wiecej nielubiqnych operacji myślowych. Nie mierzymy bowiem QE*N na matrycy idealnie, tylko wlasnie z powyższym bledem. Nigdy wiec nie mamy pewnosci jakie N. Co innego, rzecz jasna, gdybysmy z gory mieli pewnosc, ile fotonow dotarlo. Ale w zyciu tak nie ma. [Podobnie dla próbki ze statystyki normalnej, zmierzona średnia nie jest idealną, zatem wariancje estymujemy dzieląc przez (N-1) a nie N. W dodatku prowadzi to do rozkladu t-studenta gdy chcemy progów ufnosci. Gdybyśmy średnią znali dokładnie, byloby latwiej i też mniej ciekawie.]

Ps.2

Uwaga do @Behlur_Olderys, nie kazdy proces losowy jest gaussowski!

A w zasadzie... tylko gaussowski, jest gaussowski. W tym wypadku (dwumianowy, wysokie QE) histogram błędu jest raczej niesymetryczny, i sięga bardziej w dół, co powoduje, dlaczego domyślnie przy odrzucaniu lowReject jest wiekszy niz highReject. Tzn high odrzuca szybciej niz low.

A w zasadzie... tylko gaussowski, jest gaussowski. W tym wypadku (dwumianowy, wysokie QE) histogram błędu jest raczej niesymetryczny, i sięga bardziej w dół, co powoduje, dlaczego domyślnie przy odrzucaniu lowReject jest wiekszy niz highReject. Tzn high odrzuca szybciej niz low.

-

1

1

-

1

1

-

-

Super sprawa @Tuvoc!

Co do azotu, przypominam sobie słynne foto z Hubble ST, Mgławica Bąbel w NHO:

https://hubblesite.org/contents/media/images/2016/13/3725-Image.html

wtedy chyba po raz pierwszy zaczałem się zastanawiać nad azotem

-

2

2

-

-

3 godziny temu, Bioslasher napisał:

Dobrze powiedziane

dużo ludzi narzeka na cloudynights na ten sensor Sony. Powyżej 600s zaczynają się problemy, jest on niestabilny i czasami ciężko go usunąć. Dlatego zbieram teraz 100 Darków, i mam nadzieję że dzięki temu uporam się z nim całkowicie.

dużo ludzi narzeka na cloudynights na ten sensor Sony. Powyżej 600s zaczynają się problemy, jest on niestabilny i czasami ciężko go usunąć. Dlatego zbieram teraz 100 Darków, i mam nadzieję że dzięki temu uporam się z nim całkowicie.

tak. zwykle mówię, że podstawowy kwalitet sensora to niski amp glow. Jak w przypadku 2600, 533, 6200, 2400. Gdy mozna sobie zupelnie darować darki i korzystac tylko z piedestału/superBiasa.

W temacie o chlodzeniu probowałem pokazać "ile" jest tego szumu termalnego, i już w chłodzonych urządzeniach jest on absolutnie znikomy, istotny dopiero gdybyśmy chcieli produkować naukowo kalibrowane dane. (ale i wtedy można schlodzić jeszcze ciut nizej)

zupełnie inna historia to amp glow... w wypadku chlodzonych kamer darki są wlasnie po to, by usuwać amp glow, a bywa on potworny. Jest tu dużo nieporozumień w dziedzinie, bo i mój post o chlodzeniu nie był dobrze zrozumiany. wzbudzał dziwne kontrowersje jakobym mówił "nie chlodzić". a nie co glebszego można wywnioskować z tego.

-

1 minutę temu, Tayson napisał:

oczywiscie mozna z tym walczyc podczas obróbki, ale nie o to w tym chodzi.

tak

1 minutę temu, Tayson napisał:materiał surowy nie powinien miec takich wad.

tak x2

-

2 minuty temu, Kapitan Cook napisał:

@Przemek Majewski a czy dss zrobi sam te wszytskie operacje jak wegram do niego lighty,biasy, flaty ? Czy sam muszę muszę odejmować od flatów bias i potem taki wyczyszczony dać do programu ? Pytam się bo ja serio nie widzę żadnej różnicy na korzyść dawania biasów wręcz przeciwnie. Ilość szumu jest taka sama, natomiast wyrównując ogólną jasność kadru w stacku gdzie był dany bias światła będą przepalone a rogi zdjęcia ściemnione. Obróbka taka sama.

Tak, każdy program do stackowania umie to zrobić sam. Jesli jest bias, to odejmuje go od wszystkich plikow (darkow tez) albo ma wyraźne opcje do tego.

Co ważne, biasy można zastąpic darkiem, który też w sobie bias zawiera, ale biasy znacznie prościej zrobic. To kosztuje 3 minuty. Dzięki nim, jak wiele razy pokazywałem statystykami, wiadomo jaki poziom sygnału to zero. Zero nie jest w "zerze". Wynosi np 500/65536 poziomów, a u niektorych nawet 4000...

Nie można kalibrować światła flatami kiedy ten offset jest dodany. To po prostu bład. Tak samo trzeba ten offset zdjąć z masterFlata (chociaż).

Nie można kalibrować światła flatami kiedy ten offset jest dodany. To po prostu bład. Tak samo trzeba ten offset zdjąć z masterFlata (chociaż).

Biasy można czesto zastąpić zwyczajnie piedestalem (stałą), ktora, jak nietrudno zauwazyć ma "zerowy szum". Także biasy zrobione ze 100-200 klatek sa bardzo gładkie i maja naprawdę najmniej szumu. Trzeba robić naprawdę dobre lighty by taki bias miał coś zepsuć. Reasumując, strasznie łatwo takie biasy po prostu zrobic. Poza tym pokazują wprost szum odczytu. (pierwszy moj link)

A później obejrzyj sobie co jest tu:

Przeszczep CCD sensor

w Dyskusje o sprzęcie

Opublikowano

No jasne. Ale nie jak ktoś ze swojej starej ubionej 533MC 11x11 mm przełoży do nowej 533MC....

Chyba masz ostatnio jakis zły okres. (porównanie z tzw. d**py)

Raczej porówanie takie: to jak przełożyć brylant 0.5 karata ze starego pierscionka wytartego, porysowanego do nowej biżuterii, a starą przetopić. Tam będzie lśnił na nowo.

Sensory raczej sie nie psują i nie są też wiele lepsze (w przeciwieństwie do silników), oferta zapewne tyczy sie glównie sensorów typu 36 x 36 mm lub 47 mm x 47 mm, ktorych koszt w stosunku do obudowy jest taki jak tego brylantu do obrączki. Usługa ma zapewne jednostkowy koszt, gdyż jest wykonywana raz dla sensora, zas nowy sensor ma cenę proporcjonalną do powierzchni, bo jest "cięty z metra" w ogromnej i prężnej linii produkcyjnej.

Pozostaje więc kwestia od jakiej wielkości sensora koszt takiej usługi bedzie opłacalny w stosunku do jednostki z linii produkcyjnej.