-

Postów

1 267 -

Dołączył

-

Ostatnia wizyta

-

Wygrane w rankingu

1

Typ zawartości

Profile

Forum

Blogi

Wydarzenia

Galeria

Pliki

Sklep

Articles

Market

Community Map

Treść opublikowana przez rambro

-

Czy macie jakieś sposoby lub linki do tutoriali na łączenie RGB z materiałem z filtru DUO band ?. Poniżej pierwsza próba z M27. 1,2h RGB (brak Księżyca) + 4.5h Optolong l-eNhanced (Księżyc 95%). Jeszcze nie za bardzo potrafię posługiwać się programem graficznym typu PS (Affinity photo). Będę wdzięczny za wszelkie uwag, co można w zdjęciu poprawić. Przypuszczam, że oddzielna obróbka mgławicy i gwiazd dużo by pomogła.

- 3 odpowiedzi

-

- 14

-

-

Czy robiłeś test tego SVBony UV/IR ?. Mam taki i nie wiem czy warto kupić Baadera lub Optolonga.

-

Owszem. Im większa światłosiła tym światło pada pod większym kątem. Do f3.5 efekt nie przeszkadza. Do szybszych instrumentów producenci optymalizują filtry poprzez przesunięcie pasma , trochę kosztem transmisji. Problem dotyczy wąskopasmowych filtrów. Poczytaj tutaj (od strony 25) http://www.aicccd.com/archive/aic2007/Goldman-AIC2007Talk2.pdf

-

ZWO ASI 294 MC Pro problem z odbiciami

rambro odpowiedział(a) na Grzegorz Czernecki temat w Dyskusje o astrofotografii

Tylko potrzebujesz 2" lub co najmniej 36mm aby nie było winiety z sensorem 4/3. Ten na foto wygląda na 1.25". Zmierz ile ma mm. -

ZWO ASI 294 MC Pro problem z odbiciami

rambro odpowiedział(a) na Grzegorz Czernecki temat w Dyskusje o astrofotografii

A co z filtrem IR/UV cut ?. Stosowałeś ?. W refraktorze niezależnie od tych odbić to konieczność. -

ZWO ASI 294 MC Pro problem z odbiciami

rambro odpowiedział(a) na Grzegorz Czernecki temat w Dyskusje o astrofotografii

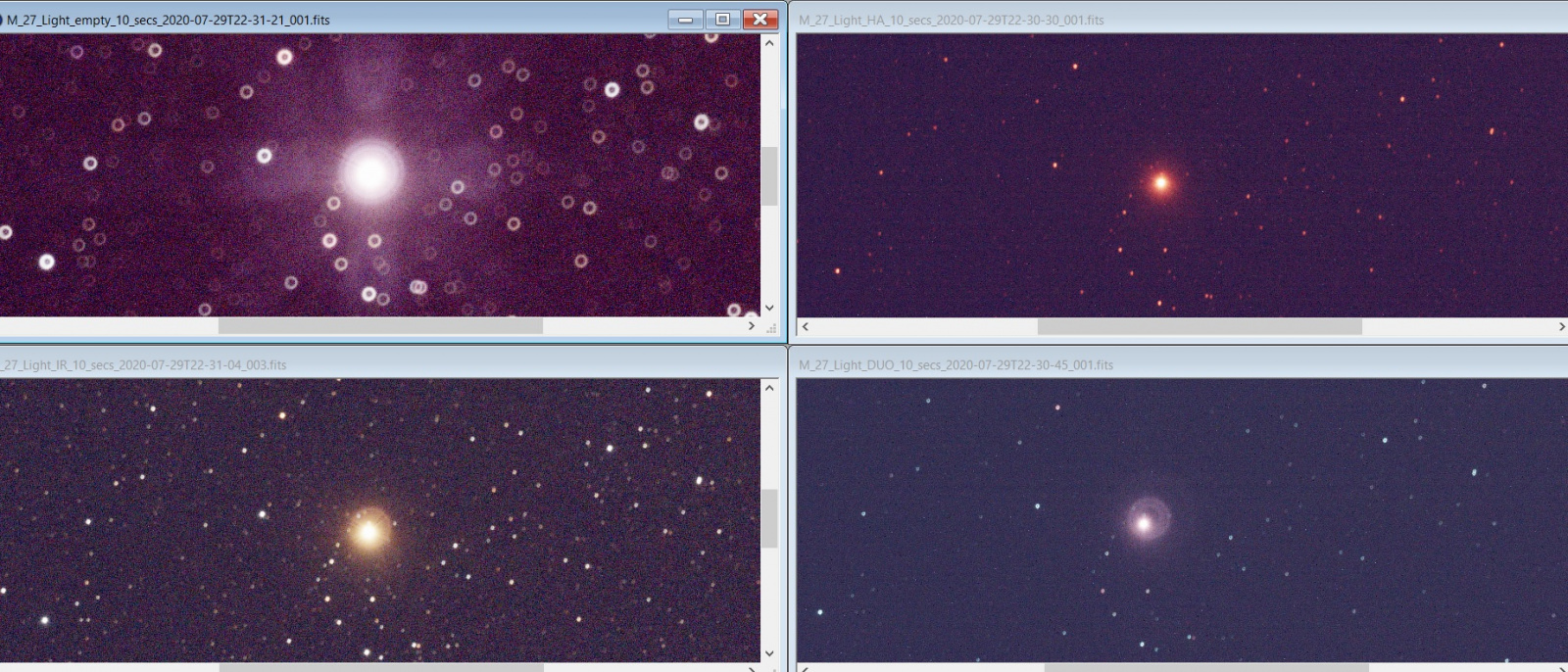

Wczoraj na koniec sesji na szybko zrobiłem poniższy test na gwieździe Erakis. Przepraszam za jakość, brak ustawionej ostrości na każdym filtrze i inne mankamenty. Robiłem ekspozycje przez dziurę w chmurach i za chwile już całe niebo było zakryte. Nie mam wpisanych offsetów pomiędzy filtrami, więc ostrość była tylko na Ha. Zdjęcie u góry po lewej jest bez żadnego filtra, a po prawej z filtrem Ha. Po lewej na dole z filtrem IR cut, a po prawej z l-eNhanced. Widoczne są różne halo ale to wielkie gwieździste halo jest tylko przy braku filtra. Na innych nawet po mocnym screen stretch nie widzę tych ośmiu ramion. Dla ASI294MC PRO wygląda na to, że problem głównie dotyczy ekspozycji bez blokady pasma IR. -

ZWO ASI 294 MC Pro problem z odbiciami

rambro odpowiedział(a) na Grzegorz Czernecki temat w Dyskusje o astrofotografii

@Grzegorz Czernecki używałeś filtra IR cut wykonując to zdjęcie ?. ASI294 MC PRO ma tylko szybkę AR. Ja ten efekt zaobserwowałem tylko raz podczas jakiś technicznych ekspozycji (plate solve, ostrzenie etc). Generalnie używam filtra IR cut ale na początku po zakupie kamery przez chwilę go nie posiadałem. -

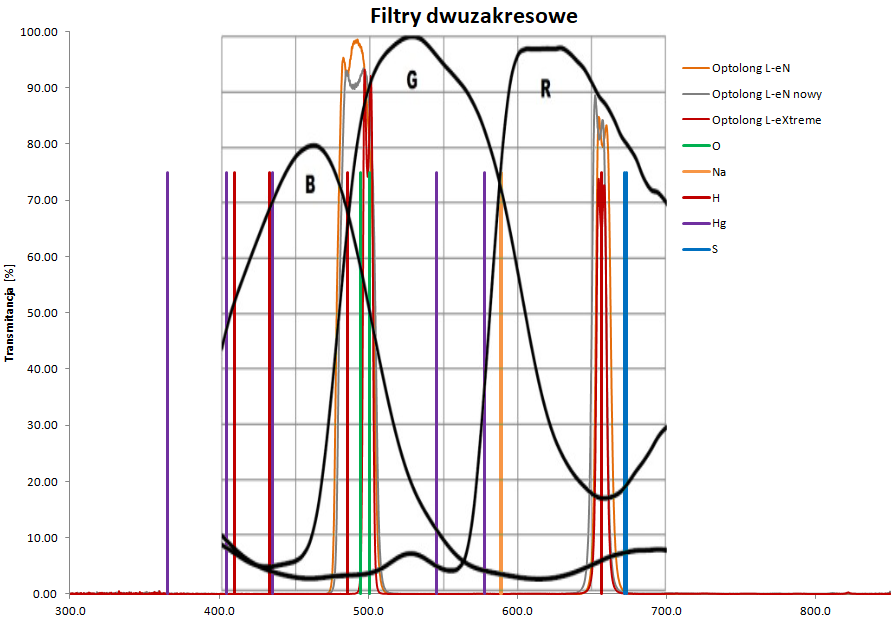

Dziękuje za wyjaśnienia. Temat jest skomplikowany i ma dużo zmiennych. W zależności od obiektu porównanie może wyjść różnie, ale raczej na korzyść nowego produktu. Jaka jest w praktyce ta niezerowa szerokość dla Ha ?. Na skutek efektu Dopplera widmo może być trochę przesunięte oraz przy szybkich teleskopach f<3.5 jest przesunięcie w kierunku niebieskiego na skutek tego, że światło nie pada równolegle na filtr. Po nałożeniu Twojego wykresu na charakterystykę matrycy IMX294 uzyskałem taki obrazek: W L-eXtreme pasmo H-beta się nie załapie. H-beta jest rejestrowane przez pixele niebieskie oraz zielone czyli 3/4 pixeli na matrycy. Jednak tylko dla części obiektów ma to znaczenie. OIII najlepiej zarejestrują pixele zielone. Na pixelach niebieskich też sygnał z OIII będzie obecny. Interesuje mnie SN. SN= sygnał/pierwiastek(szum tła). Szacuję, że w l-eNhanced ze względu na węższe pasmo tło będzie miało 2.5 raza wyższy poziom. Szum tła jest pod pierwiastkiem, więc eX zyska jakieś 37% na SN. Sygnału dla OIII będzie praktycznie tyle samo dla obu filtrów. Sygnału Ha będzie nieco więcej dla eN. Dla Hb sygnał będzie obecny tylko w eN. Uwzględniając ilość pixeli danego koloru i ich czułość prawie zawsze eX wypadnie lepiej. Ciekawe jak ta przewaga będzie widoczna w praktyce patrząc na ilość detali.

-

Czy mając oba filtry możesz zrobić jakiś praktyczny test porównawczy L-eNhance z L-eXtreme tzn. ekspozycję o tych samych parametrach, tym samym sprzętem, w tych samych warunkach. Najlepiej pod zaświetlonym niebem. Ciężko mi zinterpretować wyniki bo jednak dla h-alpha transmisja jest sporo niższa w L-eXtreme względem L-eNhance ( 82.6% / 64.8% = 1.27). Dodatkowo pasmo h-beta się nie łapie w l-eXtreme. Z drugiej strony dużo węższe pasmo w OIII i trochę węższe w ha to mniej LP.

-

ZWO ASI 294 MC Pro problem z odbiciami

rambro odpowiedział(a) na Grzegorz Czernecki temat w Dyskusje o astrofotografii

Według mojej wiedzy ten typ matrycy tak ma. To samo zauważyłem u siebie oraz u kolegi @diver Są to prawdopodobnie odbicia na mikrosoczewkach. Problem wychodzi tylko na bardzo jasnych gwiazdach. To nie wina ZWO. QHY ma to samo w kamerach z tą matrycą a w mojej ocenie dodatkowo mniej stabilne sterowniki i brak huba USB. Inne matryce np. Panasonica z ASI163MM PRO mają podobny problem. Chip Panasonica nawet nie ma tak jak Sony IMX294 powłok AR na szybce. Nie dramatyzowałbym :). Może da się wyeliminować w obróbce. -

Wybrałeś trudny obiekt na pierwsze światło. Przydałoby się więcej materiału. Brakuje mi trochę kontrastu na samej galaktyce. Najlepiej go podbić selektywnie, aby nie psuć ciemnych partii zdjęcia. Czy stosowałeś dithering ?.

-

-

Mazowiecka Grupa Obserwacyjna (Warszawa i okolice) - spotkania

rambro odpowiedział(a) na wimmer temat w Spotkania, zloty, wyjazdy i imprezy

Możesz podać dokładniejsze współrzędne miejscówki ?. -

Mam 34 klatki z kometą. Elementy krajobrazu są rozmazane, bo używałem prowadzenia matrycą (pentax o-gps). Dodatkowo zrobiłem klatkę bez prowadzenia dla ostrego krajobrazu. Niestety słabo znam się na obróbce grafiki. Jak połączyć obrobionego stacka ze zdjęciem krajobrazu np. w PS (używam Affinity photo ale powinno być podobnie) ?. Może jest jakiś dobry tutorial etc...

-

Składanie materiału LRGB - pytanie

rambro odpowiedział(a) na AdamK temat w Dyskusje o astrofotografii

W Siril jest fotometryczna kalibracja koloru. -

-

Czytając pierwsze komentarze z wątku myślałem, że trzeba jechać o 2 w nocy. Wczoraj wyszedłem na balkon po 23 i gołym okiem w mieście ją zauważyłem. Szybki wypad za miasto i mam swoje zdjęcia komety :))). Ogniskowe od 50 do 200, czasy 10-30s., f2-f4 . Pentax K-70 OGPS. Zebrałem kilkanaście klatek na stack, ale jeszcze nie obrobione. Jest piękna...

-

Kwestia śmierci - a w zasadzie tego co po nas zostanie

rambro odpowiedział(a) na Bezel temat w Społeczność AP (Rozmowy o wszystkim)

Dlatego śmierć nie boli. Przed urodzeniem i po śmierci jest tak samo. Nie ma mózgu, więc neurony nie pracują, niezależnie czy do swojej pracy mózg wykorzystuje efekty kwantowe czy nie. Ciekawy jest temat wolnej woli i determinizmu. Jeżeli nie byłoby czynnika losowego nie mielibyśmy wyboru i wszystko byłoby zdeterminowane. Jednak lubię własne wrażenie że mam wpływ na to co robię a przyszłość nie jest z góry określona. -

Kwestia śmierci - a w zasadzie tego co po nas zostanie

rambro odpowiedział(a) na Bezel temat w Społeczność AP (Rozmowy o wszystkim)

Jak masz dzieci to coś z tej funkcji jednak pozostaje na świecie. -

NGC 7635 - co to za smuga na pół zdjęcia?

rambro odpowiedział(a) na isset temat w Dyskusje o sprzęcie

Jak ktoś używa manualnego koła filtrowego np. po motoryzacji itp. ( ja mam takie https://pl.aliexpress.com/item/33058209842.html ) to też trzeba zaślepić tam gdzie się ręcznie kręci. Wychodziło mi to na klatkach kalibracyjnych robionych w dzień. Ogólnie to słaba powtarzalność jest tego koła i warto dodać łożysko, ale to zwiększa szerokość ... główny plus że całkowity koszt z motoryzacją to 300 zł za 2" a nie 1500+ zł. -

Zaprojektowałem międzygwiezdny statek kosmiczny z załogą

rambro odpowiedział(a) na Alberto temat w Społeczność AP (Rozmowy o wszystkim)

Musíte létat v masce? Regulace teploty před nástupem na palubu? QR kód na cílovém letišti? -

Cudo. Piękne kolory. Mistrzowskie połączenie LRGB+NB.

-

W Deep Sky Stacker algorytm Bayer Drizzle jest dostępny. Nie mylić ze zwykłym drizzle co zwiększa rozdzielczość. http://deepskystacker.free.fr/english/technical.htm#bayerdrizzle Potrzeba dużo subów. Próbowałem ale bez rewelacji. Może dużo zależy od materiału wejściowego. Sygnał mam mocno nadpróbkowany więc zwykle algorytmy sobie radzą. Funkcja Pixel shift przesuwająca matrycę o jeden pixel dla każdego koloru jest w Pentaxach np. K-70, KP, K1. Przydatna jest raczej w studio niż pod niebem. Lepsza metoda to dither itp. + Bayer drizzle z DSS.

-

Metoda I dla szarych scen (czarno białe paski i tekst moim zdaniem klasyfikują się pod taką scenę) opisana w artykule sprowadza się do dobrania współczynników dla składowych RGB. Moje poprzednie pytanie o balans bieli i szarą kartkę dotyczyło właśnie dobrania tych współczynników. Oświetlenie powinno być takie same jak dla badanej sceny. Dzięki temu, po pomnożeniu o odpowiednie wagi poszczególne pixele (różne kolory) będą miały zbliżoną czułość. Teoretycznie możesz z jednej kamery do drugiej przełożyć matrycę. Firmware kamery ma zapisane czy to matryca mono czy kolor. Układy z punktu widzenia elektroniki są praktycznie identyczne (ICX424AQ- kolor i ICX424AL - mono). Fizyczna różnica jest taka, że w kolor naniesiona jest maska Bayera. Rozmiary pixeli w Atiku mono i kolor są identyczne. Pasmo jest takie samo. Poboczny wątek o szybkości odczytu nic nie wnosi do tematu. Poniżej pdfy z datasheet. Można sobie porównać. https://s1-dl.theimagingsource.com/api/2.5/packages/publications/sensors-ccd/icx424al/e6f6a6dc-f966-5bf2-89ca-b1370715d416/icx424al_1.2.en_US.pdf https://s1-dl.theimagingsource.com/api/2.5/packages/publications/sensors-ccd/icx424aq/05a8c2d8-9623-5520-96bb-1d99c4a2b8a8/icx424aq_1.2.en_US.pdf

-

Dla mnie obecnie ograniczeniem nie jest niższa rozdzielczość kamery kolor względem mono a jedynie seeing. Pixele są na tyle małe, że przy długiej ogniskowej sygnał zawsze jest mocno nadpróbkowany. Przewaga mono to głównie możliwość LRGB i NB. LRGB względem RGB pozwala uzyskać ten sam SN 1.5-2x szybciej.