holeris

Społeczność Astropolis-

Postów

716 -

Dołączył

-

Ostatnia wizyta

-

Wygrane w rankingu

15

Typ zawartości

Profile

Forum

Blogi

Wydarzenia

Galeria

Pliki

Sklep

Articles

Market

Community Map

Treść opublikowana przez holeris

-

Mam te sama matryce, tylko z chlodzeniem i maska bayera (qhy168c). No ale nie za 1200zl

-

255 albo 1023 też nie lubisz?

-

Widma układów spektroskopowo podwójnych

holeris odpowiedział(a) na bajastro temat w Radioastronomia i spektroskopia

Dzięki za odpowiedź i dalsze wskazówki! Zastanawia mnie jeszcze dlaczego w widmie gwiazdy pojawiają się linie absorpcyjne, a nie emisyjne. Dlaczego na tych długościach fal dociera do nas mniej fotonów z kierunku gwiazdy, a nie więcej? Czy gwiazda nie powinna wyświecać "pełnego" widma, zgodnie z modelem CDC. A dodatkowo emitować na pasmach wzbudzonego wodoru czy innych pierwiastków? Wodór aby wyemitować foton musi najpierw zostać wzbudzony takim samym fotonem. Czy część fotonów reemitowana jest w innych kierunkach i to tłumaczy dołek na wykresie zamiast górki? EDIT: widzę, że odpowiedź jest na obrazku "wynik oddziaływań fotonów z atomami wodoru w chłodniejszym ośrodku gazowym znajdującym się w zewnętrznych warstwach gorącej gwiazdy". Już wszystko jasne. A w ogóle to WESOŁYCH ŚWIĄT :-) EDIT2: Chociaż pomimo absorpcji w zimniejszych warstwach gwiazdy pytanie pozostaje aktualne. Czy gwiazda wypromieniowuje wg. CDC plus piki na liniach emisji? A później te piki i tak ulegają absorpcji?- 13 odpowiedzi

-

- prędkość radialna

- linie widmowe

-

(i 1 więcej)

Oznaczone tagami:

-

Widma układów spektroskopowo podwójnych

holeris odpowiedział(a) na bajastro temat w Radioastronomia i spektroskopia

Pytanie laika w nawiązaniu do wątku: W podlinkowanym wątku zastanawiam się między innymi które promieniowanie dominuje: emisyjne jak h-alfa czy termiczne. Czy patrząc na Twoje wykresy można powiedzieć, że linia Hα wybija się ponad promieniowanie termiczne?- 13 odpowiedzi

-

- prędkość radialna

- linie widmowe

-

(i 1 więcej)

Oznaczone tagami:

-

Dlaczego świeci tak jak świeci

holeris odpowiedział(a) na holeris temat w Astrofizyka, kosmologia i teorie

Wyjaśnia to bardzo wiele. Dzięki :-) Czyli to po prostu 2 różne zjawiska. Docierające do nas fotony pochodzą więc albo z promieniowania termicznego, albo z emisji. To jest odpowiedź, której szukałem. A teraz w skali kosmicznej. Czyli docierające do nas fotony pochodzą albo z promieniowania termicznego, albo z emisji. Jaka jest skala? Jak dużo fotonów procentowo pochodzi z poszczególnych źródeł? Bo jeśli chodzi o długości fal, to jak rozumiem promieniowanie termiczne występuje głównie w podczerwieni i świetle widzialnym. Później jest katastrofa w nadfiolecie i prawie zanika. A kolory gwiazd czy mgławic? Co jest ich głównym źródłem? Z kolorową kamerką robię zdjęcia z filtrem IR-Cut, więc podczerwoną część promieniowania termicznego wycinam. Ale widzialna zostaje. Dominuje ona nad promieniowaniem z emisji? H-Alfa świeci na czerwono, ale większość gwiazd jest typu widmowego M, który też świeci na czerwono, ale promieniowaniem termicznym. EDIT: Nie jest tak, że mgławice są zbyt rzadkie, aby dochodziło do promieniowania termicznego? Więc w przypadku mgławic głównym źródłem fotonów jest emisja ze stanów wzbudzonych, a w przypadku gwiazd promieniowanie termiczne? -

Próbuję zrozumieć zależność pomiędzy prawem Plancka i promieniowaniem ciała doskonale czarnego, a liniami emisyjnymi poszczególnych pierwiastków. Z jednej strony mamy prawo Plancka opisujące rozkład widma ciała doskonale czarnego. Jak rozumiem na podstawie długości fali można obliczyć temperaturę, jaką musiało by mieć hipotetyczne ciało doskonale czarne, aby wypromieniować konkretną długość fali. Stąd np. temperatura barwowa gwiazd. Prawo Plancka nic nie mówi jednak o tym z czego zbudowane jest ciało doskonale czarne. Jest to nieistotne. Jeśli tylko ciało jest doskonale czarne, to, niezależnie od składu, promieniuje zgodnie z prawem Plancka. Należy zaznaczyć, że ciało doskonale czarne jest wytworem czysto teoretycznym i nie występuje w przyrodzie. Z drugiej strony wiemy o poziomach energetycznych atomów poszczególnych pierwiastków. W zależności od pierwiastka jest różna liczba poziomów energetycznych i przy przejściu z poziomu wyższego na niższy wypromieniowywany jest kwant energii o energii / długości fali zależnej od różnicy energii poziomów. Stąd na podstawie długości zmierzonej fali możemy stwierdzić jaki pierwiastek i przy jakim przejściu energetycznym ją wypromieniował. Np. seria Balmera dla wodoru opisuje między innymi linie H-α czy H-β. Nie widzę przejścia pomiędzy tymi dwoma modelami. Jeśli prawo Plancka opisuje jak promieniują ciała, to gdzie pojawia się skład? A może prawo Plancka to tylko statystyczne uproszczenie, bo pierwiastki w kółko wzbudzają się i emitują? Ale przecież to właśnie Planck w swojej pracy o promieniowaniu ciała doskonale czarnego jako pierwszy wprowadził pojęcie kwantu. A ono zbliża nas do konkretnych pierwiastków - konkretnych, skwantowanych poziomów energetycznych i odpowiadającym im emisjom. Jak patrzymy na rozgrzany metal w hucie, to na podstawie wyłącznie koloru / długości fali jesteśmy w stanie określić temperaturę z prawa Plancka? Czy musimy jeszcze wiedzieć jaki to metal? A może linie widmowe są aż tak charakterystyczne, że dają nam jednocześnie informację o składzie i temperaturze? Bo aby pierwiastek mógł wyemitować jakiś foton, najpierw musiał osiągnąć pewien stopień energetyczny czyli osiągnąć pewną temperaturę? Mam nadzieję, że nie powypisywałem żadnych herezji. Zwłaszcza proszę o wyjaśnienie kwestii zależności między modelem Plancka, a modelem "spektrometrycznym". A może ja się na siłę doszukuję tej zależności, a prawda jest taka, że model "spektrometryczny" jest rozwinięciem modelu Plancka, na podobnej zasadzie jak teoria względności rozszerza mechanikę newtonowską? Jak widać trochę się w tym gubię. Będę wdzięczny, jeśli mi to rozjaśnicie.

-

Tu jest tez fajne wytlumaczenie https://physics.stackexchange.com/questions/149516/what-are-adu-analog-to-digital-units

-

Porównanie ceny z Google One czy Amazon Drive, wypada na korzyść Astrobina. Można mieć nieskończoną ilość zdjęć max. 50 MB każde za 37 euro rocznie. U Googla jest 100GB za 90zł rocznie. Na tiffa z zachowanymi warstwami 50MB w sumie mało (o ile można tam takie przechowywać - nie wiem, nie korzystam). No i Astrobin ma funkcje społecznościowe, których standardowym chmurom brakuje. W podstawowym planie Photoshopa jest 20GB, ale to też w zasadzie niezbyt dużo. Można powiedzieć taki gratis do PS. EDIT: Pozostaje oczywiście kwestia odbudowy zaufania po ostatniej wpadce.

-

https://drive.google.com/drive/folders/1GdzZQIGsMeORQdjv3gZP67RU1WPoilKq Masz 2 surowe klatki z NGC6992 (120s z filtrem IR-Cut z Gór Izerskich), tego co wyżej wkleiłem oraz 2 klatki z M81/M82 (180s z filtrem h-alpha 7nm z Wrocławia). Pamiętaj, żeby się przesadnie nie sugerować jeśli coś będzie nie tak. Przyczyną może być małe doświadczenie, a nie optyka.

-

Ja mam ten pierwszy podlinkowany teleskop, APO 102 / f7, kupiłem używanyz 2 lata temu. Niestety jestem zdecydowanie zbyt mało doświadczony, aby wypowiedzieć się na temat możliwości tego teleskopu. Czasem wychodzi aberracja, a czasem nie. Nie rozumiem od czego to zależy. Stosuję z kamerą QHY168C, z pikselem 4.8μm oraz z korektorem x0.8. Tutaj masz zdjęcie (moim zdaniem) bez aberracji. Patrz wersje na samym dole tego wątku:

-

Astrofotografia - Pierwszy poważniejszy sprzęt

holeris odpowiedział(a) na Damian Świątczak pytanie w Pierwsze Kroki: Sprzęt

Pewnie, że nie ma, przecież ja nie o tym. Mówię, że wielkość piksela ma znaczenie dla prowadzenia. -

Astrofotografia - Pierwszy poważniejszy sprzęt

holeris odpowiedział(a) na Damian Świątczak pytanie w Pierwsze Kroki: Sprzęt

Chodzi też o skalę zdjęcia, czyli jak duży fragment nieba (w sekundach łuku) obejmuje 1 piksel. Im większy piskel, przy tej samej optyce, tym łatwiej o kompensacje pozornego ruchu gwiazd. Czytaj tańszy montaż, etc. Tutaj możesz obliczyć skalę w zależności od optyki (apertura, ogniskowa) oraz matrycy kamery (rozdzielczość, rozmiar piksela): http://www.12dstring.me.uk/fovcalc.php -

Pierwsze stackowanie DS- problem

holeris odpowiedział(a) na wajoman1991 temat w Dyskusje o astrofotografii

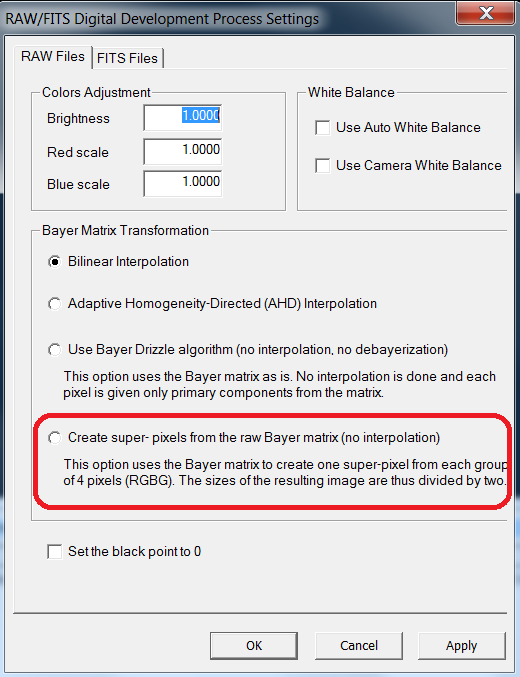

Miałem kiedyś podobnie. DSS nie chciał mi stackować krótkich, słabo naświetlonych klatek. Pomogło jedynie włączenie super pixela, ale to z kolei pogarsza rozdzielczość. Spróbuj zestackować w siril. Tylko będziesz musiał chyba przekonwertować do tiff najpierw. -

Wygląda na jeden z wielu katalogów agregujących dane z kilku projektów badawczych. Pod tym linkiem jest napisane: Total 469,053,874 Stars 260,562,744 Galaxies 208,478,448 Unknown 12,682 Sam projekt Gaia skatalogował 2 miliardy gwiazd z drogi mlecznej, tak dla porównania. W głębokim polu Hubbla jest 10000 galaktyk, a to tylko 2.6 arcmin.

-

Ile jest znanych galaktyk? Jak to sprawdzić? Jest jakiś "zbiorczy" katalog zawierający wszystkie? Czy co projekt badawczy, to osobne dane i nikt tego nie podsumowuje?

-

A ten jasny "rozbłysk" z lewej? Achernar?

-

Zmiana serwera i administratora - 2020

holeris odpowiedział(a) na Adam_Jesion temat w Sprawy techniczne

U mnie w pracy filtr zaczal wykrywac astropolis jako malicious website -

Czym są przestrzenie kolorystyczne (sRGB, AdobeRGB) i jak nimi zarządzać

holeris odpowiedział(a) na holeris temat w Dyskusje o astrofotografii

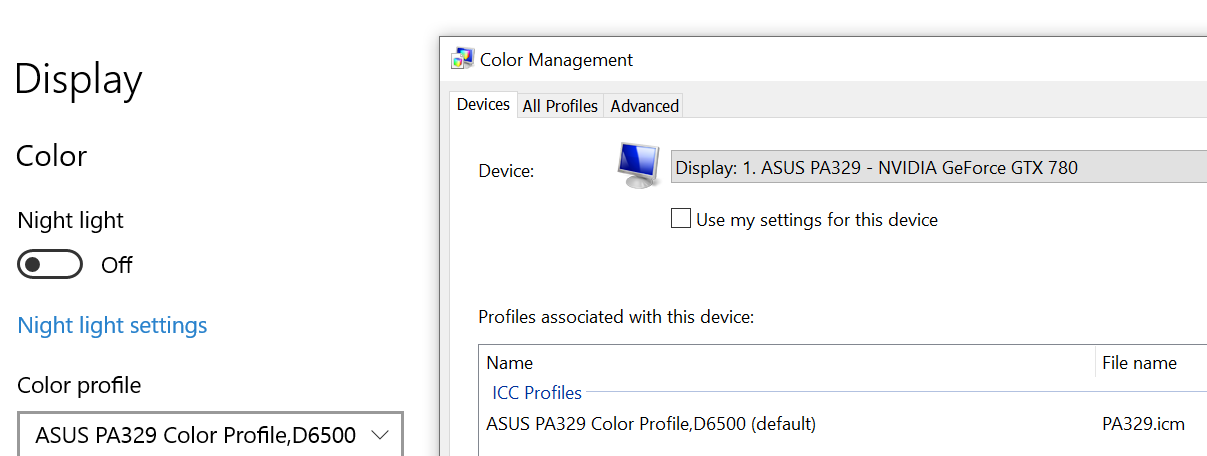

W10, bingo! To również wiele tłumaczy. -

Czym są przestrzenie kolorystyczne (sRGB, AdobeRGB) i jak nimi zarządzać

holeris odpowiedział(a) na holeris temat w Dyskusje o astrofotografii

Wyglądają OK. bla To wiele tłumaczy, dzięki! Czym się w zasadzie różni konwersja do sRGB od dołączenia profilu sRGB? -

Czym są przestrzenie kolorystyczne (sRGB, AdobeRGB) i jak nimi zarządzać

holeris odpowiedział(a) na holeris temat w Dyskusje o astrofotografii

Ciągle mam jakieś dziwne objawy. Robię tak: 1. Otwieram w PS stacka w formacie TIF. 2. Przypisuję mu profil sRGB (opcja assign profile). 3. Obrabiam testowo zdjęcie. 4. Zapisuję TIFa (przez save as). Opcja dołączenia profilu jest zaznaczona. 5. Zapisuję JPG (przez export as). Nie zaznaczam konwersji do sRGB, zaznaczam dodanie profilu. 6. JPG otwieram w PS. Wygląda tak samo jak TIF w PS. 7. JPG otwieram w firefox. Wygląda tak samo jak TIF w PS. 8. W windowsowej przeglądarce obrazów, w paincie, nawet w rawtherapy JPG wygląda inaczej niż TIF w Photoshopie / Firefoxie - czerwień jest bardziej intensywna. 9. Wracam do TIFa w PS. Próbuję przekonwertować profil (opcja convert profile to). Z sRGB w identyczne sRGB - pojawiają się inne kolory w PS (takie jak w punkcie 8). Dlaczego mam taki efekt w punkcie 8? Skoro zdjęcie ma przypisany profil sRGB, a sRGB jest de facto standardem, to nie powinno się wszędzie wyświetlać tak samo? Efekt w punkcie 9 jest równie dziwaczny. Co robię źle? -

Czym są przestrzenie kolorystyczne (sRGB, AdobeRGB) i jak nimi zarządzać

holeris odpowiedział(a) na holeris temat w Dyskusje o astrofotografii

-

Czym są przestrzenie kolorystyczne (sRGB, AdobeRGB) i jak nimi zarządzać

holeris odpowiedział(a) na holeris temat w Dyskusje o astrofotografii

No tak, trochę to uprościłem. Masz oczywiście rację. W macierzy nie jest dosłownie zapisana liczba elektronów. W każdym razie jest to surowy sygnał, który w połączeniu z gainam i offsetem daje pośrednio informację o ilości elektronów. Pytanie czy później jest transformacja jakaś, czy po prostu jeden do jednego interpretujesz to "jak chcesz". Jak ustalisz, że to czerwony, to będziesz się poruszał po RGB w ramach (ilość ADU, 0, 0), co w wybranym gamucie będzie oznaczało inne miejsce na trójkącie barw. Dalej następuje już inwencja twórcza. Nasunęła mi się początkowo myśl, że w związku z tym wszystkim zawsze powinienem pracować w gamucie Adobe RGB, bo przecież w każdej chwili, np. w celu prezentacji w internecie, mogę przekonwertować do sRGB. Ale z drugiej strony, obrabiając zdjęcie od początku w Adobe RGB mogę uzyskać kolory, których nie ma w sRGB i wtedy podczas konwersji zmienię wygląd zdjęcia i może przestać odpowiadać temu, co sobie zamierzyłem. Co z kolei skłania mnie do używania formatu sRGB, chyba że będę planował obrobić zdjęcie pod wydruk. Z tym, że wtedy będę się musiał liczyć z faktem, że jeśli będę je chciał kiedyś opublikować w internecie, to może zostać odebrane inaczej niż sobie zamierzyłem, bo a) Adobe RGB może nie być wspierane, b) większość ludzi nie ma odpowiednich monitorów. -

Czym są przestrzenie kolorystyczne (sRGB, AdobeRGB) i jak nimi zarządzać

holeris odpowiedział(a) na holeris temat w Dyskusje o astrofotografii

Świetne tłumaczenia, dziękuję! Nurtuje mnie jeszcze jedna kwestia: gdzie zaimplementowany jest algorytm transformujący liczbę elektronów na konkretne wartości RGB i czy w ogóle takowy istnieje? W moim rozumieniu zarejestrowane przez matrycę fotony przekształcane są w elektrony, przechodzi to wszystko przez przetworniki A/C, etc. Kamera ostatecznie zapisuje tę surową informację o ilości złapanych elektronów na pixel mniej więcej w postaci zero fotonów - w polu ustawiamy wartość 0, maksymalna głębokość studni - w polu ustawiamy maksa dla 14 bitów (w zależności od kamery, ilość bitów może się różnić). Tak więc mamy plik, w którym zapisana jest (nieważne w jakiej postaci) macierz mówiąca nam ile zarejestrowało się elektronów na piksel. W każdym polu tej macierzy zapisana jest 14-bitowa wartość. W którymś momencie należy jednak zdecydować jak przekształcić ilość elektronów w informację o kolorze (uprośćmy sytuację do kamery mono, bez maski bayera). Czy tutaj zachodzi jakakolwiek transformacja? Czy jest jakaś zasada, którą każdy producent oprogramowania sam implementuje? Czy też po prostu, w zależności od przyjętego gamutu, 0 bitów oznacza czerń, a maksymalna ilość bitów w macierzy taki a taki kolor, w zależności od przyjętego gamutu i koloru, który sobie akurat dla naszej, monochromatycznej przecież, klatki przyjęliśmy. Czyli zdjęcie jest de facto 14 bit na kanał i znów od softu zależy czy przy zapisie do 16bit rozciągnie je czy zostawi 2 bity puste? -

Czym są przestrzenie kolorystyczne (sRGB, AdobeRGB) i jak nimi zarządzać

holeris odpowiedział(a) na holeris temat w Dyskusje o astrofotografii

Jeszcze trochę podrążę. Format FITS nie ma informacji o przestrzeni barw. Tam informacje są surowe. A format TIF? Bo jak otwieram stacka to on nie ma żadnego profilu. Czy to dlatego, że TIF ma surowe dane, bez przestrzeni barw? Czy też dlatego, że Siril mu nie ustawił profilu ICC, ale zapisane zostało mimo wszystko w sRGB? Innym słowy gdzie w takim workflow pierwszy raz surowe dane zapisywane są w którejś z przestrzeni barw: Kamera -> pliki FITS -> Siril -> Plik TIF -> PS -> Plik TIF -> Plik JPG -

Czym są przestrzenie kolorystyczne (sRGB, AdobeRGB) i jak nimi zarządzać

holeris odpowiedział(a) na holeris temat w Dyskusje o astrofotografii

Czyli w moim przypadku Siril ustawia profil sRGB, bo ewidentnie taki ma zdjęcie po stacku. Muszę poszperać jak to zmienić. A może przestawić Sirila, żeby też wyrzucał FITS i później zapisać to w czymś do TIFa AdobeRGB, tylko w czym? Hmmm