-

Postów

5 148 -

Dołączył

-

Ostatnia wizyta

-

Wygrane w rankingu

12

Typ zawartości

Profile

Forum

Blogi

Wydarzenia

Galeria

Pliki

Sklep

Articles

Market

Community Map

Treść opublikowana przez Behlur_Olderys

-

Python na windowsie to jakaś zmora.

Żeby narysować głupi wykres danych z seriala (od Arduino) chcę mieć pyqtgraph. Ale to potrzebuje PyQt (brak binarek na windę) albo PySide (zła wersja Pythona). No to zmieniam wersję - nie ma MSCV10. To może matlplotlib? Za wooooolnoooo. Matplotlib + gtk? Nie ma gtk. Pip install gtk. Nie ma pygobject. Pip install pygobject. Błąd? Nie ma MSVC. Szlag by to trafił, instalacja MSVC 7GB się ściąga, a miało być szybko łatwo i przyjemnie :/ Na linuxie pewnie wszystko zadziałałoby "od strzała"

- Pokaż poprzednie komentarze 4 więcej

-

-

gratulacje samozaparcia, dla mnie próba uruchomienia jednej słownie jednej aplikacji (żadne tam uchowaj buku programowanie) przeciągnęła mnie przez pół internetu instalacje i odinstalowanie jakiejś nieprawdopodobnej ilości badziwewia. Kontakt z pytonem sprowadził mnie do poziomu czytania jakiegoś wątku na elektrodzie a nawet jeszcze gorzej - do zapytania kogoś kto chyba sie na tym zna....

Jak to jest miód i orzechy to znaczy że ja mam alergie bo "wstrząs anafilaktyczny" był blisko - ale odnalazłem drogę do światła, wyszperałem w sieci windową alternatywę i świat znów jest piękny:D

-

-

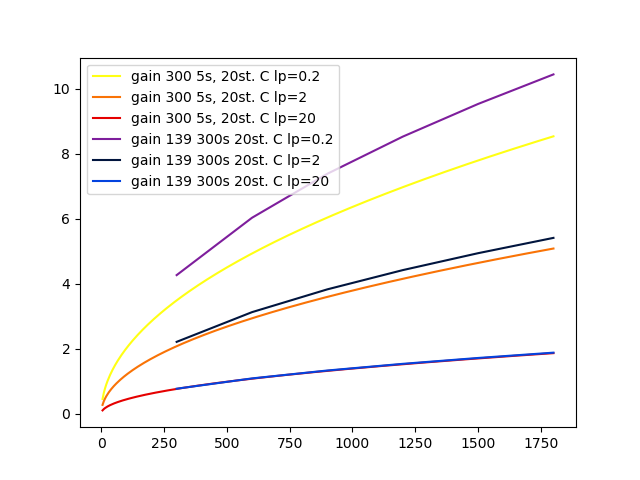

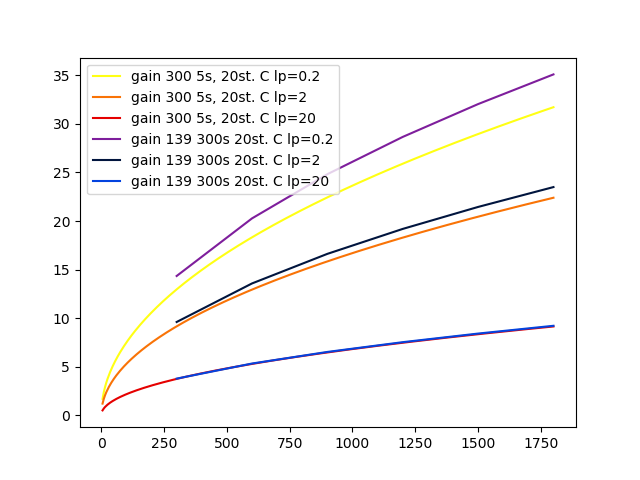

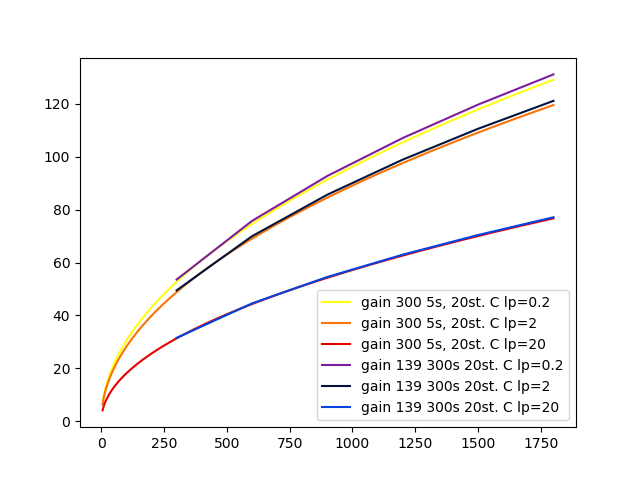

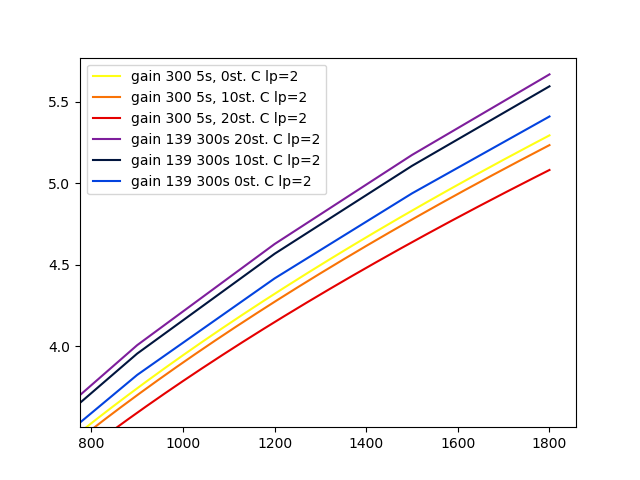

Pętla powoli się zaciska...

(pętla sprzężenia zwrotnego: enkoder->krokowiec)

-

-

Enkoder z drukarki - optyczny, transmisyjny, analogowy (sin-cos). Tarcza 1800 pasków na obrót, 200lpi (720" / pasek).

Interpolacja arctan przy użyciu 16bit ADC wstępnie daje pomiar kąta z dokładnością +/- 0.5".

Niedługo będę sprawdzał, po zapięciu pętli, ile to da realnie na osi RA przy przełożeniu ~1:2800 i sterowaniu mikrokrokami 1/16 na śrubie trapezowej ze skokiem 1mm.

Trochę więcej o historii tego projektu:

-

-

Przyjechały pryzmaty

Powoli trzeba wrócić do tematu interferometrii

Powoli trzeba wrócić do tematu interferometrii

Tips: jeśli dwa pryzmaty prostokątne skleić "na wodę" przeciwprostokątnymi powstaje idealny beamsplitter